本文主要是介绍flink 读取 apache paimon表,查看source的延迟时间 消费堆积情况,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

paimon source查看消费的数据延迟了多久

如果没有延迟 则显示0

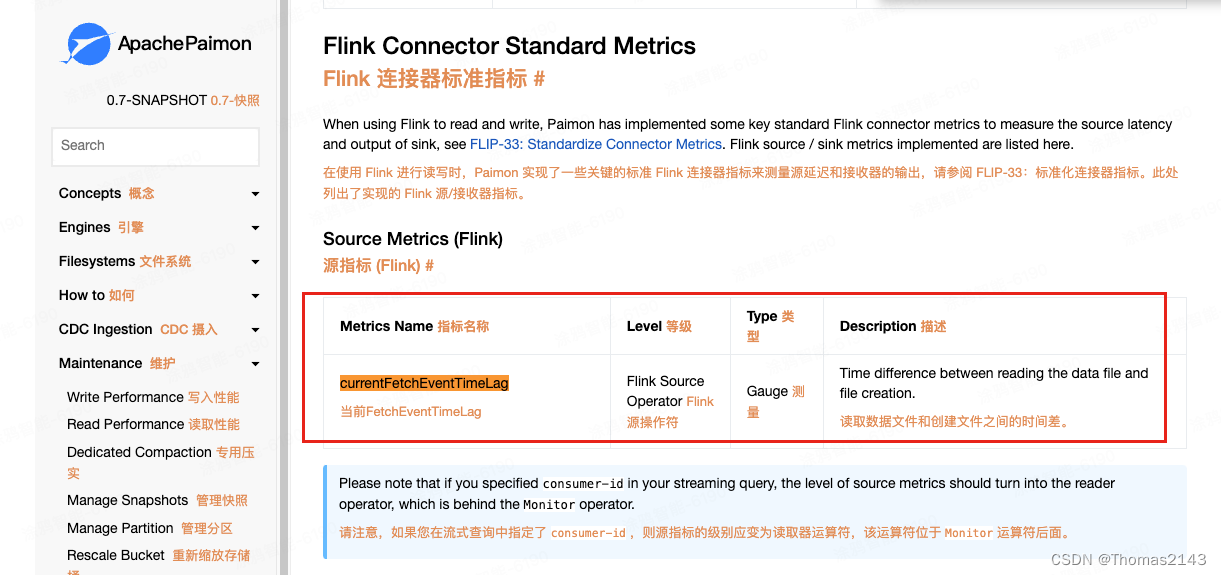

官方文档

Metrics | Apache Paimon

这篇关于flink 读取 apache paimon表,查看source的延迟时间 消费堆积情况的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

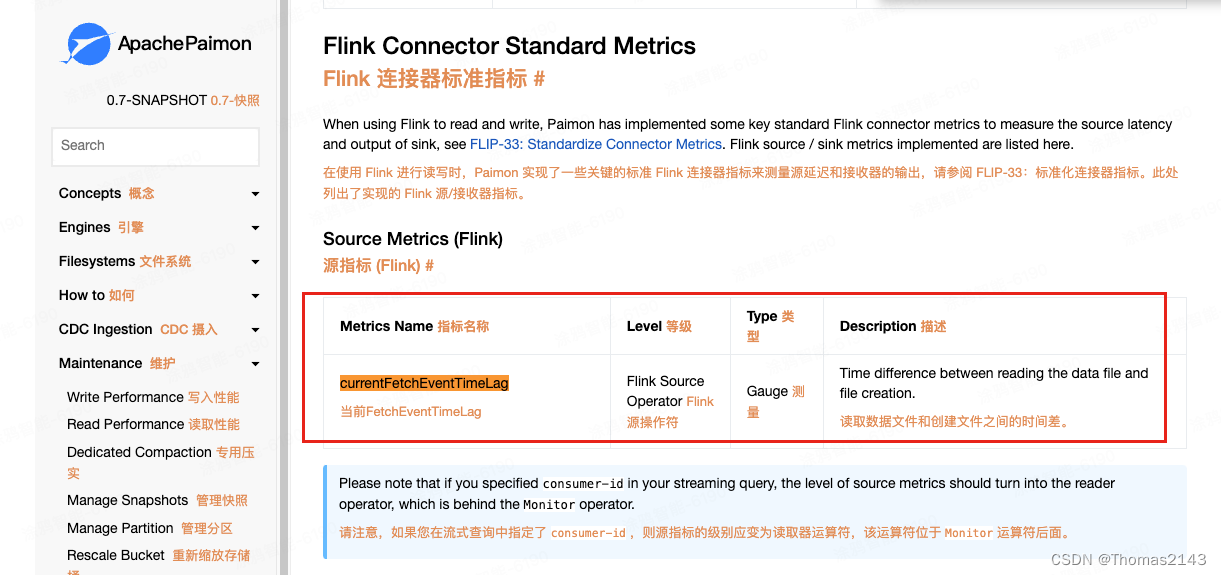

本文主要是介绍flink 读取 apache paimon表,查看source的延迟时间 消费堆积情况,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

如果没有延迟 则显示0

Metrics | Apache Paimon

这篇关于flink 读取 apache paimon表,查看source的延迟时间 消费堆积情况的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

http://www.chinasem.cn/article/513470。

23002807@qq.com