本文主要是介绍pytorch各种学习率衰减器,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

各种学习率衰减器

各类衰减器文档:【here】

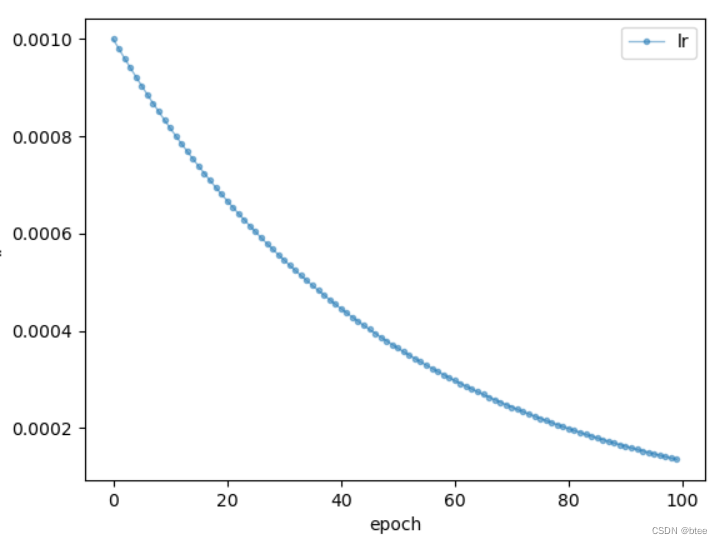

指数衰减

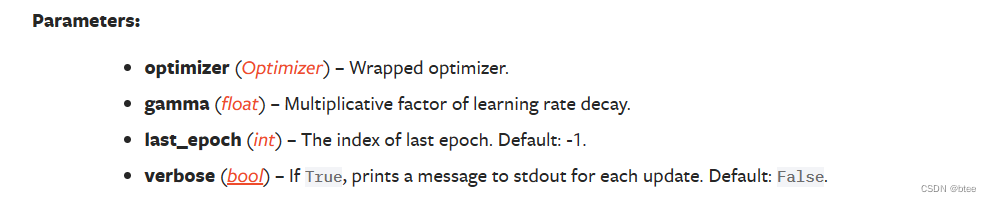

torch.optim.lr_scheduler.ExponentialLR(optimizer, gamma=0.98)

一般将last_epoch 设置成-1,verbose设置成FALSE

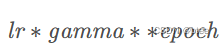

学习率调整公式:

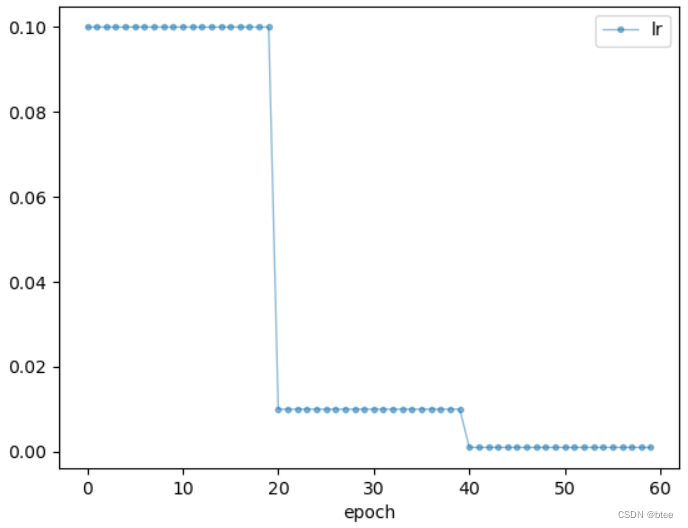

固定步长衰减

torch.optim.lr_scheduler.StepLR(optimizer, step_size=step_size, gamma=0.1)

参数:

optimizer (Optimizer):的优化器;

step_size(int):更新epoch;

gamma(float):更新lr的乘法因子;

last_epoch (int):默认-1

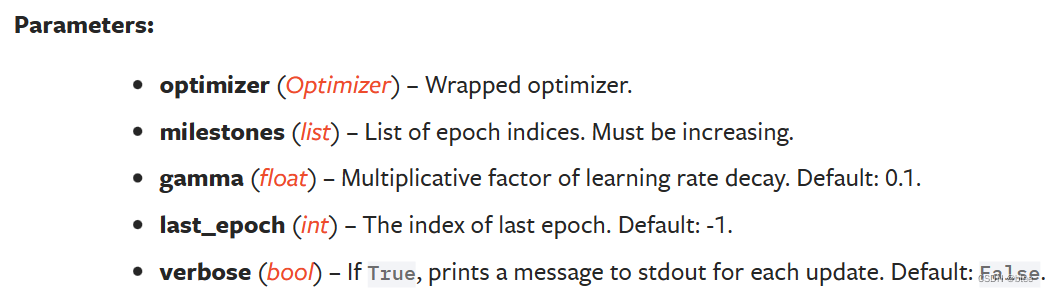

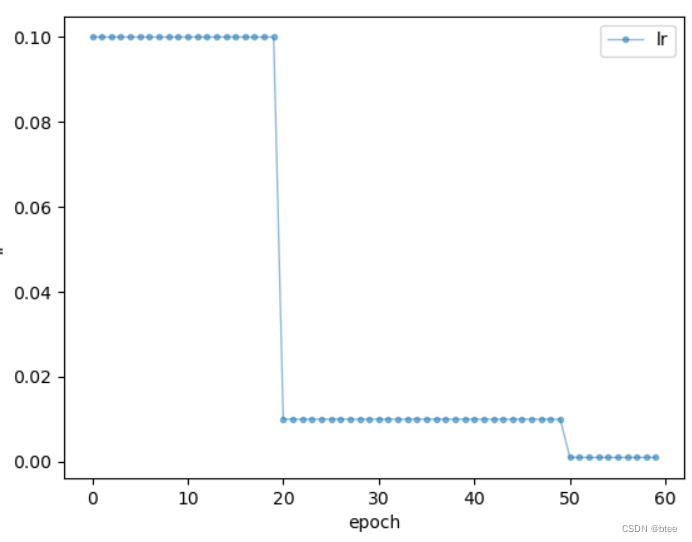

多步长衰减

torch.optim.lr_scheduler.MultiStepLR(optimizer,milestones=[20,50], gamma=0.8)

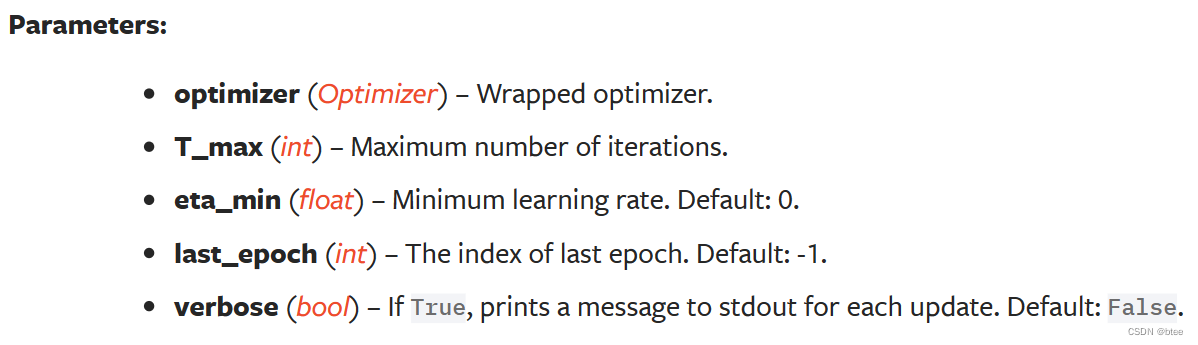

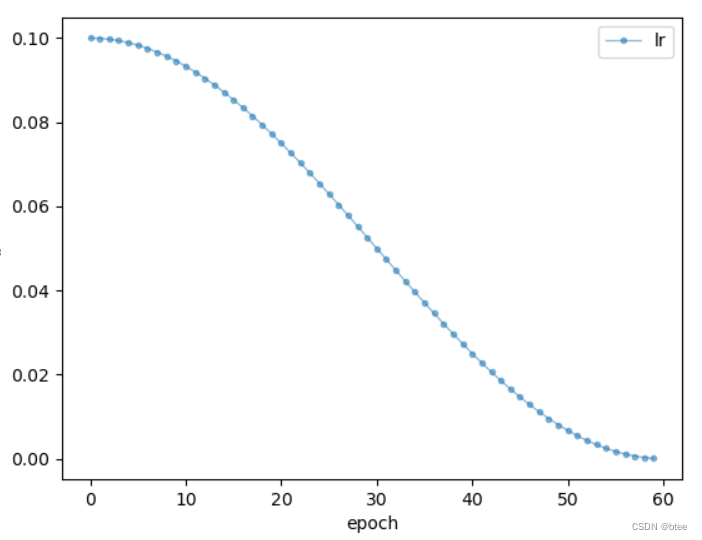

余弦退火衰减

torch.optim.lr_scheduler.CosineAnnealingLR(optimizer, T_max=60, eta_min=0)

T_max为余弦函数的一个半周期

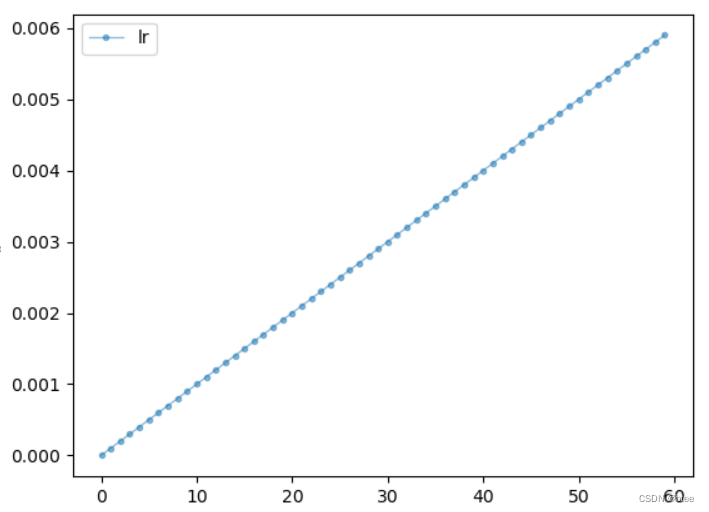

函数衰减

lambda1 = lambda i: 0.1 * i

torch.optim.lr_scheduler.LambdaLR(optimizer, lr_lambda, last_epoch=-1, verbose=False)

#lr = lr *lamda

自适应调整衰减

torch.optim.lr_scheduler.ReduceLROnPlateau(optimizer, mode='min', factor=0.1, patience=10, verbose=False, threshold=0.0001, threshold_mode='rel', cooldown=0, min_lr=0, eps=1e-08)

warm up

先将学习率从很小的值逐渐上升,再用现有的学习率衰减器

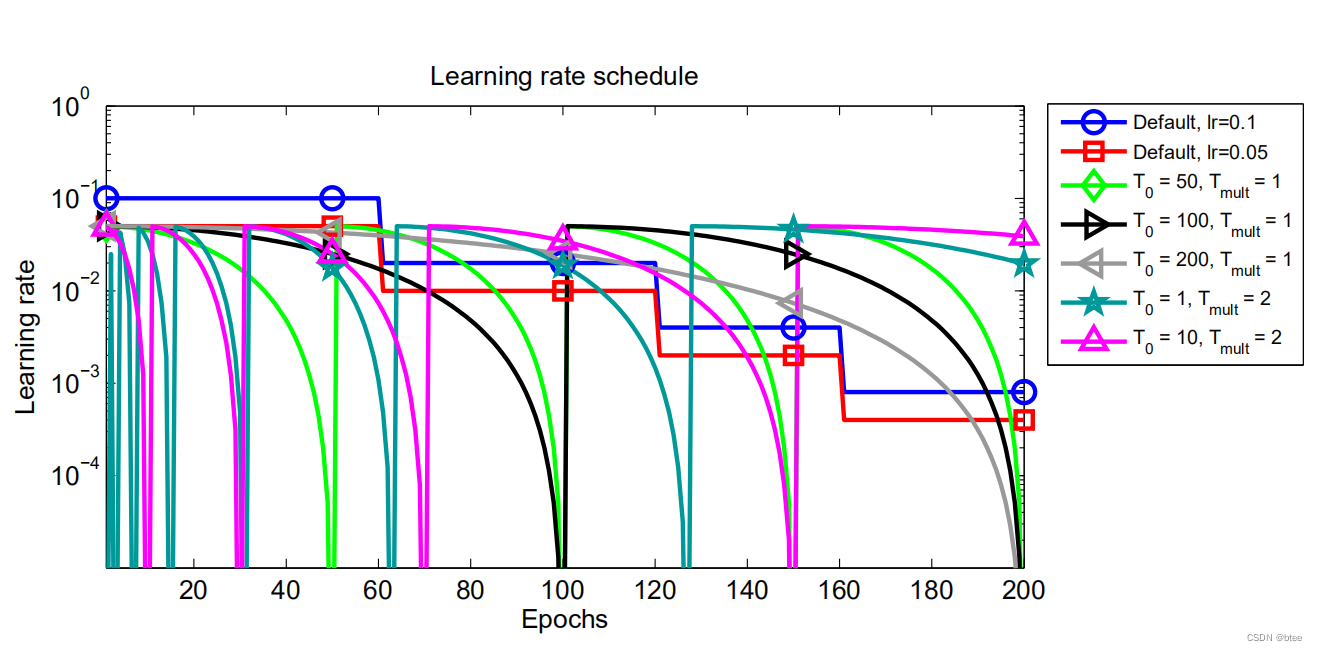

预热余弦退火

torch.optim.lr_scheduler.CosineAnnealingWarmRestarts(optimizer, T_0=20, T_mult=2, eta_min=0.01)

T_0和T_mult的不同设置的比较

这篇关于pytorch各种学习率衰减器的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!