本文主要是介绍图灵测试诞生70年,是时候下岗了吗?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

图灵测试诞生70年,是时候下岗了吗?

本文作者:林檎

2020 年是图灵测试问世的第 70 年。虽然人类仍未能建造出通过图灵测试的机器,但这也并不影响某些声音质疑这个支配了机器智能领域的测试,现在是否已不合时宜。

70 年的 “都市传说”

图灵测试是人工智能最初的概念,它甚至早于 “人工智能” 这个词本身。

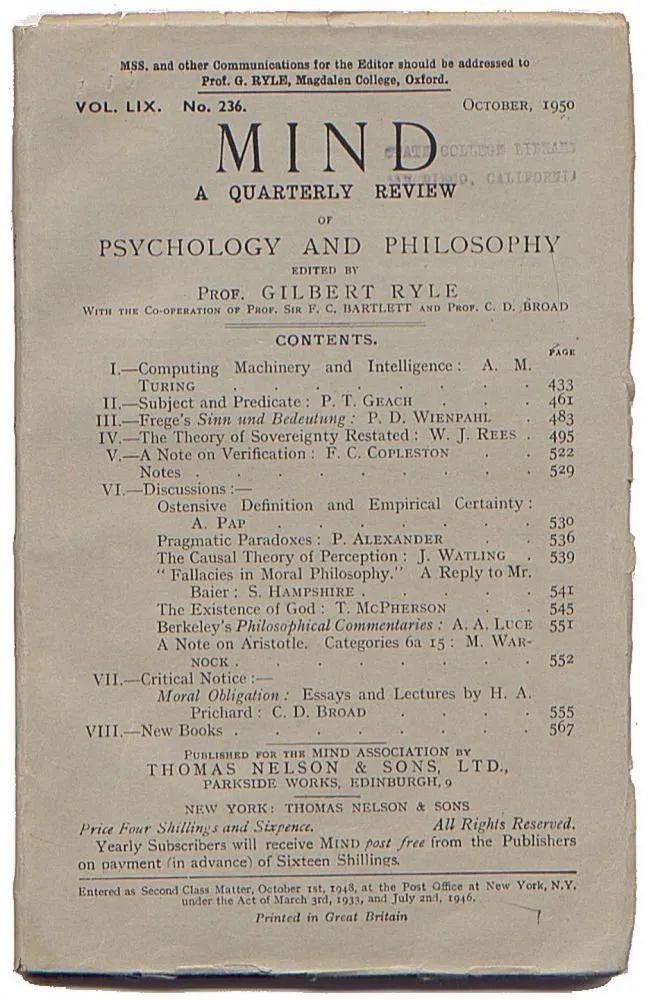

1950 年,第一台商用计算机还没有卖出去,光纤电缆还要等待 4 年才问世。但正是这一年,美国计算机科学家图灵在他一篇名为Computing Machinery and Intelligence 的论文中,提出了判断机器是否具有智能的一套方法。这套方法诞生的 6 年后,人工智能这个词语才被提出。

图片出处:manhattanrarebooks

图灵测试是回答 “机器能思考吗” 这一问题的最早尝试之一。它并不复杂。只需要将作为测试者的人类和作为被测试者的机器间隔开来,然后和机器进行一系列随机的问答,多次测试后,如果有超过 30% 的人类测试者不能确定出被测试者是人还是机器,那么,这台机器就通过了测试,可以认为具有人工智能。

诞生之后,图灵测试几乎成为 AI 界的 “北极星”。60、70 年代最早的聊天机器人 ELIZA 和 PARRY,便是围绕着通过这个测试而展开的。直至今日,图灵测试都还在发光发热,继续推动着该领域的想象力。2019 年谷歌在其年度开发大会上展示的 Duplex 语音助手,以及 2020 年横空出世的 OpenAI GPT-3 语言模型,都相继掀起了它们很有可能通过图灵测试的热烈讨论。

图灵在发表了图灵测试的相关论文之后,还曾预测,到 2000 年,这个模仿游戏就能实现。

显然,作为亲历过 2020 年的人类,我们已经可以否定这个预测。20 年过去了,整个行业还不能实现这个目标,虽然此时此刻,你我手机上的计算能力已经是阿波罗 11 号的 10 万倍,再加上云计算和高带宽,算法可以在几秒钟内根据海量数据做出决策。

而令一些 AI 科学家感到迷惑的是,图灵测试越来越不像一个“有用”的目标。

对于现实的应用,已经不合时宜了吗?

最近,亚马逊语音助手 Alexa 部门的首席科学家 Rohit Prasad 就分享道,作为 Alexa 的造物主之一,自己经常被人问道:“Alexa 何时能通过图灵测试?”

他苦恼的是,图灵测试固然是一种衡量 Alexa 智能的方法论,但这把标尺是否具有相应的意义和相关性?

他发现,当人工智能以前所未有的速度变得无处不在,愈发明显的是,人们更关心他们与机器的互动是否是有用的、流畅的(即机器的存在感尽量降低到最小),而非机器与人类之间有无差别。也就是说,图灵 70 年前提出的这个说法,是与该现实状况脱节的。

图灵测试几乎全盘否定了人工智能的机器属性,特别是快速计算和信息查询,而这些功能正是当代人工智能最有效的部分。

Rohit Prasad 用一个简单的场景作为例子,以否认图灵测试所强调的欺骗人类意味价值不大:机器要想通过图灵测试,就必须在回答 “你知道 3434756 的立方根是多少吗?” 或 “西雅图离波士顿有多远?” 等问题时,加入停顿语气。

即便人工智能的真实能力是它瞬间就知道了这些答案,但为了更像人类,它必须停顿。但停顿,显然不是对它技能的最大化利用。此外,图灵测试也没有考虑到人工智能使用传感器来听、看和感受外部世界的能力会越来越强。相反,它仅仅局限于语言文字叙述。

作为一款 AI 产品的负责人之一,Rohit Prasad 的 “控诉” 不无道理。当人工智能深度渗透到人们的日常生活,我们对它们的期待,是这些系统能够高效地完成大量的日常任务。

如果你要求 AI 助手关闭车库的灯,你可能并不希望和它进行对话。相反,你会期待它完成这个请求,并反馈一个简单的确认,例如 “确定” 或 “完成” 来告知你即可。即使你与 AI 助手聊热门话题,或者给孩子读一个故事,你也希望知道它是一个 AI,而不是人类。事实上,通过假装成人类来 “愚弄” 用户会带来真正的风险。

虽然图灵最初的设想依然鼓舞人心,但将这一测试解读为人工智能进步的终极标志,会有哪些局限性?

图灵测试的几大疑问

图灵测试自然不是一个完美的产物,其中一些局限性,图灵本人在他的开创性论文中也进行了讨论。

包括上文所提到的机器属性。由于机器必须与人类在 QA 表现上几乎无二致,所以它必然会犯错误。图灵本人在他的原始论文

中明确指出了这一点:“这台机器不会试图对算术问题给出正确的答案。它会以一种故意混淆审问者的方式引入错误。”

注意,在这里,图灵专门点出了算术问题,但我们可以将他的逻辑扩展到其他的错误类型。还有一种 “错误”,图灵可能没有预见到,那就是机器对人类凭直觉做出的言行出了过于清晰的解释。爱丁堡大学创办世界上第一个人工智能系的 D. Michie,便在他写于 1992 年的 Turing’s Test and Conscious Thought 一文中,将这种类型的错误称为 “超显性”(superarticulacy)。Michie 的观点涉及到人的潜意识的存在,人的潜意识是难以被语言化或者形式化的,而按照程式和代码进行运算的机器恰好与之相反。

“如果一种考试迫使考生通过隐藏智力来证明智力,那么人们肯定会认为这个考试是有瑕疵的”,他如此写道。

对图灵测试还有一种批判,立足于定义一种最容易通过测试的机器类型,也就是找到图灵测试最能鼓励哪一类机器产生。这种观点认为,暴力算法机器(brute force machines)会是大赢家。

有趣的是,这种声音大部分来自哲学家,他们认为,只检查机器的输出是 图灵测试的一大缺陷。这些批评中,最著名的一个理论是 美国哲学家 John Searle 的 “中文房间问题(Chinese room argument)”。

上世纪八十年代, Searle 在 1980 年论文In Behavioral and Brain Sciences 中设计了这个著名的思想实验,试图对图灵测试的设计进行强有力的反击。该实验的具体内容是,假设存在一个房间,房间中有一个完全不懂中文的人,但是房间中同时存在一个窗户,供这个人而他与外界沟通,连接的方式是传递纸条。房间内还会有一套中文汉字卡片和一本中文规则书,告知这个人如何使用和组合汉字卡片。此时,安排屋外的人向这个人传递纸条,纸条上附有中文撰写的问题。由于屋内人有一本完美的规则书,他可以在保持丝毫不懂任何中文的状态下,按照规则书的指导,正确选择并组合汉字卡片,并流畅地回答该问题。那么,屋外的人便有充分理由认为,屋内之人一定通晓中文。

“中国屋论证” 的提出,实际上便是这位哲学家对人工智能领域表现出的功能主义倾向的批判。

而另一大类来自哲学家的质疑,主要围绕人类对自身智力的认知而展开。

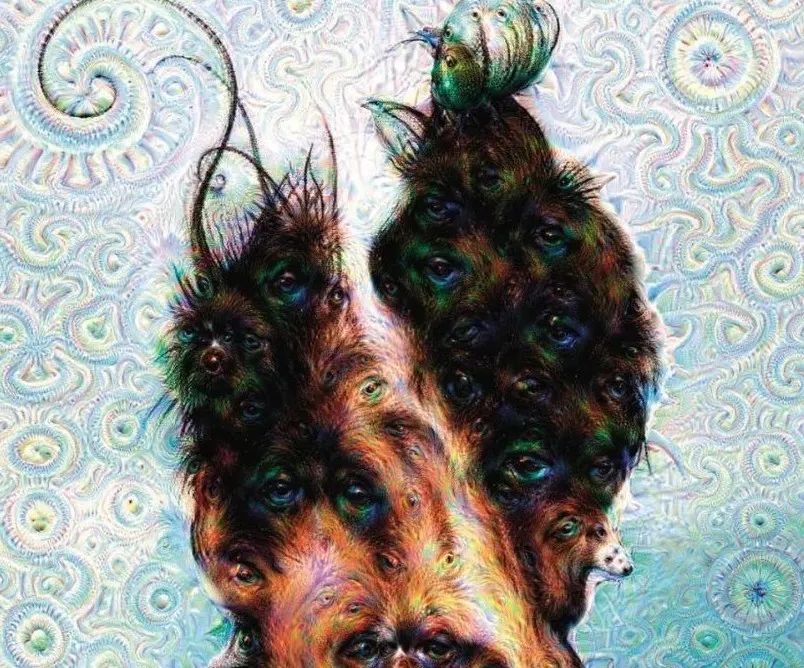

在图灵测试中,人类测试者只通过语言与机器交互,这里面不包含任何视觉或物理接触。一方面,这种互动的方法似乎是公平的,我们不应该仅仅因为机器看起来不像人类,就给机器贴上非智能的标签。另一方面,语言是否足以捕捉人类拥有的所有类型的智力?已经有不少的证据表明,语言并不等于人类的全部智力。如果再将这些问题放大,图灵测试能不能检测非人类智力?

图片出处:谷歌 AI 生成

图片出处:谷歌 AI 生成

这些疑问都仍处于现在进行时的阶段。有这些争议存在,也恰恰证明了图灵测试仍然很有价值,毕竟它基于这样一个坚实的基础性事实:语言也许就是我们所拥有的最好的智力的外在表现。

现在是时候让这个激励了该领域 70 年的 “都市传说” 退休了吗?这是一个开放的问题。正值下一个 10 年开启,如果真的有新的挑战能够拿下图灵测试的接力棒,也不失为一个好消息。

References:

1、https://www.fastcompany.com/90590042/turing-test-obsolete-ai-benchmark-amazon-alexa

2、https://academic.oup.com/mind/article/LIX/236/433/986238

关于数据实战派

数据实战派希望用真实数据和行业实战案例,帮助读者提升业务能力,共建有趣的大数据社区。

这篇关于图灵测试诞生70年,是时候下岗了吗?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![业务中14个需要进行A/B测试的时刻[信息图]](https://img-blog.csdnimg.cn/img_convert/aeacc959fb75322bef30fd1a9e2e80b0.jpeg)