本文主要是介绍【hugging face】bitsandbytes中8 bit量化的理解,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

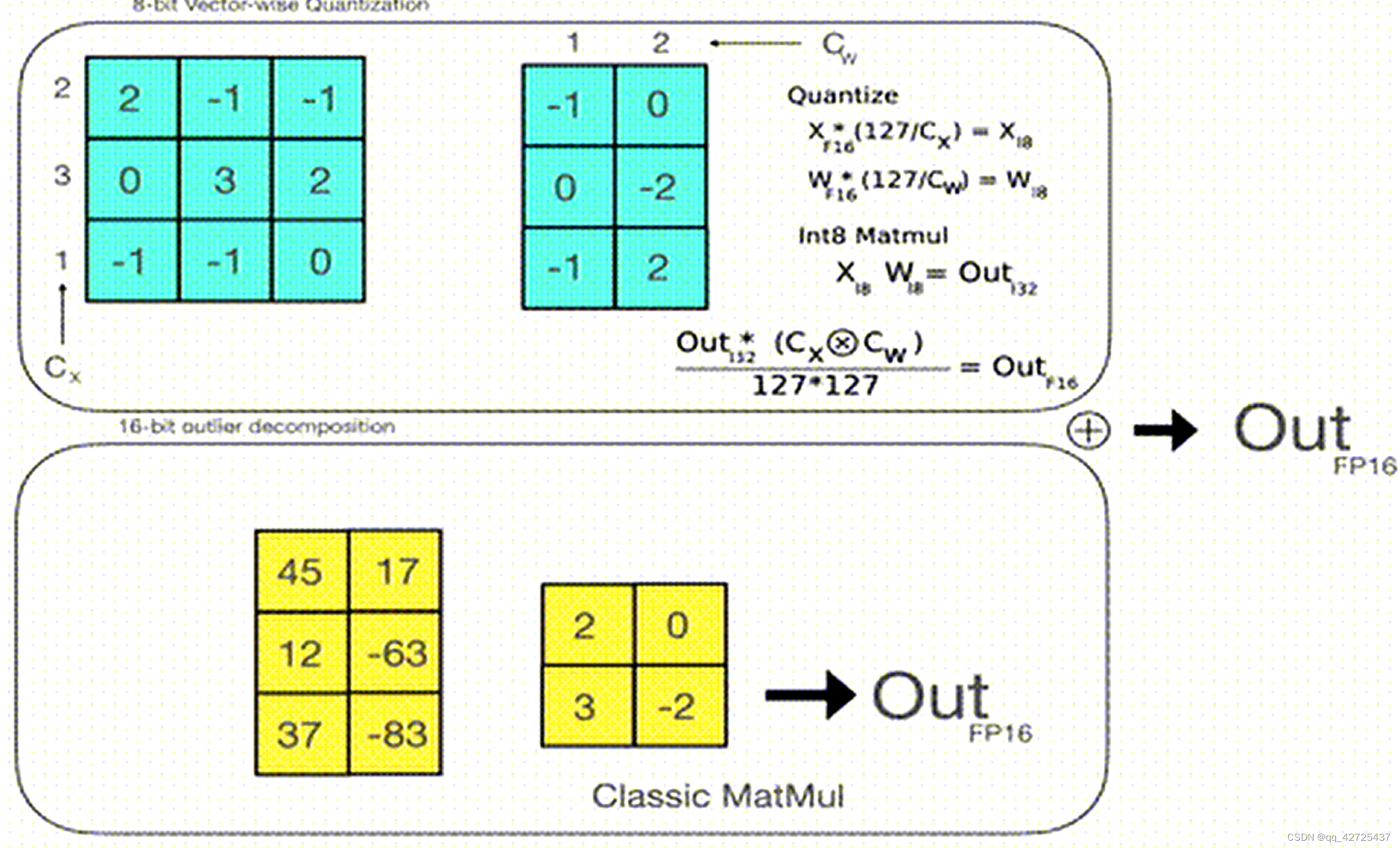

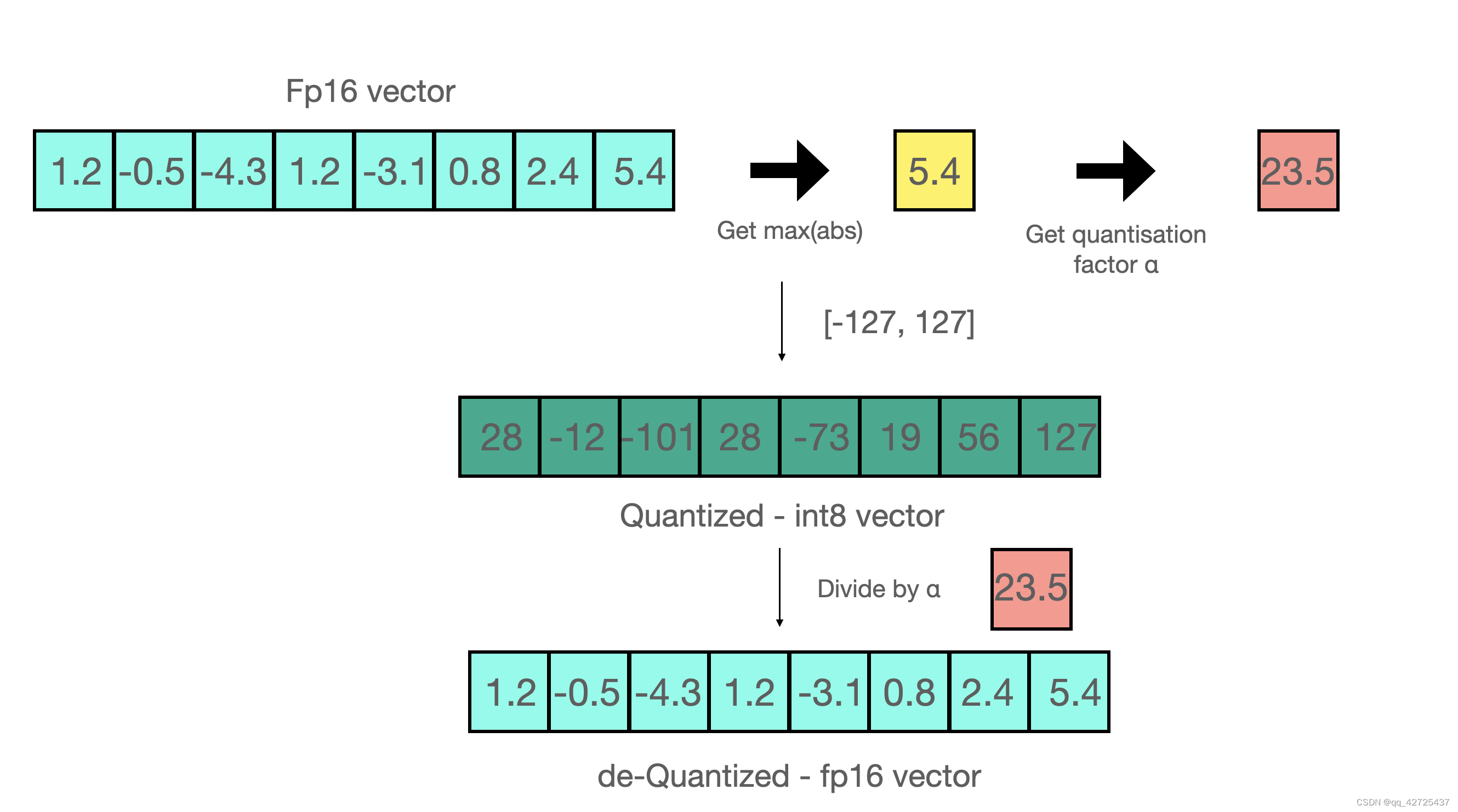

8 位量化使数十亿参数规模的模型能够适应更小的硬件,而不会降低性能。 8 位量化的工作原理如下:

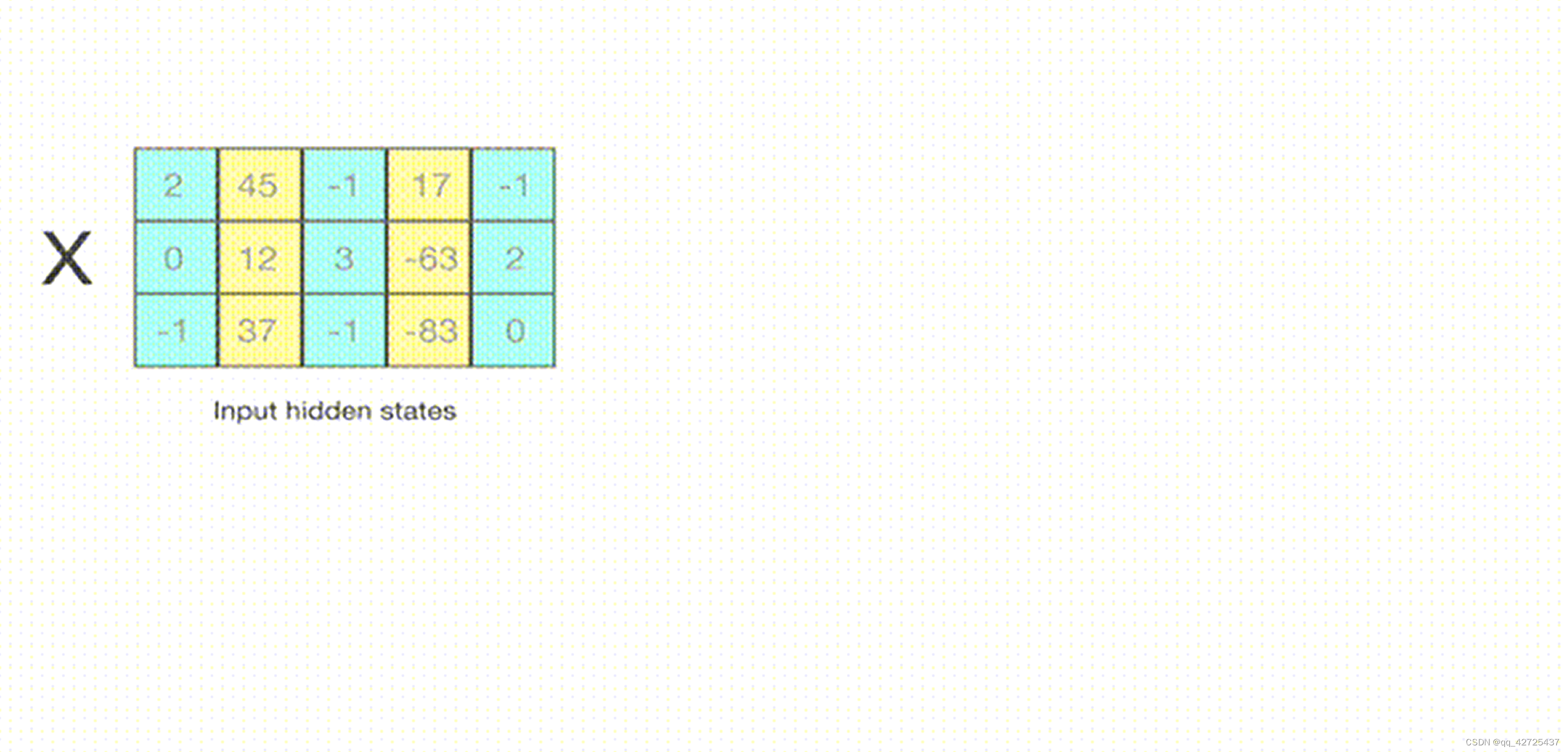

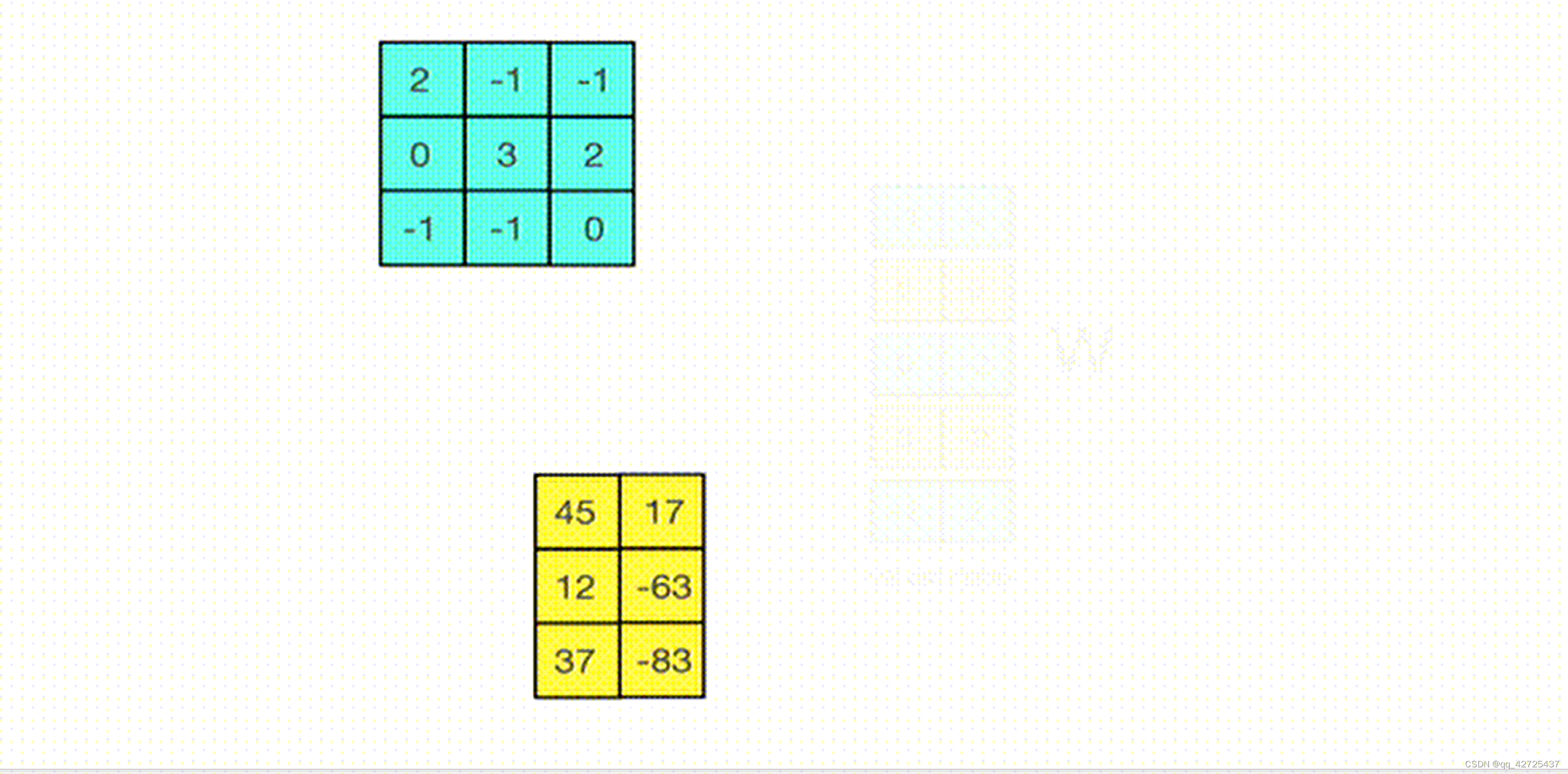

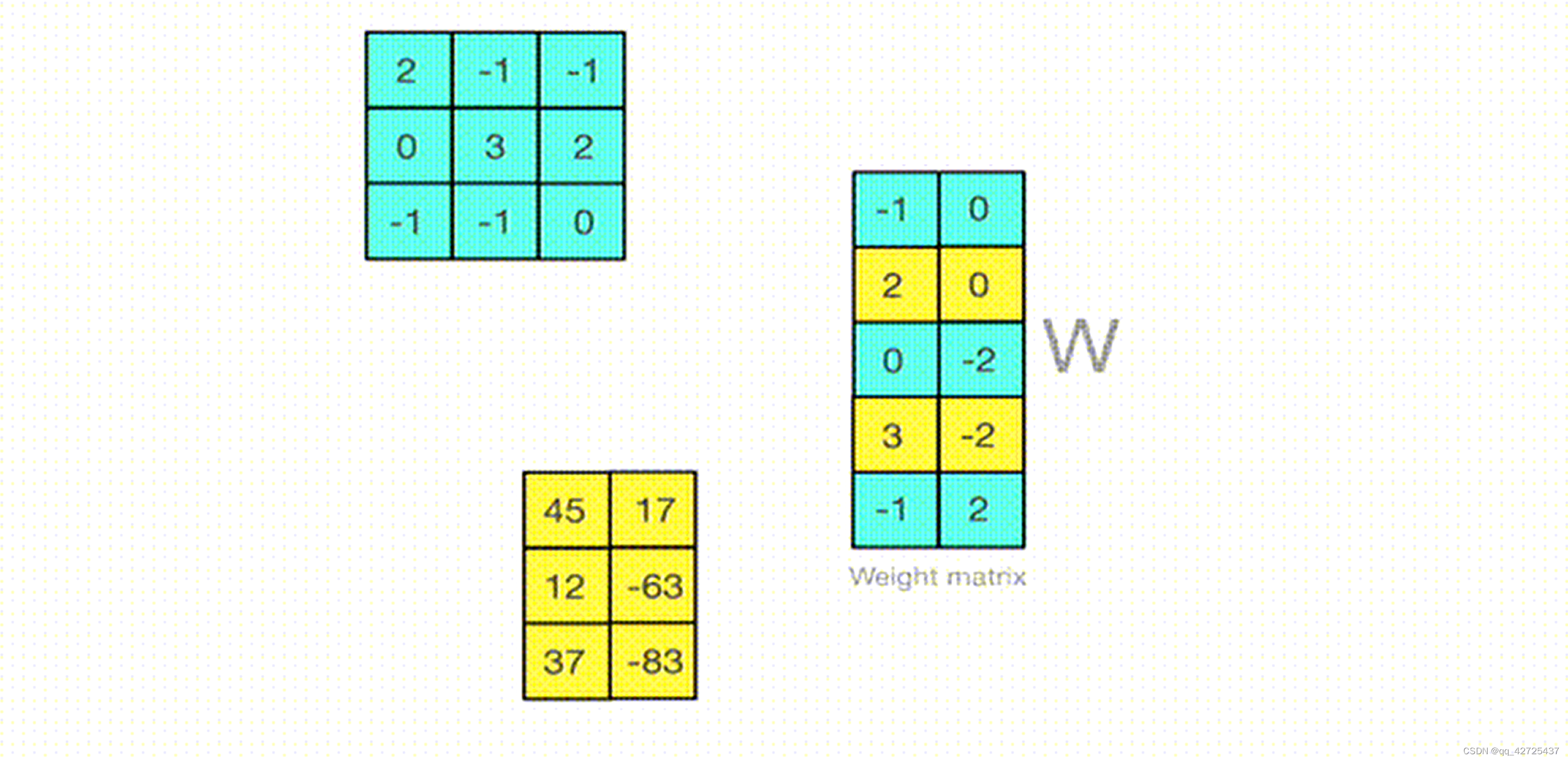

1.从输入隐藏状态中按列提取较大值(离群值)。

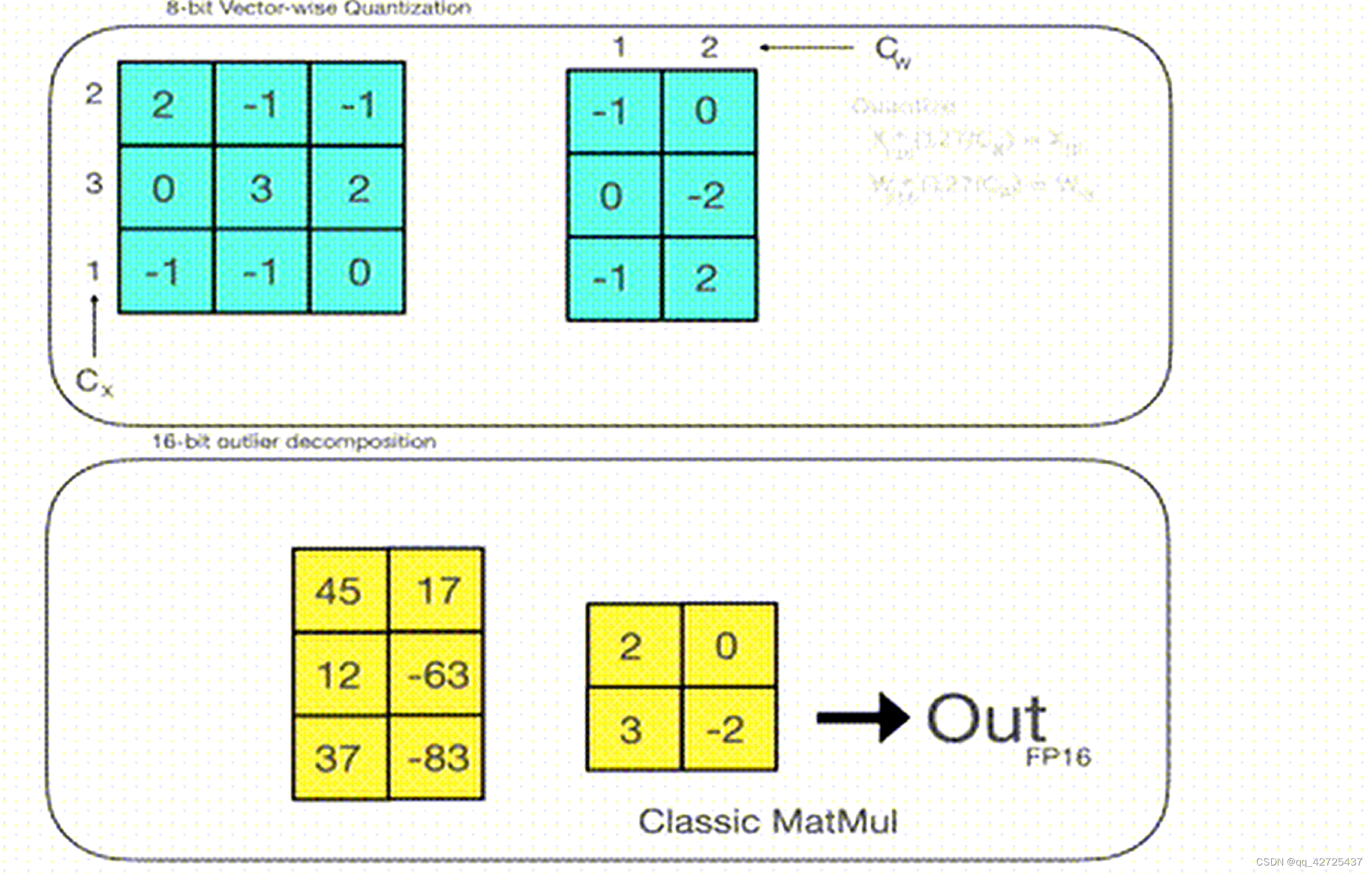

2.对 FP16 中的离群值和 int8 中的非离群值执行矩阵乘法。

3.改变非异常值结果以将值拉回到 FP16,并将它们添加到 FP16 中的异常值结果中。

因此,本质上,我们执行矩阵乘法以节省精度,然后将非异常值结果拉回到 FP16,而非异常值的初始值和按比例缩小后的值之间没有太大差异。你可以看下面的例子

这篇关于【hugging face】bitsandbytes中8 bit量化的理解的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!