本文主要是介绍1文件+2个命令,无需安装,单机离线运行70亿大模型,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

1文件+2个命令,无需安装,单机离线运行70亿大模型

大家好,我是老章

最近苹果发布了自己的深度学习框架--MLX,专门为自家M系列芯片优化。看了展示视频,这个框架还能直接运行Llama 7B的大模型,在M2 Ultral上运行流畅。但是我尝试了一下,我的M2 Mac mini根本跑不动,模型权重太大了。

这倒勾起了我继续单机玩大模型的兴趣,然后就发现了llamafile的玩法:下载模型文件、直接执行即可浏览器中运行,就可以开始聊天,还可以上传图片进行提问。

先不介绍原理,直接看看如何运行吧:

1、下载llava-v1.5-7b-q4-server.llama 文件(对应模型是[LLaVA 1.5](https://llava-vl.github.io/),在 Llama 2 之上进行微调的大型多模式模型 )

下载地址:https://huggingface.co/jartine/llava-v1.5-7B-GGUF/resolve/main/llava-v1.5-7b-q4-server.llamafile?download=true

鉴于有些同学可能无法访问huggingface,我也准备了这个文件在网盘,有需要可以找我要一下。

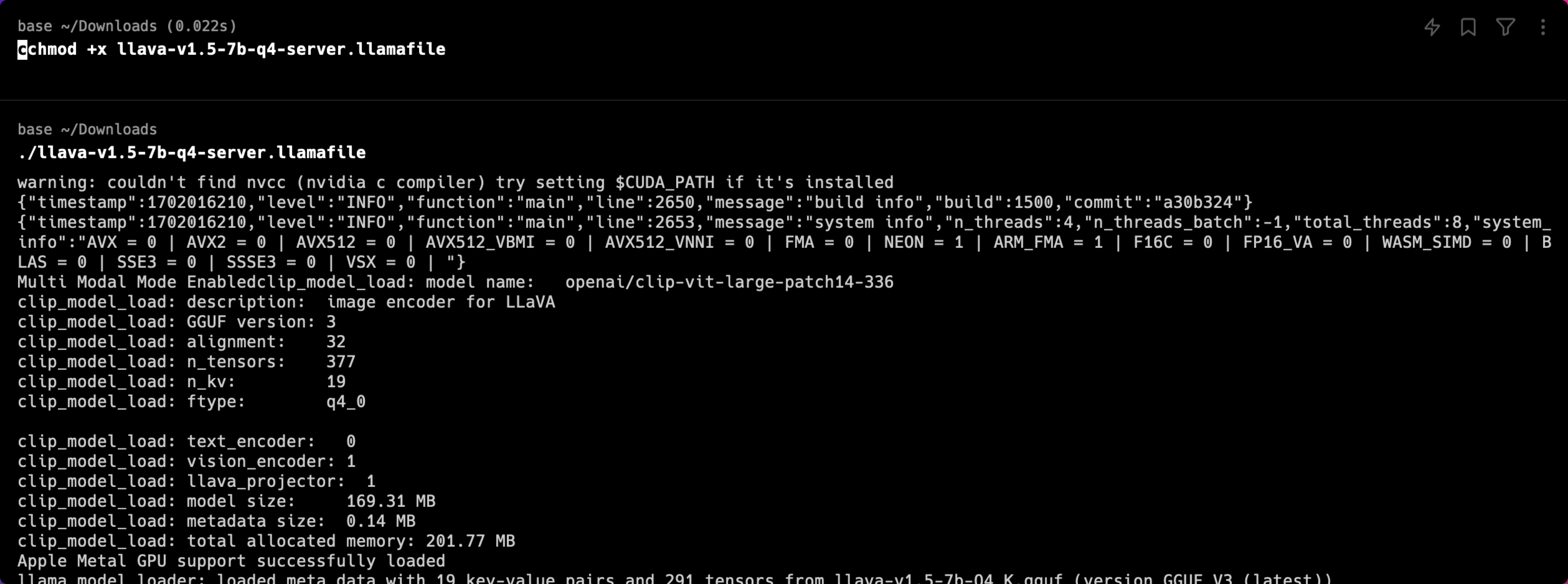

2、MacOS和linux用户需要在命令行中先授权这个文件可执行

```

chmod +x llava-v1.5-7b-q4-server.llamafile

# 然后运行

./llava-v1.5-7b-q4-server.llamafile

```

如果是windows用户,那就更省事了,直接重命名这个文件,后面加上 .exe 即可

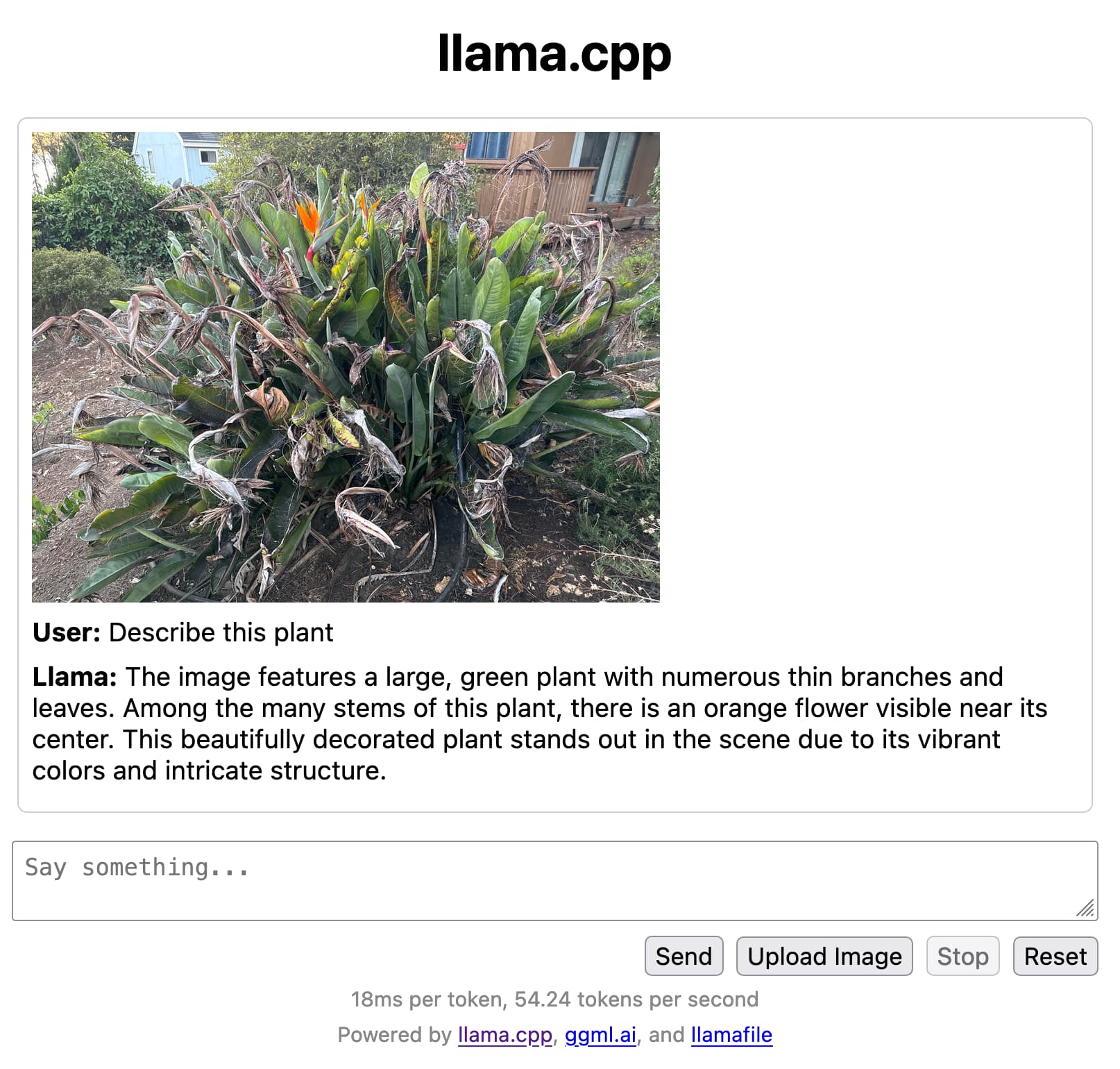

3、浏览器会自动弹开聊天界面(如果没有,浏览器中直接打开[https://localhost:8080](https://localhost:8080/)即可)

首次打开需要配置一些参数,也可以直接使用默认值。

除了聊天,也可以上传图片让它识别。聊天完毕后,返回终端并点击 Control-C关闭 llamafile。

顺便简单介绍一下llamafile:

这个大模型文件是Mozilla 团队发布的,这个文件包含 LLM 的模型权重和运行该模型所需的代码 ,可以将它视为一个完整的本地服务器,带有用于与其交互的 Web UI。

llamafile是基于[llama.cpp](https://github.com/ggerganov/llama.cpp)(一个领先的开源 LLM 聊天机器人框架)和[Cosmopolitan Libc](https://github.com/jart/cosmopolitan)(一个开源项目,使 C 程序能够在大量平台和架构上编译和运行)实现的。使用 llamafile,可以将大型语言模型 (LLM) 权重文件转换为可在六种操作系统(macOS、Windows、Linux、FreeBSD、OpenBSD 和 NetBSD)上运行的二进制文件,而无需安装,确保给定的一组权重将永远保持可用并一致且可重复地执行。

想要了解更多,可以参考一下资料:

模型演示:https://llava.hliu.cc/

模型简介:https://llava-vl.github.io/

模型代码:https://github.com/haotian-liu/LLaVA

llamafile开源地址:https://github.com/Mozilla-Ocho/llamafile

llamafile简介:https://hacks.mozilla.org/2023/11/introducing-llamafile/

这篇关于1文件+2个命令,无需安装,单机离线运行70亿大模型的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!