本文主要是介绍国内高速下载huggingface上的模型,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

前言

modelscope

huggingface安装

Windows设置环境变量

Linux设置环境变量

设置国内镜像

Windows(cmd.exe)

当前窗口有效

永久生效

Linux

当前窗口有效

永久生效

下载模型

前言

国内优先使用modelscope,hugging face镜像站下载还是不怎么稳定。

modelscope

modelscope:ModelScope - 模型列表页

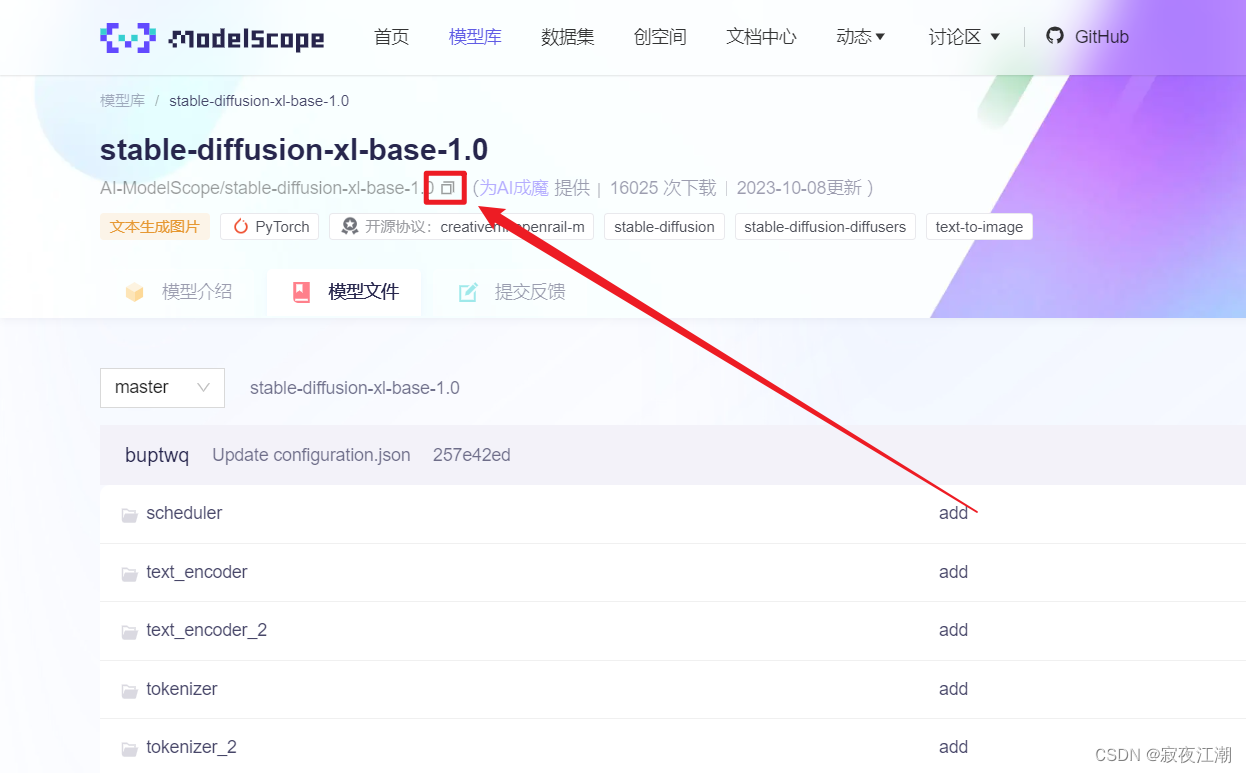

找下有没有需要的模型,有的话拷贝下 <namespace>/<model-name>,如图:

使用git clone:

git lfs clone https://www.modelscope.cn/<namespace>/<model-name>.git 比如我要下的是AI-ModelScope/stable-diffusion-xl-base-1.0,那么链接就是:

git lfs clone https://www.modelscope.cn/AI-ModelScope/stable-diffusion-xl-base-1.0.git

huggingface安装

Python版本至少是3.8

安装hugging face官方提供的下载工具

pip install -U huggingface_hub hf-transferWindows设置环境变量

在当前窗口设置临时环境变量(cmd.exe)

set HF_HUB_ENABLE_HF_TRANSFER 1你也可以设置永久的环境变量(可能需要管理员权限)

setx HF_HUB_ENABLE_HF_TRANSFER 1Linux设置环境变量

只是当前窗口下有效

export HF_HUB_ENABLE_HF_TRANSFER=1设置国内镜像

Windows(cmd.exe)

当前窗口有效

set HF_ENDPOINT https://hf-mirror.com永久生效

setx HF_ENDPOINT https://hf-mirror.comLinux

当前窗口有效

export HF_ENDPOINT=https://hf-mirror.com永久生效

# 配置环境变量

vim ~/.bashrc# 在打开文件中的最后一行添加

export HF_ENDPOINT="https://hf-mirror.com"

下载模型

huggingface-cli download --token [访问令牌] --resume-download --local-dir-use-symlinks False [模型名] --local-dir [保存位置]如果你使用的是conda,注意看下有没有切换对应的环境!!!

有些模型不需要token也能直接下载!!!把token选项去掉即可

访问令牌获取链接:https://huggingface.co/settings/tokens

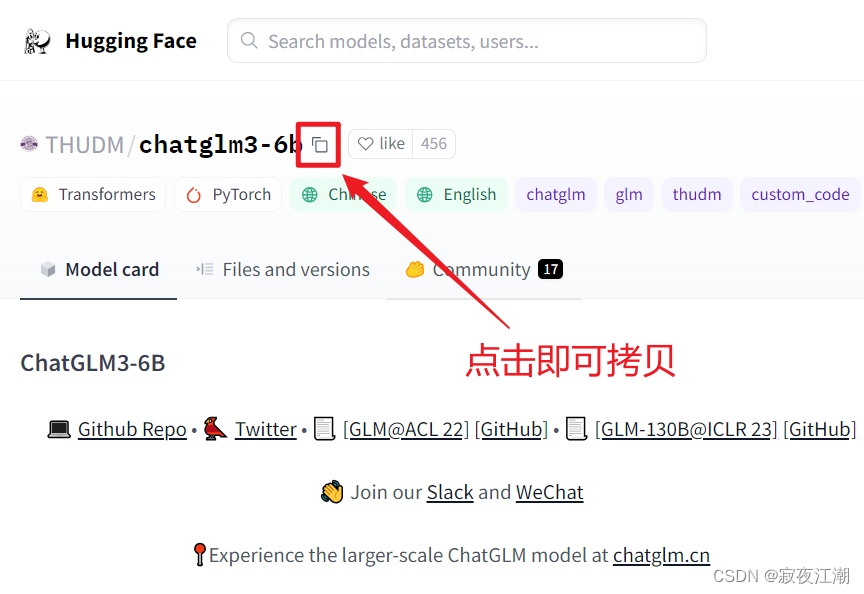

比如我要下载ChatGLM的模型,操作如下:

命令如:

huggingface-cli download --resume-download --local-dir-use-symlinks False THUDM/chatglm3-6b --local-dir chatglm3-6b

参考文章

- 如何快速下载huggingface大模型 – padeoe的小站

- hf-mirror.com - Huggingface 镜像站

👍点赞,你的认可是我创作的动力 !

🌟收藏,你的青睐是我努力的方向!

✏️评论,你的意见是我进步的财富!

这篇关于国内高速下载huggingface上的模型的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!