本文主要是介绍使用Scrapy网络爬虫框架小试牛刀,爬取某某百科。,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理

本文章来自腾讯云 作者:Python进阶者

想要学习Python?有问题得不到第一时间解决?来看看这里“1039649593”满足你的需求,资料都已经上传至文件中,可以自行下载!还有海量最新2020python学习资料。

点击查看

前言

这次咱们来玩一个在Python中很牛叉的爬虫框架——Scrapy。

scrapy创建爬虫项目

命令

scrapy startproject <项目名称>

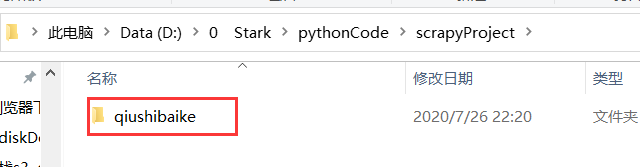

示例:创建一个糗事百科的爬虫项目(记得cd到一个干净的目录哈)

scrapy startproject qiushibaike

注:此时,我们已经创建好了一个爬虫项目,但是爬虫项目是一个文件夹

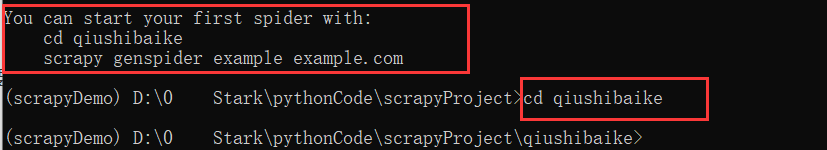

进入爬虫项目

如果想要进入这个项目,就要cd进这个目录,如上上图所示,先cd <项目>,再创建蜘蛛

项目目录结构解析

此时,我们就已经进入了项目,结构如下,有一个和项目名同名的文件夹和一个scrapy.cfg文件

scrapy.cfg # scrapy配置,特殊情况使用此配置

qiushibaike # 项目名同名的文件夹items.py # 数据存储模板,定制要保存的字段middlewares.py # 爬虫中间件pipelines.py # 编写数据持久化代码settings.py # 配置文件,例如:控制爬取速度,多大并发量,等__init__.pyspiders # 爬虫目录,一个个爬虫文件,编写数据解析代码__init__.py

呃,可能此时你并不能懂这么些目录什么意思,不过不要慌,使用一下可能就懂了,别慌。

创建蜘蛛

通过上述的操作,假设你已经成功的安装好了scrapy,并且进入了创建的项目

那么,我们就创建一个蜘蛛,对糗事百科的段子进行爬取。

代码解释如下

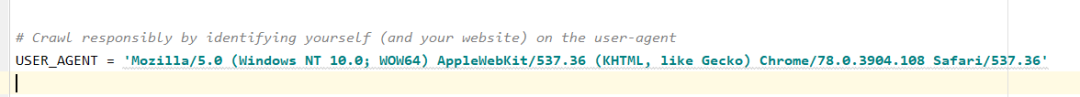

Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36

我们需要这样写

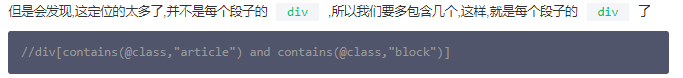

xpath代码

//div[contains(@class,"article")]

xpath代码

//div[contains(@class,"article") and contains(@class,"block")]//a[@class="contentHerf"]

这样,我们就定位了一个个a标签,只至少在控制台操作是没问题的,那么,我们使用Python代码操作一下吧

代码

def parse(self, response):a_href_list = response.xpath('//div[contains(@class,"article") and contains(@class,"block")]//a[@class="contentHerf"]/@href').extract()print(a_href_list)

启动蜘蛛命令

scrapy crawl <爬虫名> [--nolog]

获取详情页内容

在上述,我们成功的获取到了每个段子的链接,但是会发现有的段子是不全的,需要进入进入详情页才能看到所以段子内容,那我们就使用爬虫来操作一下吧。

我们定义一下标题和内容。

根据元素审查,标题的定位xpath是:

//h1[@class="article-title"]

内容的xpath是:

//div[@class="content"]

确定标题和内容的xpath定位之后,我们在python代码中实现一下。

注:但是先解决一个问题,详情页属于第二次调用了,所以我们也需要进行调用第二次,再编写代码

代码

# 详情页

def detail(self, response):title = response.xpath('//h1[@class="article-title"]/text()').extract()content = response.xpath('//div[@class="content"]//text()').extract()print("标题:" )print(title)print("内容")print(content)def parse(self, response):a_href_list = response.xpath('//div[contains(@class,"article") and contains(@class,"block")]//a[@class="contentHerf"]/@href').extract()print(a_href_list)base_url = "https://www.qiushibaike.com"for a_href in a_href_list:url = f"{base_url}{a_href}"yield scrapy.Request(url=url, callback=self.detail)

结果

但是会发现啊,似乎每个都是列表形式,这似乎不太行呐,我们稍微修改一下代码,这样我们拿到的就是正常的文本了,如下图所示:

这篇关于使用Scrapy网络爬虫框架小试牛刀,爬取某某百科。的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!