本文主要是介绍Actor and Action Video Segmentation from a Sentence,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

CVPR2018 Oral的一篇关于跨媒体(Video与NLP结合)的文章,paper链接 https://arxiv.org/abs/1803.07485,一作是荷兰阿姆斯特丹大学的PHD,作者的homepage https://kgavrilyuk.github.io/,code和datasets还没有被released出来。

个人瞎扯:这是我见过的第一篇发表出来的用NLP做video segmentetion的文章,其实还有一篇已经挂载arxiv上面了,现在应该是在投ECCV 2018。

文章要做的事情(video segmentation from a sentence)

输入:sentence+video dataset 输出:video mask

可视化的分割结果如下所示。

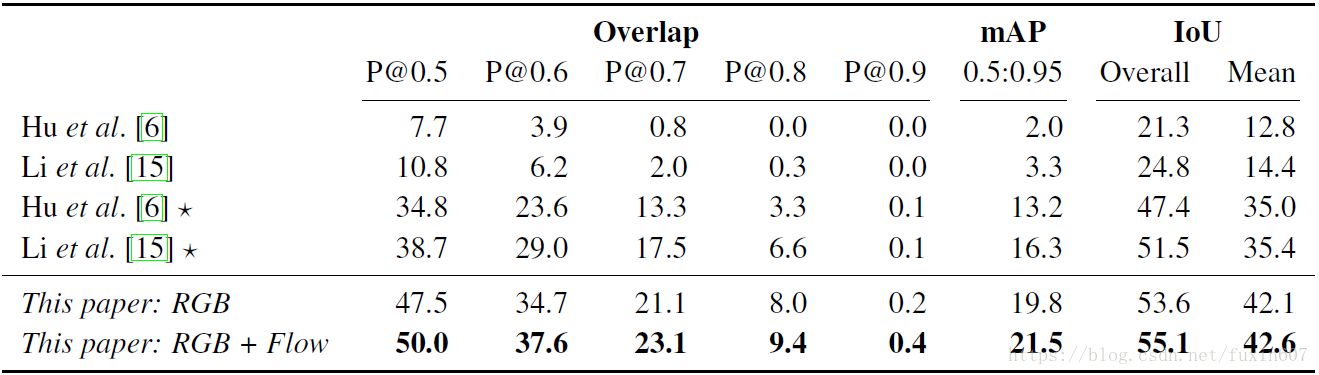

与state-of-the-art方法定量的对比结果如下所示。

method

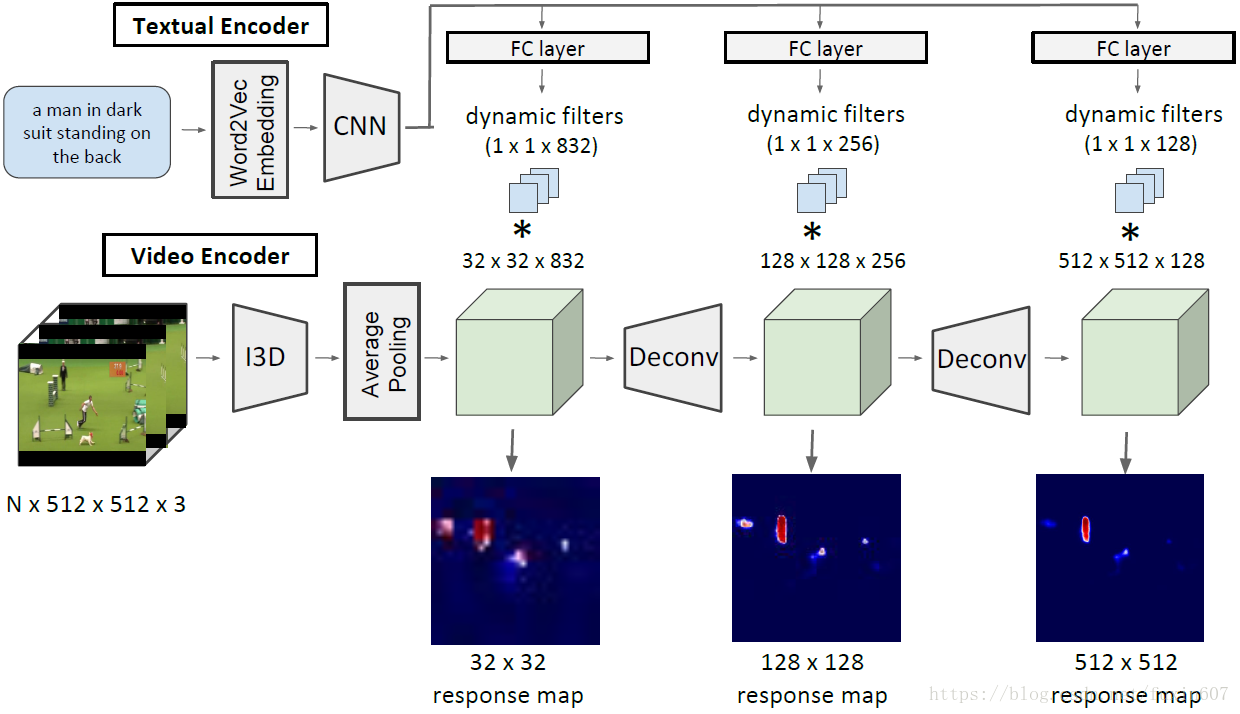

video segmentation from a sentence framework如下所示。

从这个framework中可以看出,文章主要分为三部分。

- sentence encoder。首先加padding使所有的sentence长度一样,然后用在Google News dataset上面做fine-tuning的模型提取300-300-Dim的word2ver向量,然后在用1-Dim CNN提取feature。文章在ablation study中做过分析,1-Dim CNN比vanilla LSTM和bidirectional LSTM效果都要好。

- video encoder。同样是先加padding使所有video的frame一样长,然后再用I3D encoder video,其中有两个trick。

– 1.在feature map的空间位置上面做L2 Norm。

– 2.把空间位置作为额外的通道学习空间关系(qualifiers),例如left of,above等等。 - video mask decoder。直接在video representation基础上采用deconvolutional neural network(kernel size 8 x 8 and stride 4, followed by a convolutional layer with a kernel size of 3 x 3 and a stride of 1),分别采用3个scale(32x32,128x128和512x512)的response map做loss function,highest-resolution response map是final segmentation prediction,其中也有两个trick。

– 1.tanh activation function and L2-normalization on the features。

– 2.dynamic filters。

这篇关于Actor and Action Video Segmentation from a Sentence的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!