本文主要是介绍Learning Deep Features for Discriminative Localization 笔记2,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

链接:https://www.zhihu.com/question/67987641/answer/258570104

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

不知道用文科生的视角解读是不是意味着不能再中英混杂装逼了……

anyway。

本文的动机如下:

曾经有人提出过一个方法叫做global average pooling(GAP),之前大家是用它来“正则化训练的”,这个的意思就是说让训练的结果更具有泛化性。例如,我希望在室内场景狗的数据集训练的模型可以也能拿来识别室外的狗。

然而,然而,然而。作者就是不拿GAP来干这个事情。

曾经,有一些工作将深度学习结果用容易理解的图的形式表示出来(如作者用到的热力图),帮助人们理解深度网络在训练的过程中到底在干什么。

我打赌这篇的作者就是用了以上的可视化途径去看用了GAP以后,深度网络的层的输出有了什么规律,于是,他惊奇的发现,原来GAP帮助深度网络提高泛化力的同时,还能定位与目标类别相关的位置,啊哈,又TM能去顶会灌水了...啊呸....又能为学术界提供强有力的insight了。

举例来说就是这样。

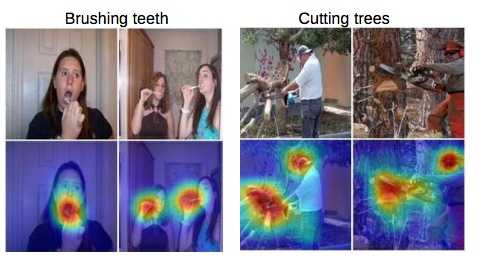

图片的标签告诉我们,女人在刷牙,大爷在砍树。用了作者的方法,再可视化成热力图,我们发现原来深度网络之所以判断正确,是因为它们的“关注点”跟人一样,在这些位置。这些位置上的信息帮它把刷牙的动作认出来,而没有认错成砍树。

那么,以前分类效果超好的深度网络为啥没发现呢?因为它们最后一层是全连层。全连层的缺点是啥?它不把图片当图片看啊,直接把人家拉成一条向量,位置信息自然就丢失咯 。GoogleNet认识到这个问题,人家就不去用全连层啦,人家开始用全都是卷积层的网络来搞分类任务啦。

那么,作者现在最想做的事情就是,如何告诉大家,使用全卷积网络和GAP来标记与识别目标相关的位置信息。

我假设一下你对深度网络如何模仿人的生理系统,大脑,有了一定认识基础,毕竟你上过课嘛。其实就是网络中的每个单元结构在模仿神经元,而在识别不同物体的时候,不同的神经元组合会被激活。放在网络里说就是某些单元在识别某个目标的时候输出值很大,例如我受了刺激我就会发飙疯狂输出能量。

作者就是要把这些受刺激的网络单元对应不同的识别目标分别找出来,再用热力图画出来。看看在空间上和人的认知是否吻合。

于是呢,问题就简单了,我们就去训练这么一个带GAP的全卷积网络。

再去把每一相同类别的图片输入网络,最后的一层(softmax)不是会告诉我每一类别的权重(置信度)吗?我就把我感兴趣的那一类的权重拿过来,跟前面的卷积层的对应单元的输出加权求和。

也就是说,把softmax层第k个位置上会有一个权重w,而且是针对类别c的权重。前面的的卷积层的某单元的激活值为f,它可以与原始图像的像素位置(x,y)形成一个映射的,怎么形成的,请看别的论文,一些博客都解释得可以了。我们把这个映射值记为f(x,y)。假设它激活了,那么w*f(x,y)的值就应该很大。

但是除了第k的单元贡献最多,其他单元可能也有贡献啊,那不如就把它们都求个和?就成了作者的CAM映射。

至此,结合点化热力图的知识你的图就应该会画了。

至于结果....这么个发现直接投太灌水了,不行,作者说我要调调参,做分类任务,诶我勒个擦没干过Alex Net!淡定淡定,想想为啥。哎呀妈呀bias我都设为0了当然干不过了啊!我要把bias加上看看,不对,不能加,加了还怎么扯motivation!

唉,反正就差那么一点点,reviewer喷我我就要说你看看,我insight多强!

为啥做弱监督分类啊?因为GAP自带泛化性啊,可以扯motivation啊!强监督我肯定干不过气其他的结构,还肯定差很远,想都懒得想。

如果我这么说你还没懂的话,我的假设,就是你上课好好听过的这个前提是崩了。那我咋说你都不会懂的咯这篇关于Learning Deep Features for Discriminative Localization 笔记2的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!