本文主要是介绍DeFMO: Deblurring and Shape Recovery of Fast Moving Objects,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

DeFMO: Deblurring and Shape Recovery of Fast Moving Objects

论文链接

一、摘要和介绍

摘要:

用相机拍摄高速移动的物体时,会明显模糊。而当拍摄的对象具有复杂的形状或纹理时,本就模糊的外观会更模糊。在这种情况下,一些经典方法甚至人类都无法恢复对象的外观和运动。该论文提出了一种方法,该方法在给定单个图像及其估计背景的情况下,在一系列子帧中输出对象的外观和位置,就像由高速摄影机(即时间超分辨率 temporal super-resolution)捕获一样。该生成模型将模糊物体的图像嵌入到潜在空间(latent space)表示,分离背景,并呈现出清晰的外观。受图像生成模型的启发,这篇论文设计了新颖的自监督损失函数项,提高了性能并表现出良好的泛化能力。所提出的DeFMO方法是在一个复杂的合成数据集上训练的,而且在来自多个数据集的真实数据上表现良好。DeFMO的性能优于现有技术,可生成高质量的时间超分辨率帧。

介绍:

在如今图像处理和计算机视觉任务中,图像的去模糊依然是一个具有挑战性的问题。而图像模糊的主要来源是相机快速运动和物体运动以及长曝光时间。现在已经提出了很多方法来解决去模糊,从图像去模糊到视频时间超分辨率等。然而这些方法都只考虑了由于摄影机运动、散焦摄影机或拍摄对象以中等速度移动而导致全局摄影模糊造成的低到中等模糊。

直到最近,才引入了用于快速移动对象(FMO)去模糊的专门算法[1,2,3]:

Restoration of Fast Moving Objects IEEE TIP, 29:8577–8589, 2020.

Intra-Frame Object Tracking by Deblatting In ICCVW, Oct 2019.

Sub-frame Appearance and 6D Pose Estimation of Fast Moving Objects In CVPR, pages 6777–6785, 2020.

FMO被定义为在相机曝光时间内(或在视频中的单个时间帧内)移动距离大于其大小的对象。

FMO检测在跟踪足球、网球或羽毛球等具有快速物体运动的运动时非常重要。在自动驾驶中,探测石头、鸟类或其他野生动物的撞击也是有益的。当捕获掉落或投掷的物体(如水果、树叶、飞虫、冰雹或雨水)时,经常会发现FMO。任何移动物体在弱光条件下或长时间曝光时都会变成FMO。换句话说,需要增加曝光时间或物体的速度来观察FMO。

我们考虑一个setting,输入一张图像,图像中的物体对象移动的很快因而显得很模糊。而我们把该图像想象成一个视频中的一个模糊帧,我们的任务就是重建假想的子帧。如果这是高速摄像机在相同时间间隔内拍摄的短视频,这些子帧就会出现。假设导致输入模糊帧的物理生成模型是基础sharp子帧的时间积分,每个sharp子帧具有更短的曝光时间。为了简化问题的复杂性,我们假设该图像的背景是给定的,例如,来自视频中的前几帧,或者作为没有对象时捕获的静态图像。实际上,前几帧的中间值效果很好。

上面的FMO去模糊的工作只考虑了相对简单的,主要是球形物体。而且之前的工作通常假设运动中的对象在所有子帧中具有恒定的外观。

这篇论文提出DeFMO–—第一个超越这些假设,通过处理快速移动物体的时变复杂外观,以3D旋转在3D轨迹上移动。DeFMO是一种生成模型,用于重建FMO的sharp轮廓和外观。首先,我们将模糊的快速运动物体从背景中分离到一个latent space中。然后,绘制网络的目标是在一系列的子帧中渲染sharp的物体(目标对象),即时捕获运动。网络在一个包含复杂、高纹理对象的合成数据集上进行端到端训练。由于受到FMOs图像生成模型的启发,采用了自监督损失函数项,该方法很容易推广到真实数据,如图1所示。

图1 时间超分辨率。 给定描述快速运动模糊对象和估计背景的输入图像,DeFMO将图像分解为一系列具有sharp对象轮廓的去模糊子帧。*

主要贡献:

1.提出了第一个用于FMO去模糊的完全神经网络模型,该模型弥补了FMO去模糊、3D建模和子帧跟踪之间的差距。

2.仅在具有新型自监督损耗的合成数据上进行训练,在FMOs的轨迹和清晰外观重建方面开创了一种新的技术状态。

3.引入了一个新的合成数据集,其中包含复杂的对象、纹理和背景。数据集和模型实现是公开的。

二、相关工作

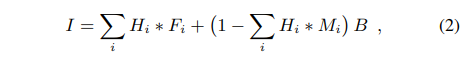

Fast moving objects在[3]中定义了,并设置了概念证明方法。模糊和消光(blatting)方程在[2,8]中被介绍为:

I = H ∗ F + (1 − H ∗ M) B, (1)

其中,由前景外观F和分割掩码M给出的sharp物体被模糊,并与背景B相结合。模糊核H是识别物体的轨迹,使|H| = 1。另一个约束条件是F≤M,即M(背景)中的0s意味着F中的0s。

blatting方程假设对象外观在一个视频帧内是静止的。与本文方法相反,物体也必须在平行于摄像机平面的二维平面上移动。Kotera等人[1]研究了平面FMO只在平行于摄像机平面的二维平面内旋转的特殊情况。在[4]中提出了一种改进的FMOs运动模糊先验。[5]中学习了FMO检测。

TbD-3D[3]方法取消了TbD的一些限制性假设,该方法假设分段恒定外观为:

其中索引 i 对应于整个轨迹 在一个坐标系 I 中的一部分。子帧外观 Fi 和mask Mi解释了潜在的旋转或变形对象。同时求解(2)中Hi, Fi Mi在实际计算中是不可行的。为了解决这个问题, TbD-3D[3] 通过首先假设一个简单的静态外观模型(1)来估计轨迹H,然后将轨迹分割成所需数量的片段,最后在保持轨迹固定的情况下估计第二次通过的子帧外观,从而求解出(2)中Fi, Mi。

在一个坐标系 I 中的一部分。子帧外观 Fi 和mask Mi解释了潜在的旋转或变形对象。同时求解(2)中Hi, Fi Mi在实际计算中是不可行的。为了解决这个问题, TbD-3D[3] 通过首先假设一个简单的静态外观模型(1)来估计轨迹H,然后将轨迹分割成所需数量的片段,最后在保持轨迹固定的情况下估计第二次通过的子帧外观,从而求解出(2)中Fi, Mi。

这篇论文认为以这种方式解决(2)是次优的,类似于鸡和蛋的问题,因为鲁棒轨迹估计需要建模的时变外观,反之亦然。因此,TbD- 3d强烈依赖于来自外部模块的初始弹道估计,如TbD或TbD- NC。实际上,TbD-3D只在物体具有普通形状(如球体)或外观(如统一颜色)时有效。

现如今已经提一些方法来从单个图像生成视频,但没有考虑到快速运动。模糊视频帧插值法、softmax splatting 或缩放慢动作 设计用于视频帧插值,以增加多个模糊输入的帧速率。然而,与FMO引起的运动模糊相比,所考虑的运动模糊还是很小的。

Classical deblurring methods已经取得了成功,如DeblurGAN-v2[7]、通过真实模糊进行的去模糊、使用深层先验进行的去模糊等。这些方法假设场景中的任何东西都可能模糊。此外,这些方法仅生成一个去模糊帧,这对于FMO是不够的,其中期望的结果是一组去模糊的高速子帧。在实验中,我们比较了DeblurGAN-v2[7]等论文方法。由于这些方法更通用,因此在专门研究的FMO引起的特定模糊情况下,它们的性能比这篇论文的差。

总之,所有现有的去模糊方法要么缺乏对FMOs的适当建模,要么严重依赖手工制作的先验,并对物体的形状和外观强加很强的假设。此外,目前的FMO去模糊方法是缓慢的,每帧需要几秒。它们还依赖于其他外部模块。为了解决这些问题,这篇论文的方法估计FMOs的复杂形状和外观,所有都在一个网络中,并实时运行。

三、去模糊模型

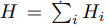

图2 DeFMO体系结构。 输入图像和估计的背景图像编码到潜在空间X, 然后,X随时间指标通道 t增强,并呈现为外观为F、mask为M的去模糊物体。.在同一绘制网络中,对多个时间指标同时生成效果图,并在时间上求平均值。在测试期间使用蓝色部分。

该方法的输入是:

RGB 图像 I : D ⊂ R2 → R3 ,其中包含模糊 FMO 和背景 B : D → R3 的估计值,其中不包括感兴趣的对象。在大多数情况下,视频流是可用的,B 可以估计为几个先前帧的中值,因为这样的操作将删除所有 FMO 。

所需的输出是在预定义的子帧时间索引 t ∈ [0, 1] 处对所有子帧的 FMO 的清晰渲染,

为此,估计了 4 通道 RGBA 渲染 Rt : D → R4 。这些渲染由 RGB 部分 Ft : D → R3(FMO 的sharp外观)和 alpha matting mask Mt:D → R(分割为前景 FMO 和背景,图 2)组成。

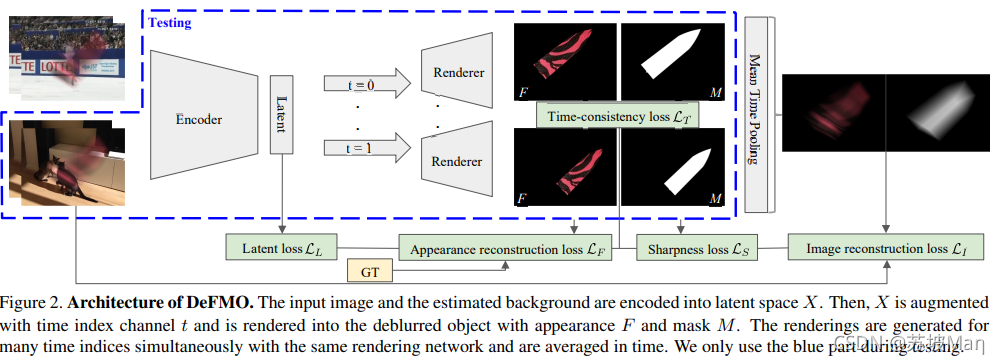

我们将输入图像 I 和背景 B 编码到潜在空间 X ∈ RK。然后,我们渲染一组子帧外观,这些外观被推为清晰、时间一致、独立于背景,并重建具有以下图像形成模型的输入图像:

这是分段常数FMO生成模型(2)的推广。与(1)和(2)不同,DeFMO直接在目标位置渲染目标。论文也没有解开轨迹模糊核Ht,它只是(3)中的Dirac deltas(狄拉克增量)。外观Ft与mask Mt的乘法取代了Ft≤Mt的约束,例如预测mask中的低值将意味着FtMt的低值。论文中假设输入图像I = I0:1。为了训练,论文将输入帧的时间分割成N个等距的部分来生成子帧,并在集合 上计算t。为了测试,任意t∈[0,1]产生一致的效果图。

上计算t。为了测试,任意t∈[0,1]产生一致的效果图。

从技术上讲,DeFMO渲染的图像几乎是在零曝光时间下捕获的。子帧时间索引 t 处的此类图像被捕获为 It = limδ→0 I t−δ : t+δ = FtMt + (1 − Mt)B。

在实践中,我们特意添加时间模糊进行定量评估,以匹配高速相机帧(见评估第5节)。这种时间模糊是由 l 产生的时间超分辨率,  其中

其中 为曝光率。生成零曝光时间图像的能力可以在任何曝光时间下生成任意帧率的图像。生成零曝光时间图像的能力可以在任何曝光时间下创建任何帧速率。

为曝光率。生成零曝光时间图像的能力可以在任何曝光时间下生成任意帧率的图像。生成零曝光时间图像的能力可以在任何曝光时间下创建任何帧速率。

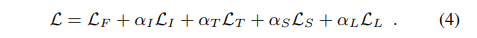

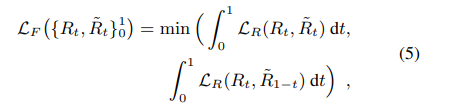

三、训练损失

损失函数的灵感来源于问题的性质。主要目标是获得不包含背景(LL)的对象(LF)的sharp(LS)重建,随时间平滑移动(LT),并根据广义生成模型(3)重建输入图像(LI)。因此,损失由五部分组成:

Appearance reconstruction loss LF

外观重建损失 LF :捕获对象外观和mask的监督子帧重建。

由于输入是单个模糊图像,我们不知道时间是向前还是向后。事实上,它们都会生成相同的模糊图像。这两种情况是无法区分的。

因此,我们评估两个方向并仅计算与GT最相符的时间方向的损失。更准确地说,我们将 LF 定义为:

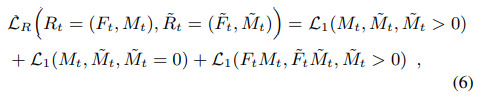

以及一对估计渲染Rt和GT渲染R˜t的渲染损失LR:

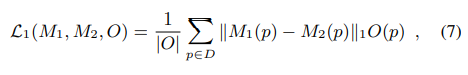

我们将三个术语组合在一起。前两个术语评估两组像素上的mask之间的差异:对象所在的位置和图像的其余部分,如GT所示。最后一项计算外观之间的差异,在第一组像素上进行计算。这种分割的直观感觉是,物体通常只占据输入图像的一小部分,我们希望损失的部分更多地集中在物体本身。然后,L1损失为:

其中M( p)表示像素位置p处的图像M。如果省略占用mask O,则假设整个图像域D。外观重建损失是唯一一个需要GT对象渲染 R~t的损失,即它是唯一的监督损失。

Image reconstruction loss LI

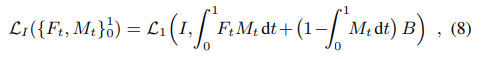

图像重建损失LI是广义形成模型(3)的直接应用。我们对输入图像和从输入背景and FMO渲染重建的合成图像之间的差异进行处理。定义图像重建损失为:

在这里,我们加强了时间集成的基础物理模型。这一损失和所有以下的损失都是自我监督的,不需要GT。

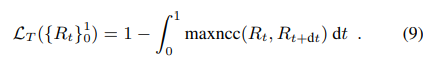

Time-consistency loss LT

时间一致性损失LT根据问题的先验知识捕获子帧渲染的时间平滑度。我们希望渲染Rt在t附近是相似的。因此,我们将两个不同时间点的渲染之间的相似度定义为图像域上归一化互相关的最大值,这可以通过卷积在GPU上有效地实现。为了考虑到对象平移的可能性,我们在其中一个渲染图中应用图像大小10%的零填充。损失定义为:

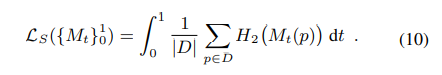

Sharpness loss LS

锐度损失LS增强了图像的sharp重建,这是图像去模糊的主要任务。在FMO设置中,对象的sharp是通过其mask来评估的。强制mask为二进制并不理想,因为我们在对象边界上混合了像素。然而,几乎所有的像素都接近于0或1。表达这一表述的一种数学方法是最小化图像域D上每像素二进制熵H2的平均值,

Latent learning loss LL

潜在性学习损失LL对latent space(潜在空间)进行建模,使同一FMO在不同背景下沿同一轨迹运动的模糊图像产生相同的latent表示。我们通过对这些图像进行训练,并计算损失:

其中X1和X2为第一幅和第二幅图像产生的潜在空间。所有其他损失、渲染和计算仅在第一张图像上完成,即与X1相关。潜在的学习损失在早期训练阶段尤其有帮助,使训练稳定下来。

Joint loss

由于损失函数的某些部分是有偏差的,即使是完美优化的联合损失也不一定会产生GT 渲染。例如,时间一致性和sharpness损失并没有被GT 渲染最小化,因为GT renderings不是二元的边界,而且外观也不是静态的。GT 渲染是否是Joint loss的全局最小值是一个有待研究的问题。

部分Joint loss与TbD[2]和TbD- 3d[3]方法中的能量最小化项存在松散的关系,如外观重建损失(appearance reconstruction loss)≈template-matching term[2],图像重建损失(image reconstruction loss)≈data likelihood[2,3],时间一致性损失( time-consistency loss)≈正则化项增强目标在相邻时间间隔内的相似性[3]。其他正则化因子,例如总的variation,预计将由数据驱动,并由网络从综合训练集学习。与我们的工作相比,之前的方法不是神经网络模型,是手工制作的,计算速度慢,不能很好地处理复杂的对象(见第2节)。

四、训练和评估数据集

Real-world datasets for evaluation

仅存在少量具有快速移动对象的真实数据集。FMO数据集[6]包含16个运动序列,其中FMO用多边形手工标注。它缺乏清晰的外观,分割mask,甚至轨迹。TbD数据集[2]更进一步,以240帧/秒的raw格式拍摄了12个高速视频,全曝光。随后,通过平均时间创建30 fps的低速视频。在高速视频中,通过对第一帧的对象进行注释,应用最先进的跟踪器[9],并纠正错误,半手动生成GT。因此,以GT为基础的sharp外表,masks,和完整轨迹的GT。然而,该数据集只包含体育视频,大部分是球形物体,而且随着时间的推移,外观几乎没有变化。为了解决这些缺点,TbD- 3D数据集[3]以与TbD相同的方式记录,但捕获的对象在一个低速视频帧内显著改变其外观。数据集只有10个序列,对象都是球形的,只有一个例外。最近的Falling Objects数据集[10]是第一个包含非平凡形状的对象,例如box、pen、marker、cell、key、eraser。提供高速视频,但没有GT轨迹。

我们通过运行带有注释的跟踪器[16]来使用轨迹增强[1]的GT——我们在第一帧中提供一个手动框,跟踪对象,并通过重新初始化跟踪器来纠正错误。我们使用这个增强的数据集进行测试和消融研究。

Synthetic dataset for training

由于缺乏大型和多样化的真实世界带注释的FMOs数据集,因此创建了用于训练的合成数据集。为了创建一个合成图像,我们使用三联:一个物体,一个6D轨迹,和一个背景帧。然后,我们使用Blender Cycles[3]沿着给定的6D轨迹渲染对象,以获得一组子帧渲染。最后,应用广义生成模型(3)显示模糊FMO的低速帧。

对象从ShapeNet数据集的50个最大类的3D模型中采样,每个类都被统一表示。由于大多数ShapeNet对象的纹理都不是很好,所以我们应用DTD纹理,就像在Neural Voxel Renderer[11]的数据集创建中一样。纹理被分成1600个用于训练,200个用于验证。

轨迹以线性的方式均匀采样,在x、y图像方向的0.5到2个物体尺寸范围内,以及在z方向的0到0.2个尺寸之间。3D旋转采样最大旋转变化30◦在每个方向。绘制时,将轨迹离散为N = 24等分.

从VOT[12]序列中采样背景用于训练,从Sports-1M[13]中采样背景用于验证。对于潜在空间学习,前景图像是在一对背景上合成的。背景B作为方法的输入被估计为5帧以上的中值。这样,该方法暴露了复杂的非静态背景,因为VOT数据集有各种动态场景,但没有其他FMOs。

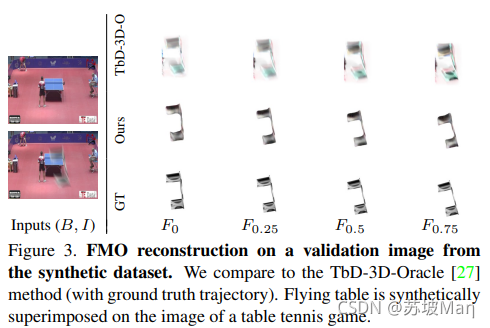

总共产生50000培训和1000验证图像(图3例)。合成数据集比现实世界更有挑战性的数据集(表1)消融研究。测试数据集上的指标更好的报道(下降对象[12])比合成训练数据集,更复杂的对象和纹理。

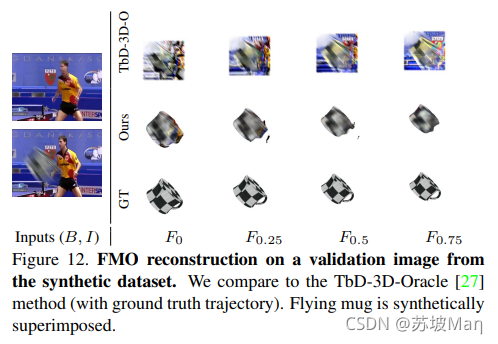

图3。对合成数据集的验证图像进行FMO重构。我们比较了TbD-3D-Oracle[3]方法(GT轨迹)。飞桌是在乒乓球比赛的形象上综合叠加而成的。

表1。DeFMO的消融研究。综合生成训练和验证数据集。没有额外的自我监督损失的训练对训练集进行过拟合(第2,3行)。值用颜色编码,越深越好。

Training settings

编码器和渲染网络都是基于批处理规范[14]和ReLU的ResNet。编码器在ImageNet上预训练的第四个向下采样算子后进行ResNet-50裁剪。使用像素shuffle将潜在空间向上缩放2次,每次之后是ResNet瓶颈(即1024、256、64、16、4个通道)。我们使用固定学习率10−3的ADAM优化器。对于输入图像分辨率w × h,潜空间分辨率为2048 × w/16 × h/16 = K(由于4个下采样算子)。通过沿第一维复制时间索引通道t,增强了绘制网络的输入,分辨率为2049 × w/16 × h/16。在实验中,我们设w = 320, h = 240。损失权重设为αI, αS, αL = 1, αT = 5。编码器和渲染网络的参数分别为23.5M和20.1M。该模型是在PyTorch中实现的,在3 nVidia 16GB gpu上训练了24个mini-batches。我们训练了50个epochs,大约花了4天时间。对于评估,该方法在单个GPU上实时运行,并适用于各种分辨率和子帧时间指标。

五、评价

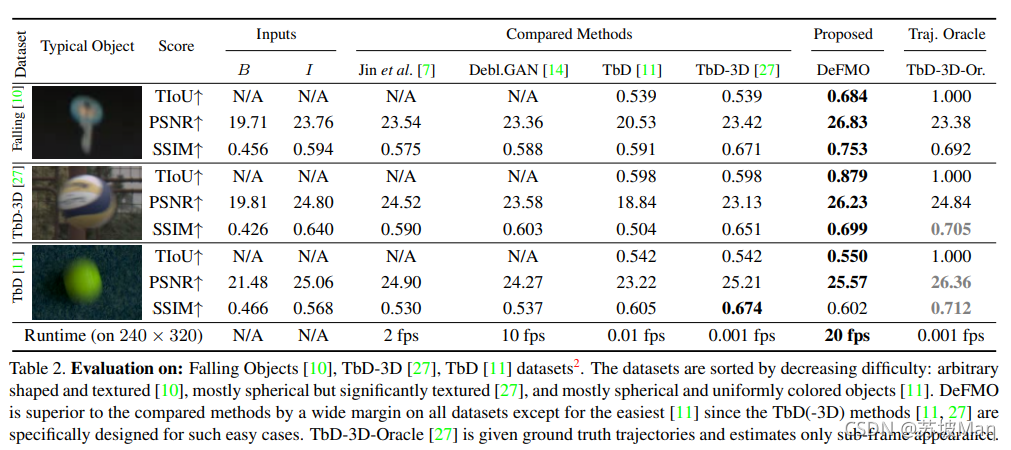

我们在几个数据集(第4节)上评估了DeFMO,并将其与当前的技术状态进行了比较。评价指标为PSNR(峰值信噪比)、SSIM(结构相似性指标测度)和TIoU (Intersection over Union averaged along the trajectory)[11]。我们比较了基于能量最小化的FMO去模糊方法:TbD[2]、TbD- 3d[3]和TbD- 3d - oracle(其中我们提供GT轨迹)。所有的FMO模糊方法和我们使用相同的前5帧背景中值估计。我们还比较了两种最先进的通用去模糊和时间超分辨率方法:DeblurGAN-v27和Jin等人的[15]。我们不与[1]方法进行比较,因为它涵盖了一个非常特殊的情况,即平面外观不变,2D旋转平行于像平面,对于一般情况,它不如TbD-3D[3]。[1]的作者介绍了下落物体数据集,但仅在物体外观不变的三个选定帧上进行定性评估。

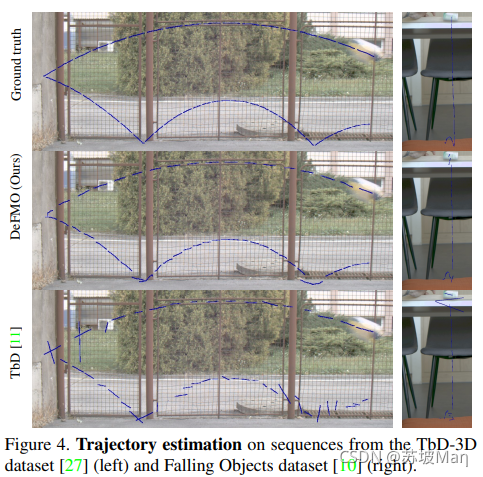

高速视频的帧率是低速视频的8倍,都是全曝光。因此,我们生成全曝光(e= 1)时间超分辨率进行定量评价,以匹配高速帧。如第3节所述,我们根据(3)生成 ,并将每个积分离散为5部分。为了获得定性结果,我们尽可能清晰地重建目标,并可视化零曝光时间超分辨率。由于我们的时间超分辨率任务是在单一图像上完成的,时间方向是模糊的。因此,我们计算两个方向的分数,并报告最好的一个(对于所有方法)。使用FMO探测器[6]对FMO进行检索并通过包围盒进行近似定位。估计子帧轨迹(图4)为生成mask的质心。

,并将每个积分离散为5部分。为了获得定性结果,我们尽可能清晰地重建目标,并可视化零曝光时间超分辨率。由于我们的时间超分辨率任务是在单一图像上完成的,时间方向是模糊的。因此,我们计算两个方向的分数,并报告最好的一个(对于所有方法)。使用FMO探测器[6]对FMO进行检索并通过包围盒进行近似定位。估计子帧轨迹(图4)为生成mask的质心。

图4。从TbD-3D数据集[3]和Falling Objects数据集[1]对序列进行轨迹估计。

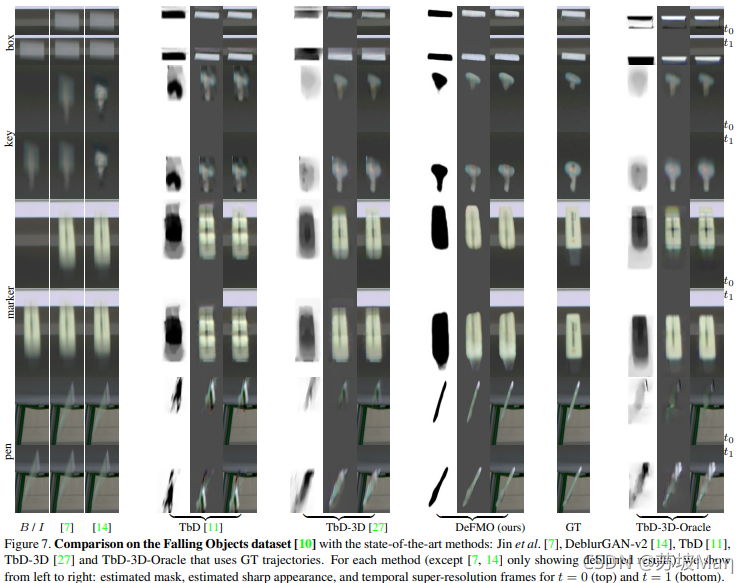

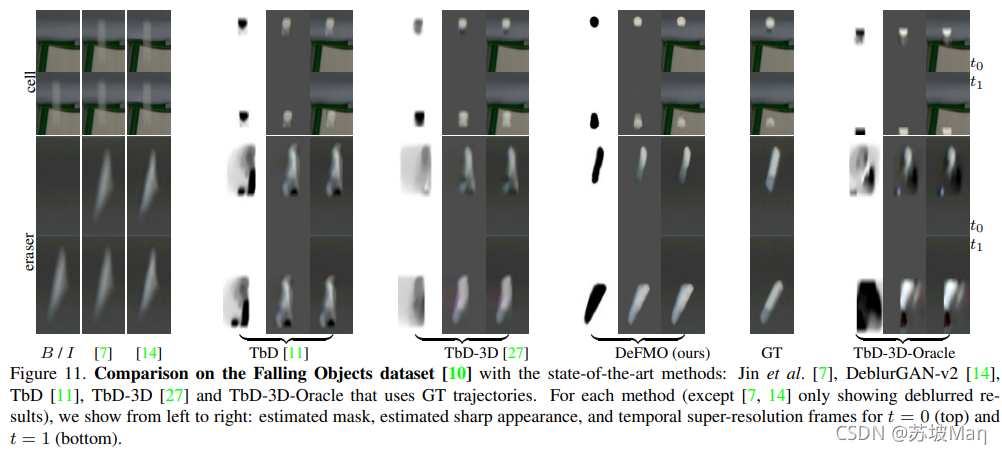

Falling Objects dataset大多数以前的方法在这个具有挑战性的数据集上失败(表2,顶部块[1]),主要是因为对象在一帧内改变了太多的外观(图7)。在这个数据集上,DeFMO在所有指标上都优于其他所有指标。它甚至优于TbD-3D-Oracle,尽管该方法需要GT轨迹作为输入,这在现实场景中是不可用的。

表2。评价: Falling Objects[1]、TbD- 3d[3]、TbD[2]数据集。数据集按难度递减排序:任意形状和有纹理的[1],大部分是球形但有显著纹理的[3],大部分是球形且颜色一致的物体[2]。除了最简单的[2]以外,DeFMO在所有数据集上都优于其他比较方法,因为TbD(-3D)方法[2,3]是专门为这种简单情况设计的。TbD-3D-Oracle[3]给出GT轨迹,仅估计子帧外观。

TbD-3D数据集 表2(中间块[3])表明,DeFMO优于其他所有不使用地面真轨迹的方法。DeFMO甚至可以与TbD-3D-Oracle相比(更好的PSNR,稍差的SSIM)。

TbD数据集 包含的对象大多是球形的,并且具有恒定的外观。在这个简单的设置中,在SSIM度量上,DeFMO比TbD(-3D)方法略差(表2,底部块2])。在PSNR和TIoU指标上,DeFMO是表现最好的方法。请注意TbD(-3D)方法是专门为这种简单的对象设计的,并且在那里工作得很好。我们的方法更一般,没有球形或常数对象的假设。然而,DeFMO的速度要快几个数量级,但在性能上是可以媲美的。提高这类对象性能的一种方法是生成具有固定外观的对象的综合训练集。

Ablation study 表1消融研究验证了自监督损失(即除监督外观重建损失LF外的所有损失)对整个模型的收敛和泛化有积极的影响。LS忽略了图像清晰度的损失,使得物体边界更加模糊,虽然保留了图像的重建质量,但却降低了图像的精度。只有外观结构损失的训练会导致对训练集的过拟合。在另一个极端,在完全自我监督的方式下训练完全失败(表1,第4行)。我们观察到,主要问题是识别感兴趣的对象和平衡背景运动的重要性。监督损失和自我监督损失的组合表现最好。

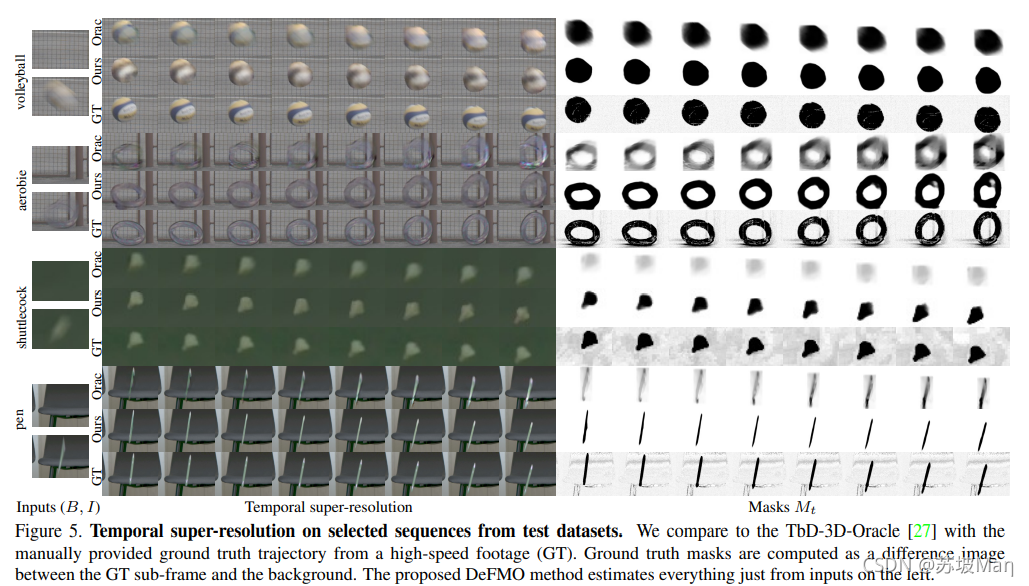

讨论 在ShapeNet中,测试数据集中的所有对象都不存在,但我们的方法仍然成功地重建了这些对象。DeFMO也可以重建一个变形的物体(图5,有氧运动),即使在训练中只使用刚体。该方法能够同时消除其他动态对象的模糊,如果他们的运动与感兴趣的对象相似,如图1中的排球。当物体的外观与背景颜色相似时,问题就会变得严重不适定。

例如,图7中标记点的黑色尖端没有被重建,因为目标是在黑色背景前面移动的,无论是否重建尖端,都正确地导致几乎相同的输入图像。

该方法不适用于透明材料制成的物体,如瓶子、玻璃。透明度的两个来源,由于快速运动的背景-前景混合和透明材料,很难区分。

图5。从测试数据集中选定序列的时间超分辨率。我们将TbD-3D-Oracle[3]与从高速镜头(GT)手动提供的地面真实轨迹进行了比较。地面真实掩模作为GT子帧和背景之间的差值图像计算。提出的DeFMO方法仅从左边的输入来估计所有东西。

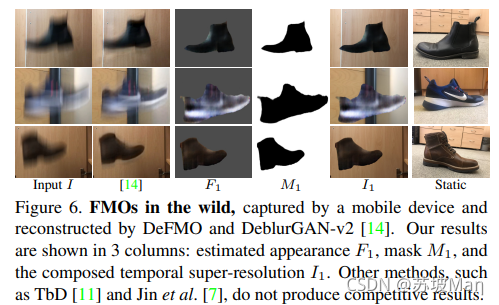

图6。野生FMOs,由移动设备捕获,由DeFMO和DeblurGAN-v2[7]重建。我们的结果显示在3列:估计的外观F1,mask M1,和组成的时间超分辨率I1。其他方法,如TbD[2]和Jin等人[15],并没有产生竞争性的结果。

图7。使用最先进的方法对下落物体数据集[1]进行比较:Jin et al. [15], DeblurGAN-v2 [7], TbD [2], TbD- 3d[3]和TbD- 3d - oracle使用GT轨迹。对于每一种方法(除了[15,7]只显示去模糊结果),我们从左到右显示:对于t = 0(上)和t = 1(下),估计的掩模、估计的清晰外观和时间超分辨率帧。

Applications该方法的应用包括时间超分辨率(图5)。它可以用于天文学等领域,重建快速小行星的外观或数据压缩,以降低视频存储的帧率,然后使用DeFMO恢复。其他应用包括运动中的球检测和速度估计,或者通过应用轮廓形状对高度模糊的物体进行全3D重建。与标准跟踪器相结合,DeFMO可以在视频的某些部分跟踪FMOs对象,而在其他部分不模糊。

DeFMO还可以处理在真实环境中录制的序列,比如在移动设备上。我们以30帧/秒的标准帧率拍摄手抛物体的视频。它们的重建示例如图6(鞋)和图1(打火机)所示。YouTube视频中物体的FMO重建如图1 (mic, cap)。更多的例子和视频可以在补充材料中找到。

六、总结

我们提出了一种新的生成模型,用于快速运动物体的disentangling和去模糊。在复杂的合成数据集上进行训练,使用精心设计的损失函数,结合问题的先验知识,可以很好地扩展到真实世界的数据。实验结果表明,该模型能够在一帧视频中处理形状复杂和外观变化显著的快速移动物体。DeFMO设置了一个新的艺术状态,因为它在多个数据集上优于所有以前的方法。时间超分辨率是可能的应用之一。

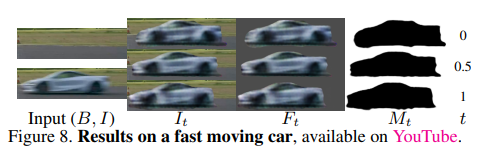

图8。一辆快速行驶的汽车的结果,可以在YouTube上看到。

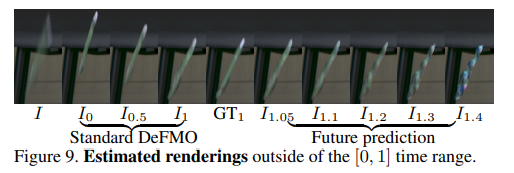

图9。在[0,1]时间范围之外的估计效果图。

图10。从测试数据集中选定序列的时间超分辨率。我们将TbD-3D-Oracle[3]与手动提供的高速镜头(GT) GT轨迹进行了对比。GT掩模是作为GT子帧和背景之间的差值图像计算的。提出的DeFMO方法仅从左边的输入来估计所有东西。

图11。使用最先进的方法对下落物体数据集[1]进行比较:Jin et al. [15], DeblurGAN-v2 [7], TbD [2], TbD- 3d[3]和TbD- 3d - oracle使用GT轨迹。对于每一种方法(除了[15,8]只显示去模糊结果),我们从左到右显示:对于t = 0(上)和t = 1(下),估计的掩模、估计的清晰外观和时间超分辨率帧。

图12。对合成数据集的验证图像进行FMO重构。我们比较了TbD-3D-Oracle[3]方法(GT轨迹)。飞行mug是综合叠加的。

References:

[1] J. Kotera, J. Matas, and F. Sroubek. Restoration of fast moving objects. IEEE TIP, 29:8577–8589, 2020.

[2] J. Kotera, D. Rozumnyi, F. Sroubek, and J. Matas. Intra-frame object tracking by deblatting. In ICCVW, Oct 2019.

[3] D. Rozumnyi, J. Kotera, F. Sroubek, and J. Matas. Sub-frame appearance and 6d pose estimation of fast moving objects. In CVPR, pages 6777–6785, 2020.

[4] F. Sroubek and J. Kotera. Motion blur prior. In ICIP, pages 928–932, 2020.

[5] Denys Rozumnyi, Jiri Matas, Filip Sroubek, Marc Pollefeys, and Martin R. Oswald. Fmodetect: Robust detection and trajectory estimation of fast moving objects. In arxiv, online, Dec 2020.

[6] . Rozumnyi, J. Kotera, F. Sroubek, L. Novotn y, and J. Matas. The world of fast moving objects. In CVPR, pages 4838–4846, July 2017.

[7] Orest Kupyn, Tetiana Martyniuk, Junru Wu, and Zhangyang Wang. Deblurgan-v2: Deblurring (orders-of-magnitude) faster and better. In ICCV, Oct 2019.

[8] J. Kotera and F. Sroubek. Motion estimation and deblurring of fast moving objects. In ICIP, pages 2860–2864, Oct 2018.

[9] Alan Lukezic, Tomas Vojir, Luka Cehovin Zajc, Jiri Matas, and Matej Kristan. Discriminative correlation filter with channel and spatial reliability. In CVPR, July 2017.

[10] J. Kotera, J. Matas, and F. Sroubek. Restoration of fast moving objects. IEEE TIP, 29:8577–8589, 2020.

[11] Konstantinos Rematas and Vittorio Ferrari. Neural voxel renderer: Learning an accurate and controllable rendering tool. In CVPR, 2020.

[12] Matej Kristan, Jiri Matas, Ales Leonardis, Tomas Vojir, Ro-man Pflugfelder, Gustavo Fernandez, Georg Nebehay, Fatih Porikli, and Luka Cehovin. A novel performance evaluation methodology for single-target trackers. IEEE TPAMI, 38(11):2137–2155, Nov 2016.

[13] Andrej Karpathy, George Toderici, Sanketh Shetty, Thomas Leung, Rahul Sukthankar, and Li Fei-Fei. Large-scale video classification with convolutional neural networks. In CVPR, 2014.

[14] Sergey Ioffe and Christian Szegedy. Batch normalization: Accelerating deep network training by reducing internal co-variate shift. In ICML, page 448–456. JMLR.org, 2015

[15] Meiguang Jin, Givi Meishvili, and Paolo Favaro. Learning to extract a video sequence from a single motion-blurred image. In CVPR, June 2018.

这篇关于DeFMO: Deblurring and Shape Recovery of Fast Moving Objects的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!