Modality to Modality Translation

2023-10-29 05:04

文章标签

modality

translation

http://www.chinasem.cn/article/298406。

23002807@qq.com

相关文章

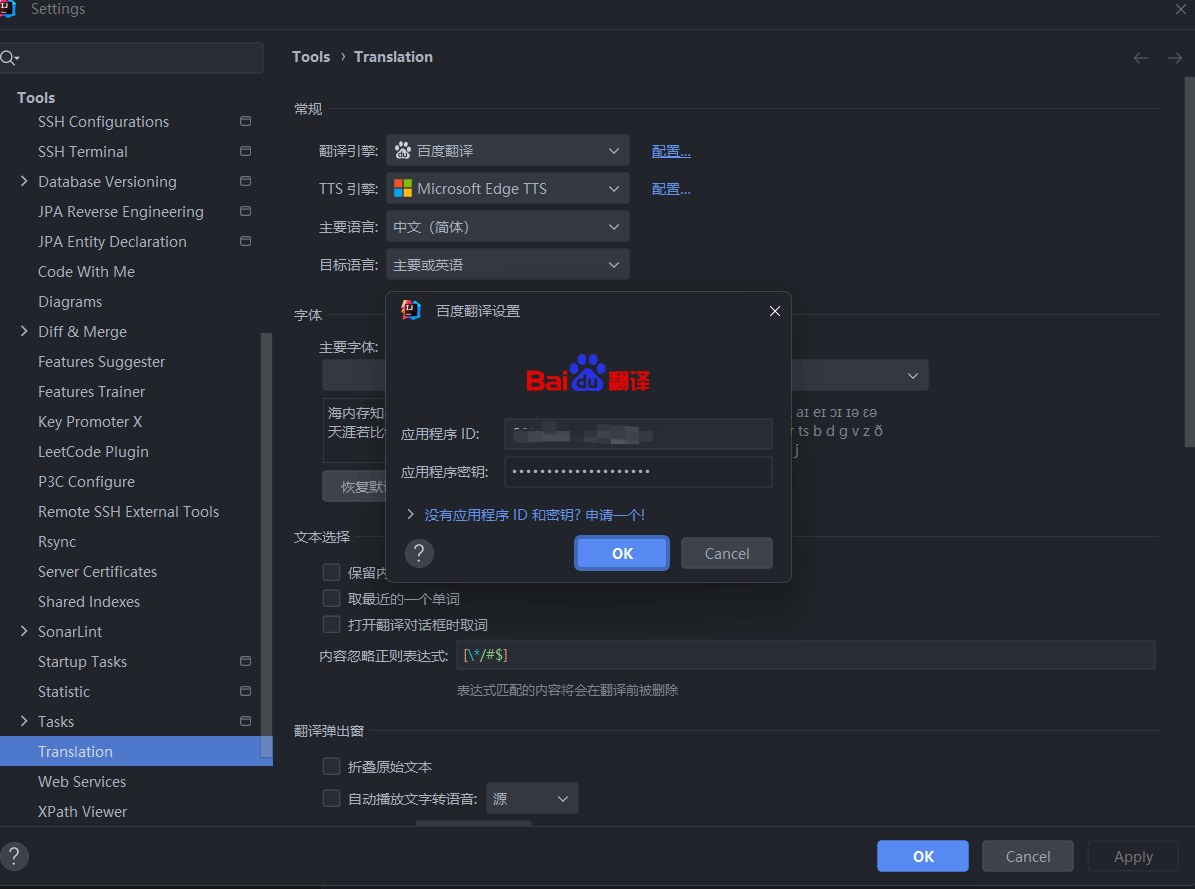

idea中配置Translation插件完成翻译功能

文章目录 idea下载插件配置有道云阿里云百度翻译开放平台 idea下载插件 idea中安装Translation插件 使用方法:右下角选择翻译引擎,鼠标选中想翻译的部分,右键翻译即可 之前一直用的微软的翻译,不需要配置,但是最近微软服务器总是抽风,无法使用,故打算配置一下国内的翻译服务。 配置 有道云 只有初始的一点额度,用完就要收费了,不推荐

S7-200编程软件STEP 7打开时界面乱码显示Translation Required

遇到的问题 如题,两个月没有打开过S7-200编程软件(软件版本是V4.0 STEP 7 MicroWIN SP9,电脑系统是Windows 11),这一次打开就发现它的那个界面乱码了,原来时中文汉化的地方全都变成了Translation Required,具体如下图所示。 心路历程 先讲一下我的心路历程,不想看的可以直接跳转解决方法论部分。 首先是两个月没打开过的软件一打开就发现是一

【论文阅读】Stealing Image-to-Image Translation Models With a Single Query(2024)

摘要 Training deep neural networks(训练深度神经网络) requires(需要) significant computational resources(大量计算资源) and large datasets(大型数据集) that are often confidential(机密的) or expensive(昂贵的) to collect. As a resul

机器翻译 -- Neural Machine Translation

本文是基于吴恩达老师《深度学习》第五课第三周练习题所做。 0.背景介绍 为探究机器翻译的奥秘,我们首先从日期翻译着手。本程序所需的第三方库、数据集及辅助程序,可点击此处下载。 from keras.layers import Bidirectional, Concatenate, Permute, Dot, Input, LSTM, Multiplyfrom keras.layers i

Glancing Transformer for Non-Autoregressive Neural Machine Translation翻译

公众号 系统之神与我同在 图1:机器翻译方法的概率模型。(b)普通的神经机器翻译(NAT)采用条件输入凹痕LM。©掩蔽-预测神经网络翻译(NAT)使用掩蔽LM(MLM)和RE需要多次解码。(d)我们提出的Glancing语言模型(GLM)利用解码器的预测来决定Glancing在训练期间进行采样策略,并且在推理期间只需要一次解码。 摘要 最近关于非自回归神经网络翻译(NAT)的研究旨在,

RNA结构调控翻译_2022_Deciphering the role of RNA structure in translation efficiency

文献核心内容总结 背景: 本文探讨了RNA二级结构在翻译效率(Translation Efficiency, TE)中的作用。RNA二级结构在转录后调控过程中扮演重要角色,包括剪接、定位、稳定性和翻译。RNA结构的稳定性尤其在翻译起始位点附近对于促进翻译效率具有重要影响。然而,目前对整个mRNA结构与翻译效率的全局关系的理解仍然有限。本研究利用高通量RNA结构探测数据,系统研究了RNA结构在调

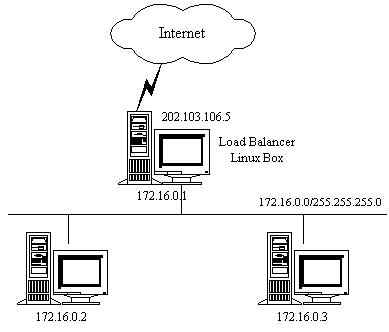

NAT(Network Address Translation)介绍

通过NAT实现虚拟服务器(VS/NAT) 由于IPv4中IP地址空间的日益紧张和安全方面的原因,很多网络使用保留IP地址(10.0.0.0/255.0.0.0, 172.16.0.0/255.128.0.0和192.168.0.0/255.255.0.0)[64, 65, 66]。这些地址不在Internet上使用,而是专门为内部网络预留的。当内部网络中的主机要访问Internet或被Int

Ruoyi5.x RuoYi-Vue-Plus新建Translation翻译类

若依框架(RuoYi)中的Translation翻译类主要作用在于实现字段值的转换或翻译功能,以提高数据展示的准确性和友好性。以下是其具体作用的一些关键点: 字段值转换:若依框架在处理数据时,有时需要将某些字段的存储值(如ID)转换为更具可读性的展示值(如名称、标签等)。Translation翻译类正是为此目的而设计的,它允许定义字段值的转换规则,并在需要时自动执行转换。 自定义注解与序列化器:

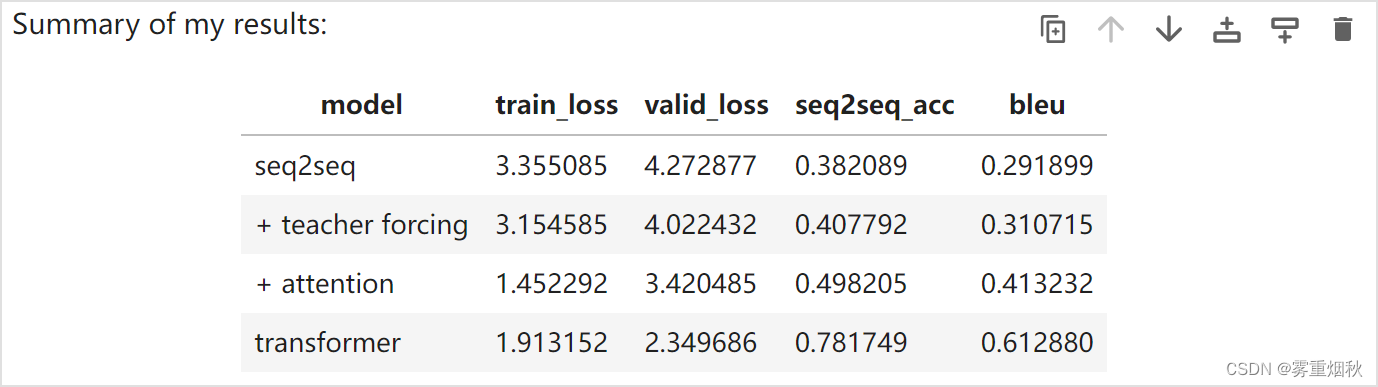

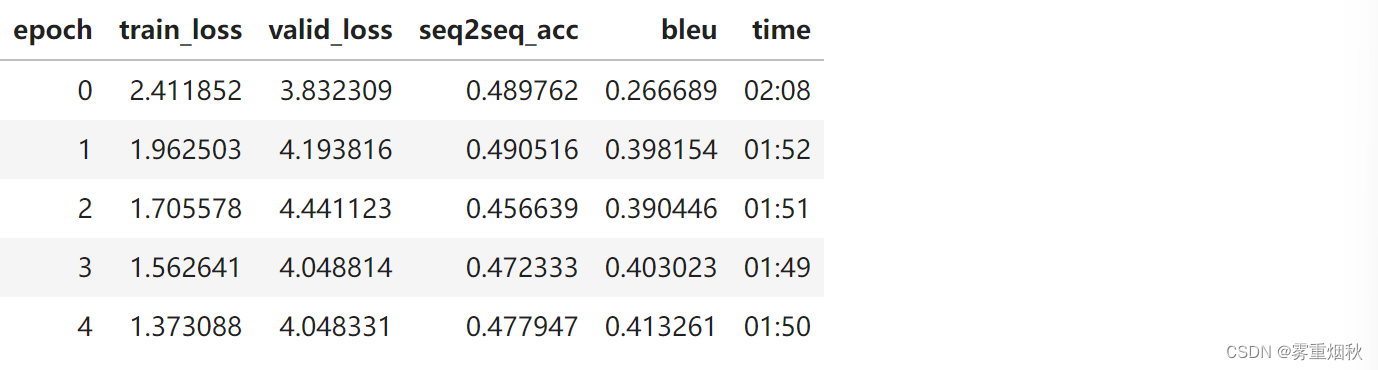

course-nlp——8-translation-transformer

本文参考自https://github.com/fastai/course-nlp。 注意力机制和 Transformer Nvidia AI 研究员 Chip Huyen 写了一篇很棒的文章《Top 8 trends from ICLR 2019》,其中的趋势之一是 RNN 正在失去研究人员的青睐。 这是有原因的,RNN 可能很麻烦:并行化可能很棘手,而且很难调试。 由于语言是递归的,RN

course-nlp——7-seq2seq-translation

本文参考自https://github.com/fastai/course-nlp。 使用 RNN 进行翻译 此笔记本是根据 Sylvain Gugger 创建的笔记本修改而来的。 今天我们将处理翻译任务。我们将从法语翻译成英语,为了使任务规模保持在可控的范围内,我们将仅限于翻译问题。 此任务是序列到序列 (seq2seq) 的一个示例。 Seq2seq 可能比分类更具挑战性,因为输出的长