本文主要是介绍深入理解Java GSS(含kerberos认证及在hadoop、flink案例场景举例),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- 01 引言

- 02 Java GSS 简介

- 2.1 Kerberos认证基本原理

- 2.2 Kerberos在Java GSS中的应用

- 03 应用

- 3.1 在hadoop中的应用

- 3.2 在Flink中的应用

- 3.3 小结

- 04 文末

01 引言

在当今的信息安全环境下,保护敏感数据和网络资源的安全至关重要。Kerberos认证协议作为一种强大的网络身份验证解决方案,被广泛应用于许多大型分布式系统中,如:Hadoop。而Java GSS(Generic Security Services)作为Java提供的通用安全服务,与Kerberos认证密切相关。

本文将探讨Java GSS和Kerberos认证的基本原理,以及它们之间的关系,同时介绍如何在Hadoop中应用Kerberos认证。

02 Java GSS 简介

详细的导读可以参考:https://www.baeldung.com/java-gss

Java GSS:是Java提供的一套用于网络安全的通用安全服务,它为Java应用程序提供了一致的、独立于底层安全机制的编程接口。

Java GSS 的主要目标:简化网络安全编程,并提供与各种安全机制的集成能力。

其中,它支持各种常见的安全机制,如 Kerberos 、SSL/TLS和数字证书 等,下图展示了GSS-API 与其内容的关系:

先简单了解kerberos认证的基本原理。

2.1 Kerberos认证基本原理

可以参考之前我写的博客:https://blog.csdn.net/qq_20042935/article/details/131281618

Kerberos是一个基于票据的身份验证协议,它通过使用共享密钥加密的票据进行认证和授权。

Kerberos认证协议的核心是Kerberos服务器(KDC)和客户端之间的相互信任,下面是Kerberos认证的基本流程:

- step1:客户端发送身份请求给KDC;

- step2:KDC验证客户端的身份,并生成一个票据授权给客户端;

- step3:客户端使用票据请求服务票据授权;

- step4:KDC验证客户端的请求,并生成一个服务票据授权给客户端;

- step5:客户端将服务票据授权发送给服务端;

- step6:服务端验证票据并向客户端发送一个加密的会话密钥;

- step7:客户端和服务端使用会话密钥进行通信。

2.2 Kerberos在Java GSS中的应用

Java GSS提供了一种使用Kerberos认证协议进行安全通信的方式,它通过Java GSS-API提供了对Kerberos协议的封装和支持,简化了开发者使用Kerberos进行身份验证和安全通信的过程。

Java GSS提供了以下关键功能:

- GSSContext:用于建立和管理安全上下文,支持与Kerberos服务器进行交互;

- GSSCredential:用于表示和管理Kerberos凭证,包括

Keytab文件和Principal; - GSSName:用于表示和管理Kerberos中的主体。

Java GSS与Kerberos的密切关系在于:Java GSS为开发者提供了一种简单而强大的方式来集成和使用Kerberos认证协议,实现安全的网络通信。 以下是相关的核心代码示例:

import javax.security.auth.Subject;

import javax.security.auth.login.Configuration;

import javax.security.auth.login.LoginContext;

import javax.security.auth.login.LoginException;

import org.ietf.jgss.*;public class GSSDemo {public static void main(String[] args) {try {// 设置Kerberos配置文件路径System.setProperty("java.security.krb5.conf", "/path/to/krb5.conf");// 创建一个LoginContext来进行Kerberos认证LoginContext loginContext = new LoginContext("KerberosClient", null, null, new CustomConfiguration());// 执行Kerberos认证loginContext.login();// 从Subject中获取GSSCredentialSubject subject = loginContext.getSubject();GSSCredential credential = subject.getPrivateCredentials(GSSCredential.class).iterator().next();// 创建一个GSSManager实例GSSManager gssManager = GSSManager.getInstance();// 创建一个GSSName,表示Kerberos中的主体GSSName serverName = gssManager.createName("HTTP/server.example.com", GSSName.NT_HOSTBASED_SERVICE);// 创建一个GSSContext,用于建立和管理安全上下文GSSContext context = gssManager.createContext(serverName, GSSCredential.DEFAULT_LIFETIME, credential, GSSContext.DEFAULT_LIFETIME);// 建立安全上下文byte[] token = new byte[0];while (!context.isEstablished()) {token = context.initSecContext(token, 0, token.length);}// 获取建立的安全上下文的信息String contextInfo = context.toString();// 输出安全上下文信息System.out.println("安全上下文已建立:" + contextInfo);// 完成Kerberos认证后,执行其他操作// ...// 登出loginContext.logout();} catch (LoginException | GSSException e) {e.printStackTrace();}}static class CustomConfiguration extends Configuration {@Overridepublic AppConfigurationEntry[] getAppConfigurationEntry(String name) {HashMap<String, String> options = new HashMap<>();options.put("keyTab", "/path/to/user.keytab");options.put("principal", "user@example.com");options.put("useKeyTab", "true");options.put("storeKey", "true");options.put("doNotPrompt", "true");options.put("isInitiator", "true");options.put("refreshKrb5Config", "true");options.put("renewTGT", "true");options.put("useTicketCache", "true");options.put("ticketCache", "/tmp/krb5cc_" + getUid());return new AppConfigurationEntry[]{new AppConfigurationEntry("com.sun.security.auth.module.Krb5LoginModule",AppConfigurationEntry.LoginModuleControlFlag.REQUIRED, options)};}private String getUid() {try {return new ProcessBuilder("id", "-u").start().getInputStream().readAllBytes().toString().trim();} catch (IOException e) {e.printStackTrace();return "0";}}}

}03 应用

3.1 在hadoop中的应用

直接上代码,这里当然有更简单的方式,为了清楚的说明流程,所以写的比较啰嗦。下面展示了在完成Kerberos认证后,执行访问Hadoop HDFS的操作的代码片段:

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;import javax.security.auth.Subject;

import javax.security.auth.login.Configuration;

import javax.security.auth.login.LoginContext;

import javax.security.auth.login.LoginException;

import org.ietf.jgss.*;public class GSSDemo {public static void main(String[] args) {try {// 设置Kerberos配置文件路径System.setProperty("java.security.krb5.conf", "/path/to/krb5.conf");// 创建一个LoginContext来进行Kerberos认证LoginContext loginContext = new LoginContext("KerberosClient", null, null, new CustomConfiguration());// 执行Kerberos认证loginContext.login();// 从Subject中获取GSSCredentialSubject subject = loginContext.getSubject();GSSCredential credential = subject.getPrivateCredentials(GSSCredential.class).iterator().next();// 创建一个GSSManager实例GSSManager gssManager = GSSManager.getInstance();// 创建一个GSSName,表示Kerberos中的主体GSSName serverName = gssManager.createName("HTTP/server.example.com", GSSName.NT_HOSTBASED_SERVICE);// 创建一个GSSContext,用于建立和管理安全上下文GSSContext context = gssManager.createContext(serverName, GSSCredential.DEFAULT_LIFETIME, credential, GSSContext.DEFAULT_LIFETIME);// 建立安全上下文byte[] token = new byte[0];while (!context.isEstablished()) {token = context.initSecContext(token, 0, token.length);}// 获取建立的安全上下文的信息String contextInfo = context.toString();// 输出安全上下文信息System.out.println("安全上下文已建立:" + contextInfo);// 完成Kerberos认证后,执行其他操作// 配置Hadoop文件系统Configuration hadoopConf = new Configuration();hadoopConf.addResource(new Path("/path/to/core-site.xml"));hadoopConf.addResource(new Path("/path/to/hdfs-site.xml"));// 登录Kerberosorg.apache.hadoop.security.UserGroupInformation.loginUserFromSubject(subject);// 创建Hadoop文件系统对象FileSystem fs = FileSystem.get(hadoopConf);// 执行HDFS操作Path path = new Path("/user/example");if (fs.exists(path)) {System.out.println("目录已存在");} else {fs.mkdirs(path);System.out.println("目录创建成功");}// 登出loginContext.logout();} catch (LoginException | GSSException | IOException e) {e.printStackTrace();}}

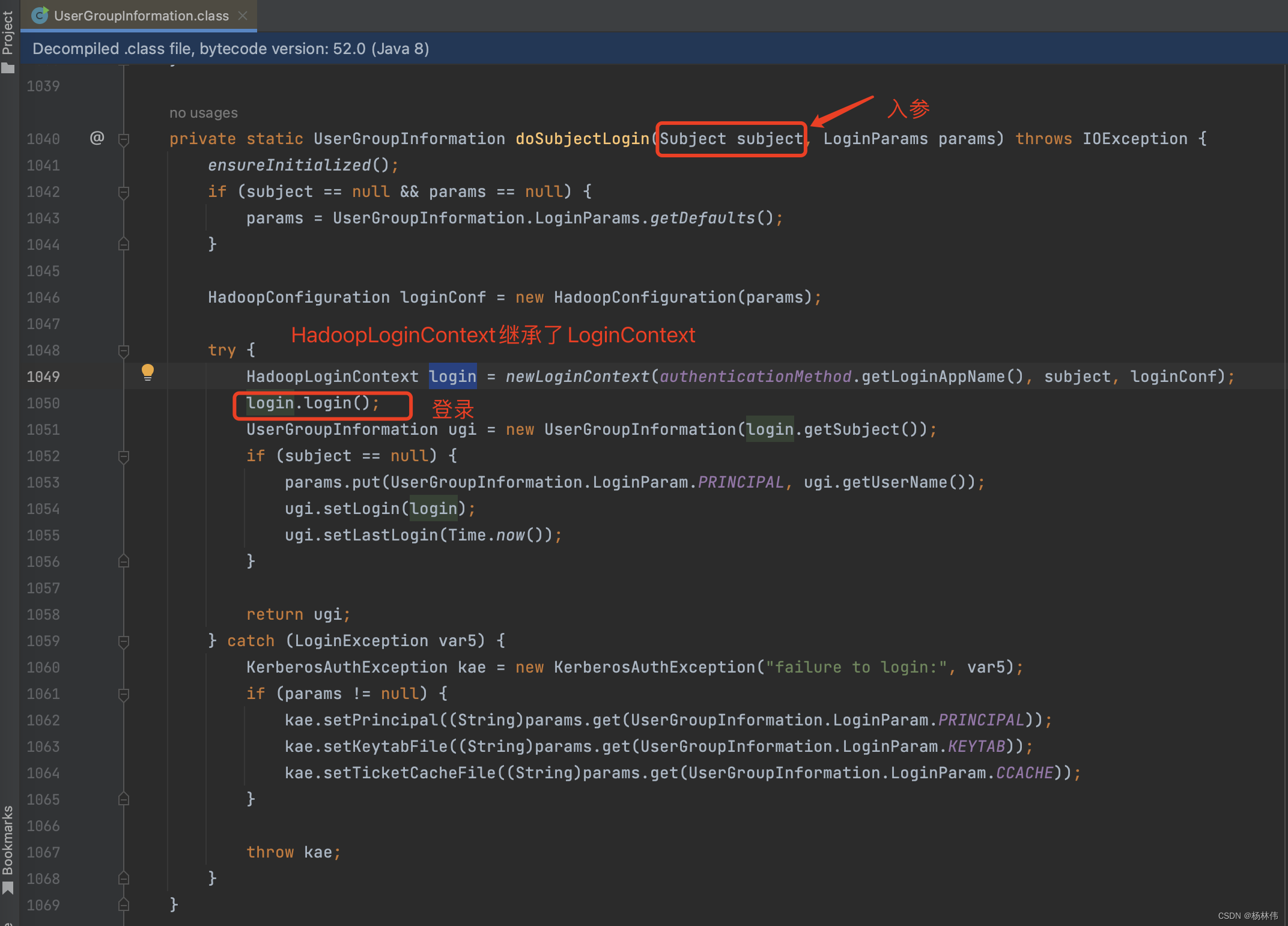

}static class CustomConfiguration extends Configuration {@Overridepublic AppConfigurationEntry[] getAppConfigurationEntry(String name) {HashMap<String, String> options = new HashMap<>();options.put("keyTab", "/path/to/user.keytab");options.put("principal", "user@example.com");options.put("useKeyTab", "true");options.put("storeKey", "true");options.put("doNotPrompt", "true");options.put("isInitiator", "true");options.put("refreshKrb5Config", "true");options.put("renewTGT", "true");options.put("useTicketCache", "true");options.put("ticketCache", "/tmp/krb5cc_" + getUid());return new AppConfigurationEntry[]{new AppConfigurationEntry("com.sun.security.auth.module.Krb5LoginModule",AppConfigurationEntry.LoginModuleControlFlag.REQUIRED, options)};}private String getUid() {try {return new ProcessBuilder("id", "-u").start().getInputStream().readAllBytes().toString().trim();} catch (IOException e) {e.printStackTrace();return "0";}}}从上述代码中,不难发现,其实Hadoop包里面的UserGroupInfomation底层就是使用了Java GSS,其核心代码片段如下:

3.2 在Flink中的应用

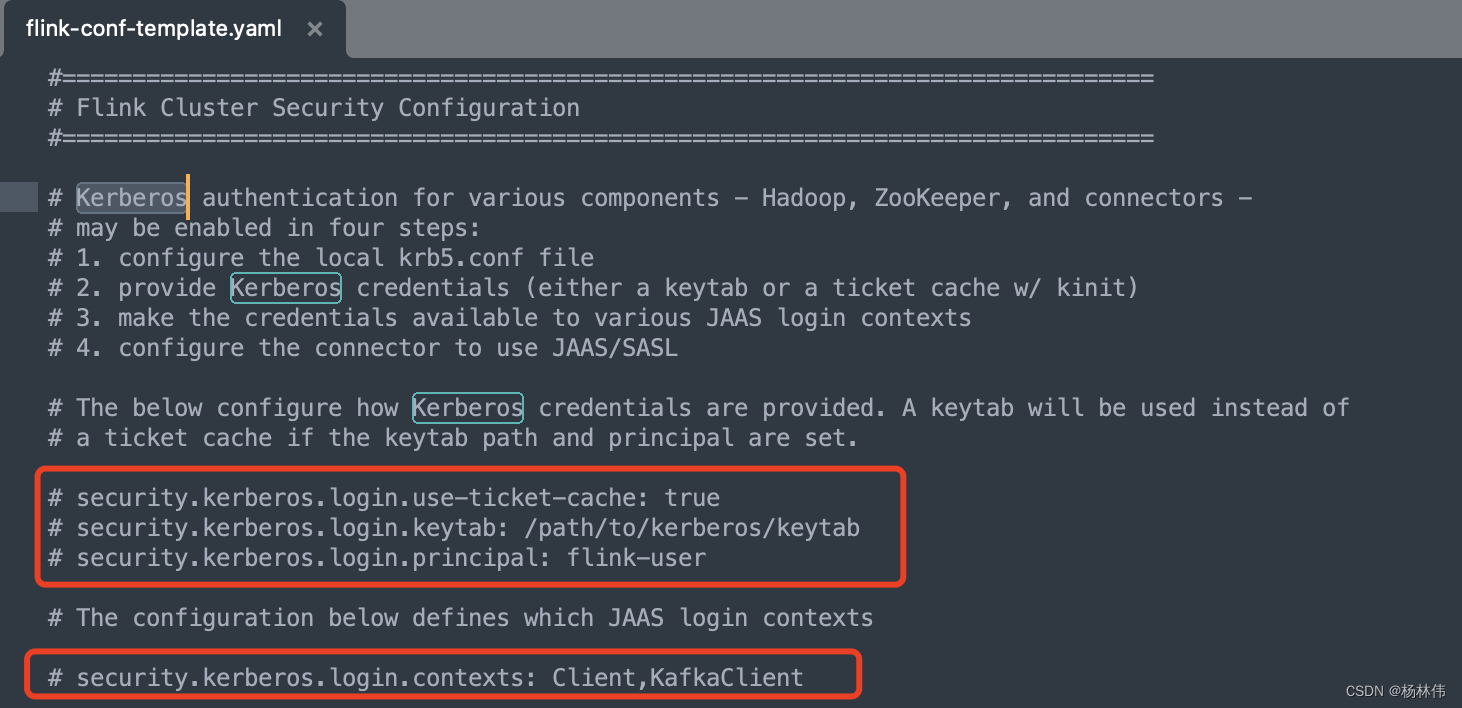

如果部署Flink作业采用Flink On yarn的模式,Hadoop开启了kerberos认证,也是需要配置kerberos信息的,具体配置flink-conf.yaml文件就可以了,具体配置如下信息:

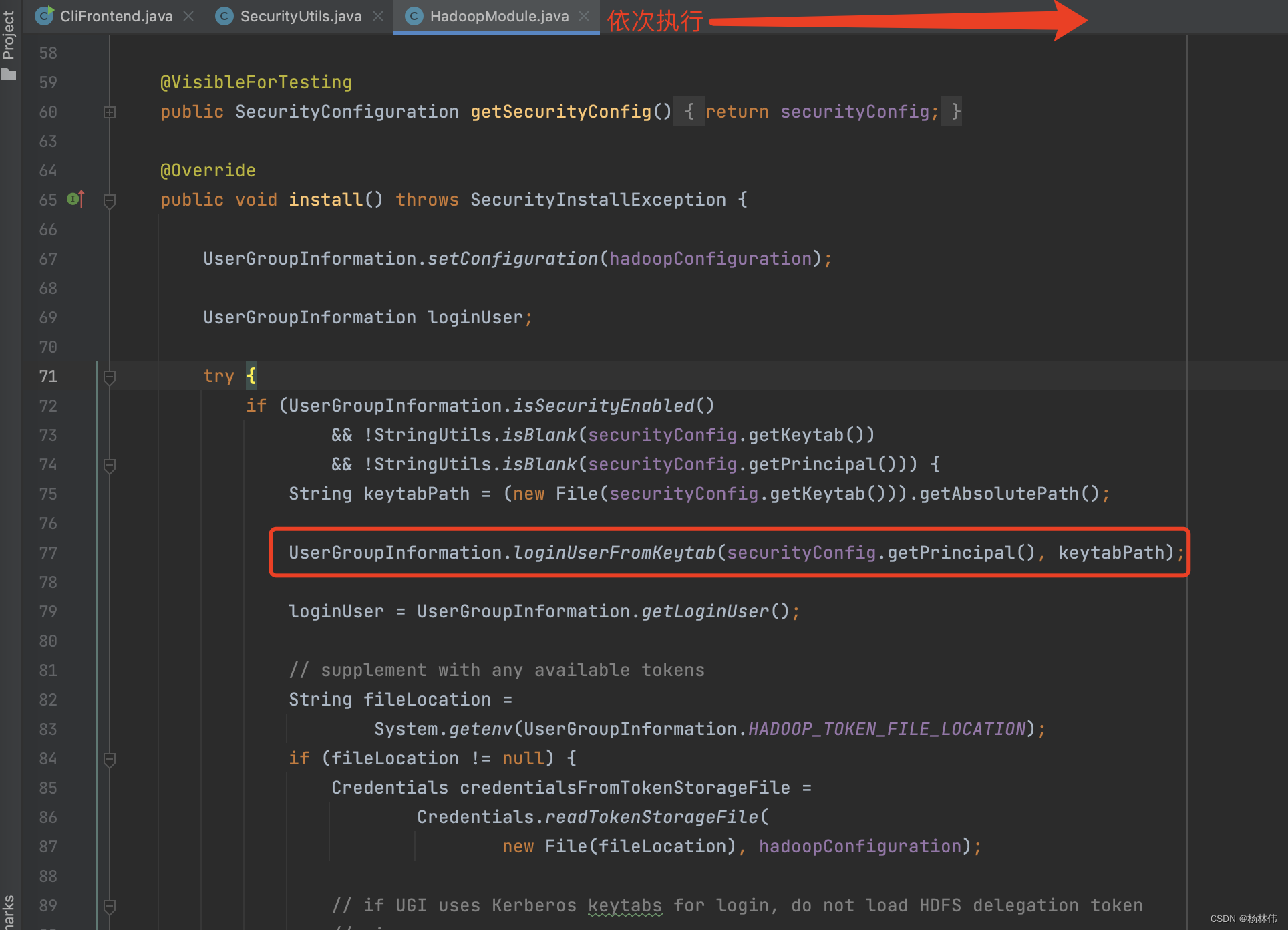

直接跳到flink核心的源码:

上述完整流程就是:首先用户输入flink命令 => 脚本解析 => 进入CliFronted.main方法 => 接着执行了SecurityUtils.install方法 => 最后走到HadoopModule,使用UserGroupInfomation去做登录,而UserGroupInfomation底层就是使用Java Gss去做登录认证的。

3.3 小结

从上述的代码可以看出,Java GSS在Hadoop和Flink中,其实他们彼此都有联系的:

- 在Hadoop中,

UserGroupInformation是Hadoop中处理用户身份验证、权限管理和安全上下文的关键组件之一; UserGroupInformation负责处理Kerberos的凭证管理和身份验证;UserGroupInformation的底层代码是由Java GSS实现的;- 而

Flink On Yarn模式最终部署逻辑,底层也是使用到了UserGroupInformation这个类。

04 文末

本文主要主要围绕Java GSS、Kerberos、UserGroupInformation 这三个核心知识点进行了讲解,希望能帮助到大家,谢谢大家的阅读,本文完!

这篇关于深入理解Java GSS(含kerberos认证及在hadoop、flink案例场景举例)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!