本文主要是介绍Python上市公司年报jieba“环保”词频统计,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目标数据:统计上市公司年报全篇总词数和环保类关键词词数。

以长春高新(000661)2021年年度报告为例。

首先,由于年报文件为pdf格式,jieba无法直接处理,因此我们用pdfplumber读取pdf文件所有内容,并将其拼接成一整个字符串。代码如下:

import pdfplumber

path = '000661:2021年年度报告.pdf'

pdf = pdfplumber.open(path)

text_all = ""

for page in pdf.pages:text = page.extract_text() text_all = text_all+'\n'+text #字符串拼接

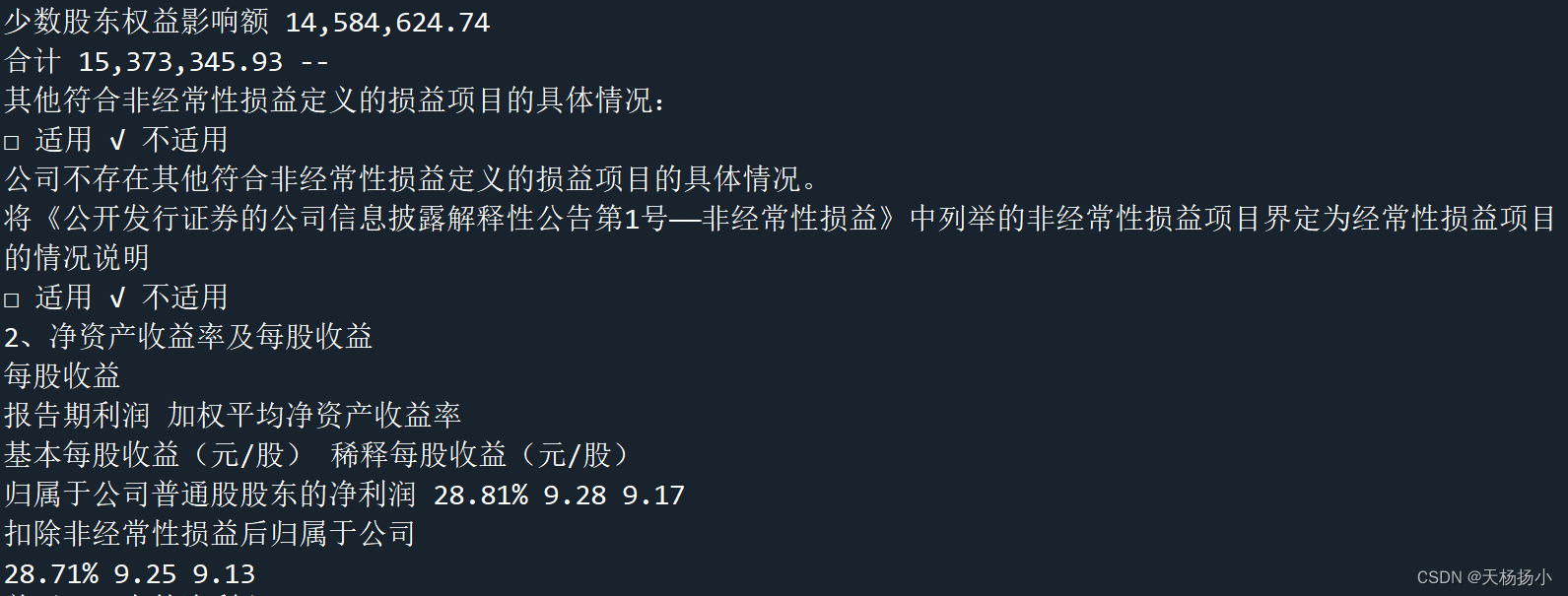

print(text_all)运行得到该pdf所有内容的字符串,部分结果截图如下:

其次,使用jieba分词器对所得字符串进行分词切割,并导入停用词词典备用,停用词参考链接:https://www.cnblogs.com/demo-deng/p/9771593.html。代码如下:

import jieba

words = jieba.cut(text_all)

stop = open("stopwords.txt", "r", encoding='utf-8').read()# 打开停用词txt文件

接着,用for循环统计pdf全篇词频,去除掉停用词和字符串长度等于1的单个字,代码如下:

counts = {}# 创建空字典,用来接收统计结果

for word in words:if word not in stop:# 去除停用词if len(word) == 1:#去除字符长度为1的字continueelse:counts[word] = counts.get(word, 0) + 1#满足上述条件,频率加1

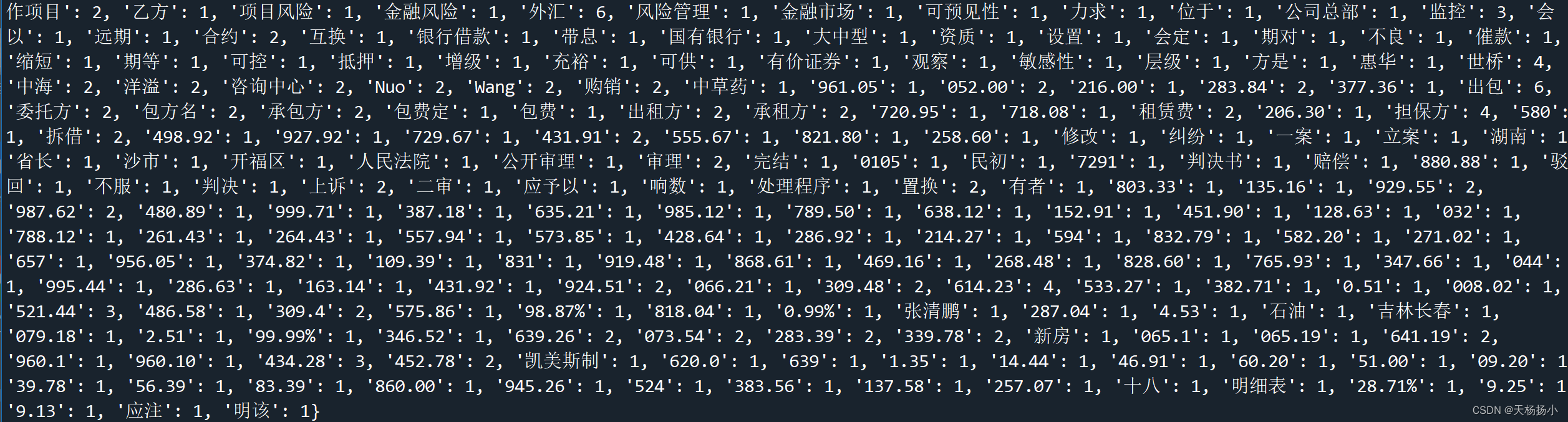

print(counts) 得到字典:

最后,通过“环保类”关键词列表,统计环保词词数和全文总词数。环保类关键词参考《雾霾污染、政府治理与经济高质量发展(陈诗一、陈登科),经济研究》。代码如下:

items = list(counts.items())#转换为列表

items.sort(key=lambda x: x[1], reverse=True)#对词频进行降序排序

list_env = ['治理','PM10','PM2.5','雾霾','保护环境','资源','循环','全球变暖','酸雨','温室效应','节水','造林','绿化','扬尘','烟尘','尾气','大气','碧水','蓝天','污水','处理率','河长','绿地','美丽','水源','水耗','颗粒','联防','联控','联防','空气质量','环保','污染','能耗','减排','排污','生态','绿色','低碳','空气','二氧化硫','二氧化碳','可持续','清洁能源','化石燃料','煤','石油','天然气','太阳能','核能','回收']

list2 = []

m = 0

n = 0

for i in range(0,len(items)):word, count = items[i] #变量名word对应字典中的键对,变量名count对应字典中的键值m = m+count #m对应全篇所有词数if word in list_env: list2.append([word,count])n = n+count #n为所有环保类关键词个数的汇总

print(m,n)运行得到总词数和环保词词数:

46223 92完整代码如下:

import pdfplumber

import jiebapath = '000661:2021年年度报告.pdf'

pdf = pdfplumber.open(path)

text_all = ""

for page in pdf.pages:text = page.extract_text() text_all = text_all+'\n'+text #字符串拼接

#print(text_all)words = jieba.cut(text_all)

stop = open("stopwords.txt", "r", encoding='utf-8').read()# 打开停用词txt文件

#print(stop)

counts = {}# 创建空字典,用来接收统计结果

for word in words:if word not in stop:# 去除停用词if len(word) == 1:#去除字符长度为1的字continueelse:counts[word] = counts.get(word, 0) + 1#满足上述条件,频率加1

#print(counts) items = list(counts.items())#转换为列表

items.sort(key=lambda x: x[1], reverse=True)#对词频进行降序排序

list_env = ['治理','PM10','PM2.5','雾霾','保护环境','资源','循环','全球变暖','酸雨','温室效应','节水','造林','绿化','扬尘','烟尘','尾气','大气','碧水','蓝天','污水','处理率','河长','绿地','美丽','水源','水耗','颗粒','联防','联控','联防','空气质量','环保','污染','能耗','减排','排污','生态','绿色','低碳','空气','二氧化硫','二氧化碳','可持续','清洁能源','化石燃料','煤','石油','天然气','太阳能','核能','回收']

list2 = []

m = 0

n = 0

for i in range(0,len(items)):word, count = items[i] #变量名word对应字典中的键对,变量名count对应字典中的键值m = m+count #m对应全篇所有词数if word in list_env: list2.append([word,count])n = n+count #n为所有环保类关键词个数的汇总

print(m,n)这篇关于Python上市公司年报jieba“环保”词频统计的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!