本文主要是介绍强化学习中Sara算法和Q-Learning算法的区别,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

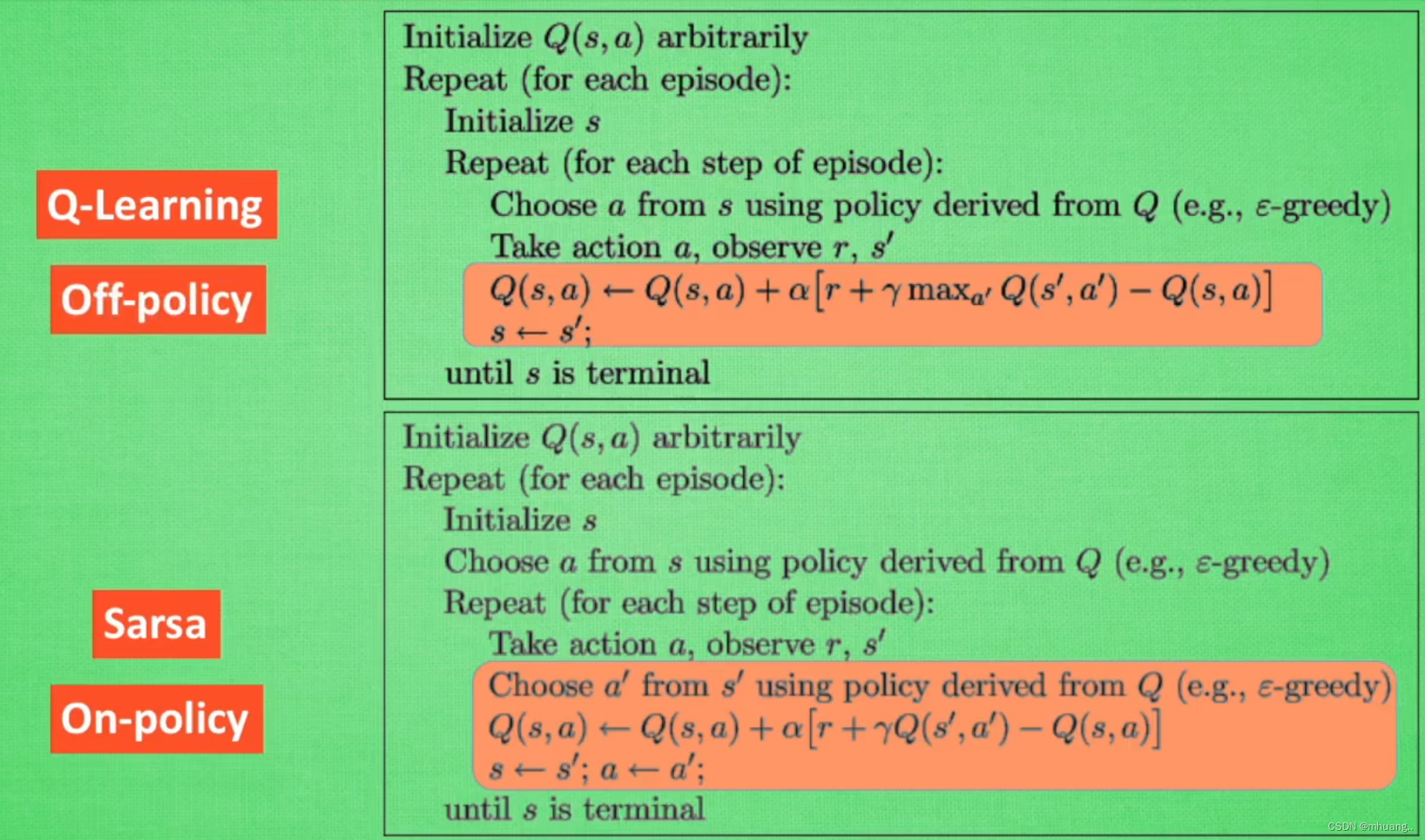

Q-Learning算法:

1,在环境S1中选出动作a1

2,得到a1这一步的动作价值

![]()

Q-target = R + γ*在状态S2中最优的下一步Q(s2, *a)的值

3,更新s1,a1这个状态的Q值

4,做出a1动作得到s2

Sara算法:

1,在环境S1中选出动作a1并得到S2

2,由环境S2选出将要下一步要进行的a2

3,由a1的奖励R,和Q(s2,a2)得到Q-target

![]()

4,由Q-target和原先的Q(s1,a1)去更新得到新的Q(s1,a1)

注:Q(s1,a1) = Q(s1, a1)+ α(Q-target - Q(s1,a1)) # α是学习率

二者在流程上是十分相似的,其区别在于Q-Learning在计算下一步的Q值时是用的S2状态中最好的那个Q值,但由于greedy在,所以实际上可能并不会采取这个动作。而Sara算法计算下一步Q值时是直接用已经得出的那个a2动作的Q值。

换句话说,当走到S2这个状态时,如果S2是个“好状态”,那么Sara一定会选择最优的那一步a2,而Q-Learning可能会“冒险”选择其他动作(要看动作选择函数中的greedy police的值)。

可以这么理解:面对一道难题,Sara比较老实,直接回答自己知道的答案,然后再检查自己这道题的是否拿到了分。而Q-Learning这个学生很聪明,他知道这道题(这个状态)的最优答案,但他也很调皮,他觉得这道题已经知道答案了所以先把这分加上,然后可能会去尝试其他答案。

对于同样的(s1,a1)得到的S2,Sara是先做出了a2动作,再计算这个动作对应的Q值,而Q-learning是得到S2后思考这个S2这个状态最优的动作是什么后就加上这个最优动作的Q值,然后再去选动作。

所以在模型训练表现上来看,Sara会看上去相对胆小,选错了就得到选错了的Q值,而Q-learning会更激进,哪怕选错了,也要得到这一步最优的Q值。

在这个阶段,如果将greedy police(探索程度)的值设为1,也就是说Q-learning一定会选择计算Q-target时的那个动作,Sara也会选择S2对应的最优动作(不会选错),那么Q-learning和Sara算法某种程度上可以看做是一样的。(我个人看法)

这篇关于强化学习中Sara算法和Q-Learning算法的区别的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!