本文主要是介绍果园环境下的路径检测论文汇总,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- 2018

- Orchard Free Space and Center Line Estimation Using Naive Bayesian Classifier for Unmanned Ground Self-Driving Vehicle

- 2020

- 果园智能车辆自动导航系统关键技术研究

- Path detection for autonomous traveling in orchards using patch-based CNN

- 2021

- 基于 U Net 网络的果园视觉导航路径识别方法

- Deep Semantic Segmentation at the Edge for Autonomous Navigation in Vineyard Rows

- 基于深度学习的果园环境路径识别研究

- An End-to-End Learning-Based Row-Following System for an Agricultural Robot in Structured Apple Orchards

- Learned Visual Navigation for Under-Canopy Agricultural Robots

- 果园机器人视觉导航行间位姿估计与果树目标定位方法

- 2022

- 基于卷积神经网络的果园运载平台行进路径自主检测方法研究

- Development of a Combined Orchard Harvesting Robot Navigation System

- Tree Trunk Recognition in Orchard Autonomous Operations under Different Light Conditions Using a Thermal Camera and Faster R-CNN

- Semantic segmentation and path planning for orchards based on UAV images

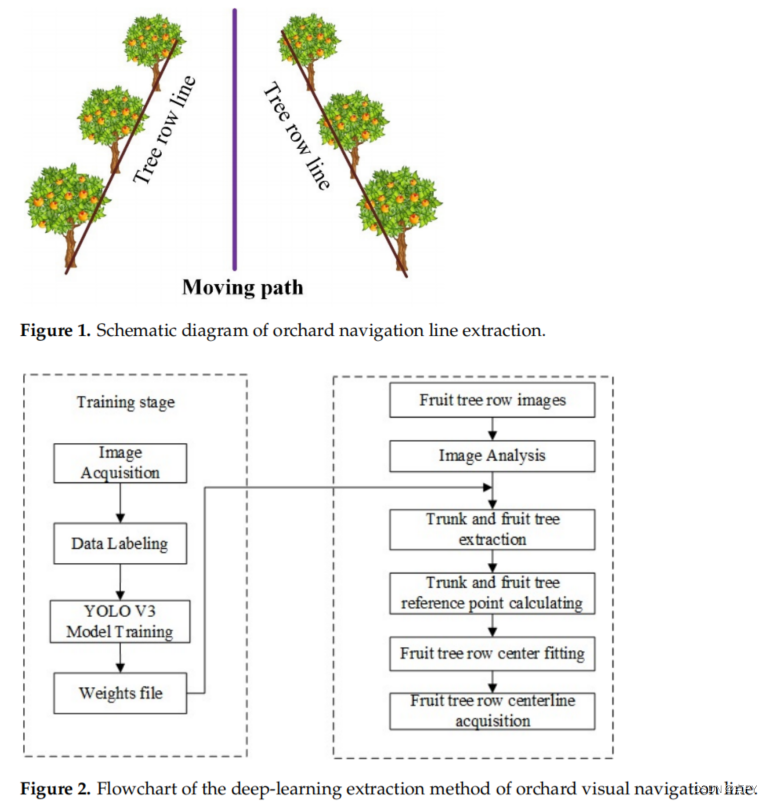

- A Deep-Learning Extraction Method for Orchard Visual Navigation Lines

2018

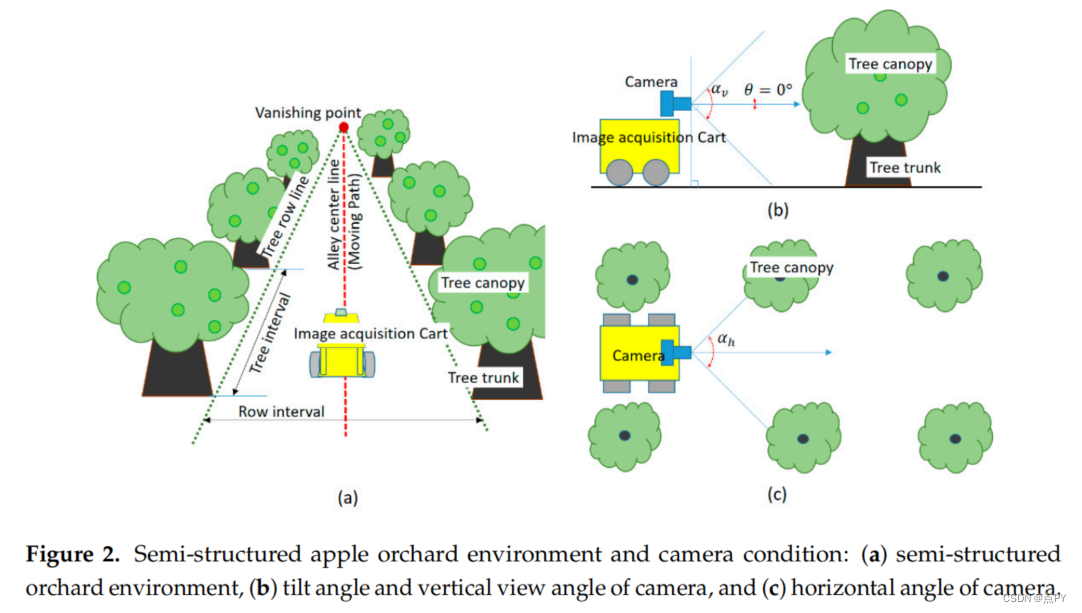

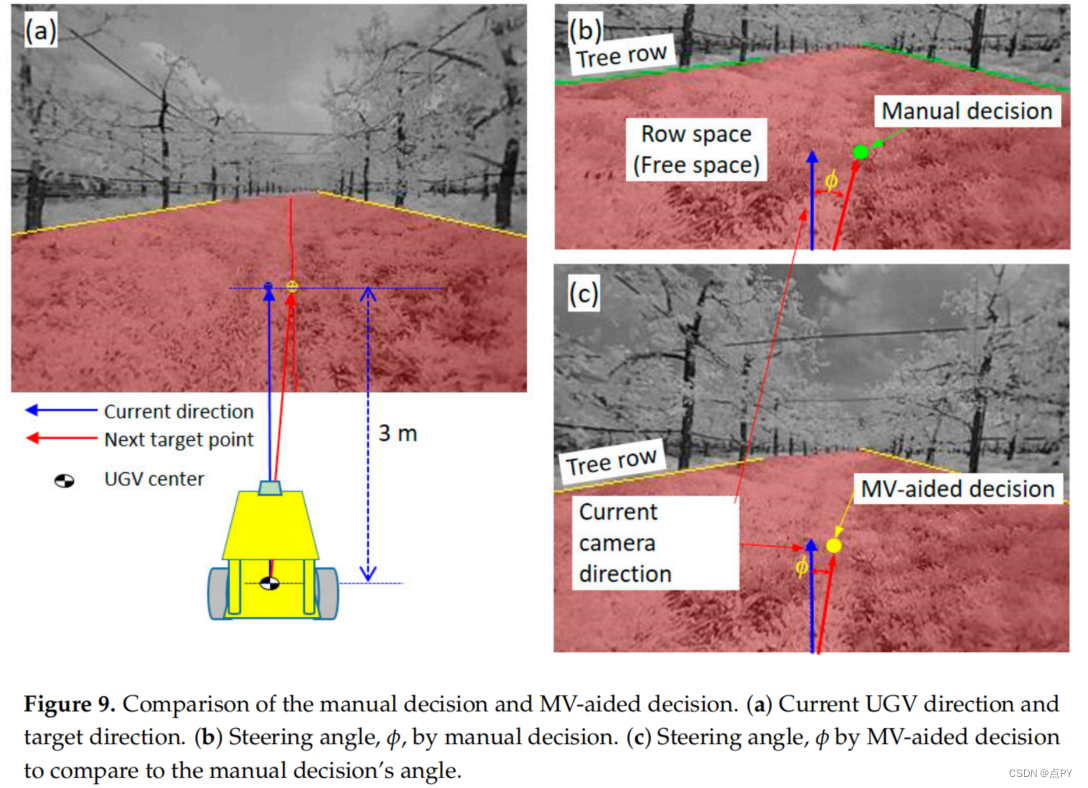

Orchard Free Space and Center Line Estimation Using Naive Bayesian Classifier for Unmanned Ground Self-Driving Vehicle

摘要: 在果园自主导航的情况下,研究人员开发了利用果园中的树干、树冠和天空等特征的算法,但在不断变化的农业环境中,识别自主导航的自由空间仍存在各种困难。在本研究中,我们应用朴素贝叶斯分类来检测树干和地面之间的边界,并提出了一种确定自由空间中心线的算法。朴素贝叶斯分类需要少量的样本进行训练和一个简单的训练过程。此外,它还能够有效地对果园的树干点和噪声点进行基于视觉处理的分类,以及小树枝、土壤、杂草、地面树木阴影造成的噪声。利用基于互补金属氧化物半导体(CMOS)图像传感器(CIS)相机的图像采集系统获得的229个样本图像,研究了该算法的性能。对单眼人工决策检测到的中心线与该算法提取的结果进行了比较和分析。在所有比较参数中,提取的中心线比手动的中心线结果更稳定。

2020

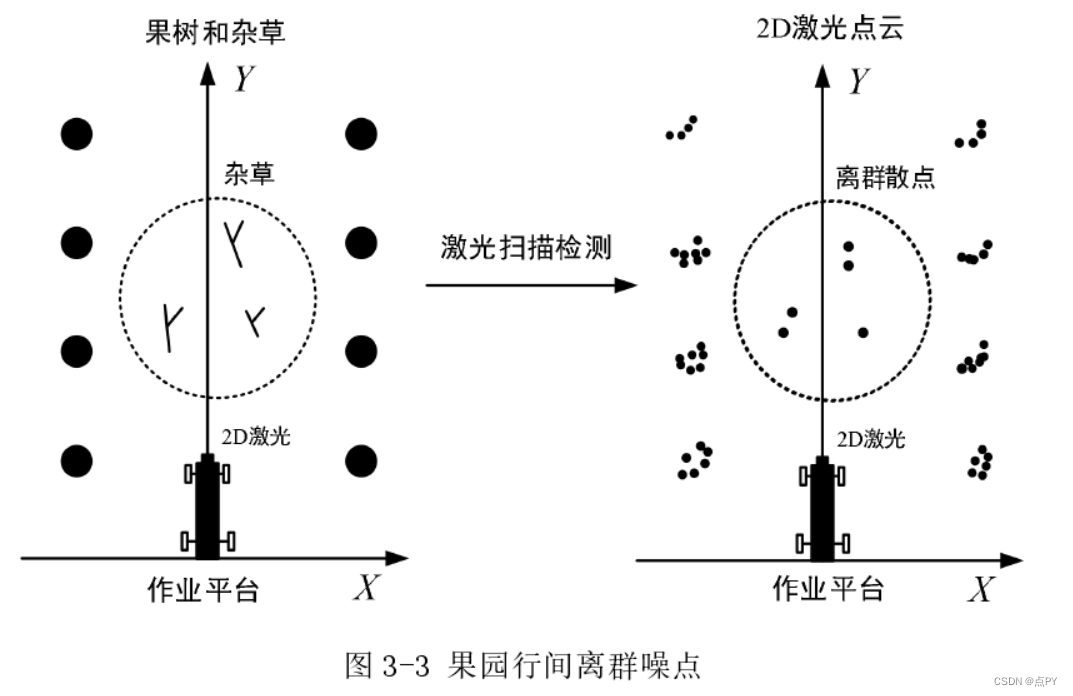

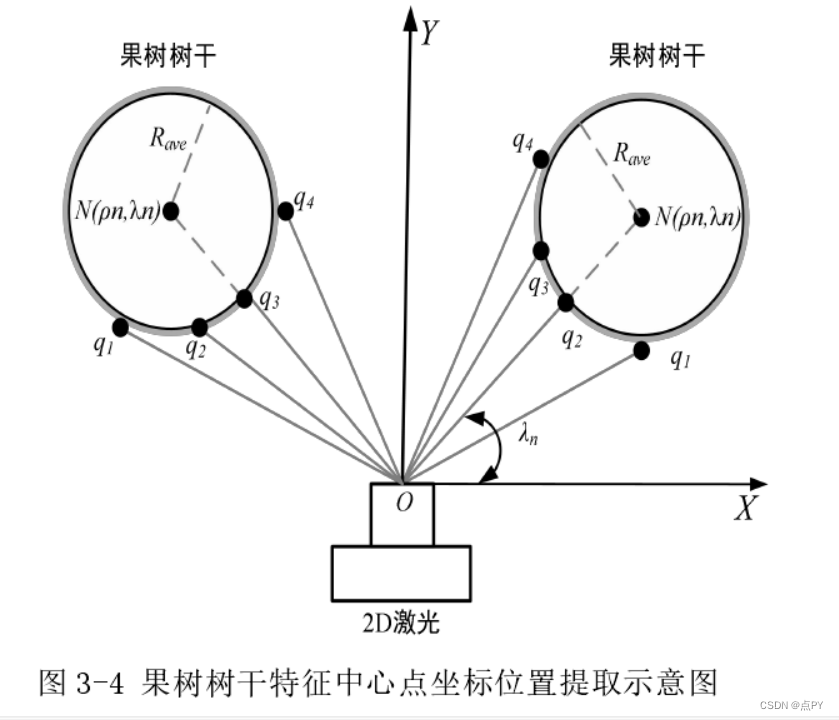

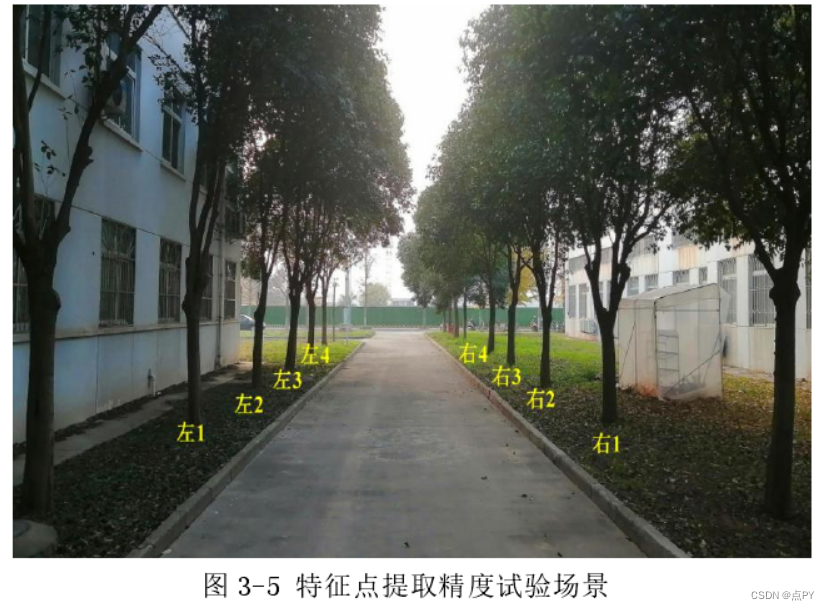

果园智能车辆自动导航系统关键技术研究

摘要: 针对环境感知定位中激光数据易受跨行果树或行间小型障碍物等因素影响,造成定位精度变差的问题,提出了一种将距离阈值法或统计滤波法相组合的数据预处理方法。为了减少导航系统的运算量,提出了一种利用欧式聚类后同棵果树下最短p值点、激光发射点和果树树干中心点几何三点共线原理来获取树干特征中心点的方法。实验结果表明与实际位置相比在X轴方向最大偏差为8cm,平均偏差为3.2cm,标准差为2.7cm;在Y轴方向最大偏差为9.9cm,平均偏差为6.5cm,标准差为2.3cm,精度可以满足实际需要。同时采用最小二乘法完成了对导航直线路径的拟合,并将航向偏差和横向偏差作为导航控制参数进行获取,与实际值相比航向角最大绝对误差为0.95°,平均绝对误差为0.682°,均方根误差为0.237°;横向偏差最大绝对误差为4.66cm,平均绝对值差为2.119cm,均方根误差为1.010cm,实验结果表明导航参数获取精度可以满足试验平台在果园自主作业要求。

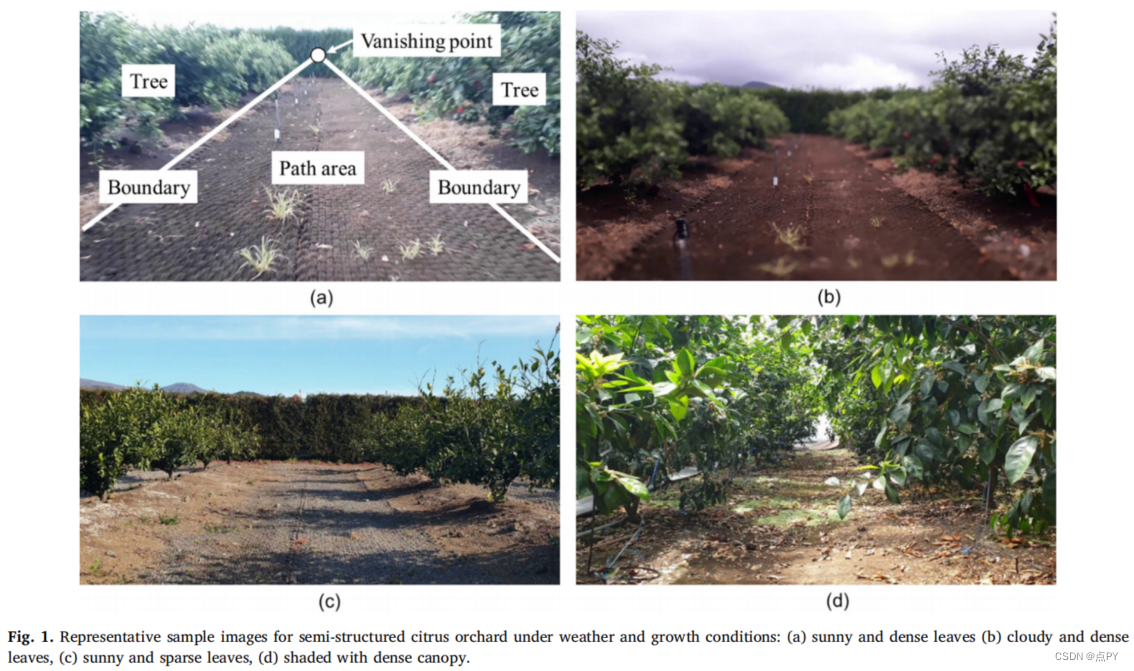

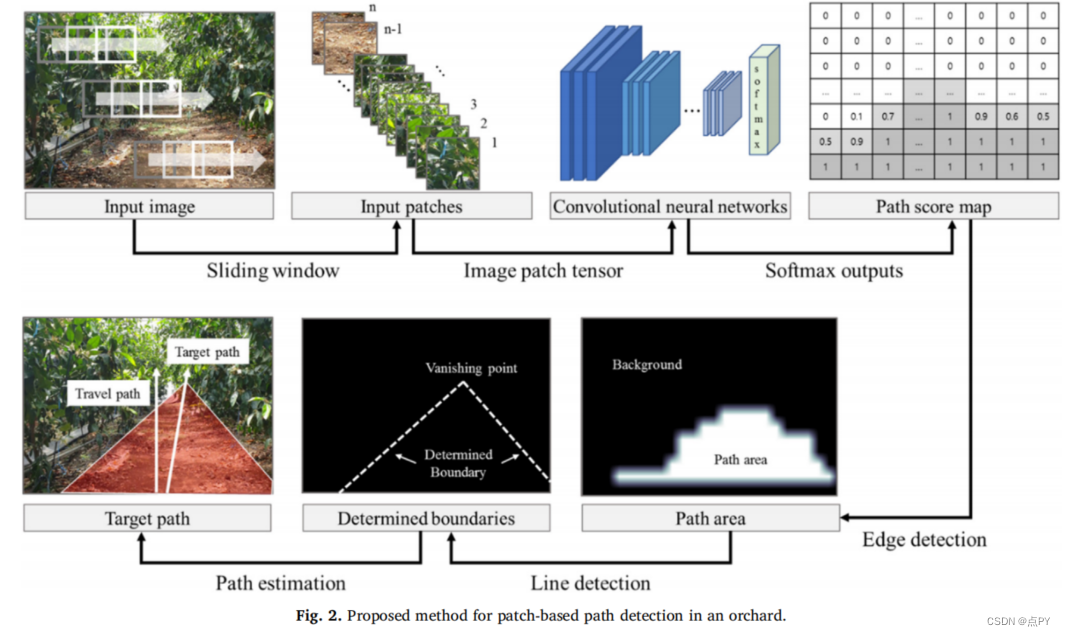

Path detection for autonomous traveling in orchards using patch-based CNN

摘要: 本文提出了一种新的、高效的基于补丁的果园等半结构化环境中的自动路径检测方法。该方法可以在正面场景中分割一个透视路径区域,有望应用于农业中的各种区域检测任务。在提出的方法,基于patch的卷积神经网络(CNN)用于图像分类实现路径区域分割,包括裁剪图像补丁输入图像使用滑动窗口,生成一个路径得分地图使用四层CNN树和路径分类,路径区域分割,目标路径检测使用边界线确定。结果表明,路径区域定位的最大交集(IoU)约为0.81,平均横向误差和角误差分别为0.051和7.8°。基于补丁的路径检测的性能取决于滑动窗口的补丁大小。因此,根据补丁大小来评估路径检测性能,当补丁大小为96×96时,其性能最好,分类精度为0.93,IoU为0.75,处理时间为0.111 s。此外,通过将该方法应用于包括弯曲路径在内的各种图像,验证了该方法的有效性。结果表明,所提出的基于补丁的路径检测方法的性能可与以前的方法相媲美。此外,利用该技术具有简单的硬件配置,可以很容易地开发一个自主的农场机器人。

2021

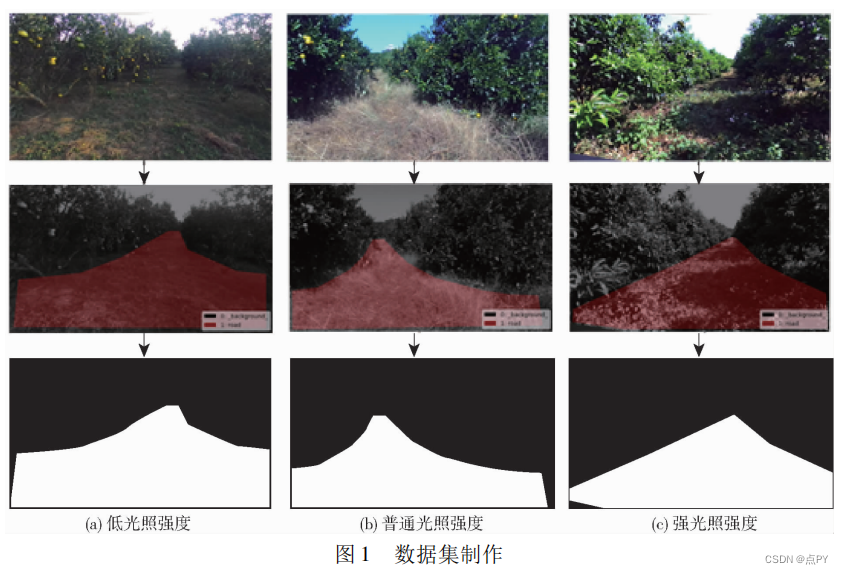

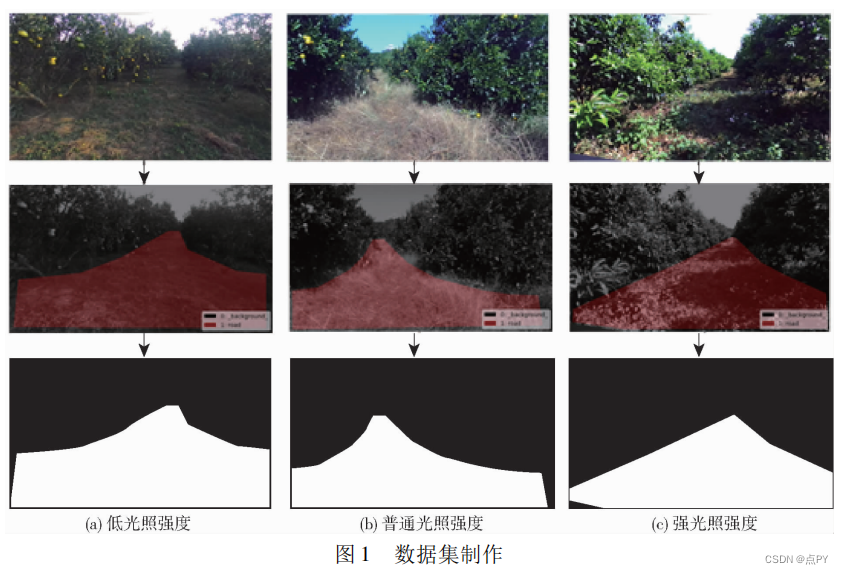

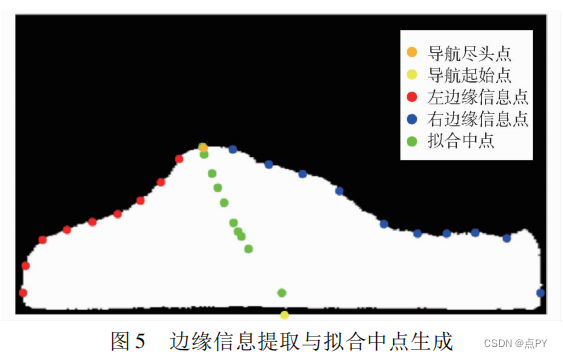

基于 U Net 网络的果园视觉导航路径识别方法

摘要: 针对视觉导航系统在果园环境中面临的图像背景复杂、干扰因素多等问题,提出了一种基于 U Net 网络的果园视觉导航路径识别方法。使用 Labelme 对采集图像中的道路信息进行标注,制作果园数据集; 基于 U Net 语义分割算法,在数据增强的基础上对全卷积神经网络进行训练,得到道路分割模型; 根据生成的道路分割掩码进行导航信息提取,生成路径拟合中点; 基于样条曲线拟合原理对拟合中点进行多段三次 B 样条曲线拟合,完成导航路径的识别; 最后,进行了实验验证。结果表明,临界阈值为 0. 4 时,语义分割模型在弱光、普通光以及强光照条件下的分割交并比分别为 89. 52% 、86. 45% 、86. 16% ,能够平稳实现果园道路像素级分割; 边缘信息提取与路径识别方法可适应不同视角下的道路掩码形状,得到较为平顺的导航路径; 在不同光照和视角条件下,平均像素误差为9. 5 像素,平均距离误差为 0. 044 m,已知所在果园道路宽度约为 3. 1 m,平均距离误差占比为 1. 4% ; 果园履带底盘正常行驶速度一般在 0 ~ 1. 4 m/s 之间,单幅图像平均处理时间为 0. 154 s。在当前果园环境和硬件配置下,本研究可为视觉导航任务提供有效参考。

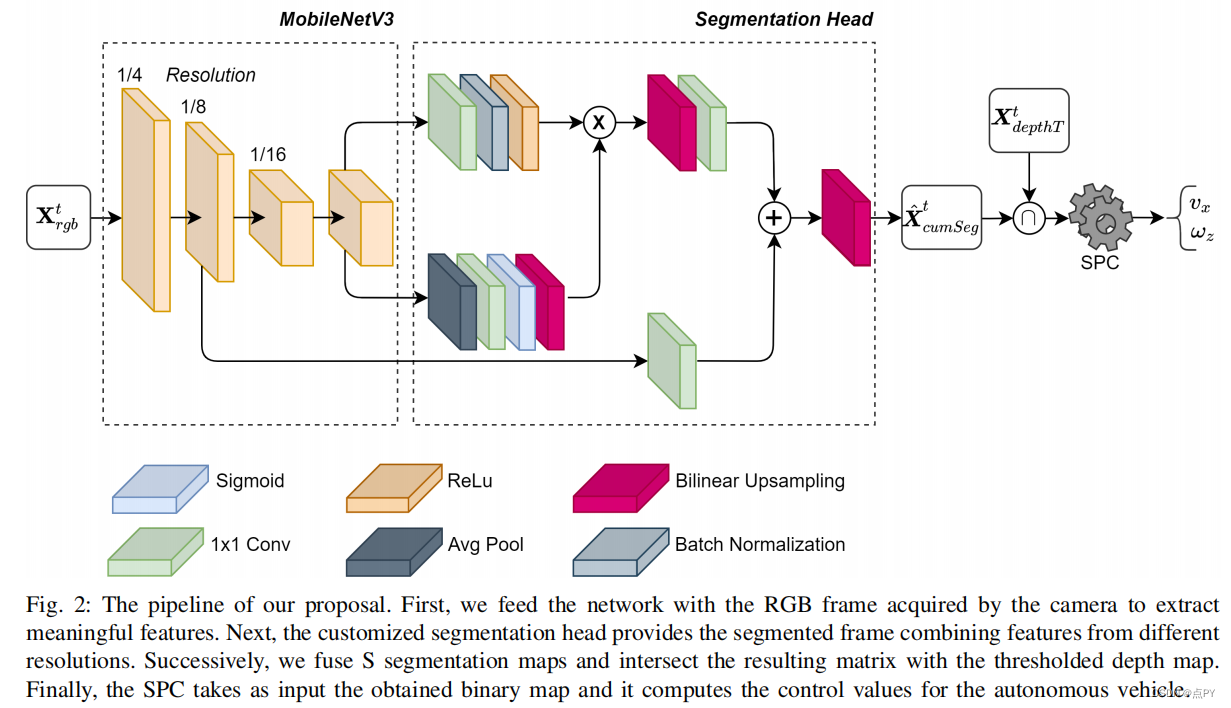

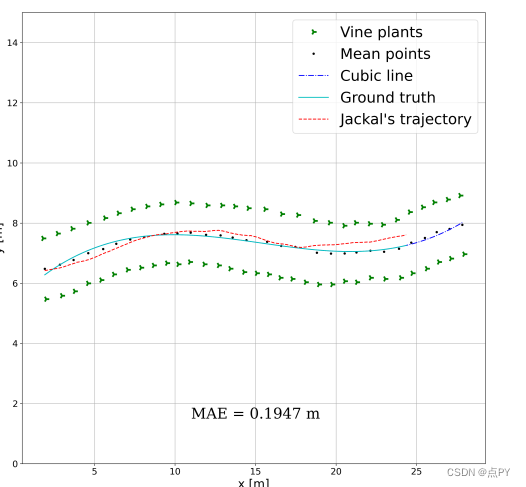

Deep Semantic Segmentation at the Edge for Autonomous Navigation in Vineyard Rows

摘要:精准农业是一个快速发展的领域,旨在将负担得起和有效的自动化引入农业过程。如今,葡萄园导航的算法解决方案需要昂贵的传感器和高的计算工作负载,这妨碍了自主机器人平台在真实商业案例场景中的大规模适用性。从这个角度来看,我们提出的新控制利用了机器感知和边缘人工智能技术的最新进展,以实现在低计算和功耗的葡萄园行内高度经济和可靠的导航。实际上,使用定制训练的分割网络和低范围的RGB-D相机,我们能够利用环境的语义信息,在不同的葡萄园场景中产生平滑的轨迹和稳定的控制。此外,由控制算法本身生成的分割图可以直接作为作物状态的营养评估的过滤器。对真实世界的数据和模拟环境进行的广泛的实验和评估证明了我们的方法的有效性和内在的鲁棒性。

基于深度学习的果园环境路径识别研究

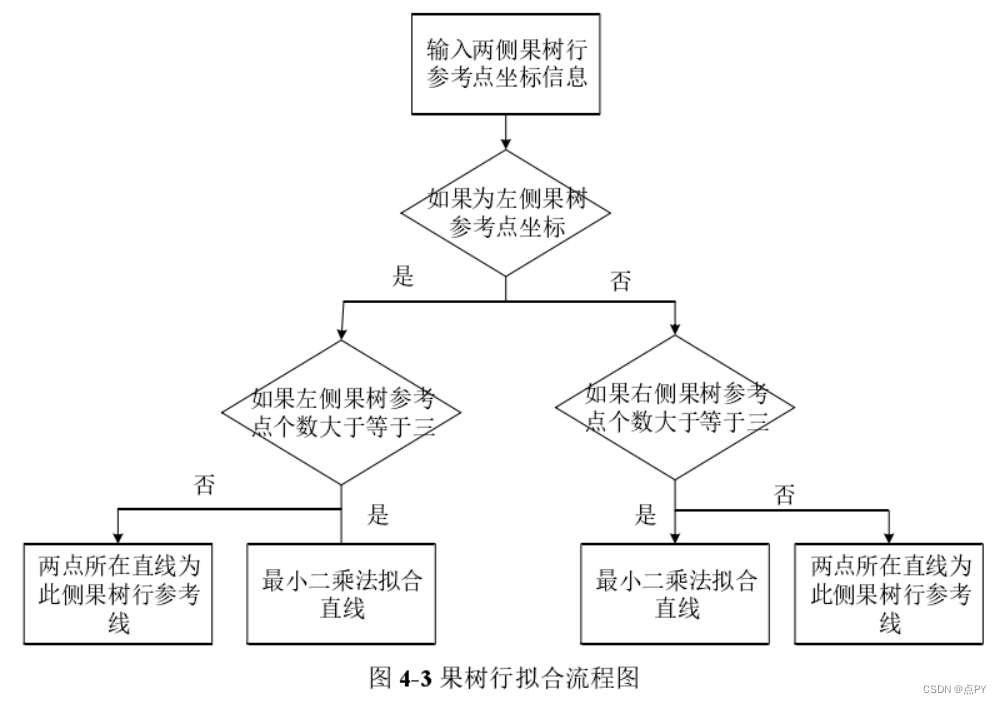

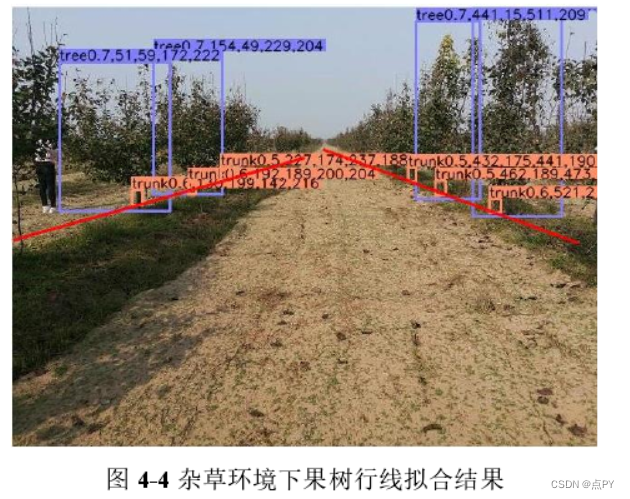

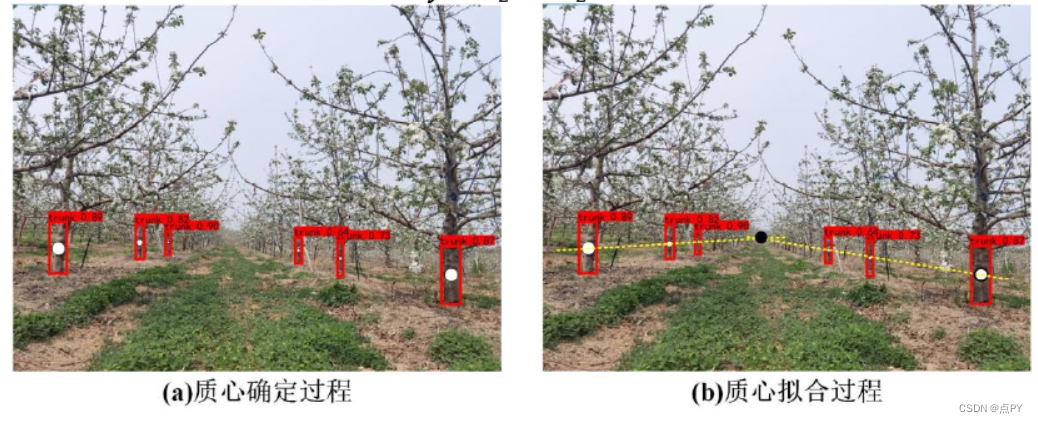

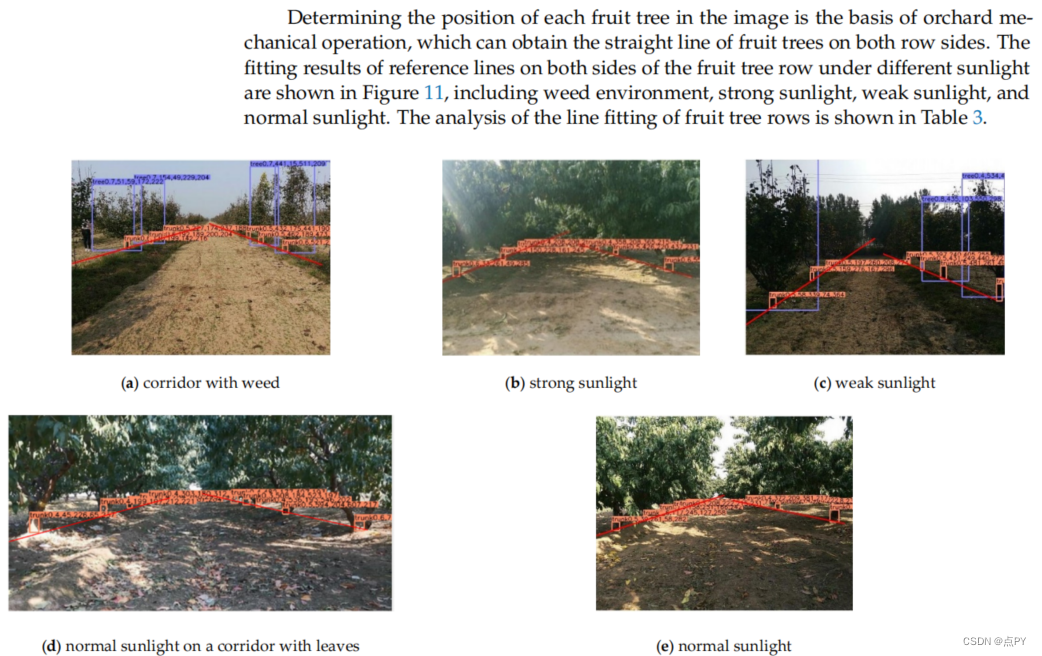

摘要: 为实现果园环境下的路径识别,本文将深度学习方法与果树行线拟合算法相结合提出DL-LF(Deep learning-Line fitting)算法。在实际的果园中采集大量图像数据,经过整理与标记后用于训练YOLOV3。果园环境下果树行中经常存在电线杆、果树支撑杆,以及杂草等干扰物,同时使用传统的方法很难迅速的识别出一些具有某些共同特征的树和非树目标。经过训练YOLOV3网络可准确识别树干与果树,同时在检测图像时同时输出边界框的坐标文本文件,树干与果树平均检测精度为92.11%。

结合深度学习方法检测图像中树干,将获得的矩形框坐标信息用以提取果园机械行走路径识别。经树干边界框坐标整理与计算后,得到此棵果树参考点坐标。此后,将两侧果树参考点分别用直线拟合算法合出当前果树行参考线。最后,取两侧参考线上最远果树参考点与最近果树参考点为两组的对应点,并分别计算两点所连线段中点。最终所得两个中点所在的直线即为果园机械行走路线,最终能够实现准确拟合果树行中线。果园机械沿着此路线自动行走在果树行间,为实现大规模果园的智能化与自动化管理打下基础。

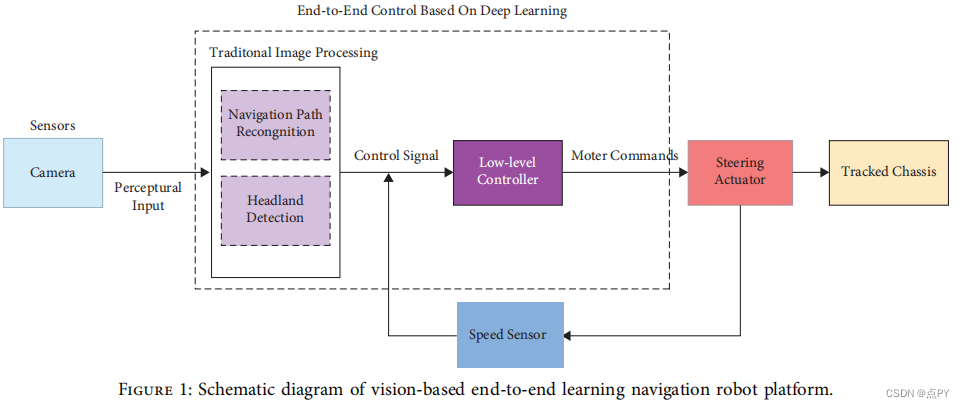

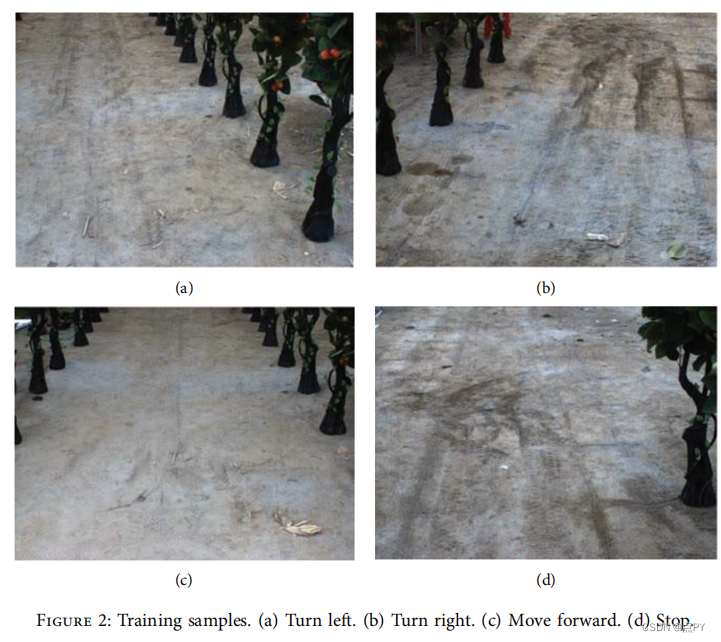

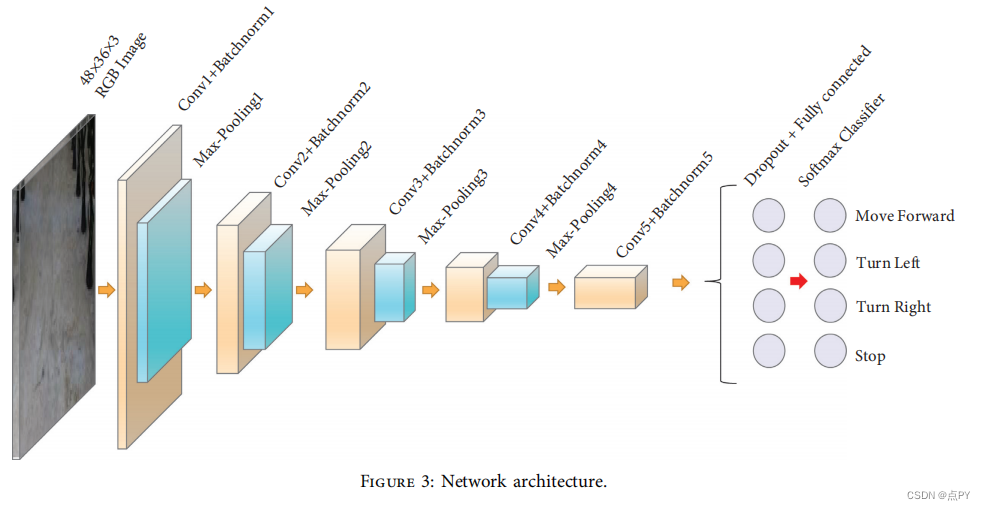

An End-to-End Learning-Based Row-Following System for an Agricultural Robot in Structured Apple Orchards

摘要:本文研究了一种基于端到端学习的农业机器人行跟踪系统。设计的端到端学习方法不是将导航划分为多个传统的子任务,而是将图像从摄像机直接映射到驾驶命令,这降低了导航系统的复杂性。提出了一种网络训练的样本采集方法,使机器人可以在无需操作员或远程控制的情况下自动驱动和采集数据。不需要对训练样本进行手工标记。为了提高网络的泛化程度,我们采用了批处理归一化、退出、数据增强和10倍交叉验证等方法。此外,还分析了网络的内部表示,并进行了行跟踪测试。测试结果表明,基于端到端学习的视觉导航系统可以根据不同的场景调整机器人的姿势,成功地引导机器人通过树行。

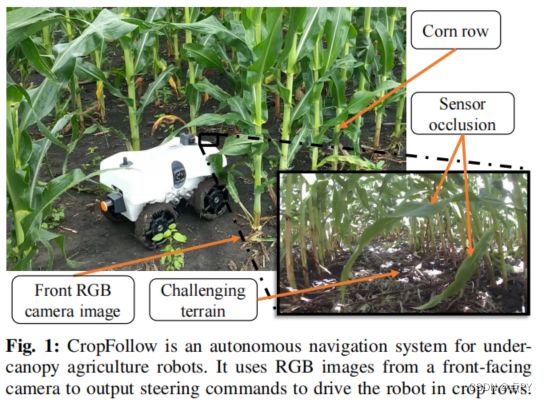

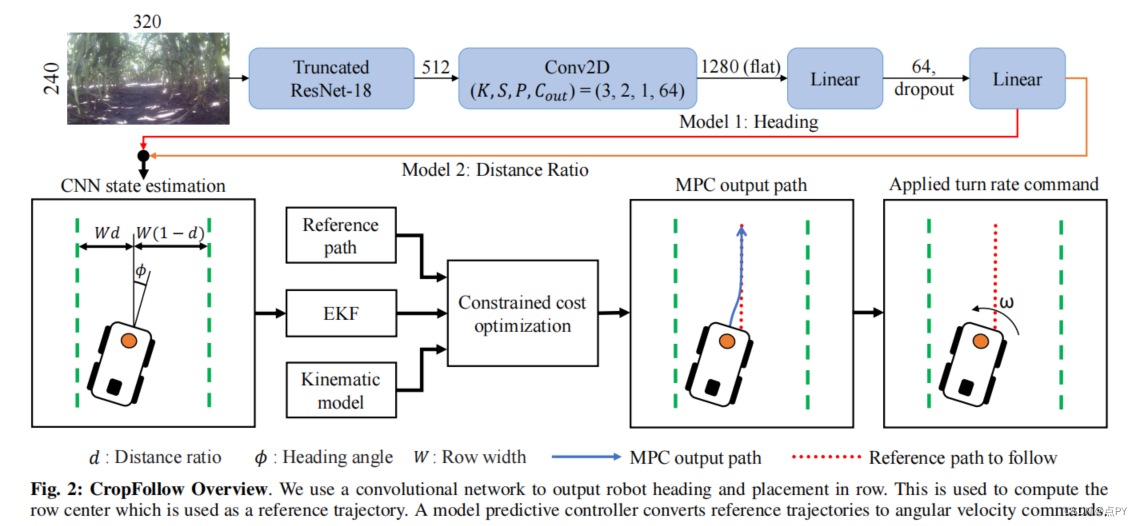

Learned Visual Navigation for Under-Canopy Agricultural Robots

摘要: 本文介绍了一种冠下农场机器人目引导自动导航系统。低成本的冠层下机器人可以在植物冠层下的作物行之间驱动,并完成冠层上的无人机或更大的农业设备无法完成的任务。然而,在树冠下自主导航它们会带来一系列挑战:不可靠的GPS和激光雷达、高感知成本、具有挑战性的农场地形、树叶和杂草造成的杂乱,以及整个季节和不同作物类型的外观的巨大差异。我们通过构建一个模块化系统来解决这些挑战,该系统利用机器学习从低成本相机的单目RGB图像中进行鲁棒和可推广的感知,并在具有挑战性的地形上进行模型预测控制。我们的系统,CropFollow,平均能够自动驾驶485米,在超过25公里的广泛现场测试中,性能优于最先进的激光雷达系统(每次干预286米)。

果园机器人视觉导航行间位姿估计与果树目标定位方法

2022

基于卷积神经网络的果园运载平台行进路径自主检测方法研究

摘要:采用训练好的目标识别模型与运载平台结合,实现路径检测。果园运载平台在果园行进时,改进的YOLOv5s目标识别模型实时检测,将目标框的实时坐标打印出来,得到识别框的位置信息,通过最小二乘法将识别框质心坐标点拟合,得到路径的下一目标点。运载平台实验结果表明,运载平台以0.7m/s的运行速度前进,可在目标识别的同时进行路径检测,能够为果园提供应用于实际环境的路径检测方法。

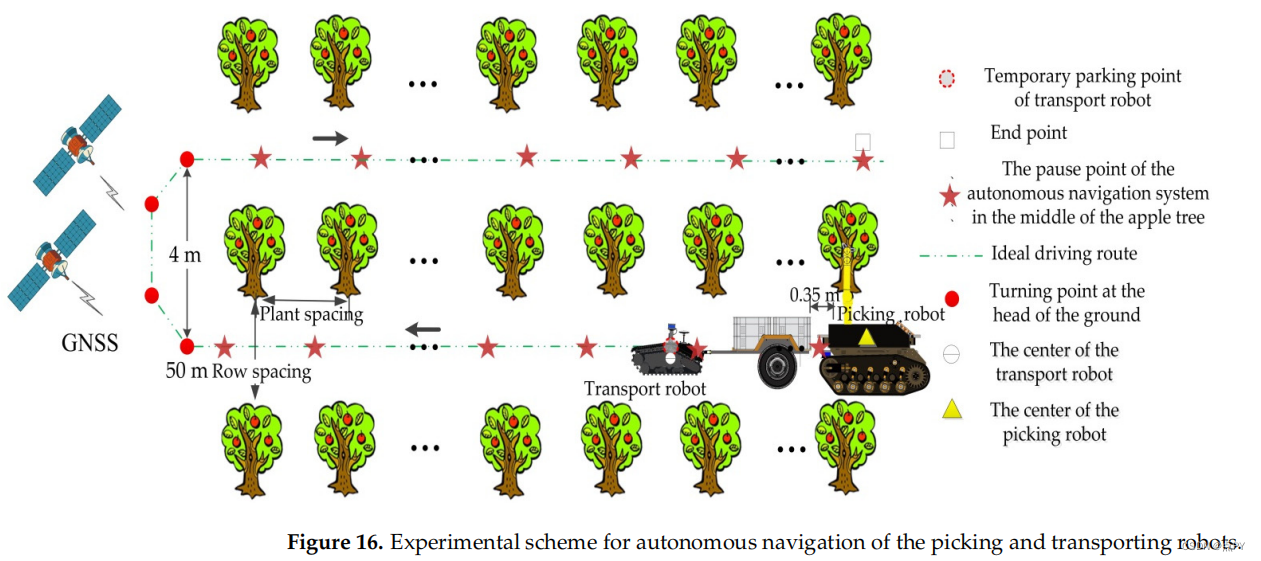

Development of a Combined Orchard Harvesting Robot Navigation System

摘要: 本研究旨在开发一种双主从模式的果园收获自动机器人导航系统,以自主导航拖拉机果园运输机器人为主,以导航果园采摘机器人为主。这就解决了在单主从导航模式下,农业联合收获设备不能在苹果树行之间重复停止和连续驱动的问题。根据从全球定位系统(GNSS)获得的距离,利用地面点切换运输拾取机器人的导航模式。采用布模拟滤波器(脑脊液)和随机样本一致(RANSAC)算法获取行间航路点。手动选择GNSS点作为主的转弯路径点,采用运动学模型计算从机的转弯路径点。最后,我们使用纯追踪算法对这些路径点进行顺序跟踪,以实现主从导航和地面头主从命令导航。实验结果表明,当机器人在50 m范围内的果园行内进行通信时,数据包丢失率小于1.2%,满足了机器人果园的通信要求。主从机器人可以通过跟踪导航实现行重复停止,满足联合果园收割的要求。主机器人位置偏差的最大、最小、均值和标准差分别为5.3cm、0.8cm、2.4cm和0.9cm。从属机器人的位置偏差大于主机器人,最大、最大、最小、均值和标准偏差分别为39.7cm、1.1cm、4.1cm和5.6cm。主从机器人之间的以下误差的最大、最小、均值和标准差分别为4.4cm、0cm、1.3cm和1 cm。对于地面航向转弯,指挥导航方法允许连续转弯,但机器人之间的横向偏差大于0.3 m,小于1m,航向偏差大于10◦,小于90◦。

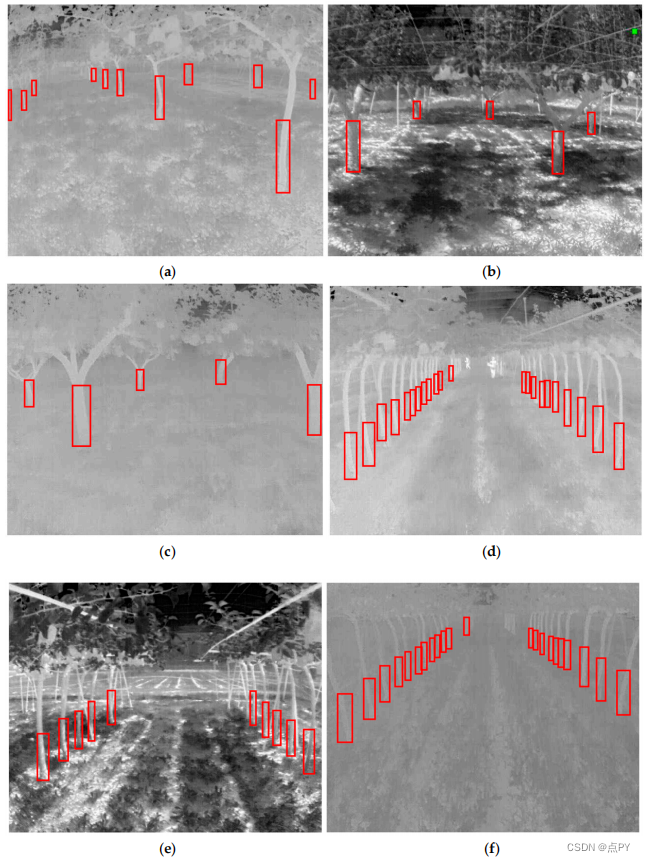

Tree Trunk Recognition in Orchard Autonomous Operations under Different Light Conditions Using a Thermal Camera and Faster R-CNN

摘要:在果园自动化过程中,当前的一个挑战是识别自然地标和树干来定位智能机器人。为了克服低光条件和全球导航卫星系统(GNSS)在密集的树冠下的信号中断,可以使用热敏摄像机来使用深度学习系统来识别树干。因此,本研究的目的是使用热敏摄像机在低光条件下检测一天中不同时间的树干,使用深度学习来让机器人导航。在2021年8月和9月(夏季),在强光(下午12-2点)、低光(下午5-6点)和无光(晚上7-8点)条件下的两种果园(常规和联合训练系统)的密集树冠层的热图像。热敏相机验证了树干的检测精度,在高、低光和无光条件下,5米的平均误差为0.16m,15米的平均误差为0.24m,20米距离的平均误差为0.3 m。热图像数据集被增强来训练,验证和测试使用更快的R-CNN深度学习模型来检测树干。共使用12876张图像进行模型训练,2318张图像用于验证训练过程,1288张图像用于模型测试。模型的mAP为0.8529,测试过程为0.8378。当热敏摄像机设置为11FPS时,图像的平均目标检测时间为83 ms,视频的平均目标检测时间为90 ms。将模型与相同数据集和训练条件的YOLO v3进行比较。在比较中,更快的R-CNN在使用热成像相机检测卡车时获得了比YOLO v3更高的精度。因此,研究结果表明,更快的R-CNN可以利用热图像识别物体,使机器人能够在不同光照条件下的果园中导航。

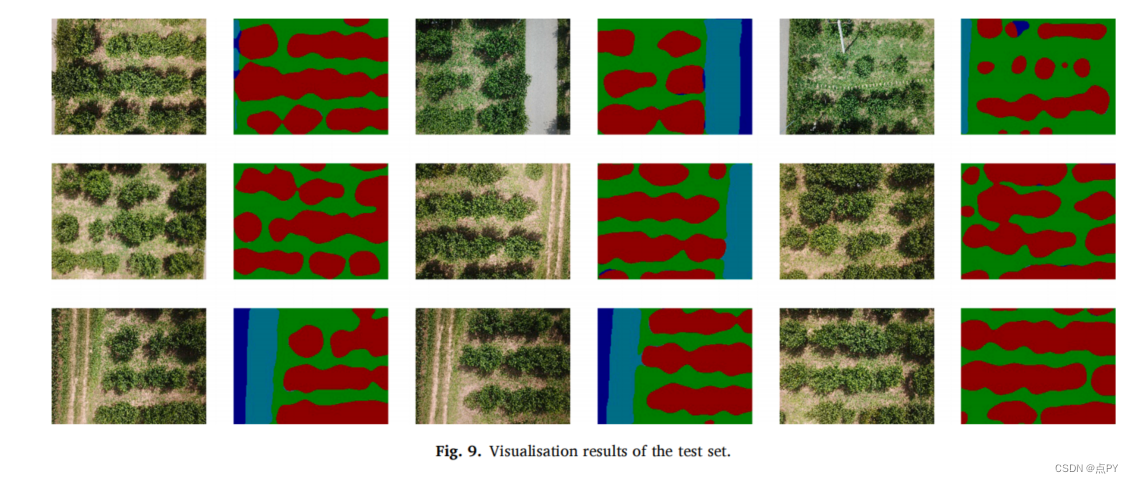

Semantic segmentation and path planning for orchards based on UAV images

摘要: 提出了一种新的语义分割网络——空间无人机深度网络(SADNet)对果园无人机(UAV)图像进行分割。在SADNet中,引入了一种深度标识卷积块(DIC)来优化网络特征提取能力。引入了一种空间空间金字塔池模块(ASPP)来融合多尺度语义信息。为了改善网络的接受域,我们还引入了并发的空间和通道挤压和激励模块(scSE),将网络聚焦在需要注意的像素上。SADNet在果园数据集上的性能优于DeepLabv3、PSPNet和R2U-Net。像素精度和并集的平均交集分别达到93.61 %和88.28 %。在公共数据集Pascal VOC 2012上,SADNet的MIoU达到了86.2 %。然后,基于果园分割的结果,提出了一种构建果园光栅图的新方法。在此基础上,我们对果园的行内路径和行间路径进行了规划。规划路径距离最优路径的均方根误差最小,为3.19 m。基于无人机图像的果园分割和路径规划方法可以同时规划整个果园的路径,并可以帮助农业机器人进行农药喷洒和水果收获。

A Deep-Learning Extraction Method for Orchard Visual Navigation Lines

摘要: 果园机械自主导航有助于提高水果生产效率,降低劳动力成本。路径规划是果园机械自主导航的核心技术之一。果树通常笔直和平行种植,果树是自然地标,可以为果园智能机械提供合适的线索。本文提出了一种基于计算机视觉技术实现路径规划的新方法。我们结合深度学习和最小二乘(DL-LS)算法,提出了一种新的果园场景导航线提取算法。首先,收集并处理了大量的实际果园图像,以训练YOLO V3模型。经过训练后,该模型对树干和树的检测的平均平均精度(MAP)可达到92.11%。其次,利用树干边界箱的坐标计算果树的参考点坐标。第三,用最小二乘法拟合两侧果树的参考线,用两条参考线确定果园机械的导航线。实验结果表明,训练后的YOLO V3网络能够准确地识别树干和果树,并且能够有效地提取出新的果树行导航线。果园中心线提取的准确率为90.00%。

这篇关于果园环境下的路径检测论文汇总的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!