本文主要是介绍IP数据报首部格式,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

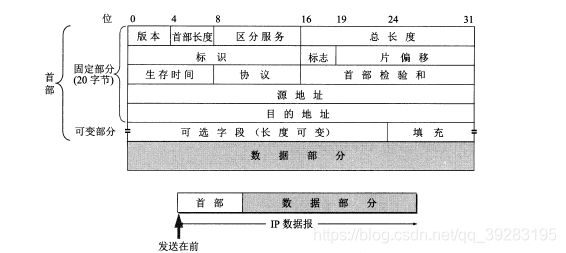

1. IP数据报首部的固定部分中的各字段

(1)版本 占4位,指IP协议的版本。通信双方使用的IP协议的版本必须一致。目前广泛使用的IP协议版本号为4 (即IPv4)。 关于以后要使用的IPv6 (即版本6的IP协议),我们将在后面的4.6节讨论。

(2)首部长度 占4位,可表示的最大十进制数值是15。 请注意,首部长度字段所表示数的单位是32位字(1 个32位字长是4字节)。因为IP首部的固定长度是20字节,因此首部长度字段的最小值是5 (即二进制表示的首部长度是0101)。 而当首部长度为最大值111时(即十进制数的15), 就表明首部长度达到最大值15个32位字长,即60字节。当IP分组的首部长度不是4字节的整数倍时,必须利用最后的填充字段加以填充。因此IP数据报的数据部分永远在4字节的整数倍时开始,这样在实现IP协议时较为方便。首部长度限制为60字节的缺点是有时可能不够用。但这样做是希望用户尽量减少开销。最常用的首部长度是20字节(即首部长度为0101),这时不使用任何选项。

(3)区分服务 占8位,用来获得更好的服务。这个字段在旧标准中叫做服务类型,但实际上-直没有被使用过。1998 年IETF 把这个字段改名为区分服务DS (DifferentiatedServices)。只有在使用区分服务时,这个字段才起作用(见8.4.4 节)。在一-般的情况下都不使用这个字段[RFC 2474, 3168, 3260]。

(4)总长度 总长度指首部和数据之和的长度,单位为字节。总长度字段为16位,因此数据报的最大长度为216- 1 = 65535字节。然而实际上传送这样长的数据报在现实中是极少遇到的。

我们知道,在IP层下面的每一种数据链路层协议都规定了-.个数据帧中的数据字段的最大长度,这称为最大传送单元MTU (Maximum Transfer Unit)。当-一个IP数据报封装成链路层的帧时,此数据报的总长度(即首部加上数据部分)一定不能超过下面的数据链路层所规定的MTU值。例如,最常用的以太网就规定其MTU值是1500字节。若所传送的数据报长度超过数据链路层的MTU值,就必须把过长的数据报进行分片处理。

虽然使用尽可能长的IP数据报会使传输效率得到提高(因为每- -个IP数据报中首部长度占数据报总长度的比例就会小些),但数据报短些也有好处。每-一个IP数据报越短,路由器转发的速度就越快。为此,IP协议规定,在互联网中所有的主机和路由器,必须能够接受长度不超过576字节的数据报。这是假定上层交下来的数据长度有512字节(合理的长度),加上最长的IP首部60字节,再加上4字节的富余量,就得到576字节。当主机需要发送长度超过576字节的数据报时,应当先了解一下,目的主机能否接受所要发送的数据报长度。否则,就要进行分片。

在进行分片时(见后面的“片偏移”字段),数据报首部中的“总长度”字段是指分片后的每一-个分片的首部长度与该分片的数据长度的总和。

(5)标识(identification) 占16位。IP软件在存储器中维持一个计数器,每产生一个数据报,计数器就加1, 并将此值赋给标识字段。但这个“标识”并不是序号,因为IP是无连接服务,数据报不存在按序接收的问题。当数据报由于长度超过网络的MTU而必须分片时,这个标识字段的值就被复制到所有的数据报片的标识字段中。相同的标识字段的值使分片后的各数据报片最后能正确地重装成为原来的数据报。

(6)标志(flag) 占3位,但目前只有两位有意义。

●标志字段中的最低位记为MF (More Fragment)。 MF = 1即表示后面“还有分片”的数据报。MF = 0表示这已是若干数据报片中的最后-一个。

●标志字段中间的一位记为DF (Don't Fragment), 意思是“不能分片”。只有当DF=0时才允许分片。

(7)片偏移 占13位。片偏移指出:较长的分组在分片后,某片在原分组中的相对位置。也就是说,相对于用户数据字段的起点,该片从何处开始。片偏移以8个字节为偏移单位。这就是说,每个分片的长度一定是8字节(64位)的整数倍。

(8)生存时间 占8位,生存时间字段常用的英文缩写是TTL (Time To Live), 表明这是数据报在网络中的寿命。由发出数据报的源点设置这个字段。其目的是防止无法交付的数据报无限制地在互联网中兜圈子(例如从路由器R;转发到R2,再转发到Rs,然后又转发到R),因而白白消耗网络资源。最初的设计是以秒作为TTL值的单位。每经过- - 个路由器时,就把TTL减去数据报在路由器所消耗掉的一-段时间。若数据报在路由器消耗的时间小于1秒,就把TTL值减1。当TTL值减为零时,就丢弃这个数据报。

然而随着技术的进步,路由器处理数据报所需的时间不断在缩短,一般都远远小于1秒,后来就把TTL字段的功能改为“跳数限制”(但名称不变)。路由器在每次转发数据报之前就把TTL值减1。 若TTL值减小到零,就丢弃这个数据报,不再转发。因此,现在ttl的单位不再是秒,而是跳数。TTL的意义是指明数据报在互联网中至多可经过多少个路由器。显然,数据报能在互联网中经过的路由器的最大数值是255。若把TTL的初始值设置为1,就表示这个数据报只能在本局域网中传送。因为这个数据报-传送到局域网上的某个路由器,在被转发之前TIL值就减小到零,因而就会被这个路由器丢弃。

(9)协议 占8位,协议字段指出此数据报携带的数据是使用何种协议,以便使目的主机的IP层知道应将数据部分上交给哪个协议进行处理。

(10)首部检验和 占16位。这个字段只检验数据报的首部,但不包括数据部分。这是因为数据报每经过一一个路由器,路由器都要重新计算一下首部检验和(一些字段,如生存时间、标志、片偏移等都可能发生变化)。不检验数据部分可减少计算的工作量。为了进- -步减小计算检验和的工作量,IP首部的检验和不采用复杂的CRC检验码而采用下面的简单计算方法:在发送方,先把IP数据报首部划分为许多16位字的序列,并把检验和字段置零。用反码算术运算把所有16 位字相加后,将得到的和的反码写入检验和字段。接收方收到数据报后,将首部的所有16 位字再使用反码算术运算相加一次。将得到的和取反码,即得出接收方检验和的计算结果。若首部未发生任何变化,则此结果必为0,于是就保留这个数据报。否则即认为出差错,并将此数据报丢弃。图4-15说明了IP数据报首部检验和的计算过程。

(11)源地址 32位

(12)目的地址 32位

这篇关于IP数据报首部格式的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!