本文主要是介绍三星与海力士发力决战HBM4,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在8月中旬,三星宣布正在加速推进下一代HBM(High Bandwidth Memory)的研发,目标是在今年年底前完成HBM4的设计定稿(tape-out)。而SK海力士则继续保持其竞争力,计划在10月份完成HBM4的设计定稿,这一产品将被用来支持NVIDIA的Rubin AI芯片系列,此消息由Wccftech和ZDNet报道。

除了为NVIDIA提供HBM4之外,SK海力士还计划在未来几个月内为AMD的AI芯片进行HBM4的设计定稿。为了应对来自AI芯片巨头即将发布的新产品所带来的强劲需求,SK海力士正组建开发团队,以确保能够及时向NVIDIA和AMD供应HBM4。

根据SK海力士的产品路线图,该公司计划在2025年下半年推出12层堆叠的HBM4,并在2026年推出16层堆叠的版本。鉴于NVIDIA的Rubin系列芯片预计将在2026年问世,因此预计将采用HBM4 12Hi,每个GPU包含8个集群。

目前,SK海力士是NVIDIA AI芯片的主要HBM3e供应商。几个月前,SK海力士已经开始出货HBM3e产品,随后Micron也加入了这一行列。相比之下,三星的HBM3已经通过了NVIDIA的认证,但其HBM3e仍在努力通过NVIDIA的资格审查。

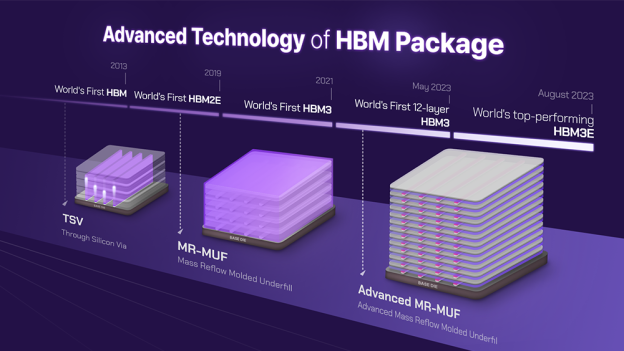

HBM4的引入对于SK海力士来说是一个重要的里程碑,因为它提供了最快的DRAM技术,具备卓越的能效和更高的带宽。HBM4将通道宽度加倍至2048位,而HBM3E仅为1024位。此外,它支持最多16层DRAM堆叠,高于HBM3e的12层,并提供24Gb和32Gb层的选择。这种进步将使每堆栈容量达到64GB,而HBM3e为32GB。

这篇关于三星与海力士发力决战HBM4的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!