本文主要是介绍测试测量-DMM直流精度,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

测试测量-DMM直流精度

最近去面试,发现了自己许多不足,比如我从未考虑过万用表准或者不准,或者万用表有多准?

在过去的实验室中,常用的DMM有KEYSIGHT 34401A以及 KEITHLEY THD2015,就以这两台为例,我们去看看他们能测试的边界在哪里?

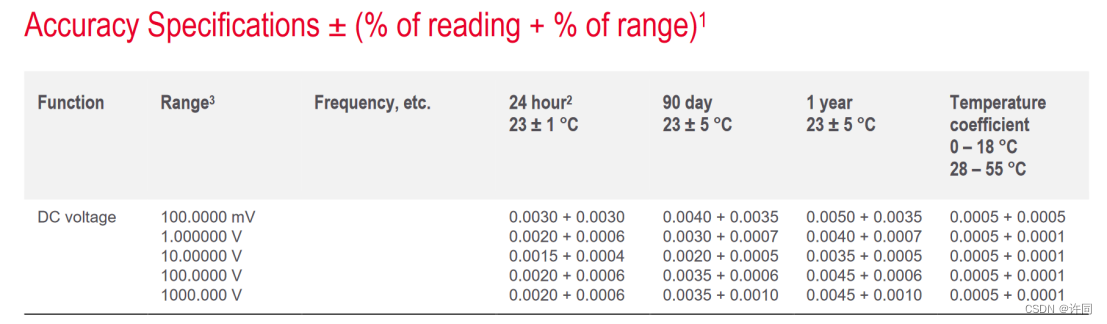

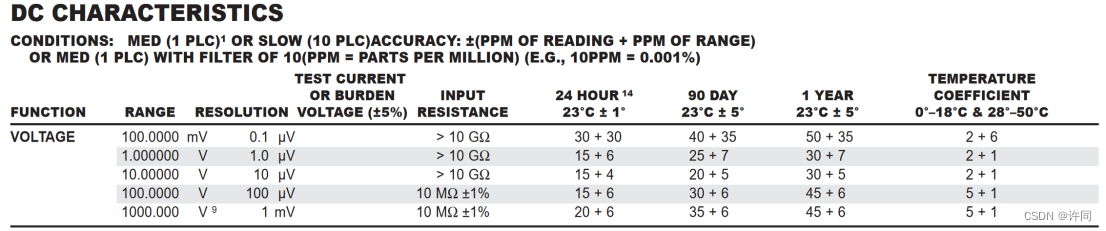

图1展示了34401A的测试精度说明,图2展示了THD2016的精度说明

图1:34401A 精度说明

图2:THD2016精度说明

在图2中 描述了THD2016的Resolution这表明了THD2016的最小分辨率是这么多。不是表示这个分辨率都是可信的,那到底那些是可信的?

我们既然有那个表了,那我们就可以从这个表得出结论。怎么算的,举个例子

例子:

首先定义输入输出条件

输入电压:7V

输入范围:10V

万用表:THD2016/34401A 校准后运行90天以内

环境温度:23℃±1℃

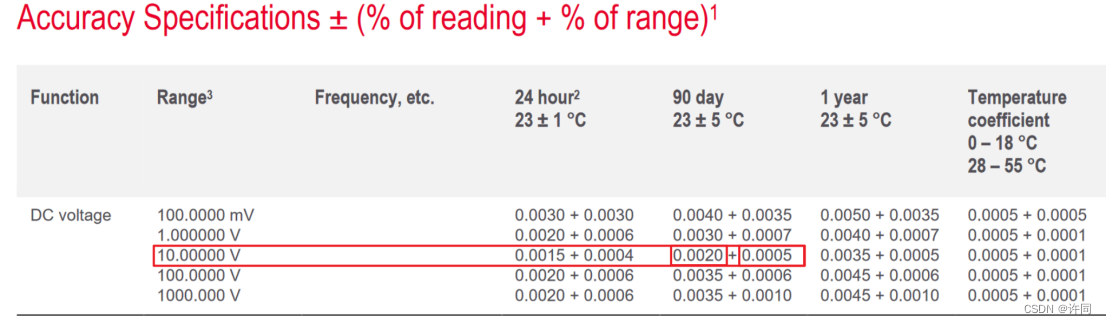

34401:

根据环境温度和校准后运行时间得出

0.002%读数

0.0005%电压档位

如图3所示:

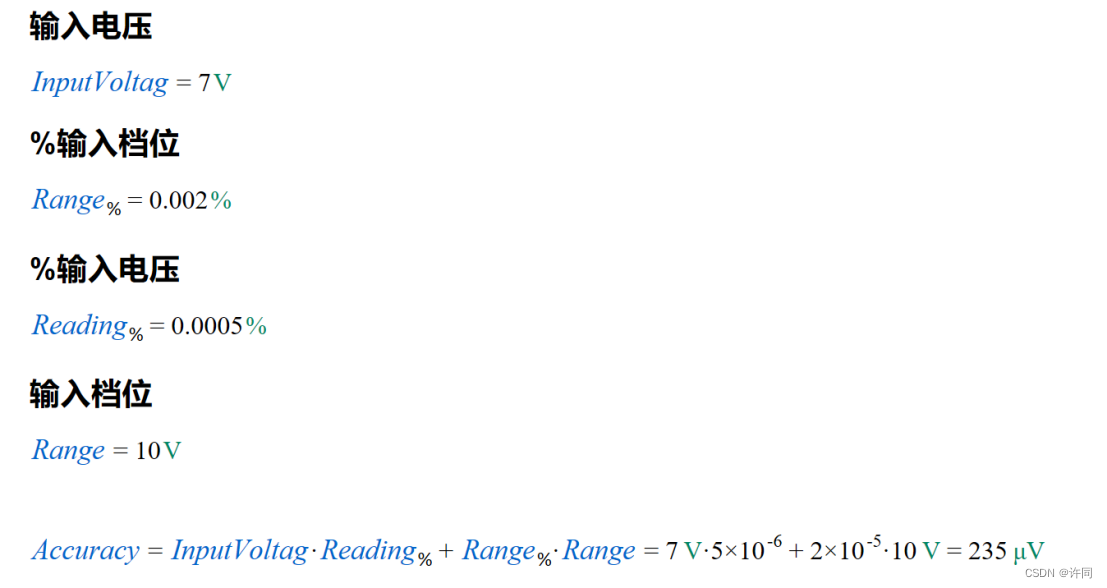

计算结果为:

CalcPad代码:

'<h3>输入电压 </h3>'

InputVoltag = 7V

'<h3>%输入档位 </h3>'

Range_% = 0.002%

'<h3>%输入电压 </h3>'

Reading_% = 0.0005%

'<h3>输入档位 </h3>'

Range = 10V

Accuracy = InputVoltag*Reading_% + Range_%*Range|μV

这个结果表明,在7V输入的时候,输入电压的范围是在7V±235uV上下波动的,这个波动值比Resolution要大的多,所以分辨率是不可以当做精度去用的。使用的时候要去注意。

在表格的最后一项我们看到,温度系数,这个温度系数咱们怎么去看他呢?

在其余工作条件不变化的情况下,我们改变温度为17℃,比23℃±5℃低一度,那我们怎么把这个东西计算进去?计算方法如下:

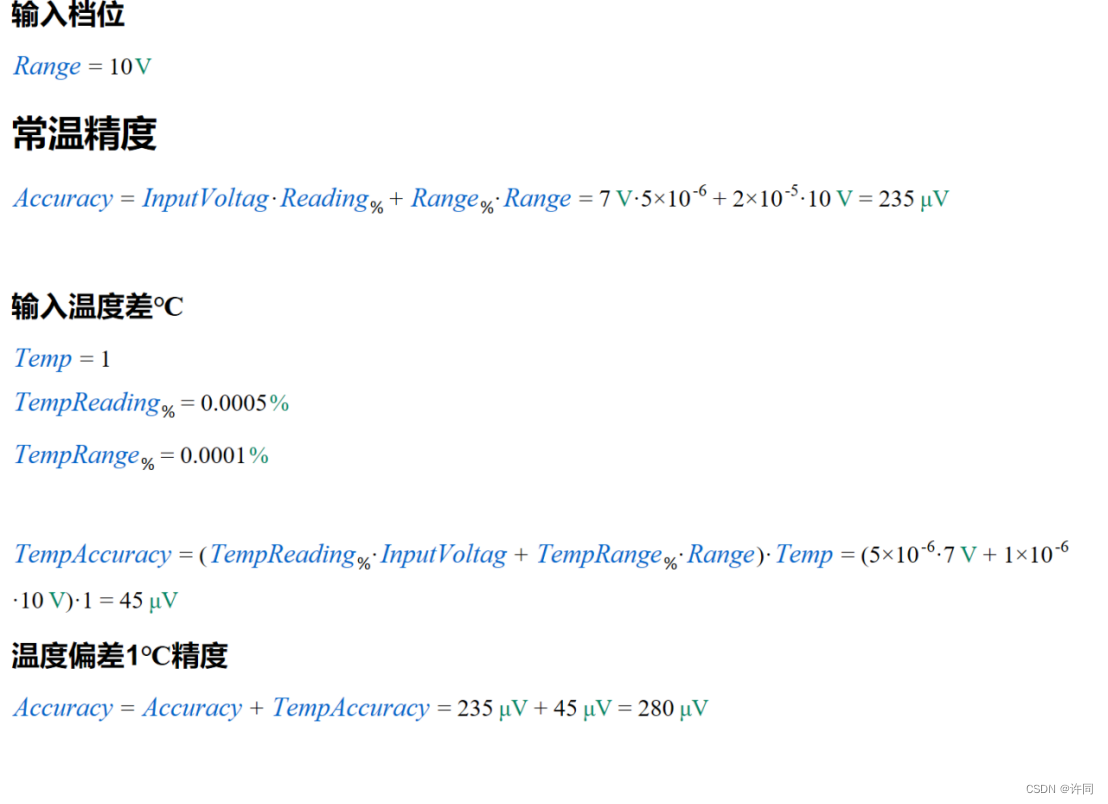

| '<h3>单位的设置 </h3>' .ppm = 10^-6 '<h3>输入电压 </h3>' InputVoltag = 7V '<h3>%输入档位 </h3>' Range_% = 0.002% '<h3>%输入电压 </h3>' Reading_% = 0.0005% '<h3>输入档位 </h3>' Range = 10V '<h2>常温精度 </h2>' Accuracy = InputVoltag*Reading_% + Range_%*Range|μV '<h3>输入温度差℃ </h3>' Temp = 1 TempReading_% = 0.0005% TempRange_% = 0.0001% TempAccuracy = (TempReading_%*InputVoltag + TempRange_%*Range)*Temp|μV '<h3>温度偏差1℃精度 </h3>' Accuracy = Accuracy + TempAccuracy |

剩下的就自己去拿THD2016的表格去算一下吧!

今天就先聊到这里了,拜拜!

参考文档

Calculate Accuracy for NI Digital Multimeters

What is the Temperature Coefficient specification and how is it applied?

Understanding specifications for precision multimeters Fluke

这篇关于测试测量-DMM直流精度的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![业务中14个需要进行A/B测试的时刻[信息图]](https://img-blog.csdnimg.cn/img_convert/aeacc959fb75322bef30fd1a9e2e80b0.jpeg)