本文主要是介绍ELK日志分析平台之helloworld,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

1.1 软件环境说明

本次安装部署所用的软件均为官网上目前的最新版本。

操作系统 | 软件 | Java环境 |

Centos 7 (服务器) | logstash-6.2.4 .tar.gz | openjdk 1.8.0_161 |

elasticsearch-6.2.4.tar.gz | ||

kibana-6.2.4-linux-x86_64.tar.gz | ||

redis-4.0.9.tar.gz | ||

Windows 7 | logstash-6.2.4.zip | jdk1.8.0_91 |

1.2 Hello word安装部署

1.2.1 Logstash安装

a. 解压zip包(logstash-6.2.4.zip);

b. 进入bin目录下,新定义一个配置文件:logstash-simple.conf(名称可自定义),这里采取最简单的标准输入输出;(注意,里面的elasticsearch输出配置可后续添加)

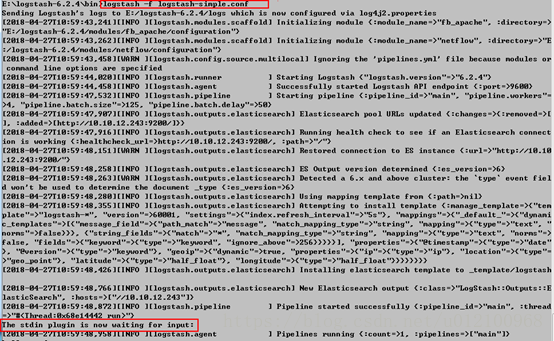

c. 进入windows的cmd窗口,使用命令进入配置文件所在的bin目录,启动logstash;(logstash –f logstash-simple.conf)

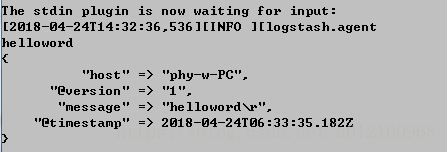

d. 输入一个简单的hello word,可以看到Logstash已经成功读取刚刚输入的字符串。

1.2.2 Elasticsearch安装

a. 解压tar包(tar -zxvf elasticsearch-6.2.4.tar.gz);

b. 修改elasticsearch.yml文件;

c. 启动elasticsearch;

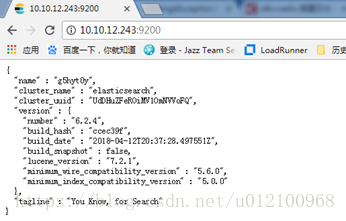

d. 访问elasticsearch,出现“you know,for search”则表明启动成功;

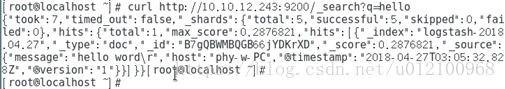

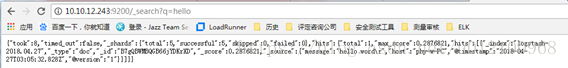

e. 试查询一下刚刚Logstash已经读取的的helloword,在elasticsearch窗口输入:curl http://10.10.12.243:9200/_search?q=hello,或者也可以使用浏览器进行搜索,网址栏内输入:http://10.10.12.243:9200/_search?q=hello进行查询,查看结果;

1.2.3 Kibanna安装

a. 解压tar包(tar –zxvf kibana-6.2.4-linux-x86_64.tar.gz);

b. 修改kibanna.yml文件;

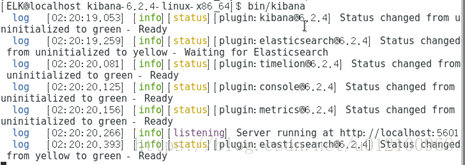

c. 启动kibanna;

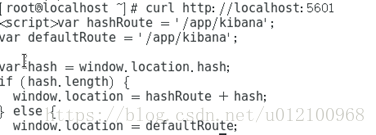

d. 访问kibanna;

e. 可以看到首页右上角的提醒,需要首先进行索引配置;

f. 在输入框内输入*,代表discover页面默认查询所有数据;然后选择每页显示的数据条数;点击下一步;

g. 选择@timestamp,代表discover页面会根据时间戳显示并统计你的数据;完成设置;

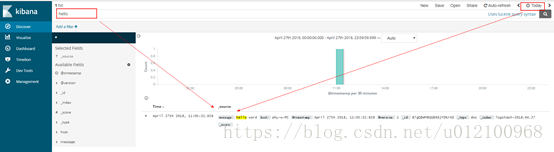

h. 再次进入discover页面,发现首页没有显示刚刚输入的helloword数据,是因为discover页面默认显示15分钟内的所有数据;

i. 在搜索栏中输入hello,页面选择合适的时间段,点击查询,查看结果。

1.2.4 加入Redis缓冲队列

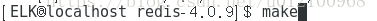

a. 解压tar包(tar –zxvf redis-4.0.9.tar.gz);

b. 进入redis文件夹,进行make编译;

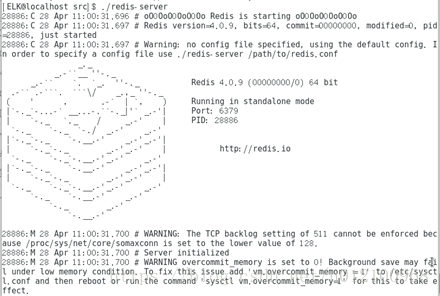

c. make完后,查看redis主目录下是否生成redis-server(服务端程序)和redis-cli(客户端程序)命令文件;若没有,查看是否生成bin目录,再去查看bin目录下的文件;若还是没有,则查看src目录;(官网上说的是会在redis主目录下,还有资料说是在bin目录下,实际上本次安装结果是存在于src目录下);

d. 进入src目录下,启动redis服务.

e. 访问redis(curlhttp://redis.io)或者启动redis-cli客户端,输入一个key-value值,查看是否启动成功;

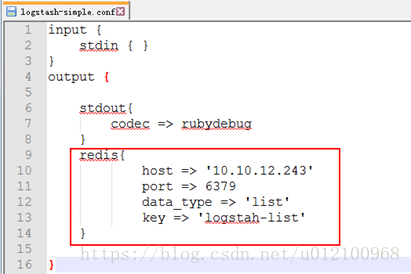

f. 更改客户端logstash的输出配置为redis;

g. 在服务端起一个logstash,并自定义配置文件(logstash-simple.conf)输入配置为redis,输出配置为elasticsearch;(注意:服务端和客户端中,redis的key值要保持一致)

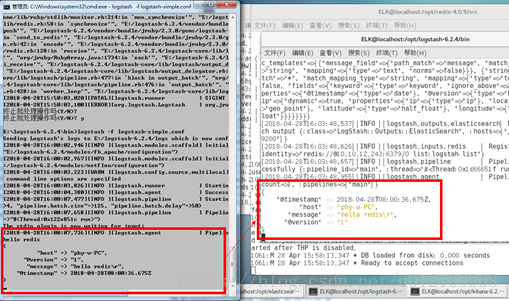

h. 重新启动各项软件,输入hello redis,分别查看客户端和服务端的Logstash显示;

i. 在kibana继续输入hello进行查询,查看结果;完成elk+redis系列的部署。

这篇关于ELK日志分析平台之helloworld的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!