本文主要是介绍【ClickHouse】副本、分片集群 (六),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

副本

副本的目的主要是保障数据的高可用性,即使一台ClickHouse节点宕机,那么也可以从其他服务器获得相同的数据。

https://clickhouse.tech/docs/en/engines/table-engines/mergetree-family/replication/

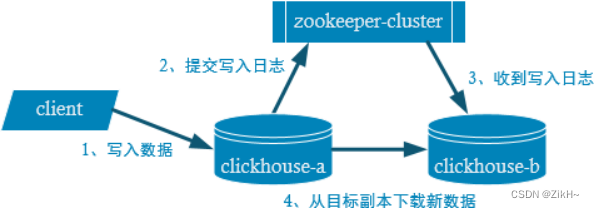

副本写入流程

写入流程如图-18所示:

图-18 写入流程

配置步骤

1)启动zookeeper集群。

2)在hadoop101的/etc/clickhouse-server/config.d目录下创建一个名为metrika.xml的配置文件,内容如下:

注:也可以不创建外部文件,直接在config.xml中指定。

<?xml version="1.0"?>

<yandex>

<zookeeper-servers>

<node index="1">

<host>hadoop101</host>

<port>2181</port>

</node>

<node index="2">

<host>hadoop102</host>

<port>2181</port>

</node>

<node index="3">

<host>hadoop103</host>

<port>2181</port>

</node>

</zookeeper-servers>

</yandex>

3)同步到hadoop102和hadoop103上。

xsync /etc/clickhouse-server/config.d/metrika.xml

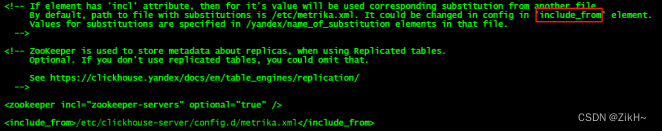

4)在hadoop101的/etc/clickhouse-server/config.xml中增加。

<zookeeper incl="zookeeper-servers" optional="true" />

<include_from>/etc/clickhouse-server/config.d/metrika.xml</include_from>

图-19 配置文件

5)同步到hadoop102和hadoop103上。

xsync /etc/clickhouse-server/config.xml

6)分别在hadoop102和hadoop103上启动ClickHouse服务。

clickhouse restart

注意:因为修改了配置文件,如果以前启动了服务需要重启。

注意:我们演示副本操作只需要在hadoop101和hadoop102两台服务器即可,上面的操作,我们hadoop103可以你不用同步,我们这里为了保证集群中资源的一致性,做了同步。

7)在hadoop101和hadoop102上分别建表。

副本只能同步数据,不能同步表结构,所以我们需要在每台机器上自己手动建表。

hadoop101:

create table t_order_re ( id UInt32,

sku_id String,

total_amount Decimal(16,2),

create_time Datetime

) engine =ReplicatedMergeTree('/clickhouse/table/01/t_order','rep_001') partition by toYYYYMMDD(create_time)

primary key (id) order by (id,sku_id);

hadoop102:

create table t_order_re ( id UInt32,

sku_id String,

total_amount Decimal(16,2),

create_time Datetime

) engine =ReplicatedMergeTree('/clickhouse/table/01/t_order','rep_002') partition by toYYYYMMDD(create_time)

primary key (id) order by (id,sku_id);

参数解释

ReplicatedMergeTree中,第一个参数是分片的zk_path一般按照:/clickhouse/table/{shard}/{table_name}的格式写,如果只有一个分片就写 01 即可。

第二个参数是副本名称,相同的分片副本名称不能相同。

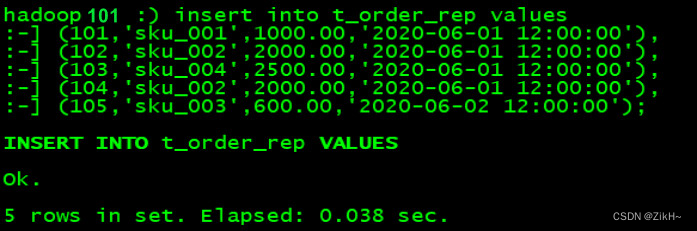

在hadoop101上执行insert语句,结果如图-20所示:

insert into t_order_re values (101,'sku_001',1000.00,'2020-06-01 12:00:00'),

(102,'sku_002',2000.00,'2020-06-01 12:00:00'),

(103,'sku_004',2500.00,'2020-06-01 12:00:00'),

(104,'sku_002',2000.00,'2020-06-01 12:00:00'),

(105,'sku_003',600.00,'2020-06-02 12:00:00');

图-20 插入数据

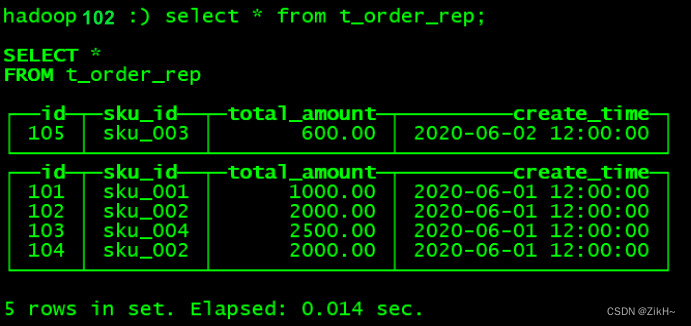

在hadoop102上执行select,可以查询出结果,如图-21所示,说明副本配置正确。

图-21 执行结果

分片集群

副本虽然能够提高数据的可用性,降低丢失风险,但是每台服务器实际上必须容纳全量数据,对数据的横向扩容没有解决。

要解决数据水平切分的问题,需要引入分片的概念。通过分片把一份完整的数据进行切分,不同的分片分布到不同的节点上,再通过Distributed表引擎把数据拼接起来一同使用。

Distributed表引擎本身不存储数据,有点类似于 MyCat 之于 MySql,成为一种中间件, 通过分布式逻辑表来写入、分发、路由来操作多台节点不同分片的分布式数据。

注意:ClickHouse的集群是表级别的,实际企业中,大部分做了高可用,但是没有用分片,避免降低查询性能以及操作集群的复杂性。

集群写入流程(3 分片 2 副本共 6 个节点)

写入流程如图-22所示:

图-22 写入流程

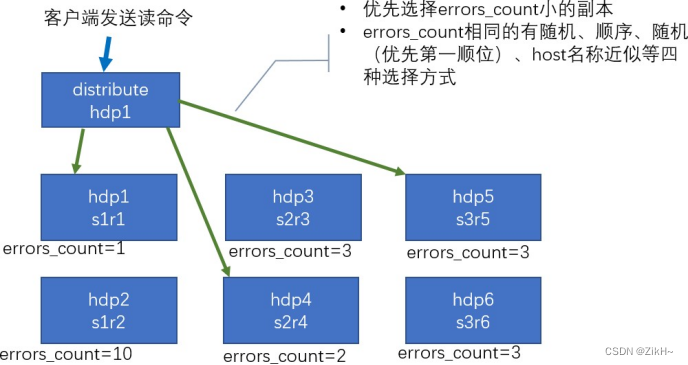

集群读取流程(3 分片 2 副本共 6 个节点)

读取流程如图-23所示:

图-23 读取流程

集群搭建

配置的位置可以在之前的/etc/clickhouse-server/config.d/metrika.xml,内容如下。

注:也可以不创建外部文件,直接在config.xml的<remote_servers>中指定。

hadoop101配置如下:

<yandex>...省略...<listen_host>::</listen_host><remote_servers><perftest_3shards_1replicas><shard><replica><host>hadoop101</host><port>9000</port></replica></shard><shard><replica><host>hadoop102</host><port>9000</port></replica></shard><shard><replica><host>hadoop103</host><port>9000</port></replica></shard></perftest_3shards_1replicas></remote_servers><!-- zookeeper相关配置 --><zookeeper-servers><node><host>hadoop101</host><port>2181</port></node><node><host>hadoop102</host><port>2181</port></node><node><host>hadoop103</host><port>2181</port></node></zookeeper-servers><!-- 复制标识的配置,也称为宏配置,这里唯一标识一个副本名称,每个实例都要配置并且都是唯一的 --><macros><shard>01</shard><replica>01</replica></macros> ...省略...

</yandex>

hadoop102配置如下:

<yandex>...省略...<listen_host>::</listen_host><remote_servers><perftest_3shards_1replicas><shard><replica><host>hadoop101</host><port>9000</port></replica></shard><shard><replica><host>hadoop102</host><port>9000</port></replica></shard><shard><replica><host>hadoop103</host><port>9000</port></replica></shard></perftest_3shards_1replicas></remote_servers><!-- zookeeper相关配置 --><zookeeper-servers><node><host>hadoop101</host><port>2181</port></node><node><host>hadoop102</host><port>2181</port></node><node><host>hadoop103</host><port>2181</port></node></zookeeper-servers><!-- 复制标识的配置,也称为宏配置,这里唯一标识一个副本名称,每个实例都要配置并且都是唯一的 --><macros><shard>02</shard><replica>01</replica></macros> ...省略...

</yandex>

hadoop103配置如下:

<remote_servers><perftest_3shards_1replicas><shard><replica><host>hadoop101</host><port>9000</port></replica></shard><shard><replica><host>hadoop102</host><port>9000</port></replica></shard><shard><replica><host>hadoop103</host><port>9000</port></replica></shard></perftest_3shards_1replicas></remote_servers><!-- zookeeper相关配置 -->

<zookeeper-servers><node><host>hadoop101</host><port>2181</port></node><node><host>hadoop102</host><port>2181</port></node><node><host>hadoop103</host><port>2181</port></node></zookeeper-servers><!-- 复制标识的配置,也称为宏配置,这里唯一标识一个副本名称,每个实例都要配置并且都是唯一的 --><macros><shard>03</shard><replica>01</replica></macros>

这篇关于【ClickHouse】副本、分片集群 (六)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!