本文主要是介绍如何定位报错: indexSelectLargeIndex:... Assertion `srcIndex < srcSelectDimSize` fail,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- 1. 背景

- 2. 准备工作

- 2.1 debug工具

- 2.2 设置准备工作

- 3. 开启 debug

1. 背景

在使用 cuda 在 gpu 计算的过程中,出现索引超过最大长度。

indexSelectLargeIndex:... Assertion `srcIndex < srcSelectDimSize` fail

通常这种时候堆栈底部还伴随以下报错:

RuntimeError: CUDA error: device-side assert triggered

如果你明确你的输入是什么,那么这种问题不难排查。

困难的是,如果你调用了一些封装很深的库,例如模型训练库,比如 transformer 。特别是你还是用多 gpu 跑这种代码,那么这种问题排查起来尤其困难。

ps:

对于这种隐藏太深的问题,在网上(包含外网)几乎搜索不到太多的解决方法。

2. 准备工作

目前遇到这种问题,最好的解决方法只有对代码 debug。千万别害怕 debug,这是当你遇到疑难杂症时,理解代码、解决问题的最佳方法!

2.1 debug工具

当然 debug 也有方法的,掌握合适的工具事半功倍:

(1)本地代码可以用 IDE 编码的,那么直接用 IDE 的 debug 方便

(2)远程部署在服务器上的,如果本地可以通过内网 ssh 连接服务器,建议部署用 VSCode,远程连接进行 debug

(3)远程部署在服务器上的,本地没有任何办法连接服务器的,那么可以借助 python 的 pdb 库。详细用法请参考《Python内置debug库: pdb用法详解》

(4)当然,肯定有其他方法,更多的方法我就没用过了~

2.2 设置准备工作

为了可以高效的 debug,需要简单配置以下设置:

(1)将 gpu 运算替换成 cpu 运算

(2)将多线程改成单线程

(3)如果是深度学习模型训练,请调低模型参数、减少训练的数据量

下面依次解释以上操作:

(1)将 gpu 运算替换成 cpu 运算;

model.to(torch.device("cpu"))- 如果你使用

transformer库,在TrainingArguments中use_cpu = True

(2)将多线程改成单线程;例如此前你使用多机多卡训练,请调整成一张卡

(3)调低模型参数、减少训练的数据量;

- 现在的大模型的参数量巨大,可能导入会爆内存,请调低模型的参数,例如 attention 的head数、网络隐藏层数、embedding维度、max_seq_length 等

- 另外,为了提高效率,训练 load 的数据可以少一些,加速 debug 效率

3. 开启 debug

由于我们并不知道是哪里的问题引起的索引超过最大长度,因此我们需要从头开始 debug,那么是不是一步一步来 debug 呢?

这里有一个加速的方法,我们采用二分法。

(1)在大致代码1/2的位置打上断点,然后放行代码,看代码是否可以运行到这个断点。

(2)如果可以,那么在后半部分的1/2再打断点,再运行;

(3)否则在前半部分的1/2再打断点。

(4)直到可以定位到是哪一行函数报错,再追踪进去重复上面的步骤

举个例子:

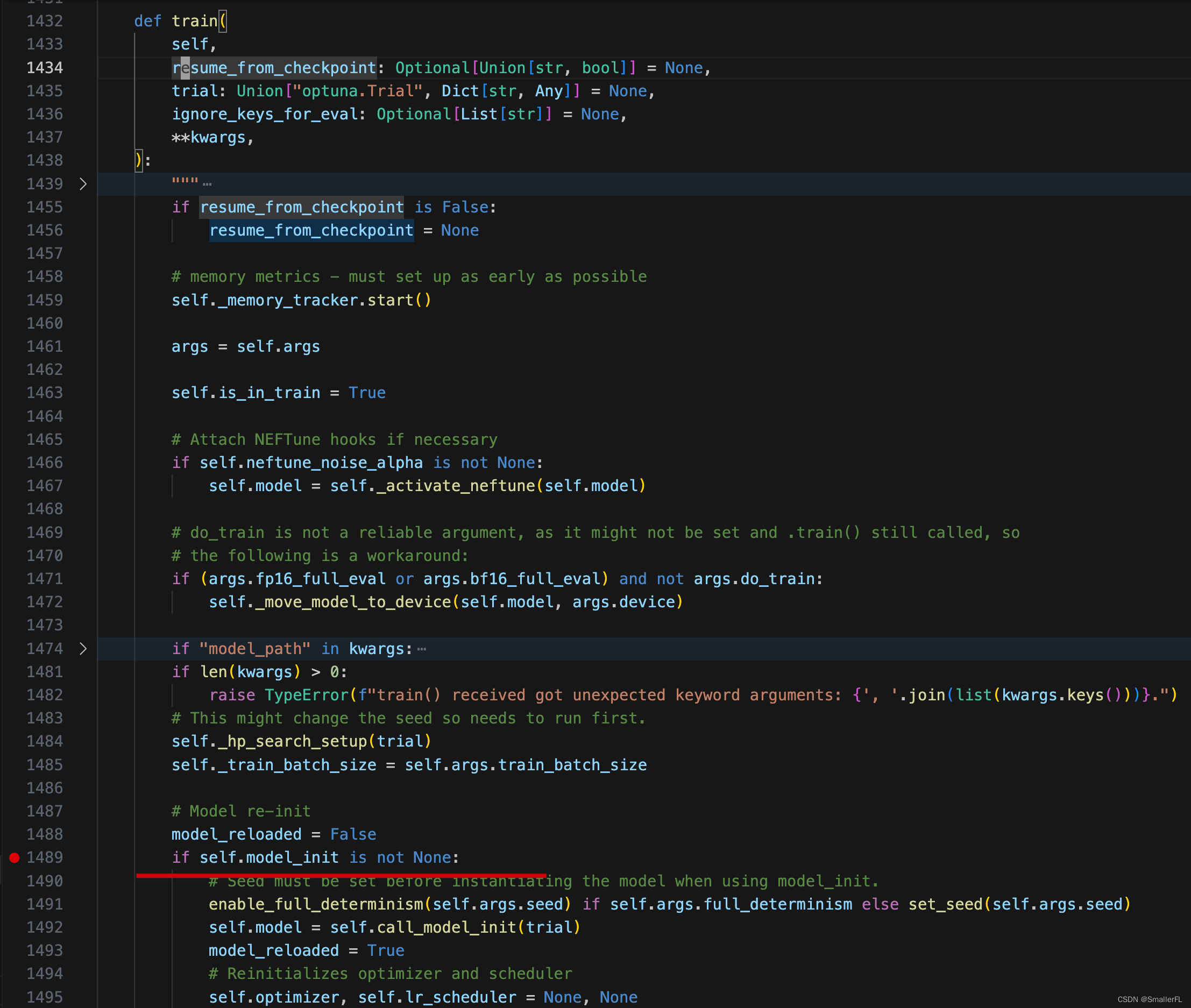

这是transformer的内置的train 的内部代码,明确是这里出现了问题,现在就需要找到是哪一行有问题。我们可以找一个大致的位置打上断点,然后放行 debug 代码

找到报错的一行代码以后,再具体根据里面的变量之间的关系具体分析。

欢迎关注本人,我是喜欢搞事的程序猿; 一起进步,一起学习;

欢迎关注知乎/CSDN:SmallerFL

也欢迎关注我的wx公众号(精选高质量文章):一个比特定乾坤

这篇关于如何定位报错: indexSelectLargeIndex:... Assertion `srcIndex < srcSelectDimSize` fail的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!