本文主要是介绍Selective Kernel Networks(CVPR-2019),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

摘要

提出了一种动态选择机制,允许每个神经元根据输入信息的多个尺度自适应调整感受野大小。设计了一种称为选择核(SK)单元的结构块,利用softmax attention 对不同核大小的多个分支进行融合。对这些分支的不同attention产生融合层神经元有效感受野的不同大小。多个SK单元被堆叠成一个称为选择性核的网络SKNets。

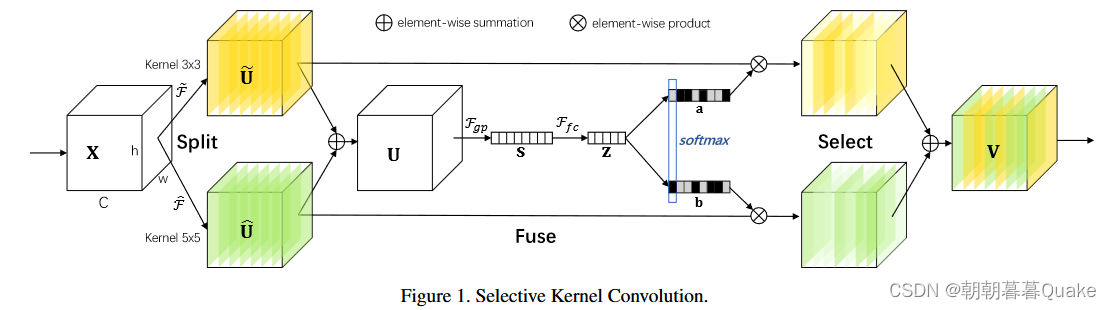

文章提出了一种非线性方法,从多个内核中聚合信息,实现神经元的自适应RF大小。我们引入了 “选择性内核”(SK)卷积,它由三组运算符组成:Split, Fuse and Select。分裂运算符产生具有不同内核大小的多个路径,对应于神经元的不同RF大小。融合运算符结合并汇总来自多条路径的信息,以获得选择权重的全局和综合表示。选择运算符根据选择权重聚合不同大小的内核的特征图。

为了验证所提出的模型是否具有调节神经元感受野大小的能力,我们通过在自然图像中放大目标对象并缩小背景以保持图像大小不变来模拟刺激。研究发现,当目标对象越来越大时,大多数神经元越来越多地从较大的kernel apth中收集信息。这些结果表明,所提出的SKNet中的神经元具有自适应的RF大小,这可能是该模型在目标识别方面的优越性能的基础。

首先split:

对给定特征图x,用卷积核大小为3和5的卷积执行两个转换。

注意F都是有深度卷积、批处理规范化和relu函数按顺序组成的。为了进一步提高效率,将传统的55核卷积替换为33核卷积,dilation大小为2.

Fuse操作:

将分支中的信息通过元素求和进行融合:

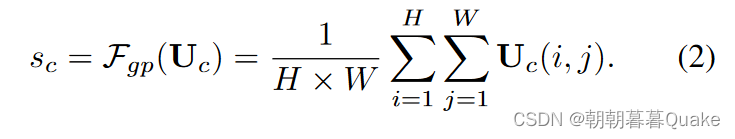

然后通过全局平均池化来嵌入全局信息,从而生成channel-wise的信道统计信息:

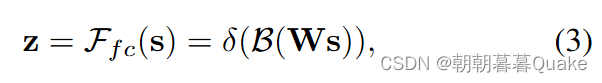

接着建立一个紧凑的特征,使之能够进行精确的自适应选择,这通过简单的全连接层实现:

其中δ是ReLU函数[ 29 ],B是批归一化[ 15 ],

。为了研究d对模型效率的影响,我们使用一个折减比率r来控制它的值:

式中:L为d ( L = 32是我们实验中的典型设置)的最小值。

select操作

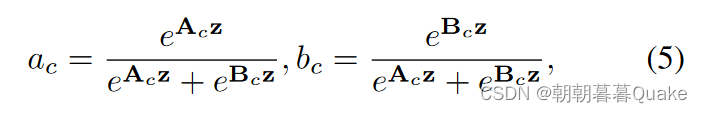

跨通道的软注意力用于自适应地选择不同空间尺度的信息,由紧凑的特征描述子z引导。具体地,在通道数字上应用softmax算子:

其中A,B分和a,b分别代表 的软注意力向量。

的软注意力向量。 ,是A的第c行,

,是A的第c行, 是a的第c个元素。在两个分支中,B是冗余的因为

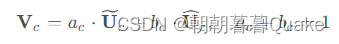

是a的第c个元素。在两个分支中,B是冗余的因为 ,特征图V由以下在各个核上的注意力权重得到。

,特征图V由以下在各个核上的注意力权重得到。

这篇关于Selective Kernel Networks(CVPR-2019)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![BUUCTF靶场[web][极客大挑战 2019]Http、[HCTF 2018]admin](https://i-blog.csdnimg.cn/direct/ed45c0efd0ac40c68b2c1bc7b6d90ebc.png)

![[Linux Kernel Block Layer第一篇] block layer架构设计](https://i-blog.csdnimg.cn/direct/6f402f42143b4aac927657769404055e.png)