本文主要是介绍【深度学习】数竹签演示软件系统,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

往期文章列表:

【YOLO深度学习系列】图像分类、物体检测、实例分割、物体追踪、姿态估计、定向边框检测演示系统【含源码】

【深度学习】物体检测/实例分割/物体追踪/姿态估计/定向边框/图像分类检测演示系统【含源码】

【深度学习】YOLOV8数据标注及模型训练方法整体流程介绍及演示

【深度学习】行人跌倒行为检测软件系统

【深度学习】火灾检测软件系统

【深度学习】吸烟行为检测软件系统

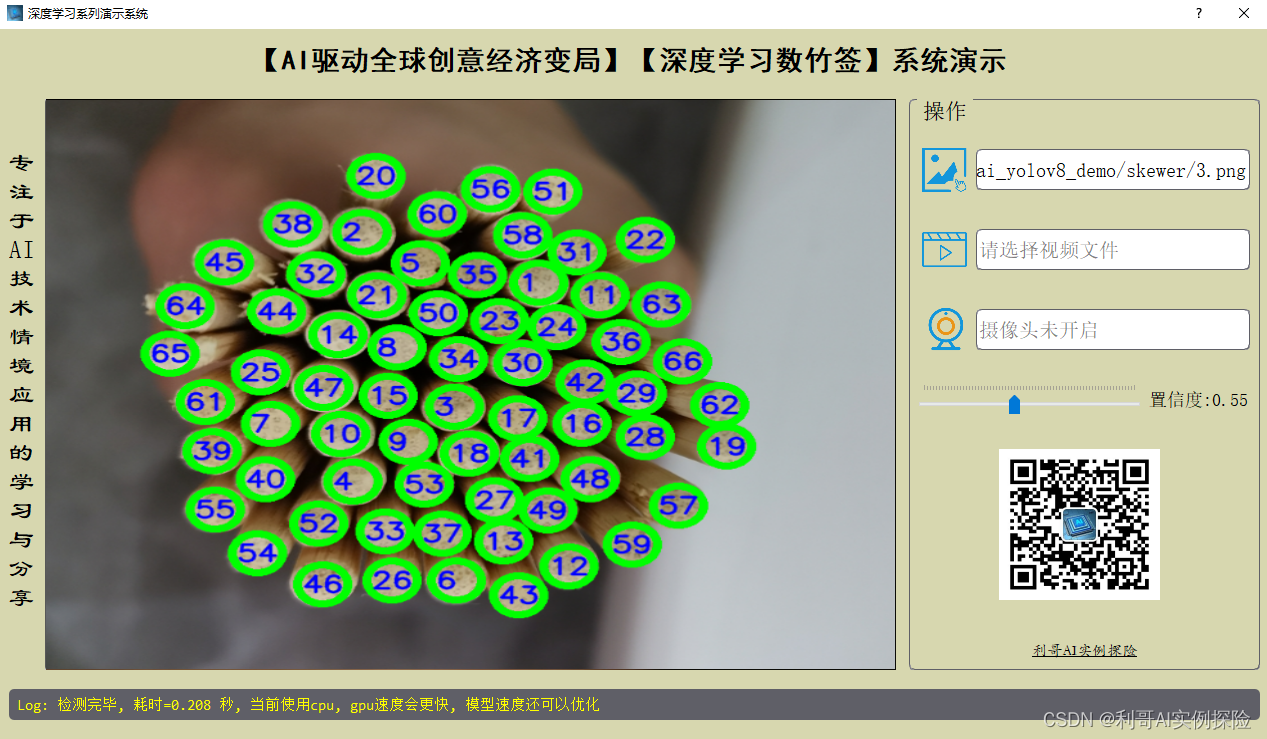

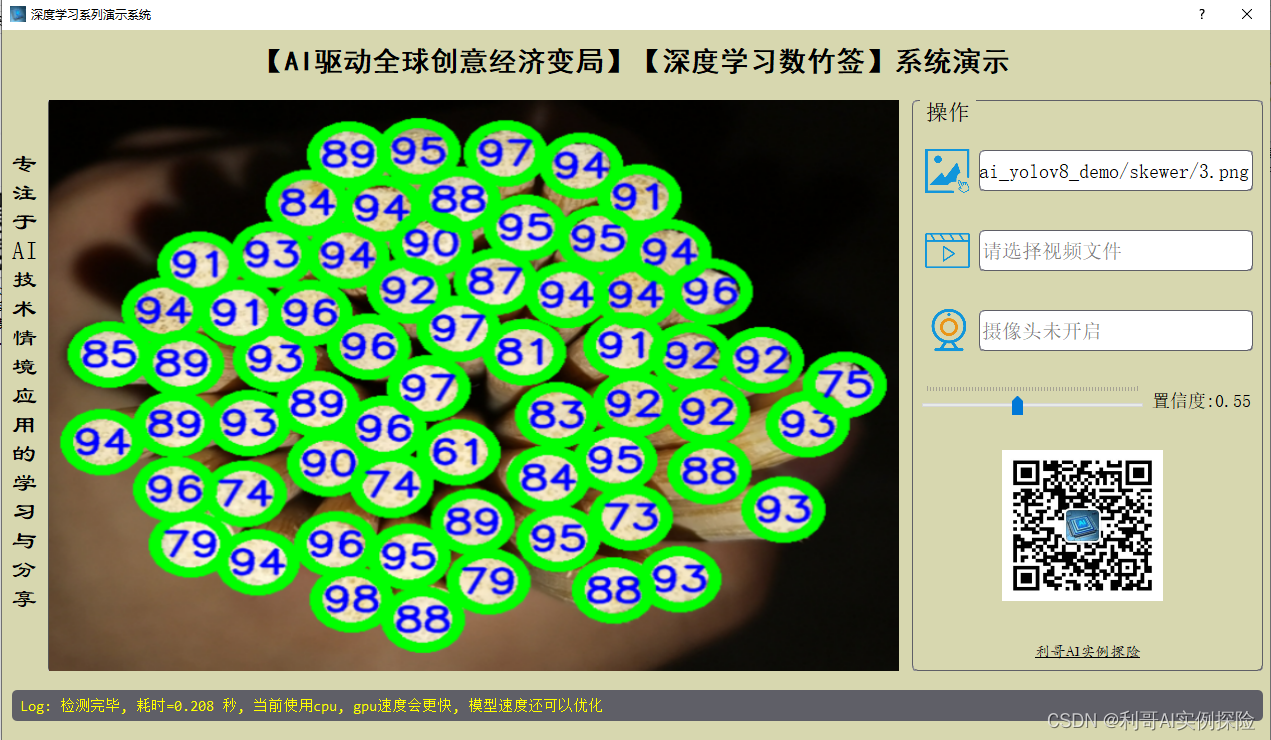

软件功能演示

摘要:本文主要使用YOLOV8深度学习框架自训练了一个“数竹签检测模型”,基于此模型使用PYQT5实现了一款界面软件用于功能演示。让您可以更好的了解和学习,该软件支持图片、视频以及摄像头进行目标检测,使用目标检测的方式可以对竹签/筷子/钢管等目标进行监测和计数,应用场景还是比较丰富的。本系统所涉及的训练数据及软件源码已打包上传。

文中源码文件【获取方式】:关注公众号:利哥AI实例探险, 给公众号发送 “数竹签” 获取下载方式 给公众号发送 “数竹签数据集”

获取数据集下载方式,由于本人能力有限,难免有疏漏之处。

数竹签

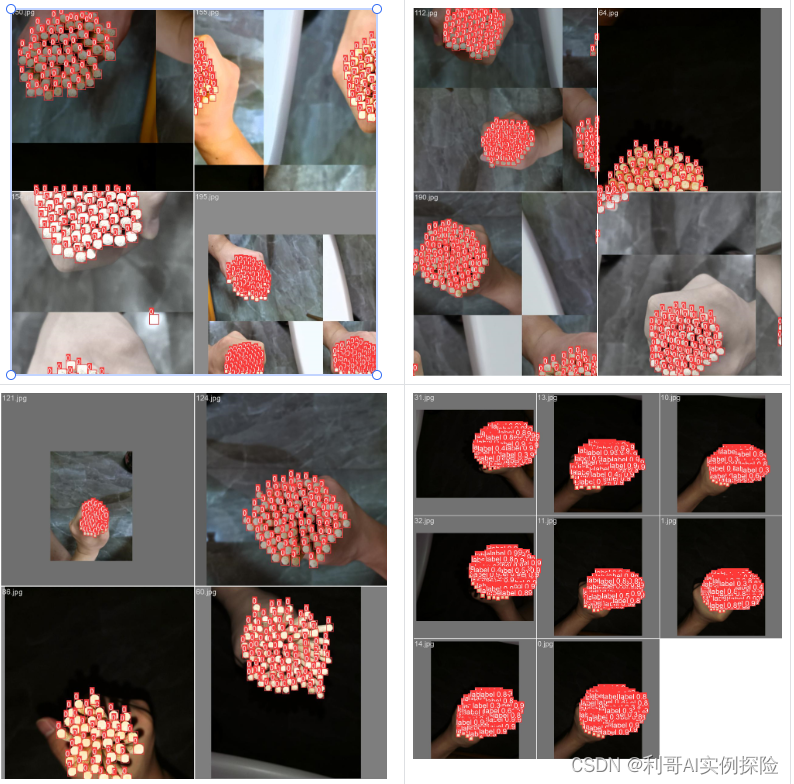

图片检测演示

点击图片图标,选择需要检测的图片,即可得到检测结果。

视频检测演示

点击视频图标,选择需要检测的视频,即可得到检测结果。

摄像头功能

系统还提供了摄像头实时监测功能,可自行尝试

模型训练

整体可参考:【深度学习】YOLOV8数据标注及模型训练方法整体流程介绍及演示

以下是简单说明:

关于YOLOV8的数据标注及模型训练更详细的内容,可关注我的另一篇专门记录这部分的文章。

数据集准备及标注

目标检测的数据标注,可以用LabelImg,建议直接下载其可执行程序,而不是通过pip安装使用。

准备了 “数竹签数据集”,用作训练演示。把准备的数据集分为训练和验证两个数据集,一共包含 210 张图片,部分图片如下所示,这些数据集来源于网上:

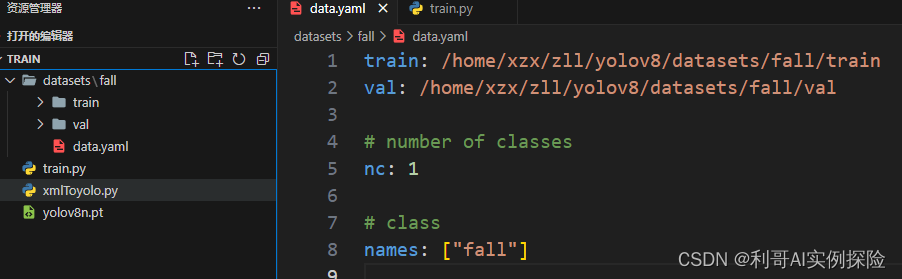

模型训练

可参考:【深度学习】YOLOV8数据标注及模型训练方法整体流程介绍及演示

- 新建一个data.yaml文件,用于存储训练数据的路径及模型需要进行检测的类别,yolov8在进行模型训练时,会读取该文件的信息,用于进行模型的训练与验证,data.yaml的具体内容如下,路径和names改成具体的即可:

注:train与val后面表示需要训练图片的路径,建议直接填写绝对路径

2. 数据准备完成后,通过调用train.py文件进行训练,epochs参数用于调整训练的轮数,batch参数用于调整训练的批次大小(根据内存大小调整即可,最小为1),代码如下所示:

![[图片]](https://img-blog.csdnimg.cn/direct/c8b59cf2dd7b4292bd19dae8e591089e.png)

- 用到基础模型yolov8n.pt,所涉及的文件已打包上传,可关注【深度学习】YOLOV8数据标注及模型训练方法整体流程介绍及演示进行获取,运行 python train.py进行训练,如果想后台运行,可以使用 nohup python train.py & 命令,训练过程如下所示:

![[图片]](https://img-blog.csdnimg.cn/direct/076947db71134365bfab60072f1431c6.png)

训练结果保存在 /runs/train 系列文件夹中,训练完的最终文件目录结构如下:

![[图片]](https://img-blog.csdnimg.cn/direct/ec2b60fe0a4349cfaa8c3b10bc0e8b55.png)

训练结果评估

关于该系统涉及到的完整源码、UI界面代码、数据集、训练代码、测试图片视频等相关文件,均已打包上传,感兴趣的小伙伴可以通过下载链接自行获取,下载方式放在文章开头部分。

通常用损失函数下降的曲线来观察模型训练的情况,yolov8训练时主要包含三个方面的损失:定位损失、分类损失和动态特征损失,训练结束后,在runs/目录下找到训练过程及结果文件:

![[图片]](https://img-blog.csdnimg.cn/direct/bea4c87a9a5f4e09ad09b21fca7b120e.png)

- 定位损失box_loss:预测框与标定框之间的误差GloU,越小定位越准确

- 分类损失cls_loss:计算锚框与对应标定分类是否正确,越小分类越准确

- 动态特征损失dfl_loss:一种用于回归预测框与目标框之间距离的损失函数,通过计算动态特征损失,可以更准确地调整预测框的位置,提高目标检测的准确性。

本文训练结果如下:

![[图片]](https://img-blog.csdnimg.cn/direct/8b1e63d46a5c48c4b978c619342c461c.png)

PR曲线体现精确率和召回率的关系,mAP表示Precision和Recall作为两轴作图后围成的面积,m表示平均,@后面的数表示iou为正负样本的阈值,mAP@0.5表示阈值大于0.5的平均mAP,可以看到本文模型目标检测的mAP@0.5。

![[图片]](https://img-blog.csdnimg.cn/direct/e1f0995190db4ee8817fb57bb7233c46.png)

检测结果识别

模型训练完成后,可以得到一个最佳的训练结果模型best.pt文件,在runs/train/weights/bset.pt,可以使用该文件进行推理检测。

原文地址:【深度学习】数竹签演示软件系统

这篇关于【深度学习】数竹签演示软件系统的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!