本文主要是介绍解锁ChatGPT:从GPT-2实践入手解密ChatGPT,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

⭐️我叫忆_恒心,一名喜欢书写博客的研究生👨🎓。

如果觉得本文能帮到您,麻烦点个赞👍呗!

近期会不断在专栏里进行更新讲解博客~~~

有什么问题的小伙伴 欢迎留言提问欧,喜欢的小伙伴给个三连支持一下呗。👍⭐️❤️

📂Qt5.9专栏定期更新Qt的一些项目Demo

📂项目与比赛专栏定期更新比赛的一些心得,面试项目常被问到的知识点。

一、ChatGPT架构概览

随着自然语言处理(NLP)的快速进展,由OpenAI推出的ChatGPT引领了对话型AI的新趋势。基于GPT架构,这一AI不仅改变了公众与AI的互动模式,还引起了广泛的技术内核探讨。本部分将详细分析ChatGPT的原理,从模型结构、训练方式到应用实践等方面进行阐述。

GPT模型概述

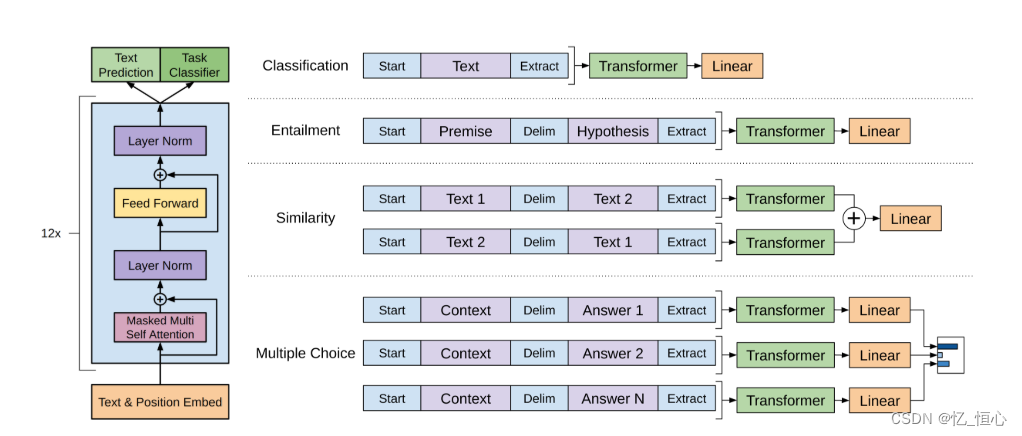

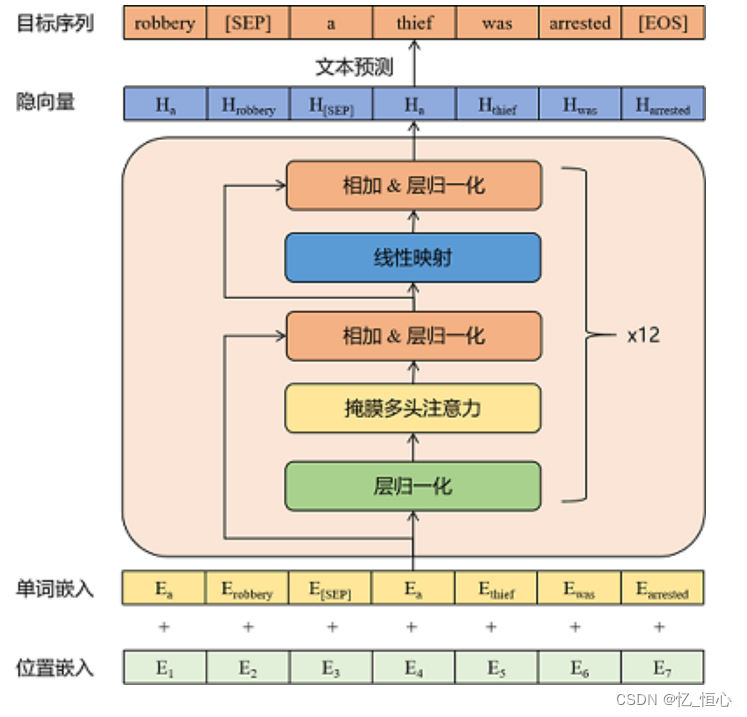

GPT基于Transformer架构,初期在大量文本数据上进行预训练,掌握语言模式后在特定任务上细化调优。其预训练是一种无监督学习,旨在通过预测被遮蔽的文本来理解语言结构。

ChatGPT的原理持续迭代,现行的GPT-4和原始模型都基于OpenAI团队的《Generative Pre-Training》论文。

简单地来说,堆叠多个Transformer模型,不断微调,因此在早几年的,自然语言处理时,GPT论文的复现难度比较大,且成本非常高。

说到这就不得不提一下Transformer架构。

Transformer架构

这个思路来源于《attention is all you need》,这论文现在的饮用量已经高达了12W了,非常推荐大家去读一下原文。

Transformer模型是由多个编码器(Encoder)和解码器(Decoder)层堆叠而成,是目前自然语言处理技术的核心。其核心技术是自注意力机制(Self-Attention Mechanism),允许模型在处理输入的每个单词时,考虑到句子中的其他单词,从而更好地理解语境。

简单来说,这篇论文主要介绍下面的内容:

“Attention Is All You Need”,作者是 Ashish Vaswani 等人。该论文提出了一种新的简单网络架构——Transformer,它完全基于注意力机制,摒弃了递归和卷积。在两个机器翻译任务上的实验表明,这些模型在质量上更优越,同时更具并行性,训练所需的时间也显著减少。

二、模型训练与微调

ChatGPT目前并没有进行开源,但是如果从深度解析原来来看,我们完全可以通过GPT2.0 来完成学习。

GPT-2的预训练阶段,模型使用一个非常大的数据集进行训练,这些数据集包括从网上收集的8百万个网页的文本。预训练的目标是让模型学会语言的统计规律,通过预测给定文本片段中的下一个单词来进行。

GPT2

2.1 预训练过程:

- 数据收集: 搜集各类文本数据如书籍、网页、新闻。

- 训练目标: 预测文本中的下一个词汇。

2.2 微调过程:

- 特定数据: 使用对话型数据集进行优化,提升模型的对话能力。

- 调整目标: 提高生成对话的连贯性和相关性。

要撰写一个关于OpenAI GPT-2模型的技术博客,你可以从以下几个方面入手:

-

模型概述:介绍GPT-2的基本架构和其在自然语言处理中的应用,强调其使用变换器(Transformer)模型的重要性。

-

模型版本和参数:解释不同的模型版本(如124M、355M、774M和1.5B),每个版本的参数和层数的差异。

-

关键代码讲解:

- 模型下载代码:讲解如何使用

download_model.py脚本下载不同大小的模型文件。import os os.system("python download_model.py 124M") # 下载124M模型 - 生成文本示例代码:展示如何使用

generate_unconditional_samples.py生成文本。os.system("python src/generate_unconditional_samples.py --model_name='124M' --nsamples=1 --length=100")

- 模型下载代码:讲解如何使用

-

实际应用案例:描述如何将GPT-2应用于聊天机器人、内容生成等场景。

2.3 代码示例(伪代码):

import torch

from transformers import GPT2Tokenizer, GPT2LMHeadModel, AdamW# 加载预训练模型和分词器

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

model = GPT2LMHeadModel.from_pretrained('gpt2')

optimizer = AdamW(model.parameters(), lr=5e-5)# 示例文本输入

input_ids = tokenizer.encode("Sample text input:", return_tensors='pt')# 微调模型

for _ in range(100):outputs = model(input_ids, labels=input_ids)loss = outputs.lossloss.backward()optimizer.step()optimizer.zero_grad()三、实际应用与性能优化

在实际应用中,ChatGPT可服务于多种业务场景,如自动客服、内容推荐、自动编程辅助等。针对具体任务,可能需要通过模型剪枝来降低模型大小,或使用量化技术减少计算资源的消耗,从而提高响应速度和处理效率。这些技术帮助部署在资源受限的环境中,同时保持良好的性能。

项目 GPT2-chitchat 是由Yang Jianxin开发的一个开源代码库,用于构建基于GPT-2模型的中文闲聊机器人。该项目在GitHub上托管,并且是基于Hugging Face的Transformers库实现的。它利用了DialoGPT的多轮对话生成思想(MMI),以提升对话的自然性和连贯性【10†source】。

1 主要特点和结构

- 代码结构:包括数据预处理(

preprocess.py),模型训练(train.py),以及用户交互(interact.py)三个主要脚本。模型的训练数据和生成的字典也包含在项目文件夹中。 - 模型训练与微调:使用

train.py脚本进行模型训练,支持早停(early stopping)来防止过拟合。模型训练过程中,将多轮对话数据进行拼接后输入模型进行自回归训练。 - 人机交互:通过

interact.py脚本实现,允许用户与训练好的模型进行实时对话。该脚本支持调整多个生成参数,如topk、topp等,以优化对话生成的质量。

2 环境依赖

项目运行需要Python 3.6环境,并且依赖于特定版本的transformers和pytorch库(transformers4.2.0, pytorch1.7.0)。

3 应用示例

在模型训练好后,可以使用interact.py脚本与模型进行交互,生成的对话实例体现了模型的响应能力和对话质量。

4 数据预处理

使用preprocess.py对原始文本数据进行处理,包括分词和序列化,以便训练使用。预处理后的数据保存在train.pkl文件中,格式为多轮对话的列表。

该项目还包括丰富的闲聊语料资源链接,供进一步训练和测试使用。

5 模型分享

作者还提供了预训练模型的下载链接,方便用户直接下载使用,而无需从头开始训练。

整体而言,GPT2-chitchat 提供了一个完整的框架和丰富的工具,使研究人员和开发者能够在中文NLP领域,特别是在自动对话生成方面,进行实验和应用开发。更多详情可以参考其GitHub仓库。

四、总结

通过深入探索ChatGPT的架构、训练过程和应用场景,我们可以更好地理解并利用这项技术。希望本文能为读者提供有价值的见解和帮助。

往期优秀文章推荐:

- 研究生入门工具——让你事半功倍的SCI、EI论文写作神器

- 磕磕绊绊的双非硕秋招之路小结

- 研一学习笔记-小白NLP入门学习笔记

- C++ LinuxWebServer 2万7千字的面经长文(上)

- C++Qt5.9学习笔记-事件1.5W字总结

资料、源码获取以及更多粉丝福利

这篇关于解锁ChatGPT:从GPT-2实践入手解密ChatGPT的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!