本文主要是介绍聊一聊大数据需求的流程,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

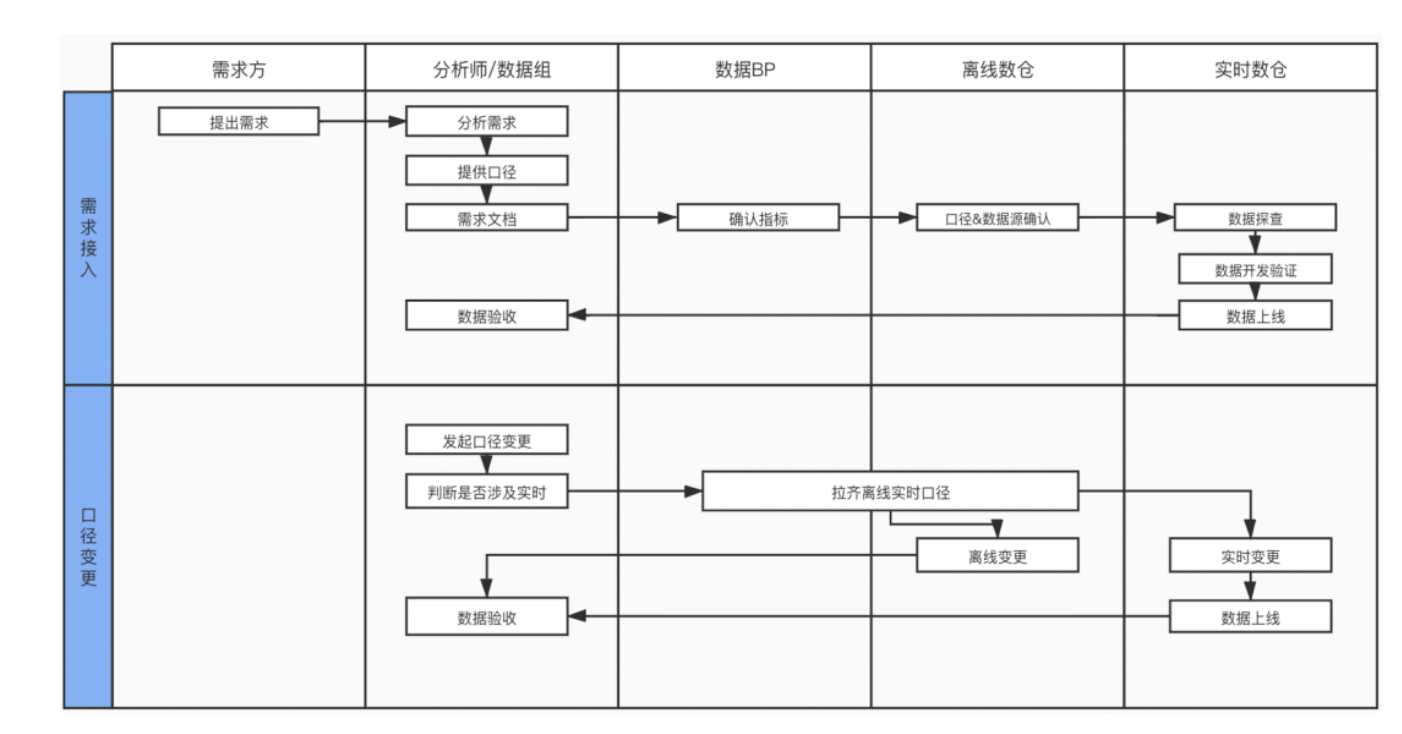

大致的流程:需求对接、口径梳理、数据开发、任务发布、任务监控、任务保障

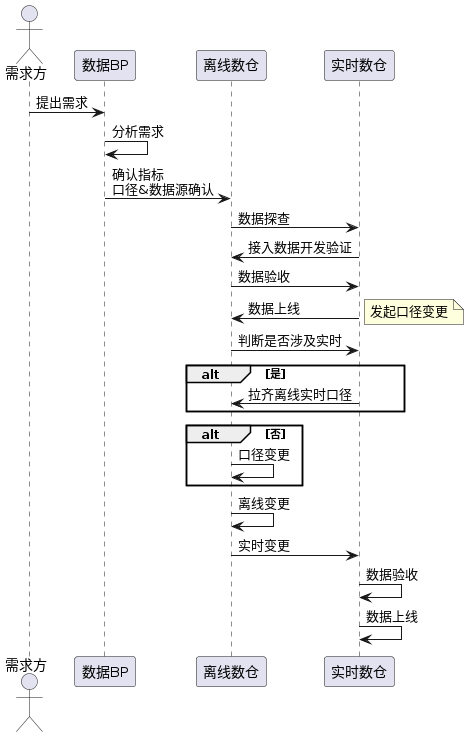

流程图

@startuml

skinparam packageStyle rectangleactor 需求方

participant 数据BP as 数据组

participant 离线数仓

participant 实时数仓需求方 -> 数据组: 提出需求

数据组 -> 数据组: 分析需求

数据组 -> 离线数仓: 确认指标\n口径&数据源确认

离线数仓 -> 实时数仓: 数据探查

实时数仓 -> 离线数仓: 接入数据开发验证

离线数仓 -> 实时数仓: 数据验收

实时数仓 -> 离线数仓: 数据上线note right: 发起口径变更

离线数仓 -> 实时数仓: 判断是否涉及实时

alt 是

实时数仓 -> 离线数仓: 拉齐离线实时口径

end

alt 否

离线数仓 -> 离线数仓: 口径变更

end离线数仓 -> 离线数仓: 离线变更

离线数仓 -> 实时数仓: 实时变更

实时数仓 -> 实时数仓: 数据验收

实时数仓 -> 实时数仓: 数据上线

@enduml

渲染过之后,长这样子了

大数据开发是一个复杂而系统性的过程,涉及多个环节和角色。以下是各个环节的详细介绍:

1. 需求对接

需求对接是大数据开发的起点,主要包括以下几个步骤:

- 需求收集:与业务部门或客户沟通,明确他们的数据需求。例如,需要哪些数据、数据的来源、数据处理后的输出形式、数据的更新频率等。

- 需求分析:分析需求的可行性,评估技术实现的难度,估算所需的时间和资源。

- 需求确认:与业务部门或客户确认需求细节,确保双方对需求有一致的理解。

示例1:零售行业的需求对接

- 需求收集:

- 业务背景:某零售连锁店希望分析会员消费数据,以便进行精准营销。

- 沟通内容:

- 数据需求:会员的购买历史、优惠券使用记录、反馈评论等。

- 数据来源:POS系统、会员管理系统、在线购物平台。

- 输出形式:个性化营销方案、促销活动推荐。

- 更新频率:每周更新一次。

- 需求分析:

- 可行性分析:数据获取和处理的复杂性,数据量的大小,对数据实时性的要求。

- 资源估算:预计需要1个月时间,涉及1名数据工程师、1名数据分析师。

- 需求确认:

- 细节确认:与营销部门详细讨论和确认每个数据字段和分析指标,确定数据的处理流程和输出方式。

- 确认文档:编写需求文档并获得相关部门签字确认。

2. 口径梳理

口径梳理是指对数据指标、维度等进行定义和规范化,以确保数据的一致性和准确性。具体步骤包括:

- 定义数据口径:明确数据指标的计算方法、维度的划分方式、数据的来源等。

- 口径文档:编写详细的口径文档,记录数据口径的定义和规则,以便后续开发和维护。

- 沟通确认:与相关部门沟通口径定义,确保所有人对口径的理解一致。

3. 数据开发

数据开发是整个过程的核心环节,涉及数据的获取、处理和存储。具体步骤包括:

- 数据采集:从各种数据源(如数据库、日志文件、API等)获取原始数据。

- 数据清洗:对原始数据进行清洗,处理缺失值、重复数据、异常值等问题。

- 数据转换:根据需求对数据进行转换和加工,如聚合、分组、计算等。

- 数据存储:将处理后的数据存储到数据仓库或数据库中,以便后续使用。

4. 任务发布

任务发布是指将开发完成的数据处理任务部署到生产环境中,通常包括以下步骤:

- 测试:在测试环境中对数据处理任务进行测试,确保其能正确运行。

- 部署:将经过测试的数据处理任务部署到生产环境中。

- 发布:正式发布数据处理任务,并通知相关部门或客户。

5. 任务监控

任务监控是保证数据处理任务正常运行的重要环节,具体包括:

- 实时监控:通过监控系统实时监控任务的运行状态,及时发现和处理异常。

- 日志分析:通过分析任务的运行日志,了解任务的执行情况,发现潜在问题。

- 告警机制:设置告警机制,当任务运行出现异常时,及时通知相关人员处理。

6. 任务保障

任务保障是确保数据处理任务稳定运行的一系列措施,包括:

- 备份和恢复:定期备份数据和任务配置,确保在发生故障时能快速恢复。

- 容错机制:设计任务的容错机制,如任务失败时自动重试、任务失败时的应急预案等。

- 性能优化:对数据处理任务进行性能优化,提高任务的执行效率,减少资源消耗。

- 定期巡检:定期对数据处理任务进行巡检,发现并解决潜在问题,确保任务的长期稳定运行。

以上是大数据开发各个环节的详细介绍,每个环节都至关重要,只有各个环节紧密配合,才能确保大数据开发工作的顺利进行和最终数据产品的高质量交付

这篇关于聊一聊大数据需求的流程的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!