本文主要是介绍BF16相比FP16的优点,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

BF16和FP16

参考链接:

- Understanding the advantages of BF16 vs. FP16 in mixed precision training

- Megatron-LM & Megatron-Core

- BFloat16: The secret to high performance on Cloud TPUs

BF16相比FP16的优点:

- BF16和FP16都是两个字节,区别是指数位和小数位不一样

- BF16的指数位和FP32一样,所以在整数表示的范围上,BF16和FP32保持一致,但是在小数精度上比较低。

- 这样可以保证在模型训练的过程中尽量不要发生数据的溢出(上溢或者下溢),防止在一些计算中出现nan的数据(例如inf * 0 = nan),导致了模型的训练崩溃。

- 小数精度上虽然BF16有损失,但是考虑到FP16在训练过程中,和FP32进行转换的时候,也会发生小数精度上的损失,所以小数精度虽然重要,但是相比数据溢出出现nan问题,可能并不是一个最大的问题,毕竟nan会导致模型无法正常训练,且一个参数出现nan,很快就会导致整个模型参数都变成nan。

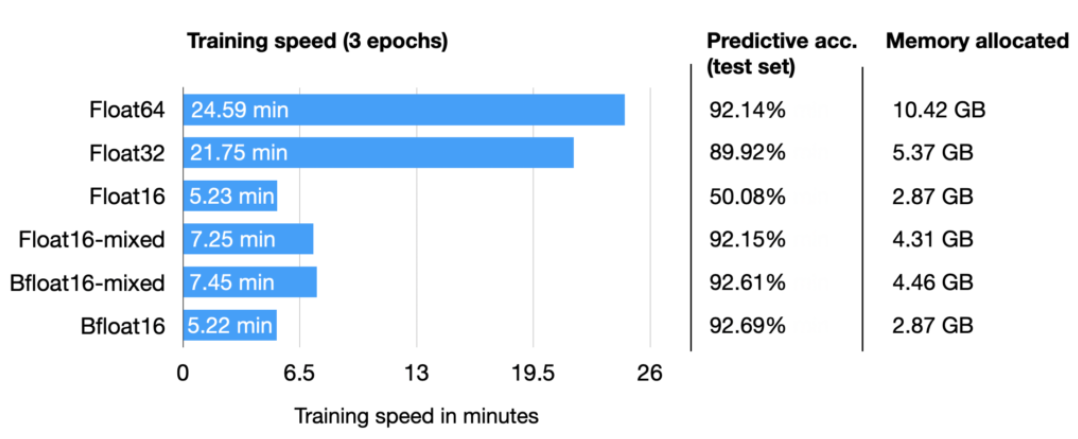

- 在混合精度训练过程中,BF16比FP16更加节省内容,这里我理解,是因为FP16的混合精度训练过程中,需要保存一个模型副本,然后前向推理过程中还需要一个FP16的副本。但是在BF16中,这个FP32和FP16的副本可以直接用一个FP32来使用,因为BF16相当于是FP32的前两个字节,需要用BF16的时候,直接截取前两个字节进行计算(这里可能会有精度损失,但是使用FP16这样转换也一样会有精度损失),需要FP32的时候,再把后两个字节加回来。

- BF16转化到FP32更加简单,不需要做转化了,直接截取前2个字节。FP16和FP32之间的转换需要更多的逻辑操作。

- 由于直接使用一个FP32来存储FP32和BF16的副本,所以这里减少了转换步骤,更加方便快捷

- BF16 硬件可以实现比相同芯片尺寸的 FP32 单元更高的吞吐量(With fewer mantissa bits than FP16, the bfloat16 multipliers are about half the size in silicon of a typical FP16 multiplier, and they are eight times smaller than an FP32 multiplier!)

这篇关于BF16相比FP16的优点的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!