本文主要是介绍IK分词器基础安装入门,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

安装

进入到elasticsearch的安装目录下, 找到bin目录。 执行里面的elasticsearch-plugin 命令,这个命令是管理es中的插件的。 ik分词器就是一个插件。

执行下面这个命令就可以安装成了, 注意IK分词器的版本要和es的版本一致才行。 具体哪个版本可以去github中去找。

bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.8.1/elasticsearch-analysis-ik-7.8.1.zip

安装完成之后需要重启一下es服务。 直接kill掉,在启动。

IK 分词器的分词过程

这里面的最后一部是说如果词句里面有英文的话,还会在进行分词过滤 。

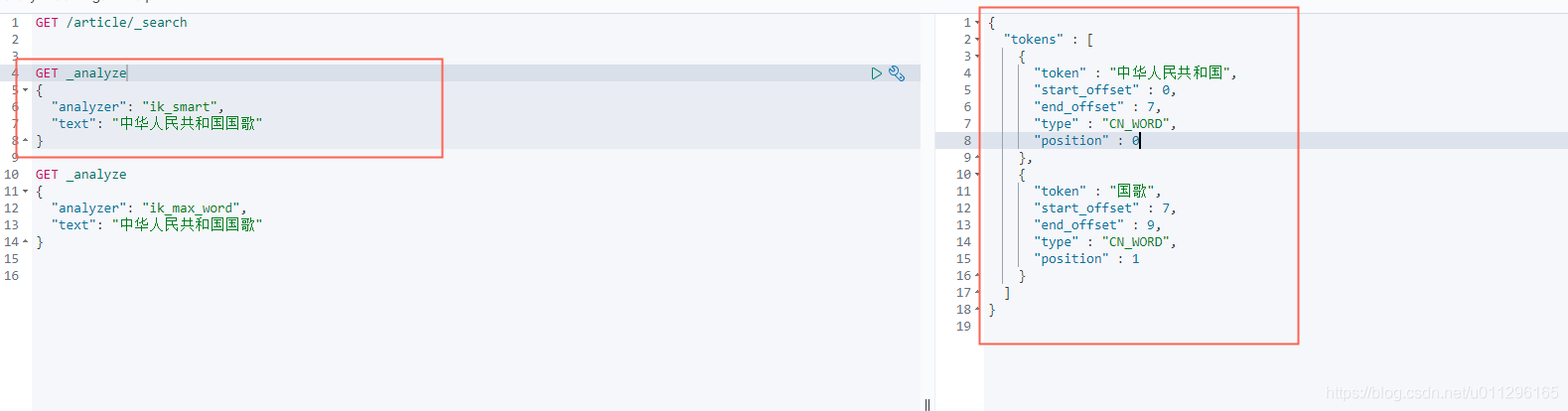

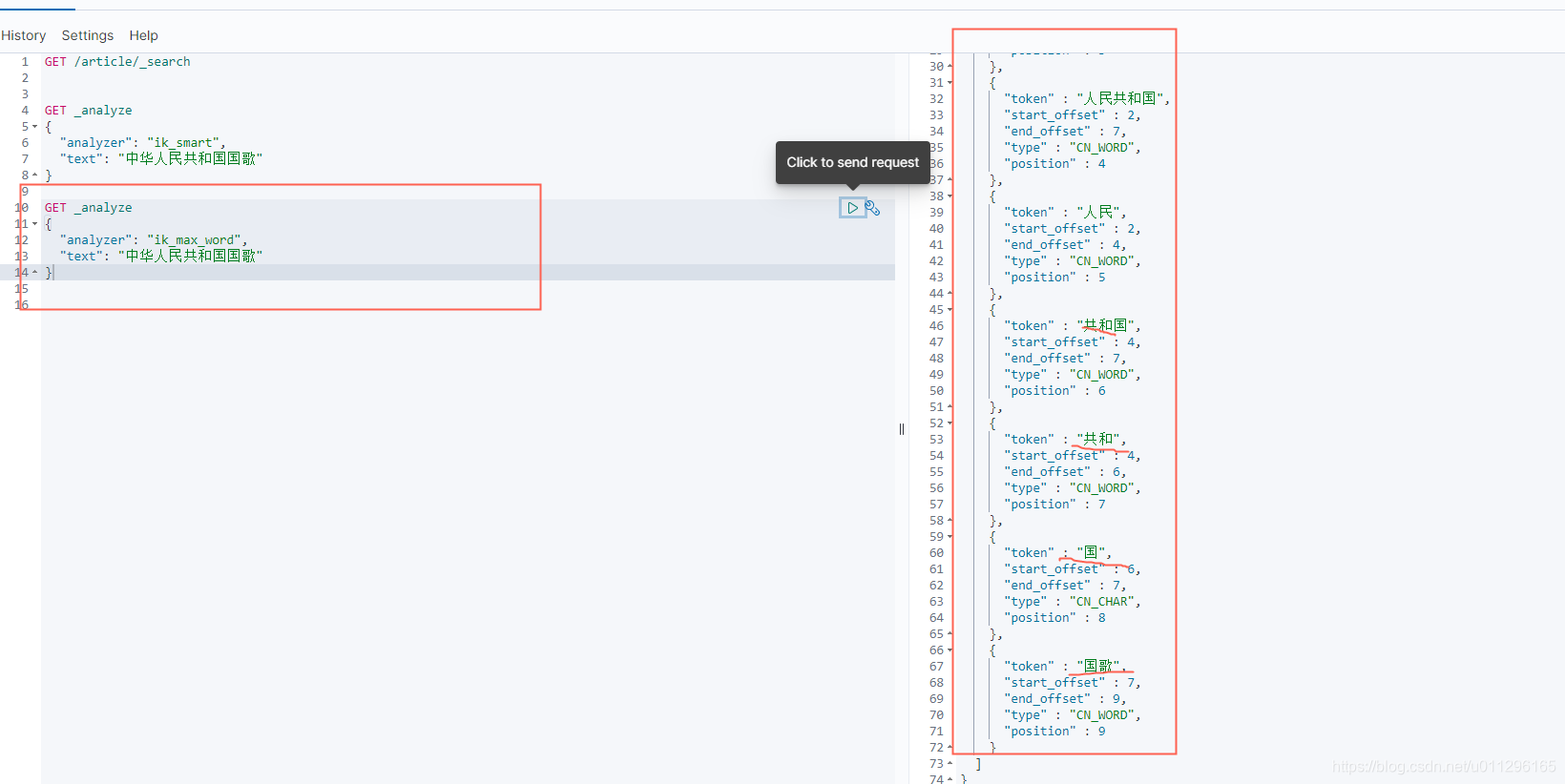

不同分词效果

智能分词法和最大化分词法。

智能分词法就是尽量的保证不会有重复分词的情况下分词。

最大化分词,是说只要是一个词或者有意义的字都给分开。如下图: 有很多字重复出现了, 也有一个字就做为一个词。

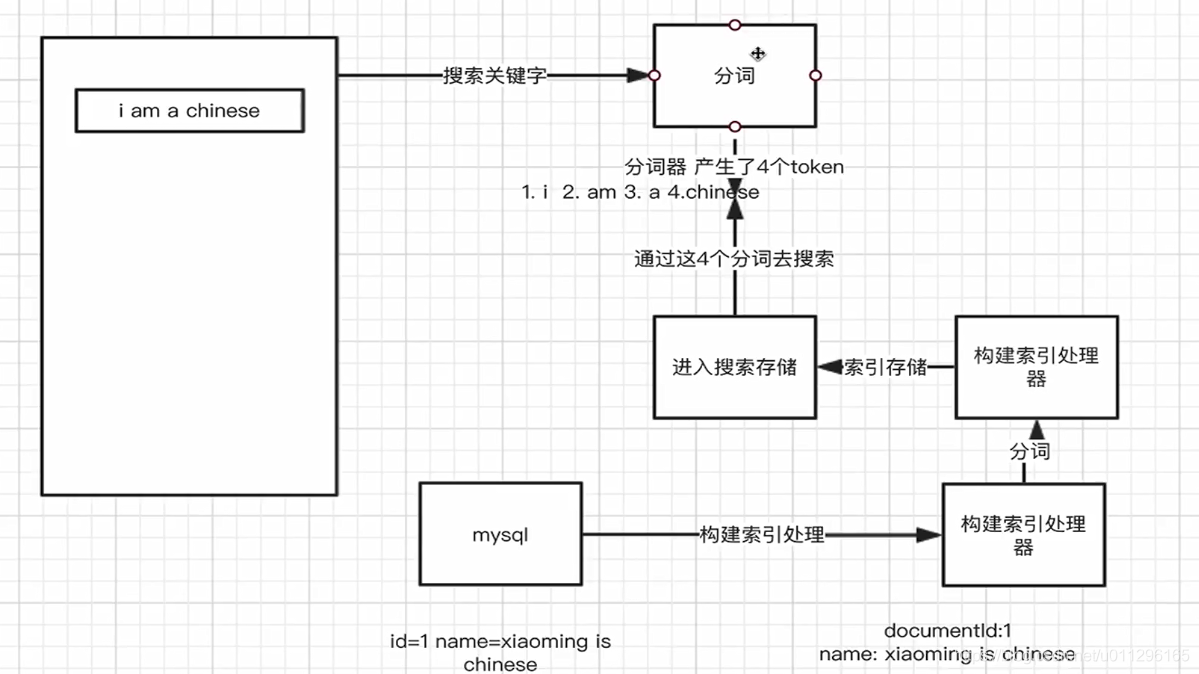

查询分词和存储分词

可以看到下面这个图, 分成三部分, 一个是搜索存储做为中心保存数据。 二个是构建索引处理器通过分词规则将数据存储到搜索存储中。 三个是客户端将要搜索的词进行分词,然后分到这个分词去搜索存储查询。 其中第二部分和第三部分都使用到了分词器,而这个分词器是可以使用不同的分词器。

最佳实践: 索引数据的时候使用max_word,但是在查询的时候使用smart_word。当没有召回的时候,可以在搜索的时候指定使用max_word分词器。

停用词和主分词

停用词和主分词都包含在IK的配置文件中,可以在config目录下查看。

ES会在config目录下给插件创建自己的目录 。可以看到红色的为主分词文件,绿色的为停用词文件

停用词就是说词的时候,这些词不做为一个词创建索引 。

主分词就是这些词会做一个分词创建索引 。

可以看一下main.dic的内容。

交个朋友吧

这篇关于IK分词器基础安装入门的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!