本文主要是介绍Hadoop2.8.0+Zookeeper3.4.8+Hbase1.2.6完全分布式配置,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

- 准备环境

三台Ubuntu系统的电脑

同一局域网

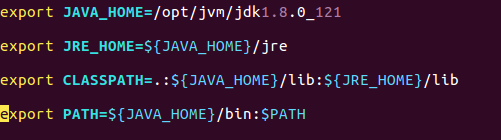

Java1.8.0_121

Hadoop2.8.0

Zookeeper3.4.8

Hbase1.2.6

大家可以自行取官网下载各工具的最新版本.

- Hadoop完全分布配置

- 安装JDK

解压java1.8.0_121.tar.gz到/opt/jvm下,编辑 vim /etc/profile文件,添加jdk环境变量:

source /etc/profile命令使配置生效

java -version命令查看jdk环境变量是否配置成功

2. 配置所有机器的hostname和hosts

(1)三台机器均新建个hadoop用户用来专门进行hadoop大数据相关操作

(2)更改hostname,可以编辑 vim /etc/sysconfig/network 重启后生效。

(3)更改host,可以编辑 vim /etc/hosts,增加如下内容:

192.168.1.8 bigdata1

192.168.1.7 bigdata2

192.168.1.10 bigdata3 (我这里把bigdata3作为master)

hosts可以和hostname不一致 ,这里为了好记就写一致了。

3. 配置ssh免密登录

(1)输入命令,ssh-keygen -t rsa,生成key,一直按回车,

就会在~/.ssh生成:authorized_keys id_rsa.pub id_rsa 三个文件,

这里要说的是,为了各个机器之间的免登陆,在每一台机器上都要进行此操作。

(2)接下来,在bigdata3服务器,合并公钥到authorized_keys文件,

进入/root/.ssh目录,输入以下命令

cat id_rsa.pub>> authorized_keys 把bigdata3公钥合并到authorized_keys 中

ssh hadoop@192.168.1.7 cat ~/.ssh/id_rsa.pub>> authorized_keys

ssh hadoop@192.168.1.8 cat ~/.ssh/id_rsa.pub>> authorized_keys

把bigdata1、bigdata2公钥合并到authorized_keys 中

完成之后输入命令,把authorized_keys远程copy到bigdata1和bigdata2之中

scp authorized_keys 192.168.1.7:/home/hadoop/.ssh/

scp authorized_keys 192.168.1.8:/home/hadoop/.ssh/

最好在每台机器上进行chmod 600 authorized_keys操作,

使当前用户具有 authorized_keys的读写权限。

拷贝完成后,在每台机器上进行 service sshd restart 操作, 重新启动ssh服务。

之后在每台机器输入 ssh 192.168.1.xx,测试能否无需输入密码连接另外两台机器。

4. 配置Hadoop环境变量,HADOOP_HOME、hadoop-env.sh、yarn-env.sh。

(1)配置HADOOP_HOME,编辑 vim /etc/profile 文件,添加如下内容:

export HADOOP_HOME=/home/hadoop/hadoop-2.8.0 (Hadoop的安装路径)

export PATH=$PATH:$HADOOP_HOME/sbin

export PATH=$PATH:$HADOOP_HOME/bin

(以下两行最好加上,若没有启动Hadoop、hbase时都会有没加载lib成功的警告)

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib/native"

(2)配置hadoop-env.sh、yarn-env.sh,在Hadoop安装目录下

编辑 vim etc/hadoop/hadoop-env.sh

加入export JAVA_HOME=/opt/jvm/jdk1.8.0_121(jdk安装路径)

编辑 vim etc/hadoop/yarn-env.sh

加入export JAVA_HOME=/opt/jvm/jdk1.8.0_121(jdk安装路径)

保存退出

5. 配置基本相关xml,core-site.xml、hdfs-site.xml、mapred-site.xml、mapred-site.xml

(1)配置core-site.xml,在Hadoop安装目录下 编辑 vim etc/hadoop/core-site.xml

主要配置NameNode 的URI和hadoop临时文件的存放目录

(2)配置hdfs-site.xml,在Hadoop安装目录下 编辑 vim etc/hadoop/hdfs-site.xml

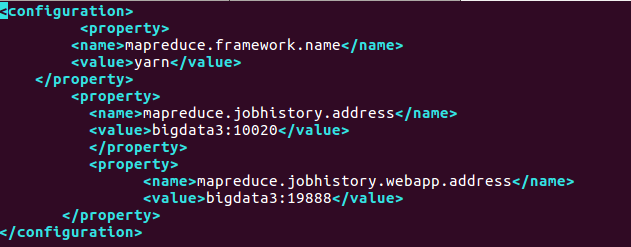

(3)配置mapred-site.xml,在Hadoop安装目录下 编辑 vim etc/hadoop/mapred-site.xml

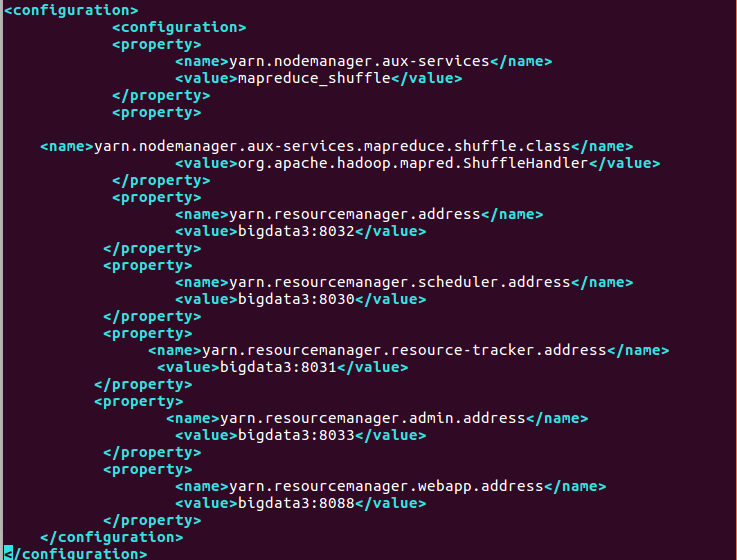

(4)配置yarn-site.xml,在Hadoop安装目录下 编辑 vim etc/hadoop/yarn-site.xml

6. 配置slaves

在Hadoop安装目录下,编辑vim etc/hadoop/slaves,

去除默认的localhost,加入bigdata1、bigdata2,保存退出。

7. 通过远程复制命令scp,将配置好的Hadoop复制到各个节点对应位置

scp -r /home/hadoop/hadoop2.8.0 192.168.1.7:/home/hadoop/hadoop2.8.0

scp -r /home/hadoop/hadoop2.8.0 192.168.1.8:/home/hadoop/hadoop2.8.0

8. Hadoop的启动与停止

(1) 在Master服务器启动hadoop,从节点会自动启动,进入Hadoop目录下,

输入命令,bin/hdfs namenode -format进行hdfs格式化

输入命令,sbin/start-all.sh,进行启动

也可以分开启动,sbin/start-dfs.sh、sbin/start-yarn.sh

在master 上输入命令:jps, 看到ResourceManager、NameNode、SecondaryNameNode进程

在slave 上输入命令:jps, 看到DataNode、NodeManager进程

出现这5个进程就表示Hadoop启动成功。

在浏览器中输入http://bigdata3:50070查看bigdata3(master)状态,

输入http://bigdata3:8088查看集群状态

(2) 停止hadoop,进入Hadoop目录下,输入命令:sbin/stop-all.sh, 即可停止master和slave的Hadoop进程

- zookeeper完全分布配置

(1) 解压下载好的zookeeper后,然后进入conf目录(将zoo_sample.cfg修改为zoo.cfg)mv修改名称或者cp一个,老的作为样本

(2)vim zoo.cfg进行配置

tickTime=2000 心跳间隔

initLimit=10 初始容忍的心跳数

syncLimit=5 等待最大容忍的心跳数

dataDir=/home/hadoop/zookeeper-3.4.8/data 本地保存数据的目录,tmp存放的临时数据,可以修改为自己的目录;

dataLogDir=/home/hadoop/zookeeper-3.4.8/logs 日志保存的目录

clientPort=2181 客户端默认端口号

server.1=192.168.1.8:2888:3888

server.2=192.168.1.7:2888:3888

server.3=192.168.1.10:2888:3888

(3)由于需要事先创建好data目录和logs,所以现在在zookeeper目录下创建data目录:

mkdir data

mkdir logs

然后在data目录创建一个文件myid,里面写一个3 (每台机器对应自己Ip的server.x中的x数字)

(4)然后将修改好的复制到bigdata1和bigdata2上面,记得修改myid中的数字

(5)至此Zookeeper搭建结束,下面开始启动Zookeeper,分别启动:

如果你不想切换到Zookeeper目录启动,可以配置环境变量:

vi /etc/profile(修改文件)

export ZOOKEEPER_HOME=/home/hadoop/zookeeper-3.4.8

export PATH=PATH:ZOOKEEPER_HOME/bin

重新编译文件:

source /etc/profile

注意:3台zookeeper都需要修改

(6)三台分别启动zookeeper,并查看状态

jps查看进程发现三台均多了个QuorumPeerMain进程

(7)关闭zk命令: bin/zkServer.sh stop

- HBase分布式安装

(1)配置环境变量

编辑 vim /etc/profile 加入

export HBASE_HOME=/home/hadoop/hbase-1.2.6

export PATH=$HBASE_HOME/bin:$PATH

编辑vim /home/hadoop/hbase-1.2.6/conf/hbase-env.sh

export HBASE_CLASSPATH=/home/hadoop/hbase-1.2.6/conf

export HBASE_PID_DIR=/home/hadoop/hbase-1.2.6/pids

export HBASE_LOG_DIR=${HBASE_HOME}/logs

export JAVA_HOME=/opt/jvm/jdk1.8.0_121/

export HBASE_HOME=/home/hadoop/hbase-1.2.6

export HBASE_LOG_DIR=/home/hadoop/hbase-1.2.6/logs

export PATH=$PATH:$HBASE_HOME/bin

export HBASE_MANAGES_ZK=false

export HADOOP_HOME=/home/hadoop/hadoop2.8.0

(2)配置hbase-site.xml文件

(3)配置regionservers

编辑 vim /hadoop/hbase-1.2.6/conf/regionservers 去掉默认的localhost,

加入bigdata1、bigdata2,保存退出

然后把在bigdata3上配置好的hbase,通过远程复制命令复制到bigdata1、bigdata2对应的位置

(4)启动与停止Hbase

在Hadoop已经启动成功的基础上,输入start-hbase.sh,过几秒钟便启动完成,

输入jps命令查看进程是否启动成功,若 bigdata3上出现HMaster,

bigdata1,bigdata2上出现HRegionServer,就是启动成功了。

输入hbase shell 命令 进入hbase命令模式输入status命令可以看到如下内容,1个master,2 servers,3机器全部成功启动。

1 active master, 0 backup masters, 2 servers, 0 dead, 2.0000 average load

当要停止hbase时输入stop-hbase.sh,过几秒后hbase就会被停止了

- 至此配置完成啦!

关闭顺序:hbase-->zookeeper-->hadoop

这篇关于Hadoop2.8.0+Zookeeper3.4.8+Hbase1.2.6完全分布式配置的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!