本文主要是介绍2024 第三届 AIGC 中国开发者大会:多模态大模型的发展与趋势,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

引言

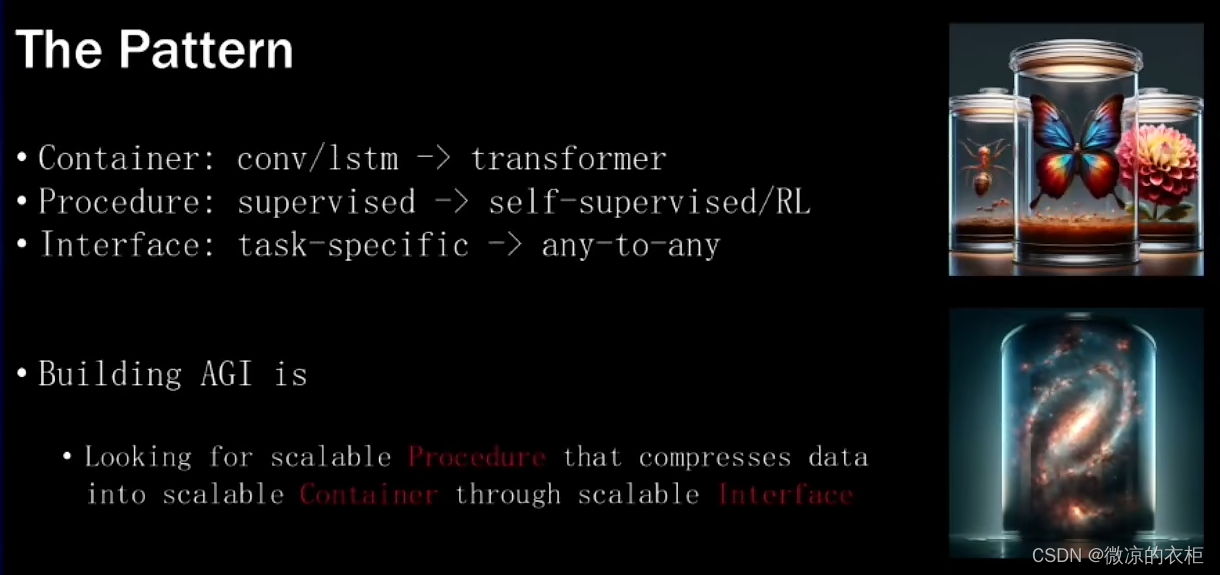

在2024年第三届AIGC中国开发者大会上,零一万物联合创始人潘欣分享了多模态大模型的发展与趋势。潘欣对多模态大模型的历史、现状和未来进行了详细回顾和深刻思考,为我们揭示了该领域的发展路径和技术前景。本文将详细解读潘欣的分享内容,探讨多模态大模型的技术背景、发展历程、应用案例以及未来展望。

一、多模态大模型的技术背景

1.1 早期的任务特定单模态模型

在多模态大模型出现之前,机器学习主要集中在任务特定的单模态模型上。2012年,随着AlexNet的出现,单模态模型在图像分类任务上取得了巨大成功。这些模型通常针对特定任务进行训练,例如图像分类、语音识别或自然语言处理(NLP),需要分别训练不同的模型并收集相应的数据。

1.2 通用单模态模型的兴起

随着技术的进步,到2018年,单模态模型逐渐向通用模型发展。例如,在NLP领域,BERT模型的出现标志着一种新的训练方式,即掩码语言模型(Mask Language Model),通过自监督或无监督的方式训练,提高了训练效率。进一步,GPT-3的出现将模型参数量提升到170B级别,使其能够处理多种任务并包含广泛的世界知识。

二、多模态大模型的发展历程

2.1 从单任务到多任务

在视觉和语音领域,类似的转变也在发生。Clip模型在2020年出现,使得视觉模型从单任务转向通用模型,能够处理开放词表的分类和检测任务。同样,在生成类任务中,从StyleGAN到Stable Diffusion模型的发展,使得图像生成模型能够通过一个模型生成任意图像内容。

2.2 融合多模态输入与输出

多模态大模型的下一步是支持任意模态的输入和输出。例如,GPT-4已经展示了这种能力,能够处理文本、图像和语音等多种模态的输入,并生成相应的输出。这种多模态融合的能力,使得模型能够更全面地理解和生成内容。

三、多模态大模型的技术实现

3.1 编码器(Encoder)

多模态大模型的一个关键部分是编码器。编码器的作用是将自然信号编码成统一的表示,便于下游任务处理。例如,视觉编码器将图像信号转换为语义信号,使得语言模型能够高效学习视觉输入。编码器的选择和设计对于模型的性能至关重要。

3.2 语言模型(Language Model)

多模态模型通过语言模型整合不同模态的信息,并基于指令进行分析和推理。语言模型利用其庞大的世界知识,对不同模态的输入进行统一理解,并生成相应的输出。

3.3 解码器(Decoder)

解码器的作用是将语言模型生成的语义信息转换为具体的输出形式,例如图像或语音。当前的技术水平下,专门的解码器能够提供比纯语言模型更高质量的输出。

四、多模态大模型的训练与应用

4.1 多模态预训练

多模态模型的训练过程通常包括预训练和微调阶段。近年来,逐步引入多模态信号进行预训练,让模型能够更早地接触到大规模、多模态的数据,提高模型的泛化能力和应用性能。

4.2 实际应用案例

潘欣在演讲中提到了零一万物的E-Vision系统,该系统基于1.5和34B的语言模型,展示了多模态模型在实际应用中的强大能力。例如,通过对PPT中的视觉元素进行分析,生成图表等。这些应用案例展示了多模态模型在实际场景中的广泛潜力。

五、多模态大模型的未来展望

5.1 长多模态输入与细粒度语义理解

未来,多模态模型将进一步提升对长输入的处理能力,能够理解视频、长文档等复杂输入,并进行细粒度的语义理解。

5.2 长输出的一致性与可控性

在生成长输出时,确保一致性和可控性是一个重要的挑战。例如,在生成长篇故事或视频时,模型需要保持一致的风格和背景,提供连贯的输出。

5.3 多模态预训练的发展

多模态预训练将成为主流,通过更早地引入多模态信号,提高模型的训练效果和应用性能。

结论与未来展望

多模态大模型的发展展示了人工智能技术的巨大潜力。从早期的任务特定单模态模型,到当前的通用多模态模型,技术的不断进步为我们带来了更多的应用场景和可能性。未来,随着多模态预训练的普及和技术的进一步发展,多模态大模型将在更多领域发挥重要作用,推动人工智能技术的进一步发展。

这篇关于2024 第三届 AIGC 中国开发者大会:多模态大模型的发展与趋势的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!