本文主要是介绍PatchEmbed,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

PatchEmbed 是用于计算机视觉任务的神经网络层,特别是在Vision Transformer (ViT) 模型中使用。它负责将输入的图像分割成固定大小的图像块(patches),并将这些图像块线性嵌入到高维空间中。这是Vision Transformer处理图像的方式,它不像传统的卷积神经网络那样使用卷积层,而是通过这种分割和嵌入的方式来处理图像。

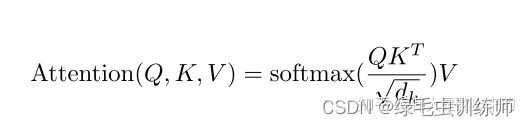

具体来说,PatchEmbed 的过程包括以下几个步骤:

- 图像分割(Image Patching):将输入的图像分割成多个固定大小的图像块。例如,对于一个尺寸为

H x W x C的图像(其中H是高度,W是宽度,C是通道数,例如RGB图像的C为3),可以将其分割成(H/P) x (W/P)个图像块,每个图像块的尺寸为P x P x C。 - 展平(Flatten):将每个图像块展平成一个一维的向量。如果每个图像块的大小是

P x P x C,那么展平后的向量长度将是P*P*C。 - 线性嵌入(Linear Embedding):通过一个线性层(即全连接层)将这些展平后的图像块向量映射到一个高维空间中。这个线性层的输出是图像块的嵌入表示,它们将用于后续的Transformer编码器中。

在Vision Transformer模型中,这种处理图像的方式允许模型能够捕捉到图像中不同区域之间的关系,并且因为使用了Transformer结构,模型能够处理更加长距离的依赖关系。这种方式在许多视觉任务中展示了很好的性能,如图像分类、目标检测和分割等。

代码

import torch

from torch import nn

class PatchEmbed(nn.Module):def __init__(self, img_size, patch_size, in_chans=3, embed_dim=768):super().__init__()self.img_size = img_sizeself.patch_size = patch_sizeself.grid_size = (img_size[0] // patch_size[0], img_size[1] // patch_size[1])self.num_patches = self.grid_size[0] * self.grid_size[1]self.proj = nn.Conv2d(in_chans, embed_dim, kernel_size=patch_size, stride=patch_size)def forward(self, x):B, C, H, W = x.shapex = self.proj(x).flatten(2).transpose(1, 2)return x

在这个简化的实现中:

img_size是输入图像的尺寸,通常是一个二元组(H, W)。patch_size是图像块的大小,也是一个二元组(P, P)。in_chans是输入图像的通道数,例如对于RGB图像,这个值是3。embed_dim是嵌入向量的维度,即每个图像块将被映射到的特征空间的维度。

在__init__方法中,我们计算了图像将被分割成的图像块的数量,并初始化了一个二维卷积层self.proj,它将负责将每个图像块展平并映射到高维空间。

在forward方法中,输入x是一个形状为(B, C, H, W)的张量,其中B是批量大小,C是通道数,H和W分别是图像的高度和宽度。我们使用self.proj对输入图像进行卷积操作,得到嵌入后的特征图,然后将其展平并转置,以便与Transformer编码器的输入格式相匹配。

在实际的timm实现中,PatchEmbed类可能会有更多的功能和选项,例如包括位置编码的嵌入、不同的Normalization层等,但基本原理是相同的。

这篇关于PatchEmbed的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!