本文主要是介绍辅导男朋友转算法岗第1天|tokenizer,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- LLM训练流程

- LLM中的tokenizers

- BPE

- WordPiece

- Unigram

- SentencePiece(使用BBPE或Unigram)

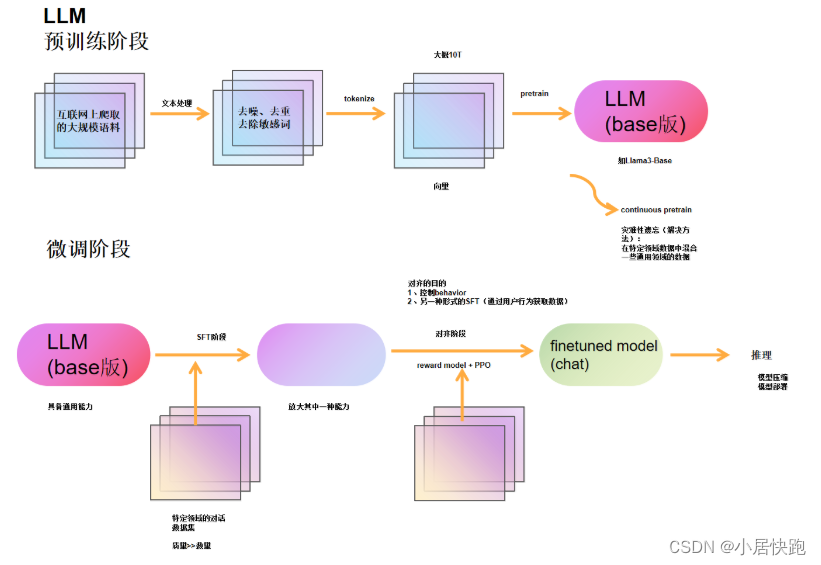

LLM训练流程

【大语言模型LLM基础之Tokenizer完全介绍-哔哩哔哩】 https://b23.tv/2kdTKxf

LLM中的tokenizers

三种不同分词粒度的Tokenizers

- word-based

- character-based

- subword-based

- WordPiece:BERT、DistilBERT

- Unigram:XLNet、ALBERT

- BPE(Byte-Pair Encoding):GPT-2、RoBERTa

- SentencePiece

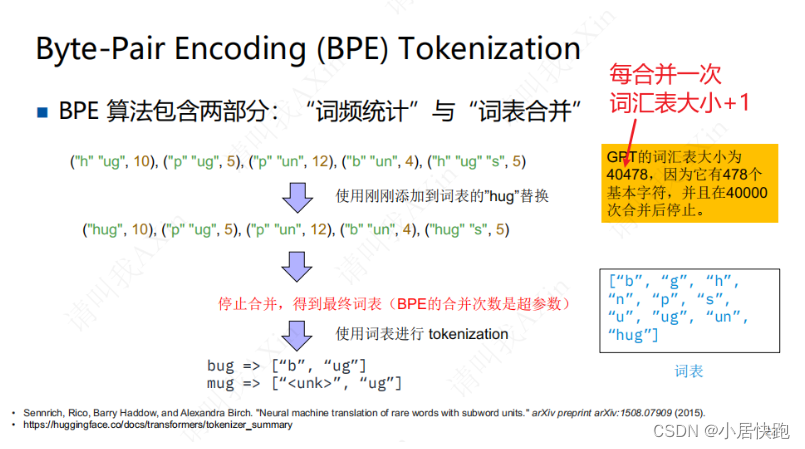

BPE

词频统计->词表合并

设置:BPE的合并次数

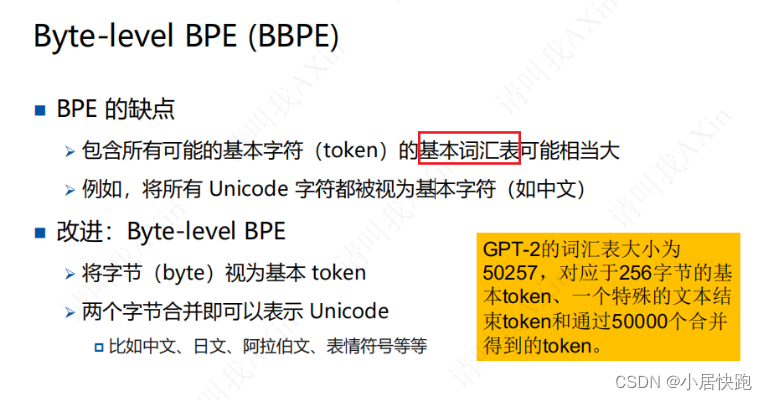

改进:BBPE

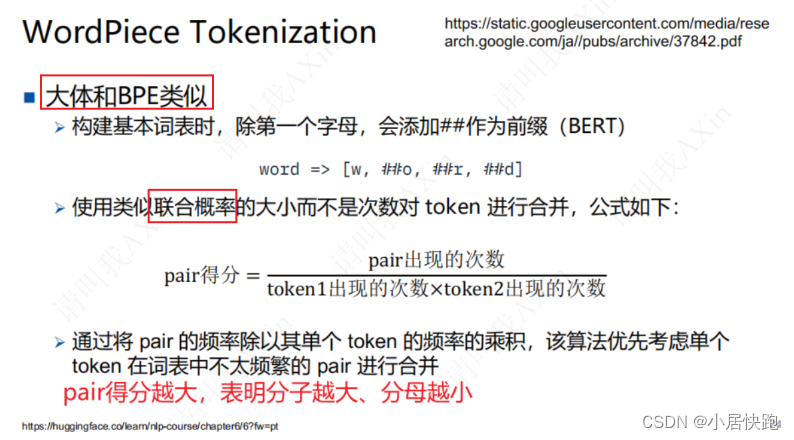

WordPiece

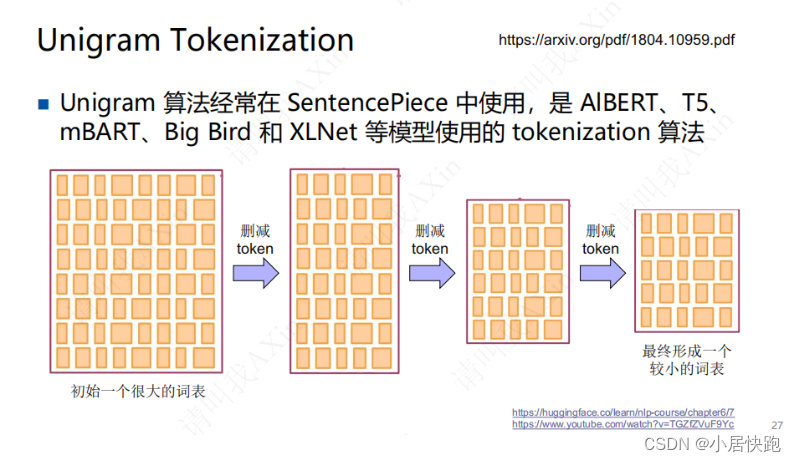

Unigram

先初始化一个很大的词表(字母、单词、subword都包括)

设置:删减的次数

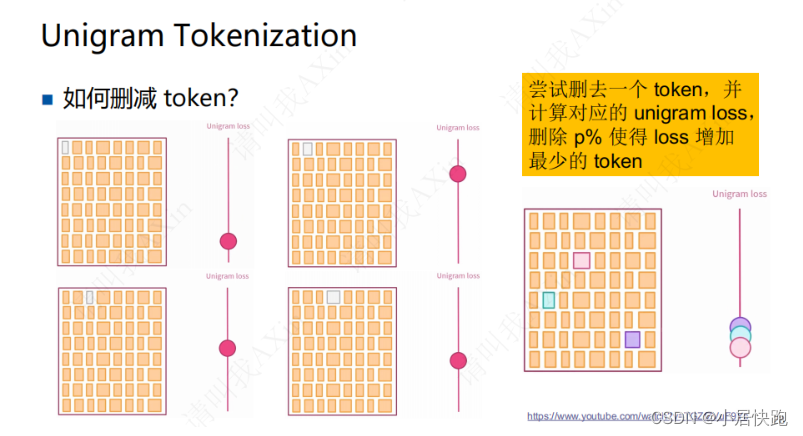

删去对词表的表达能力影响不大的token

基于统计的划分

loss:负对数似然

SentencePiece(使用BBPE或Unigram)

解决多国语言的分词问题,输入都当做字节流(含空格)

这篇关于辅导男朋友转算法岗第1天|tokenizer的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!