airflow专题

深入理解Apache Airflow 调度器(最新推荐)

《深入理解ApacheAirflow调度器(最新推荐)》ApacheAirflow调度器是数据管道管理系统的关键组件,负责编排dag中任务的执行,通过理解调度器的角色和工作方式,正确配置调度器,并... 目录什么是Airflow 调度器?Airflow 调度器工作机制配置Airflow调度器调优及优化建议最

Airflow 核心原理分析

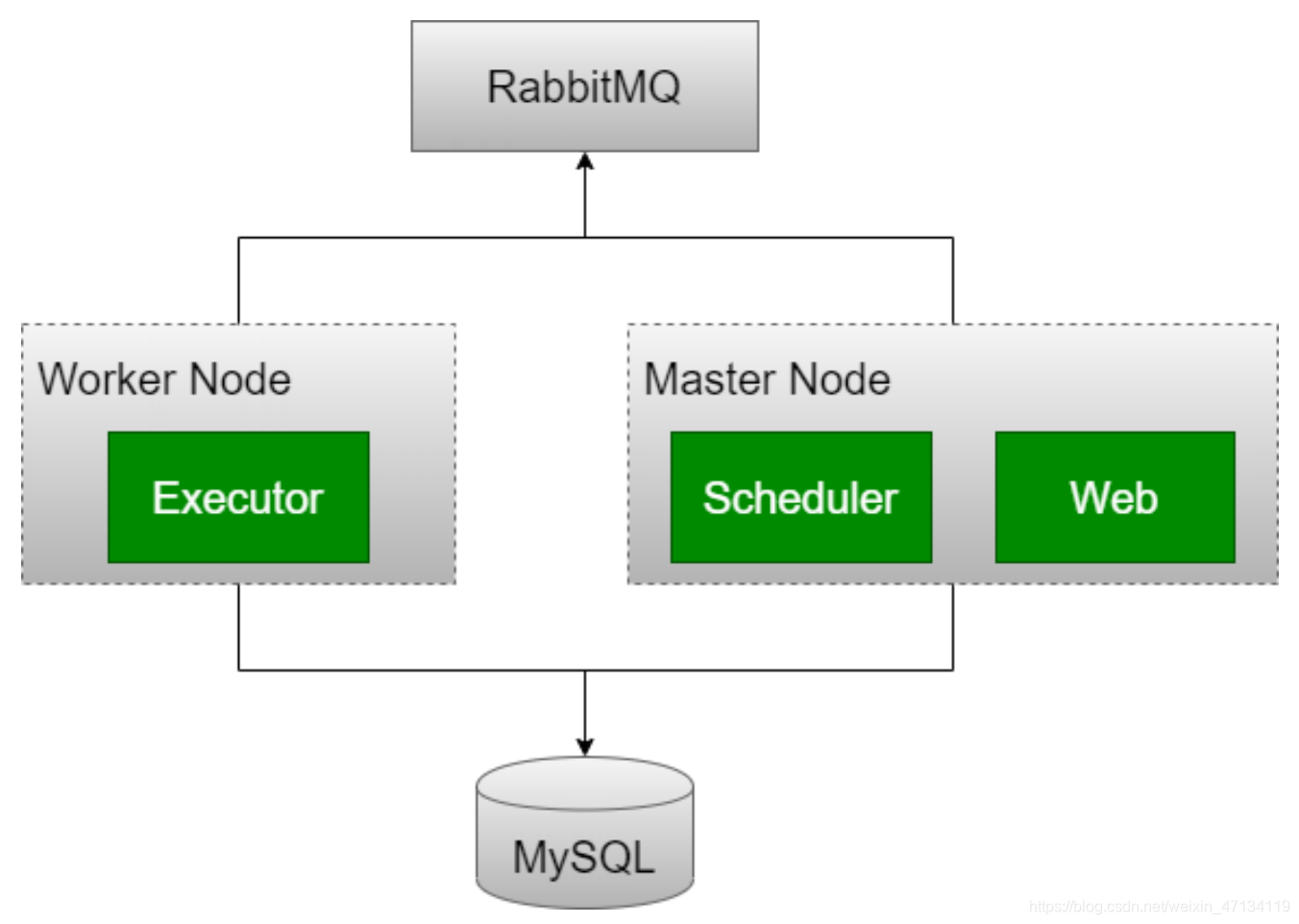

1. airflow架构 scheduler,它处理触发计划的工作流,并将任务提交给executor运行。 executor,处理正在运行的任务。在默认的 Airflow 安装中,它运行在scheduler中,但大多数适合生产的executor实际上将任务执行推送给workers。 webserver,它提供了一个方便的用户界面来检查、触发和调试 DAG 和任务的行为。 DAG Di

airflow调度时间详解

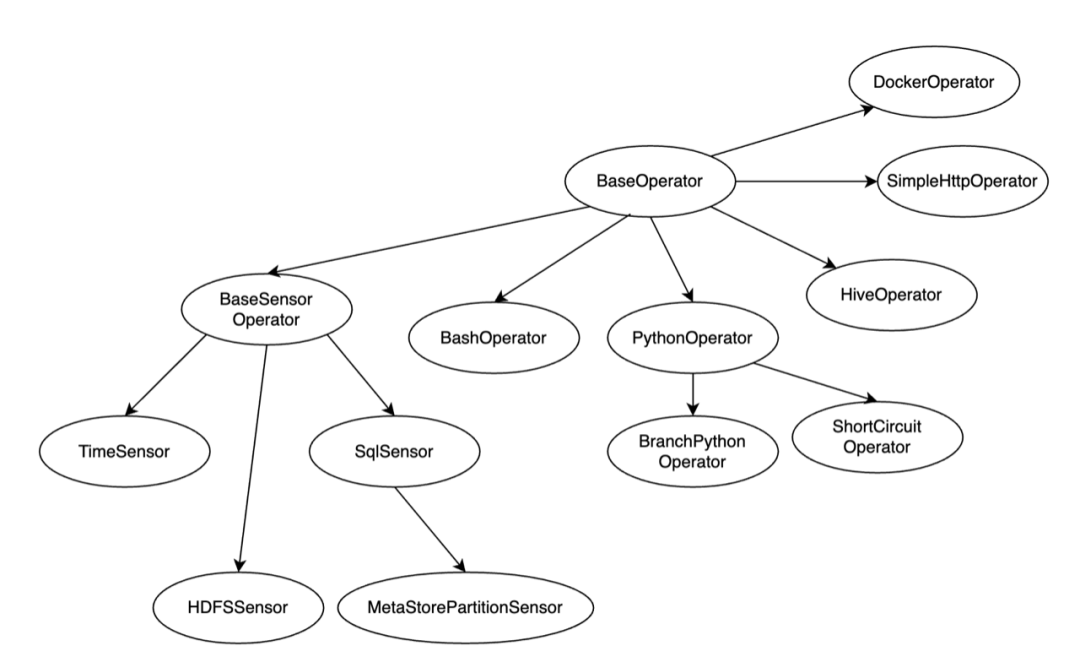

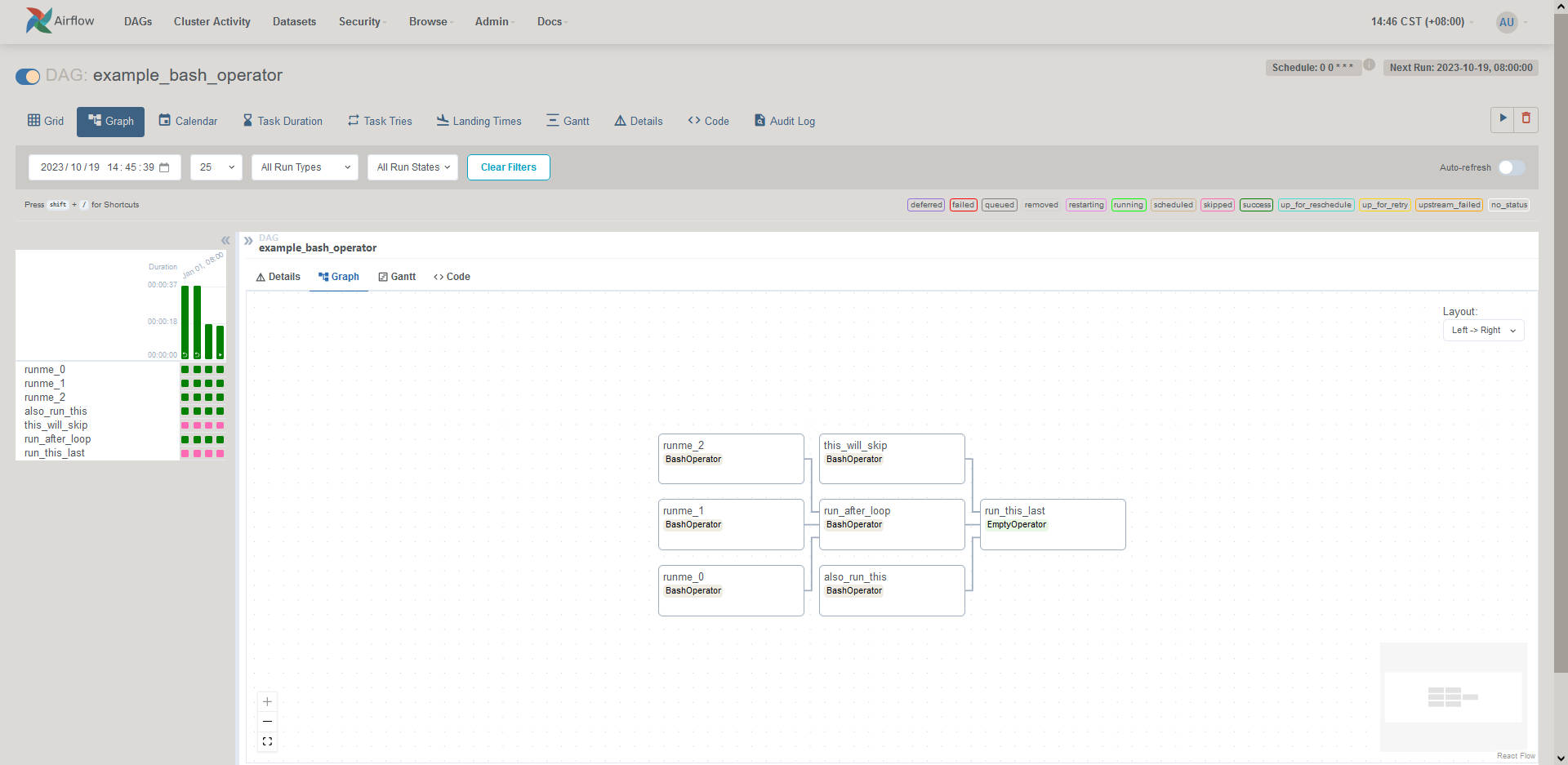

⭐️ airflow调度概述 Apache Airflow 是一个开源的工作流调度和监控平台,广泛用于数据工程、ETL(提取、转换、加载)管道以及各种自动化任务。下面我将详细说明 Airflow 的调度算法。 1. DAG(有向无环图) Airflow 的核心是 DAG(Directed Acyclic Graph),它定义了一组有序的任务,其中每个任务称为一个 “task”。DAG 是调度

Airflow 中的trigger_rule

最近正在使用airflow,用到了这个,记录下 在 Apache Airflow 中,trigger_rule 是用于控制任务何时被触发的规则。TriggerRule 是一个枚举类型,它包含了多种不同的触发规则。以下是这些规则及其用途的详细说明: ALL_SUCCESS(默认就是它) 描述: 只有当所有上游任务都成功时,当前任务才会被触发。 用途: 用于确保当前任务只在所有前置条件都

mac下安装airflow

背景:因为用的是Mac的M芯片的电脑,安装很多东西都经常报错,最近在研究怎么把大数据集群上的crontab下的任务都配置到一个可视化工具中,发现airflow好像是个不错的选择,然后就研究怎么先安装使用起来,后面再做优化 一、安装conda环境 因为我本地已经安装了anaconda,所以这里可以直接使用试试,有问题再说 网上好多说安装miniconda的 二、安装airflow 我是直接使

调度工具:Airflow

Airflow安装 airflow对python-devel、numpy等版本有一定的要求,想减少麻烦可参考: 《 Install Python 2/3 on CentOS 6.5 Server》 python搞掂了,airflow安装其实很简单 pip install airflowpip install airflow[mysql]airflow initdbairfl

【Docker】Airflow Worker 容器部署

Airflow Worker环境标准软件基于Bitnami airflow-worker 构建。当前版本为2.4.58 你可以通过轻云UC部署工具直接安装部署,也可以手动按如下文档操作,该项目已经全面开源,可以从如下环境获取 配置文件地址: https://gitee.com/qingplus/qingcloud-platform qinghub自动安装部署配置库 What is Apach

任务调度系统 Airflow

任务调度系统 Airflow 文章目录 一. Airflow 简介1.1 体系结构1.2 重要概念1.2.1 DAG(Directed Acyclic Graph)有向无环图1.2.2 Task 二. Airflow 安装部署2.1 安装依赖2.2 Python 环境准备2.3 安装 Airflow2.4 创建数据库用户并授权2.5 修改 Airflow DB 配置2.6 安

Airflow的简单入门

Airflow 作为一款开源分布式任务调度框架,已经在业内广泛应用。本文总结了 Freewheel Transformer 团队近两年使用 Airflow 作为调度器,编排各种批处理场景下 ETL Data Pipelines 的经验,希望能为正在探索 Airflow 的技术团队提供一些参考价值。 为什么选择 Airflow? FreeWheel 的批数据处理使用场景主要分成两种,

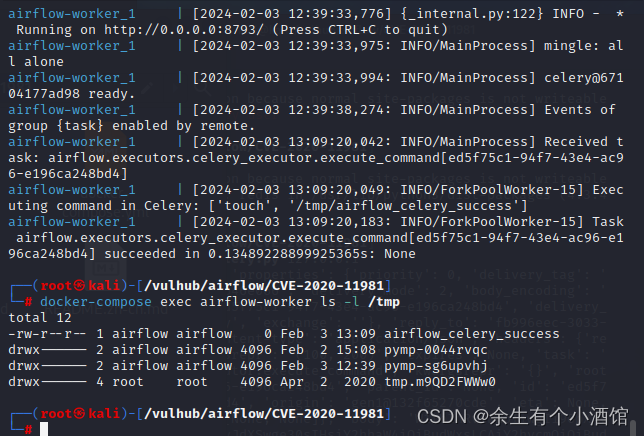

vulhub中 Apache Airflow Celery 消息中间件命令执行漏洞复现(CVE-2020-11981)

Apache Airflow是一款开源的,分布式任务调度框架。在其1.10.10版本及以前,如果攻击者控制了Celery的消息中间件(如Redis/RabbitMQ),将可以通过控制消息,在Worker进程中执行任意命令。 1.利用这个漏洞需要控制消息中间件,Vulhub环境中Redis存在未授权访问。通过未授权访问,攻击者可以下发自带的任务`airflow.executors.celery

Airflow原理浅析

⭐️ airflow基本原理 Apache Airflow 是一个开源的工作流自动化工具,它用于调度和管理复杂的数据工作流。Airflow 的原理基于有向无环图(DAG)的概念,它通过编写和组织任务的有向图来描述工作流程。 以下是 Apache Airflow 的一些关键原理: 1. 有向无环图 (DAG): Airflow 使用 DAG 来表示工作流程,其中每个节点表示一个任务,边表示任

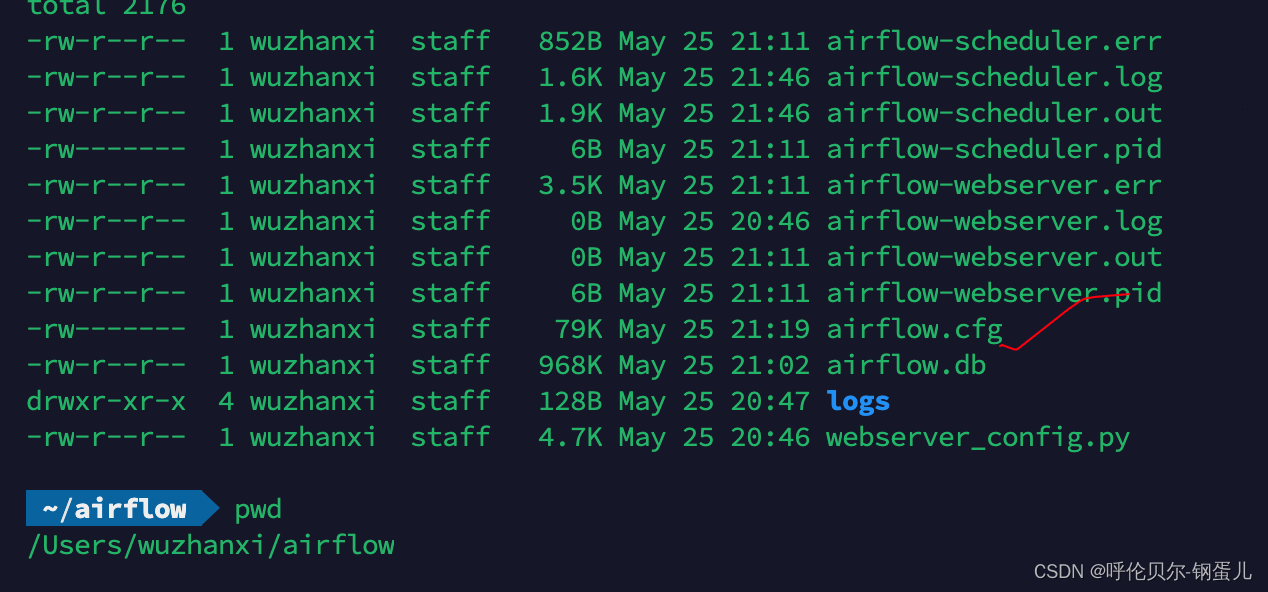

Airflow【部署 01】Airflow官网Quick Start实操(一篇学会部署Airflow)

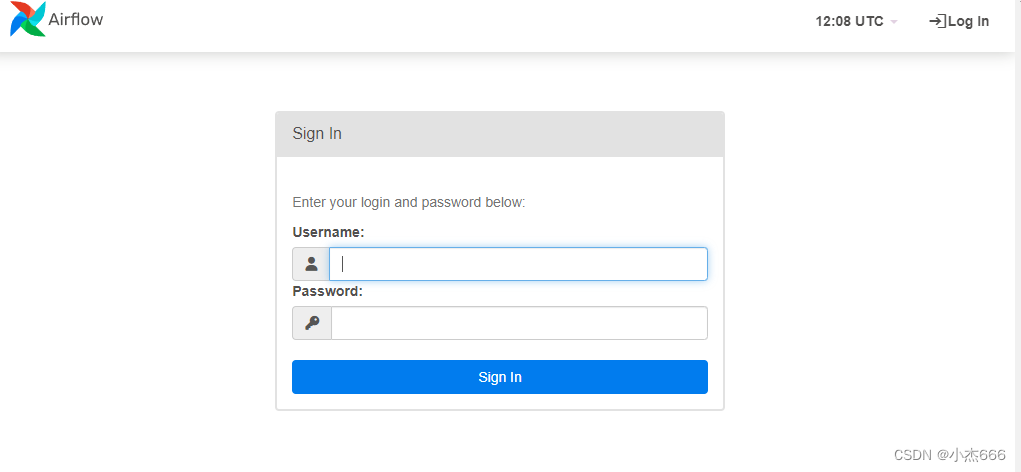

Airflow官网Quick Start实操 1.环境变量设置2.使用约束文件进行安装3.启动单机版3.1 快速启动3.2 分步骤启动3.3 启动后3.4 服务启动停止脚本 4.访问4.1 登录4.2 测试 来自官网的介绍: https://airflow.apache.org/ Airflow™是一个由社区创建的平台,以编程方式编写,调度和监控工作流。这个快速入门指南将帮助您在

Rocky8 顺利安装 Airflow 并解决数据库报错问题

rocky是替代centos的服务器系统,稳定可靠。rocky8会比centos7新,可以支持更多服务软件的安装,免去升级各种库的麻烦,本文运行airflow服务就用rocky8系统。airflow是一个定时任务管理系统,功能强大,目前是apache旗下的一个开源项目。话不多说,正文开始。 准备一个vm虚拟机,在里面安装rocky8,完成后进入系统终端(下文pyenv和airflow都将安装在用

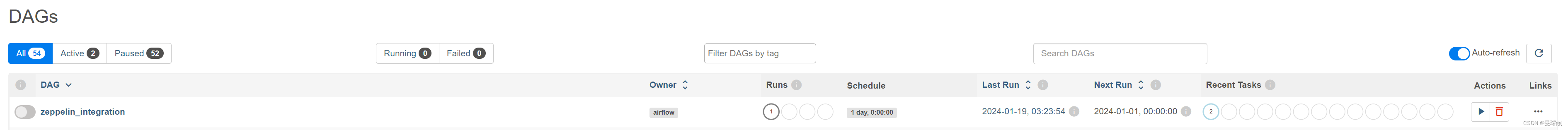

Apache Zeppelin结合Apache Airflow使用1

Apache Zeppelin结合Apache Airflow使用1 文章目录 Apache Zeppelin结合Apache Airflow使用1前言一、安装Airflow二、使用步骤1.目标2.编写DAG2.加载、执行DAG 总结 前言 之前学了Zeppelin的使用,今天开始结合Airflow串任务。 Apache Airflow和Apache Zeppelin是两

工作流管理框架airflow-安装部署教程

1 概述 Airflow是一个以编程方式编写,用于管理和调度工作流的平台。可以帮助你定义复杂的工作流程,然后在集群上执行和监控这些工作流。 Airflow计划程序在遵循指定的依赖项,同时在一组工作线程上执行任务。丰富的命令实用程序使在DAG上执行复杂的调度变的轻而易举。Airflow的可扩展Python框架可以让你构建连接几乎任何技术的工作流程。丰富的用户界面可以随时查看生产中正在运行的管道,

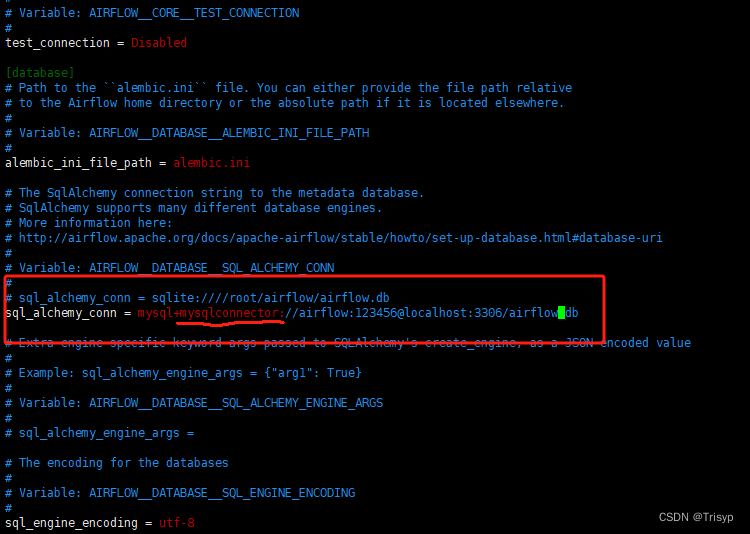

67 Airflow配置MySQL数据库和LocalExecutor

Airflow使用SQLite数据库作为元数据库(知识库),元数据库存放一些DAG相关信息、连接信息、日志信息等。我们可以使用sqlite3命令查看Airflow知识库所包含的表清单,如下图。 SQLite是一个轻量级的文件型数据库,读操作可以并发执行,但增、删、改操作时会有锁,即同一时刻只有一个进程/线程来进行写操作。由于生产环境往往是高并发的美因茨SQLi

66 Airflow安装与部署

环境 系统:CentOS 7 Python:3.6 Airflow:1.10.2 安装配置 1.安装gcc #yum install gcc -y 2.安装 python3.6及开发库 #yum install python36 -y #yum install python36-pip -y #yum instal

65 Airflow组成部分的概念介绍

1. DAG Linux的额crontab和Windows的“任务计划”都可以配置定时任务或间隔任务,但不能配置作业之间的依赖关系。Airflow中的DAG就是管理作业依赖关系的。DAG(Directed Acyclic Graphs)翻译为有向无环图,如下图所示就是一个简单的DAG。 在Airflow中,这种DAG是通过编写Python代码来实现的,D

64 任务调度神器 Airflow

Airflow是Apache下孵化项目,是纯Python编写的一款非常优雅的开源调度平台。Airflow使用DAG(有向无环图)来定义工作流,配置作业以来关系非常方便,毫不夸张的说:再开源的调度工具中,Airflow是首屈一指。 Airflow简介 Airflow具备以下天然优势: 1 . 灵活易用。 Airflow本身是Python编写的,且

airflow配置163企业邮箱

airflow配置163企业邮箱 背景介绍获取163的smtp配置信息airflow.cfg修改smtp配置 背景介绍 最近在使用airflow,对于邮件自动提醒服务,构建了一个如下所示的dag文件,想使用163企业邮箱作为smtp服务,中间走过一些坑,在这里把过程记录下来,避免大家入坑。 airflow版本:2.1.4163企业的邮箱域名在这里假设为airflowdemo,也

airflow系列教程(十)MySqlOperator和PostgresOperator

1. 依赖 MySqlOperator 的数据库交互通过 MySQLdb 模块来实现, 使用前需要安装相关依赖: pip install apache-airflow[mysql] 2. 使用 使用 MySqlOperator 执行sql任务的一个简单例子: from airflow import DAGfrom airflow.utils.dates import days_ago

airflow系列教程(五)在Rancher上部署AirFlow

一、把AirFlow镜像上传到Harbor 1.在本地虚拟机把做好的容器导入成镜像 docker load -i airflow.tar 2.登录私有仓库(其实就是登录Harbor) docker login 10.1.119.12 -u admin -p Harbor12345 3.重命名对象 docker tag airflow 10.1.119.12/gx/airflow:1 4

AirFlow容器部署和使用

一、如何制作AirFlow容器 1、安装docker环境基于centos环境下进行部署,建议在centos6或者centos7的环境下1.1、下载docker安装包下载地址:https://download.docker.com/linux/static/stable/x86_64/推荐使用的版本是18.09.61.2、下载到本地后解压tar -zxf docker-18.09.6.tg

AirFlow初始化的时候遇到 Global variable explicit_defaults_for_timestamp needs to be on (1) for mysql

在安装airflow后,初始化遇到这样的问题 Traceback (most recent call last):File "/opt/anaconda3/bin/airflow", line 32, in <module>args.func(args)File "/opt/anaconda3/lib/python3.7/site-packages/airflow/bin/cli.py", li

airflow系列教程(四)在docker容器下安装airflow(完全离线)

本人的环境是基于centos7下来安装的 一、安装docker 下载docker安装包,下载地址:https://download.docker.com/linux/static/stable/x86_64/ 下载到本地后解压 tar -zxf docker-18.09.6.tgz 将解压出来的docker文件内容移动到 /usr/bin/ 目录下 cp docker/* /

macos pycharm调试airflow代码

项目目录:本案例基于pycharm项目虚拟环境 1.进入项目虚拟环境目录 yololi@bogon bin % pwd/Users/yololi/PycharmProjects/pythonProjecttest/venv/bin 2.安装airflow ./python3.8 -m pip install apache-airflow==2.2.5 -i https://pypi.