训练方法专题

最简单的AI训练方法-RAG增强检索原理

文章目录 1、RAG( Retrieval-Augmented Generation)2、RAG的基本原理3、简化训练流程4、RAG增强检索原理图 1、RAG( Retrieval-Augmented Generation) RAG( Retrieval-Augmented Generation)是一种结合了检索和生成两种策略的AI训练方法,旨在通过检索相关信息来增强模型的生成能

【Stable Diffusion】 训练方法篇

一、四种模型训练方法简介 Stable Diffusion 有四种训练模型的方法:Textual Inversion、Hypernetwork、LoRA 和 Dreambooth 。它们的训练方法存在一定差异,我们可以通过下面对比来评估使用哪种训练方式最适合你的项目。 如果你知道模型中已经可以产生你想要的东西,例如,某种风格,或者已经 "在里面 "的特定名人,你可以使用这个模型,但是当你发现模

LLM大语言模型原理、发展历程、训练方法、应用场景和未来趋势

LLM,全称Large Language Model,即大型语言模型。LLM是一种强大的人工智能算法,它通过训练大量文本数据,学习语言的语法、语义和上下文信息,从而能够对自然语言文本进行建模。这种模型在自然语言处理(NLP)领域具有广泛的应用,包括文本生成、文本分类、机器翻译、情感分析等。本文将详细介绍LLM大语言模型的原理、发展历程、训练方法、应用场景和未来趋势。 1.原理 LLM大语

基于自动编码器的预训练模型方法模型预训练方法RetroMAE和RetroMAE-2

文章目录 RetroMAERetroMAE详情编码解码增强解码 RetroMAE-2RetroMAE-2详情编码[CLS]解码OT解码和训练目标向量表征 总结参考资料 RetroMAE RetroMAE 出自论文《RetroMAE: Pre-Training Retrieval-oriented Language Models Via Masked Auto-Encoder

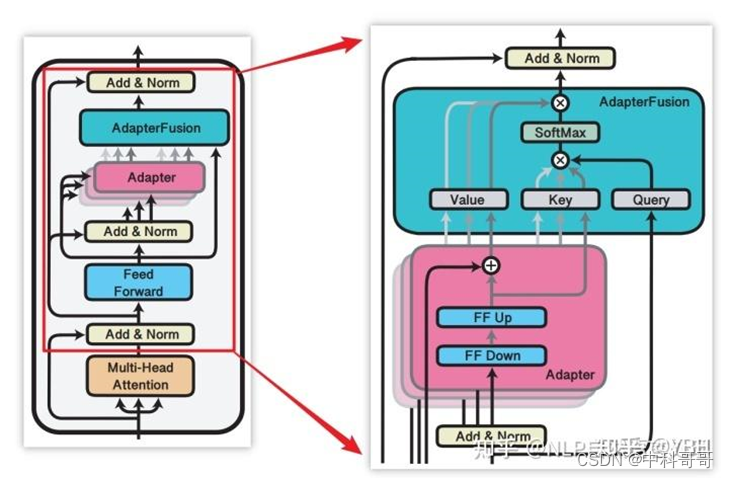

大模型主流微调训练方法总结 LoRA、Adapter、Prefix-tuning、P-tuning、Prompt-tuning 并训练自己的数据集

大模型主流微调训练方法总结 LoRA、Adapter、Prefix-tuning、P-tuning、Prompt-tuning 概述 大模型微调(finetuning)以适应特定任务是一个复杂且计算密集型的过程。本文训练测试主要是基于主流的的微调方法:LoRA、Adapter、Prefix-tuning、P-tuning和Prompt-tuning,并对它们进行总结。 LoRA (Learn

天津大学研究团队开发了一种结合视觉场景和电刺激的长期运动训练神经反馈训练方法...

脑机接口 (BCI) 作为大脑和周边环境之间的直接通信途径,能够通过学习控制帮助运动障碍患者恢复运动功能,其中基于BCI的长期运动训练会使大脑和肌肉之间的功能耦合会发生什么变化一直是人们感兴趣的问题。最近,天津大学医学工程与转化医学研究院明东教授及陈龙副教授带领其团队,开发了一种结合视觉场景和电刺激的长期运动训练神经反馈训练方法,成果发表在《IEEE Transactions on Human

数字人解决方案——RAD-NeRF真人视频的三维重建数字人源码与训练方法

前言 1.真人视频三维重建数字人源码是基于NeRF改进的RAD-NeRF,NeRF(Neural Radiance Fields)是最早在2020年ECCV会议上的Best Paper,其将隐式表达推上了一个新的高度,仅用 2D 的 posed images 作为监督,即可表示复杂的三维场景。 NeRF其输入稀疏的多角度带pose的图像训练得到一个神经辐射场模型,根据这个模型可以渲染出任意视角

基于数据共享的神经网络快速训练方法

导读:神经网络技术的普及离不开硬件技术的发展,GPU 和 TPU 等硬件型训练加速器带来的高算力极大的缩短了训练模型需要的时间,使得研究者们能在短时间内验证并调整想法,从而快速得到理想的模型。然而,在整个训练流程中,只有反向传播优化阶段在硬件加速器上完成,而其他的例如数据载入和数据预处理等过程则不受益于硬件加速器,因此逐渐成为了整个训练过程的瓶颈。本文应用数据共享和并行流水线的思想,在一个数据读

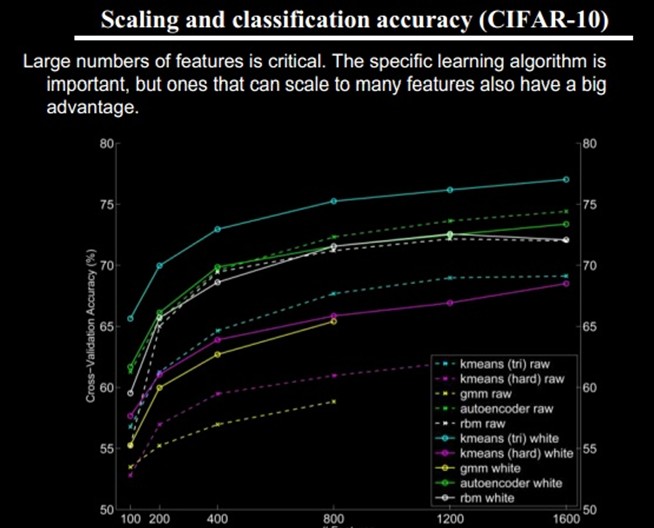

Deep Learning(深度学习)之(一)特征以及训练方法

目录: 一、概述 二、背景 三、人脑视觉机理 四、关于特征 4.1、特征表示的粒度 4.2、初级(浅层)特征表示 4.3、结构性特征表示 4.4、需要有多少个特征? 五、Deep Learning的基本思想 六、浅层学习(Shallow Learning)和深度学习(Deep Learning)

theano中训练方法和模型的一些写法

按照这theano的tutorial开始跟着写了,因为去年年底之前学习过一段时间,但是当时时间少,并且很多地方也没搞懂,大多都是看着书来模仿,结果出错不好找地方之外,自己如果根据自己的想法随便写下结果就出错了。这几天好好的学习了下。我来总结下 在softmax或者逻辑回归的代码中: 1:在教程中写法是,先写一个类,在类的init方法中初始化w和b,以及计算概率。 2:然后分别再另外的函数中计

AI:大语言模型训练方法 - 机器学习

Transformer Transformer是一种深度学习的模型架构,特别适用于自然语言处理任务。Transformer 模型的核心创新在于其 "自注意力"(Self-Attention)机制,这种机制使得模型可以有效地捕捉输入数据中的长距离依赖关系。 Transformer 模型的优点有以下几点: 强大的表达能力:由于其自注意力机制,Transformer 能够捕捉到输入数据中的长距离依

lecture8-RNN的训练方法之二三

HInton第8课,之所以说之二三,是因为训练RNN的四种方法之一:长短时记忆在lecture7中介绍过了,这里介绍的是第二和第三种方法:HF优化和Echo (这个字觉得翻译成回声是不是欠妥,所以保留着,不过个人觉得“回显”不错)状态网络。这课有两个论文作为背景可以看《Generating Text with Recurrent Neural Networks》和《Echo state netwo

ACM训练方法_该我自己检讨了_By LCY

首先,我想说,下面检讨的很多问题并不是现在才有,去年或许更早就已经逐步显现出来,只不过还算过得去的比赛成绩,特别是去年幸运的第一次World Final出线经历,掩盖了很多问题,也让我自己不够清醒。 但是现在,几次比赛的打击让我清醒了很多,断断续续想了很多天,我自己在很多地方实在应该好好检讨: 1、集训队几年来不断进步的趋势,让我心理上过于放松,以为只要按照既定的训练模式,保持以往的训练力度

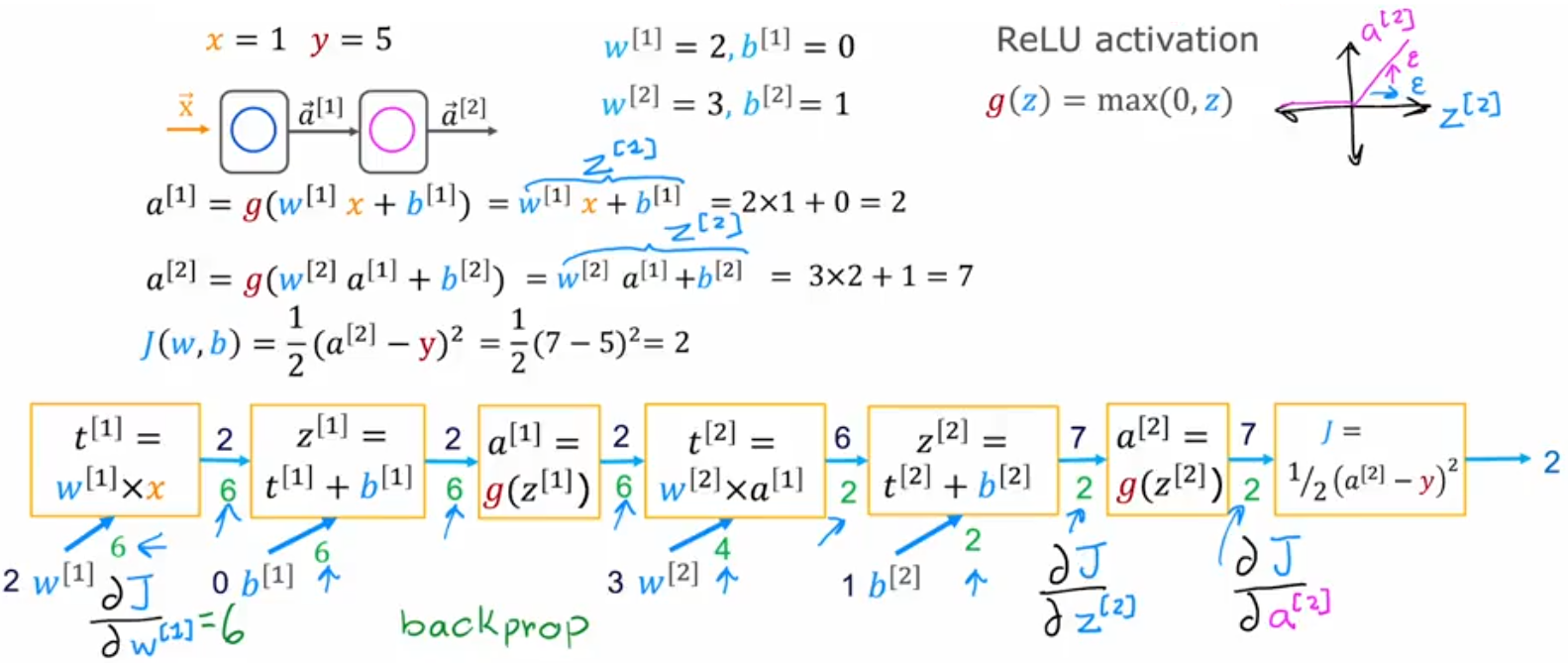

Course2-Week2-神经网络的训练方法

Course2-Week2-神经网络的训练方法 文章目录 Course2-Week2-神经网络的训练方法1. 神经网络的编译和训练1.1 TensorFlow实现1.2 损失函数和代价函数的数学公式 2. 其他的激活函数2.1 Sigmoid激活函数的替代方案2.2 如何选择激活函数2.3 为什么需要激活函数 3. 多分类问题和Softmax函数3.1 多分类问题3.2 逻辑回归的推广:S

如何进入训练模式_为何孩子学习痛苦又低效?巧用这2个训练方法,孩子学习更高效...

在孩子刚开始上小学的阶段,由于教育方式与幼儿园大不相同,孩子的基础参差不齐,有很多字不认识,就需要家长在一旁陪着写作业。 一开始孩子可能会因为新鲜,所以会主动积极要求父母陪着写作业,然后会过渡到父母每天要提醒孩子写作业,最后则是怎么叫孩子他都不愿意写作业。 这个时候就算开始写作业了,也会心思恍惚,各种拖延小动作,一边玩一边写,态度敷衍。用任何方法无法让孩子自己提起写作业的热情,即使父母想要用一些

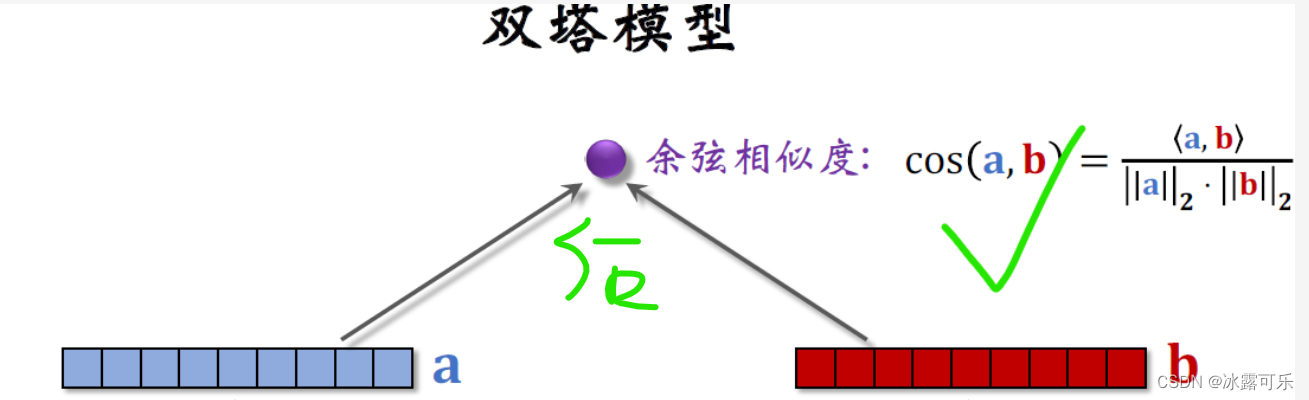

一文看懂推荐系统:召回06:双塔模型——模型结构、训练方法,召回模型是后期融合特征,排序模型是前期融合特征

一文看懂推荐系统:召回06:双塔模型——模型结构、训练方法,召回模型是后期融合特征,排序模型是前期融合特征 提示:最近系统性地学习推荐系统的课程。我们以小红书的场景为例,讲工业界的推荐系统。 我只讲工业界实际有用的技术。说实话,工业界的技术远远领先学术界,在公开渠道看到的书、论文跟工业界的实践有很大的gap, 看书学不到推荐系统的关键技术。 看书学不到推荐系统的关键技术。 看书学不到推荐系统的

X-VLM:多粒度视觉语言预训练方法

原文:Zeng, Yan, Xinsong Zhang and Hang Li. “Multi-Grained Vision Language Pre-Training: Aligning Texts with Visual Concepts.” ArXiv abs/2111.08276 (2021). 源码:https://github.com/zengyan-97/x-vlm 现有的视

对抗训练方法:保卫人工智能的盾牌

❤️觉得内容不错的话,欢迎点赞收藏加关注😊😊😊,后续会继续输入更多优质内容❤️ 👉有问题欢迎大家加关注私戳或者评论(包括但不限于NLP算法相关,linux学习相关,读研读博相关......)👈 (封面图由文心一格生成) 对抗训练方法:保卫人工智能的盾牌 在当今人工智能技术迅猛发展的时代,保护模型的鲁棒性和安全性变得尤为重要。对抗训练方法应运而生,