结巴专题

浅谈结巴分词:Boost库中的易上手分词工具

导语 之前在做自己的个人的“搜索引擎”项目的时候,遇到一个对于字符串分词的问题。对于待查询的字符串,进行的第一步操作就是要先分词。但是分词这个功能如果说要自己去实现的话,还是相当的复杂。为了能够在较短时间内完成好这个项目,所以就借用到了第三方boost库中的分词工具——结巴分词来完成这个分词模块的功能了。Boost库中的结巴分词很好上手,简单的看看readme文档和应用实例就能大致

jieba(结巴)分词种词性简介

jieba为自然语言语言中常用工具包,jieba具有对分词的词性进行标注的功能,词性类别如下: Ag 形语素 形容词性语素。形容词代码为 a,语素代码g前面置以A。 a 形容词 取英语形容词 adjective的第1个字母。 ad 副形词 直接作状语的形容词。形容词代码 a和副词代码d并在一起。 an 名形词 具有名词功能的形容词。形容词代码 a和名词代码n并在一

自然语言处理-结巴分词实践

文章目录 安装包方法1方法2 代码 安装包 方法1 首先安装jieba包,我用了虚拟环境首先激活到我自己的TensorFlow(为自己取名的包)环境中,然后pip install jiba 安装 activate TensorFlow 方法2 当然也可以直接在anaconda中进行安装 代码 导入包 import jieba text='我是练习时长两年半的

【马上NLP】jieba结巴分词工具常用功能详细介绍 笔记

【马上NLP】jieba结巴分词工具常用功能详细介绍 笔记 视频地址jieba安装功能分词四种分词模式对比:是否关闭发现新词: 词性标注关键词提取方式参数 载入词典 视频地址 图片与代码均源自up主和官方文档 https://www.bilibili.com/video/BV1xy4y187iC jieba官方文档 jieba安装 需要python3.7的版本 全自动安装

关键词抽取——结巴分词

结巴分词5--关键词抽取 作者:zhbzz2007 出处:http://www.cnblogs.com/zhbzz2007 欢迎转载,也请保留这段声明。谢谢! 1 简介 关键词抽取就是从文本里面把跟这篇文档意义最相关的一些词抽取出来。这个可以追溯到文献检索初期,当时还不支持全文搜索的时候,关键词就可以作为搜索这篇论文的词语。因此,目前依然可以在论文中看到关键词这一项。 除了这些,关键词还

jieba-fenci 结巴分词之词性标注实现思路 speechTagging segment

拓展阅读 DFA 算法详解 为了便于大家学习,项目开源地址如下,欢迎 fork+star 鼓励一下老马~ 敏感词 sensitive-word 分词 segment 词性标注 词性标注的在分词之后进行标注,整体思路也不难: (1)如果一个词只有一种词性,那么直接固定即可。 (2)如果一个词有多种词性,那么需要推断出最大概率的一种。 这个其实有些类似分词的时候做的事情,

分词工具 结巴个人词典构造

结巴 结巴 JIEBA项目github地址 训练数据 载入词典 开发者可以指定自己自定义的词典,以便包含 jieba 词库里没有的词。虽然 jieba 有新词识别能力,但是自行添加新词可以保证更高的正确率 用法: jieba.load_userdict(file_name) # file_name 为文件类对象或自定义词典的路径 词典格式和 dict.txt 一样,一个词占一行;每一

python中的jieba的作用_Python jieba结巴分词原理及用法解析

1、简要说明 结巴分词支持三种分词模式,支持繁体字,支持自定义词典 2、三种分词模式 全模式:把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义 精简模式:把句子最精确的分开,不会添加多余单词,看起来就像是把句子分割一下 搜索引擎模式:在精简模式下,对长词再度切分 # -*- encoding=utf-8 -*- import jieba if __name__ == '__

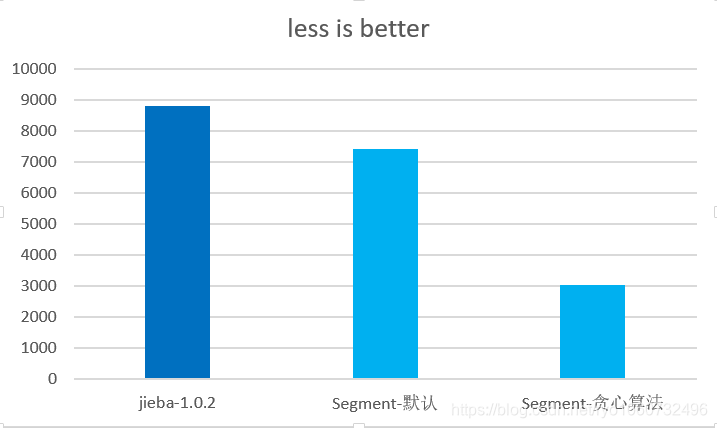

结巴分词 java 高性能实现,优雅易用的 api 设计,性能优于 huaban jieba 分词

Segment Segment 是基于结巴分词词库实现的更加灵活,高性能的 java 分词实现。 变更日志 创作目的 分词是做 NLP 相关工作,非常基础的一项功能。 jieba-analysis 作为一款非常受欢迎的分词实现,个人实现的 opencc4j 之前一直使用其作为分词。 但是随着对分词的了解,发现结巴分词对于一些配置上不够灵活。 (1)有很多功能无法指定关闭,比如

Java:java版结巴分词:jieba-analysis

文档 https://github.com/huaban/jieba-analysishttps://mvnrepository.com/artifact/com.huaban/jieba-analysis 依赖 <!-- https://mvnrepository.com/artifact/com.huaban/jieba-analysis --><dependency><groupId