分批专题

MyBatis-Plus通用中等、大量数据分批查询和处理方法

《MyBatis-Plus通用中等、大量数据分批查询和处理方法》文章介绍MyBatis-Plus分页查询处理,通过函数式接口与Lambda表达式实现通用逻辑,方法抽象但功能强大,建议扩展分批处理及流式... 目录函数式接口获取分页数据接口数据处理接口通用逻辑工具类使用方法简单查询自定义查询方法总结函数式接口

渲染十万条数据的方法之分批渲染

前言:前端渲染海量数据列表的情况可能不多,因为很多列表都采用了分页,但是在读写Excel表数据这种情况下,处理海量数据还是有可能会用到。渲染十万条数据,可以体现前端开发同学处理高性能渲染的能力,也是面试常常问到的问题。 对于一次性插入大量数据的情况,一般有两种做法: 分批渲染虚拟列表 本次对使用 分批渲染 的方式进行实现 分批渲染 React代码实现 requestAnimatio

Java 使用线程池和CountDownLatch分批插入或者更新数据

需求:在开发业务报表时,需要从MySQL数据库读取数据后进行操作,然后写入数据库,使用定时任务跑批。 分析:①兼顾性能,② MySQL没有Oracle那么方便、强大的存储过程。综上所述,使用线程池以分批提交的方案把数据插入MySQL数据库,对于更新操作、在Java端进行分页等的操作,本方案也支持。代码如下: /*** 分页操作数据*/@Slf4j@Componentpubli

集合数据分批添加,删除

分批次处理: 在处理大批量数据的时候一次性的插入或删除会对数据库造成压力(还有其他原因),我们分批处理, private static final int DELETE_COUNT_LIMIT =2000; if(!CollectionUtils.isEmpty(existTopicIds)){if (topicIds.size()>DELETE_COUNT_LIMIT){int size

android Listview分批加载+自动加载(改进版)(附源码下载)

这次在代码上比上一次改进了一些,并且加载完全部数据后会在lisview底部显示一个“已加载全部“的textview。大家可以对比我的上一篇博客 android Listview分批加载+自动加载(附源码下载)看看代码有啥不同 直接上代码: public class TestForListviewActivity extends Activity implementsOnScroll

数据批量导入时,加入队列,分批处理,只是个笔记

1,用到技术点:队列,线程,单例模式,分批处理 2,添加笔记代码: 入口: if(null != set && set.size() > 0){//异步,加入队列logger.info(String.format("加入队列,总共 %s 条数据", set.size()));TrackBusinessRunner trackBusinessRunner = TrackBusinessRun

多线程 分批调用方法接口

工具类 public abstract class BatchHandlerList<T> implements BatchHandlerInterface<T> {private static final Logger LOGGER = Logger.getLogger(BatchHandlerList.class);//每次处理条数private Integer perNum;privat

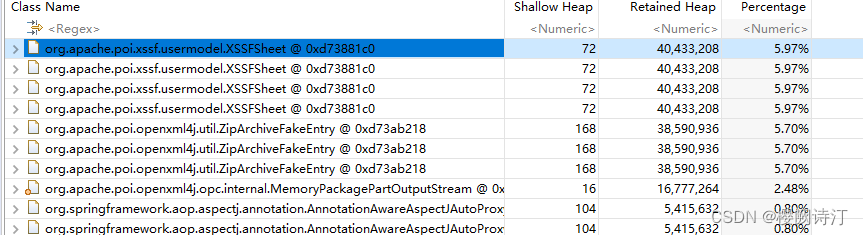

EasyExcel追加写入数据,分批查询多次写入场景下,注意使用方式【OOM警告】

使用.withTemplate(file) 将临时数据文件和真实数据文件合并的方式,在生产环境大批量数据下,完全不可取,有很高的内存溢出风险 伪代码 public static void writeAppend(String fileName) {String filePath = "tempDir".concat(File.separator).concat(fileName);F

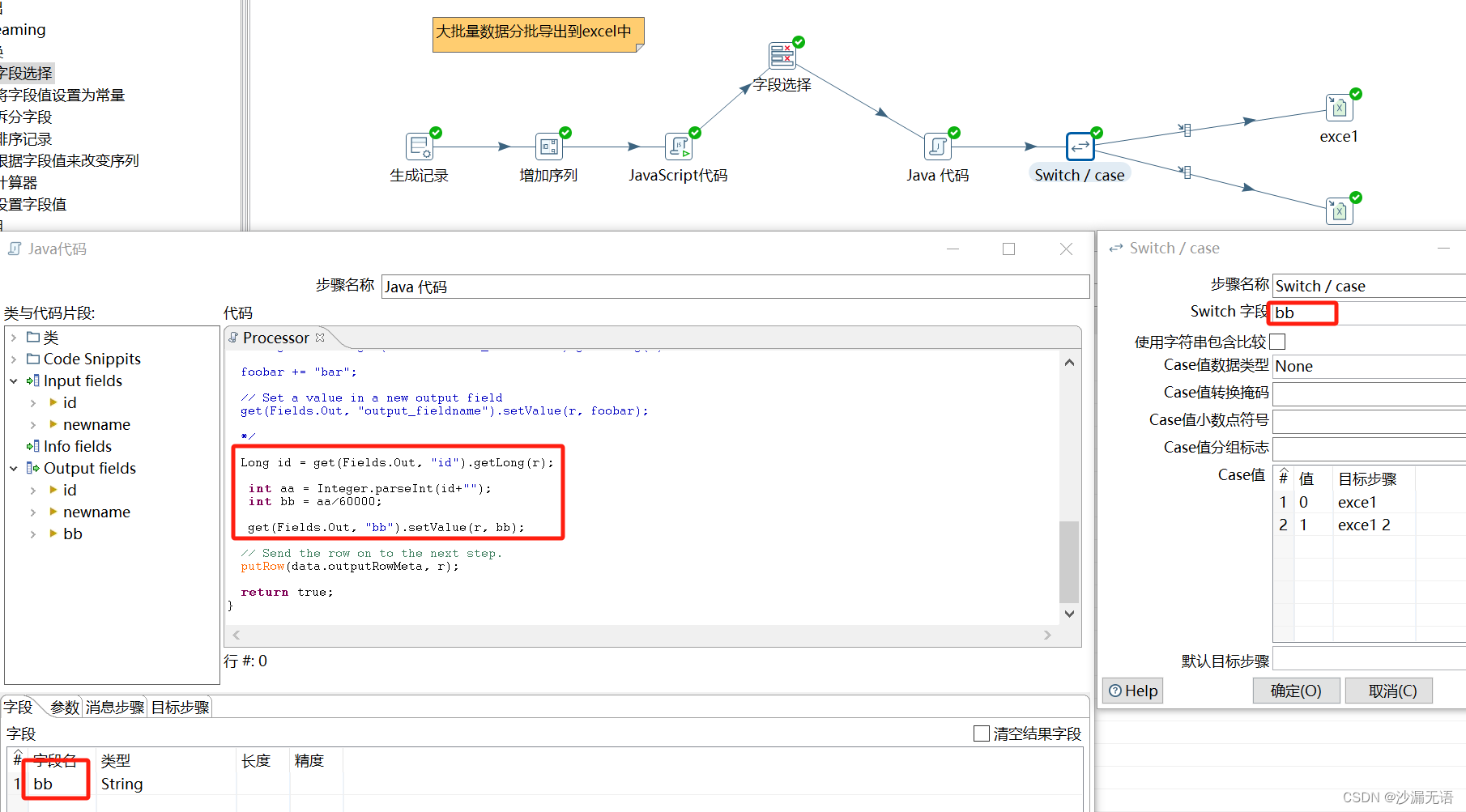

[自研开源] 数据集成之分批传输 v0.7

开源地址:gitee | github 详细介绍:MyData 基于 Web API 的数据集成平台 部署文档:用 Docker 部署 MyData 使用手册:MyData 使用手册 试用体验:https://demo.mydata.work 交流Q群:430089673 介绍 本篇基于 数据集成之任务流程 介绍任务分批传输的使用场景和配置操作。 使用场景 mydata使用API方式集成数

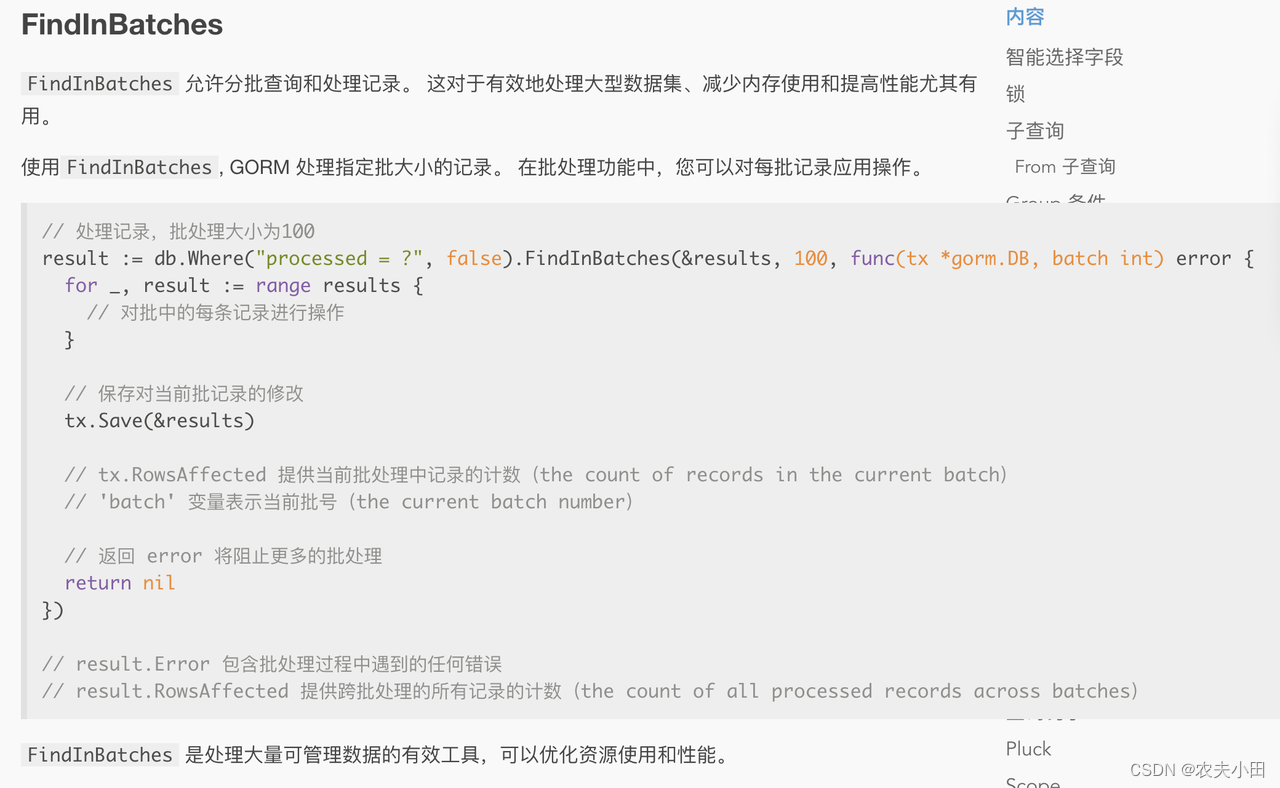

Golang Gorm 自动分批查询

场景: 目标查询全量数据,但需要每次Limit分批查询,保护数据库 文档: https://gorm.io/zh_CN/docs/advanced_query.html // Param: // dest 目标地址// batchSize 大小// fc 处理函数func (db *DB) FindInBatches(dest interface{}, ba

rxjava之数据分批加载

使用场景: 当从服务器请求的数据比较庞大时,这个时候,需要对数据进行分批处理,然后以当前的数据刷新界面 效果图: 原理分析图: 完整代码如下: mDataInfo = new DataInfo();List<Integer> objects = new ArrayList<>();for (int i = 0; i < 4000; i++) {objects.ad

js需要同时发起百条接口请求怎么办?--通过Promise实现分批处理接口请求

如何通过 Promise 实现百条接口请求? 实际项目中遇到需要批量发起上百条接口请求怎么办? 最新案例代码在此!点击看看 前言 不知你项目中有没有遇到过这样的情况,反正我的实际工作项目中真的遇到了这种玩意,一个接口获取一份列表,列表中的每一项都有一个属性需要通过另一个请求来逐一赋值,然后就有了这份封装真的是很多功能都是被逼出来的这份功能中要提醒一下:批量请求最关键的除了分批功能之外,适当

mysql 大数据量分批添加索引

先在测试环境测试,没问题再上生产环境,避免生产环境数据库负载过多而崩溃 创建存储过程 DELIMITER //CREATE PROCEDURE batch_add_index_to_email()BEGINDECLARE done INT DEFAULT FALSE;DECLARE start_id INT DEFAULT 0;DECLARE end_id INT;DECLARE batch

深度学习-Pytorch数据集构造和分批加载

深度学习-Pytorch数据集构造和分批加载 pytorch 目前在深度学习具有重要的地位,比起早先的caffe,tensorflow,keras越来越受到欢迎,其他的深度学习框架越来越显得小众。 数据分析 数据分析-Pandas如何转换产生新列 数据分析-Pandas如何统计数据概况 数据分析-Pandas如何轻松处理时间序列数据 数据分析-Pandas如何选择数据子集 数据分析-

使用 CompletableFuture 分批处理任务

一、无返回值任务函数 // 数据分批List<List<StatisticsDTO>> batches = Lists.partition(statisticsList, BATCH_SIZE);List<CompletableFuture<Void>> futures = new ArrayList<>(batches.size());// 数据处理for (int i = 0; i <

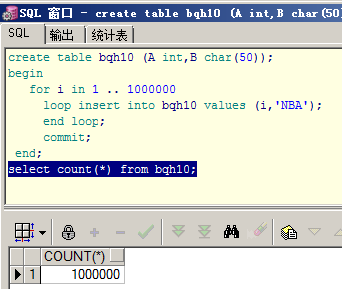

oracle千万数据分批插入,orcle 如何快速插入百万千万条数据

有时候做实验测试数据用到大量数据时可以用以下方法插入: 方法一:使用xmltable create table bqh8 as select rownum as id from xmltable('1 to 10000000'); select count(*) from bqh8; -----------------------一千万条数据已插入。 方法二:使用dual+connect by

easyExcel实现分批导入,动态表头分批导出,以及导出表格样式设置

<dependency><groupId>com.alibaba</groupId><artifactId>easyexcel</artifactId><version>2.2.6</version></dependency> 一,分批导入 1.首先配置表格头映射类 @Getter@Setter@EqualsAndHashCodepublic class IndexOr

easyExcel实现分批导入,动态表头分批导出,以及导出表格样式设置

<dependency><groupId>com.alibaba</groupId><artifactId>easyexcel</artifactId><version>2.2.6</version></dependency> 一,分批导入 1.首先配置表格头映射类 @Getter@Setter@EqualsAndHashCodepublic class IndexOr

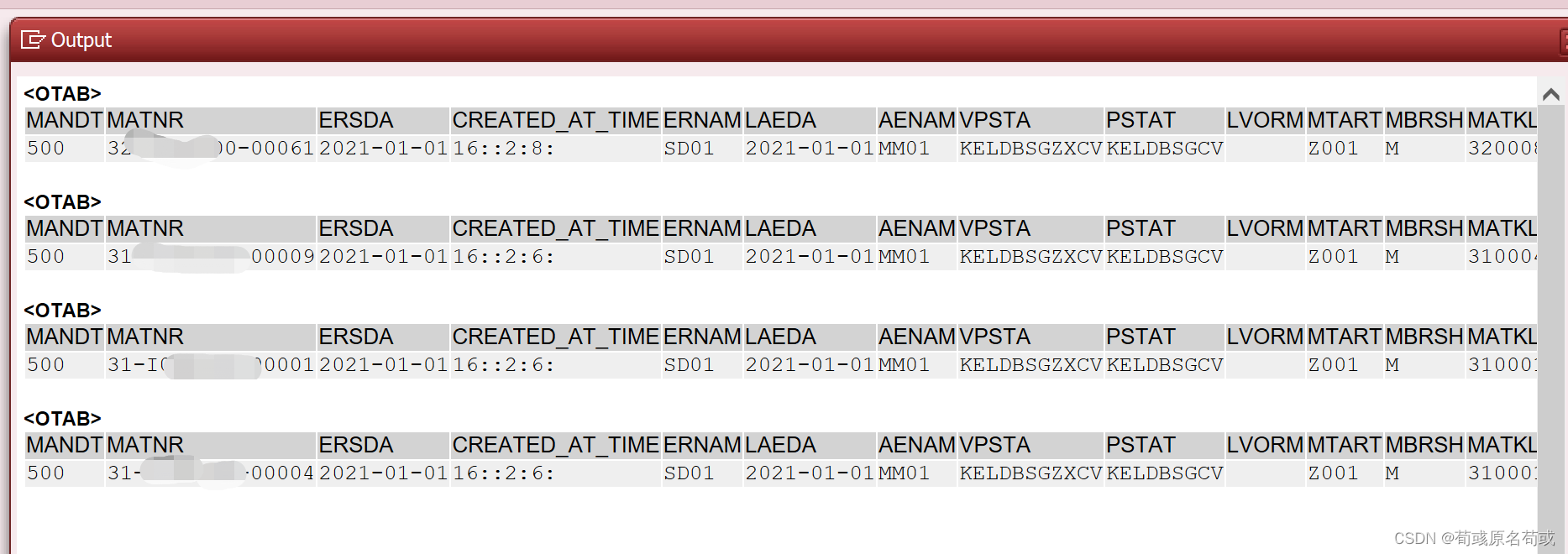

SAP 通过游标来分批从数据库表读取2G数据

原文链接:https://blog.csdn.net/Buffalo_soldier/article/details/109772612 我们在写程序的时候可能会遇到用内表处理超大量数据的情况,比如取MSEG、BSEG表,内表里的数据如果超过2G就会报程序dump了,所以关键是要控制内表的数据量。 以下载一个系统表的数据为例,选择界面输入系统表名,用户点执行则将系统表数据下载到本地或进行其他处理

![[自研开源] 数据集成之分批传输 v0.7](https://img-blog.csdnimg.cn/direct/cc203271f1e94b9186cd195781d39c03.png)