六十四专题

(六十四)第 10 章 内部排序(静态链表的插入排序)

示例代码 staticLinkList.h // 静态链表的插入排序实现头文件#ifndef STATIC_LINK_LIST_H#define STATIC_LINK_LIST_H#include "errorRecord.h"#define SIZE 100#define NUM 8typedef int InfoType;typedef int KeyType;ty

Flink实例(六十四): :Flink的重启策略(二)

重启策略 Flink何时才会重启? 一个拥有检查点的应用如果出现问题,他会经过一些列步骤来进行重启。重启过程中可能会出现的问题? 有些时候,应用可能会被相同的故障不断“杀死”举例: 当我处理数据的时候程序出现了Bug,导致处理算子出现异常,此时程序就会陷入一个循环中: 启动任务、恢复状态、继续处理。 在继续处理的时候,由于这个Bug没有被修复,然后 启动任务、恢复状态、继续处理。

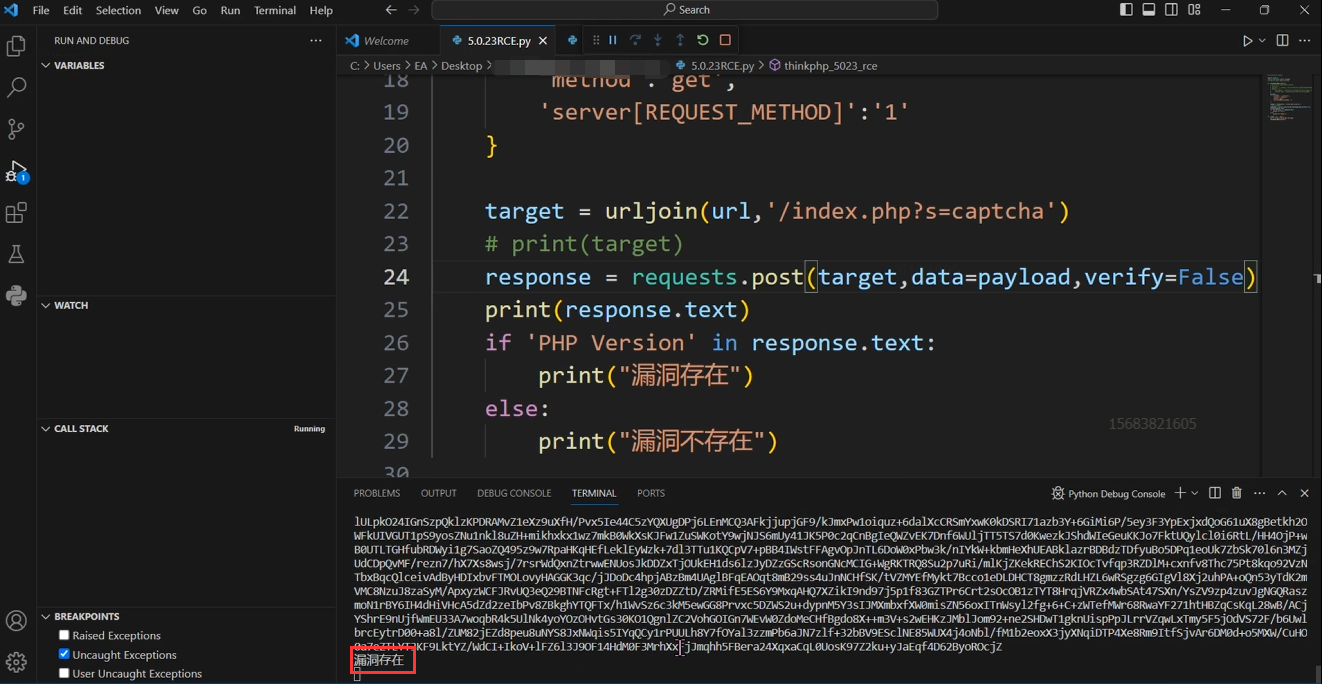

Python武器库开发-武器库篇之ThinkPHP 5.0.23-RCE 漏洞复现(六十四)

Python武器库开发-武器库篇之ThinkPHP 5.0.23-RCE 漏洞复现(六十四) 漏洞环境搭建 这里我们使用Kali虚拟机安装docker并搭建vulhub靶场来进行ThinkPHP漏洞环境的安装,我们进入 ThinkPHP漏洞环境,可以 cd ThinkPHP,然后通过 ls 查看可以搭建的靶场,目前 vulhub关于 ThinkPHP漏洞。可以搭建的靶场有五个。我们拿 5.0.

C语言试题六十四之请编写函数fun:求勾股数

📃个人主页:个人主页 🔥系列专栏:C语言试题200例目录 💬推荐一款刷算法、笔试、面经、拿大公司offer神器 👉 点击跳转进入网站 ✅作者简介:大家好,我是码莎拉蒂,CSDN博客专家(全站排名Top 50),阿里云博客专家、51CTO博客专家、华为云享专家 1、题目 请编写函数fun,其功能时:求100以内的所有勾股数。 所谓勾股数,是指能够构成直角三角形三条边的三个正整

在framework和hal添加log(六十四)

在framework和hal添加log 1.在Android.mk添加LOCAL_PATH:= $(call my-dir) include $(CLEAR_VARS) LOCAL_C_INCLUDES:= $(LOCAL_PATH)/includeLOCAL_SRC_FILES:= test.cLOCAL_M

Ubuntu18.04关闭docker开机自启动(六十四)

第一种方式:systemctl启动方式 1.查看docker服务是否开机启动# sudo systemctl list-unit-files | grep enable|grep dockersnap-docker-796.mount enabled snap.docker.dockerd.service

SpringBoot 系列教程(六十四):Spring Boot 中的静态资源到底要放在哪里?

转自江南一点雨:http://springboot.javaboy.org/2019/0408/springboot-static-resources 一、Spring Boot 中的静态资源到底要放在哪里? 当我们使用 SpringMVC 框架时,静态资源会被拦截,需要添加额外配置,之前老有小伙伴在微信上问松哥Spring Boot 中的静态资源加载问题:“松哥,我的HTML页面好像没有样式

Android14音频进阶:AudioFlinger向HAL输出数据过程(六十四)

简介: CSDN博客专家,专注Android/Linux系统,分享多mic语音方案、音视频、编解码等技术,与大家一起成长! 优质专栏:Audio工程师进阶系列【原创干货持续更新中……】🚀 优质专栏:多媒体系统工程师系列【原创干货持续更新中……】🚀 人生格言: 人生从来没有捷径,只有行动才是治疗恐惧和懒惰的唯一良药. 更多原创,欢迎关注:Android系统攻城狮

Lua程序设计(六十四)

控制垃圾收集的步长 通过函数collectgarbage可以对垃圾收集器进行一些额外的控制,该函数实际上是几个函数的集合体:第一个参数是可选的字符串,用来说明进行何种操作;有些选项使用一个整形作为第二个参数,称为data。 第一个参数的选项有以下七个。 ”stop": 停止垃圾收集器,使用选项"restart"再次调用collectgarbage。 “restart”: 重启垃圾收集器。

Spring Boot(六十四):获取 Spring Boot 应用进程的 PID

1 ApplicationPidFileWriter ApplicationPidFileWriter 是 Spring Boot 提供的一个 Listener,它可以在应用启动后把 PID 写入到指定的文件。 它需要在启动前,通过编程式配置到应用中,并且需要在配置文件中指定要写入 PID 的文件。 2 配置 ApplicationPidFileWriter 监听器 在启动前,配置 App

易经六十四卦零基础入门,易经学习从初级到高级教学

一、教程描述 本套教程由浅入深,分为四个阶段,初级班,基础班,中级班,高级班,共有108个课时,除了视频教程以外,易经课程笔记1和2,也是经过精心整理的,值得认真研究学习。本套易经教程,大小26.93G,共有208个文件。 二、教程目录 01-易经完全通-初级班(共25课时) 02-易经完全通-基础班(共13课时) 03-易经完全通-中级班(共36课时) 04-易经完全通-高级班(共

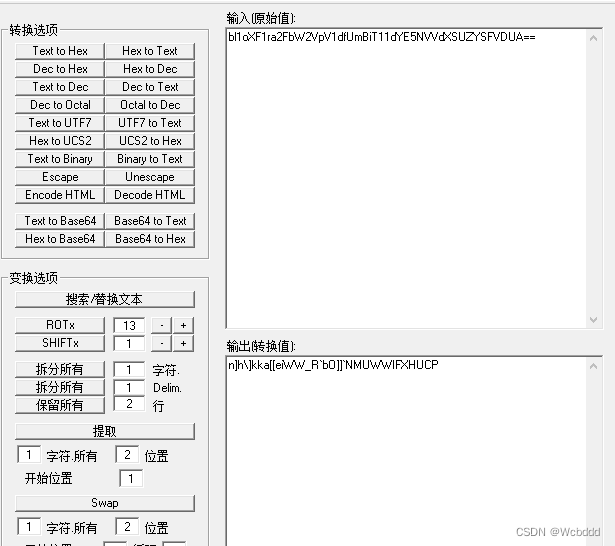

CRYPTO-2BJDCTF2020-伏羲六十四卦

0x00 前言 CTF 加解密合集CTF Web合集网络安全知识库溯源相关 文中工具皆可关注 皓月当空w 公众号 发送关键字 工具 获取 0x01 题目 这是什么,怎么看起来像是再算64卦!!!密文:升随临损巽睽颐萃小过讼艮颐小过震蛊屯未济中孚艮困恒晋升损蛊萃蛊未济巽解艮贲未济观豫损蛊晋噬嗑晋旅解大畜困未济随蒙升解睽未济井困未济旅萃未济震蒙未济师涣归妹大有嗯?为什么还有个b呢?b=7fl

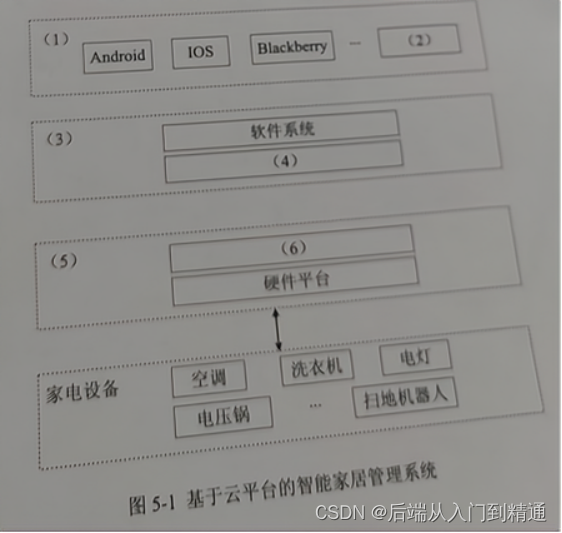

面向服务架构-架构师(六十四)

SOA概述和发展、参考架构、协议和规范、标准和原则、设计模式、构件和实施。 SOA概述和发展 服务指系统对外提供的功能,SOA是一种应用框架。 微服务去掉了ESB企业服务总线,SOA集中式,SOA和微服务的区别: 微服务更加精细。服务器接口方式更加通用化,例如HTTP服务器更倾向于分布式去中心化部署方式。 SOA以企业服务总线连接各个子系统。 参考架构 服务如何被组合在一起完

RUP核心工作流2021-架构师(六十四)

1、根据传统的软件生命周期方法学,可以把软件生命周期划分为()。 A、软件定义、软件开发、软件测试、软件维护 B、软件定义、软件开发、软件运行、软件维护 C、软件分析、软件设计、软件开发、软件维护 D、需求获取、软件设计、软件开发、软件测试 答案:B 解析: 定义,开发,运行,维护 SDN的网络架构中不包含()。 逻辑层控制层转发层应用层 答案:A 解析: 既然是网络架

面向服务架构-架构师(六十四)

SOA概述和发展、参考架构、协议和规范、标准和原则、设计模式、构件和实施。 SOA概述和发展 服务指系统对外提供的功能,SOA是一种应用框架。 微服务去掉了ESB企业服务总线,SOA集中式,SOA和微服务的区别: 微服务更加精细。服务器接口方式更加通用化,例如HTTP服务器更倾向于分布式去中心化部署方式。 SOA以企业服务总线连接各个子系统。 参考架构 服务如何被组合在一起完

NLP(六十四)使用FastChat计算LLaMA-2模型的token长度

LLaMA-2模型部署 在文章NLP(五十九)使用FastChat部署百川大模型中,笔者介绍了FastChat框架,以及如何使用FastChat来部署百川模型。 本文将会部署LLaMA-2 70B模型,使得其兼容OpenAI的调用风格。部署的Dockerfile文件如下: FROM nvidia/cuda:11.7.1-runtime-ubuntu20.04RUN apt-get up