xlnet专题

自然语言处理(NLP)-预训练模型:别人已经训练好的模型,可直接拿来用【ELMO、BERT、ERNIE(中文版BERT)、GPT、XLNet...】

预训练模型(Pretrained model):一般情况下预训练模型都是大型模型,具备复杂的网络结构,众多的参数量,以及在足够大的数据集下进行训练而产生的模型. 在NLP领域,预训练模型往往是语言模型,因为语言模型的训练是无监督的,可以获得大规模语料,同时语言模型又是许多典型NLP任务的基础,如机器翻译,文本生成,阅读理解等,常见的预训练模型有BERT, GPT, roBERTa, transf

20 项任务全面碾压 BERT,CMU 全新 XLNet 模型屠榜,代码已开源!

BERT 带来的影响还未平复,CMU 与谷歌大脑提出的 XLNet 在 20 个任务上超过了 BERT 的表现,并在 18 个任务上取得了当前最佳效果。令人激动的是,目前 XLNet 已经开放了训练代码和大型预训练模型,这又可以玩一阵了~ 转载来源 公众号:机器之心 “ 阅读本文大概需要 5 分钟。 ” 2018 年,谷歌发布了基于双向 Transformer 的大规模预训练语言模型 B

语境化语言表示模型-ELMO、BERT、GPT、XLnet

一.语境化语言表示模型介绍 语境化语言表示模型(Contextualized Language Representation Models)是一类在自然语言处理领域中取得显著成功的模型,其主要特点是能够根据上下文动态地学习词汇和短语的表示。这些模型利用了上下文信息,使得同一词汇在不同语境中可以有不同的表示。以下是一些著名的语境化语言表示模型: ELMo(Embeddings from Lan

第11章: 挑战BERT地位的Autoregressive语言模型XLNet剖析及源码完整实现

1,作为Autoregressive语言模型的XLNet何以能够在发布时在20个语言任务上都能够正面挑战作为Autoencoding与训练领域霸主地位的BERT? 2,XLNet背后Permutation LM及Two-stream self-attention数学原理解析 3,Autoregressive LM和Autoencoding LM数学原理及架构对比 4,Denoising au

从xlnet预训练数据集中获取词向量

如下展示了从XLNET预训练数据集中提取词向量的方法。 利用pytorch-transformers中的方法进行预训练模型加载,然后进行词向量的获取和提取。

NLP-预训练模型:迁移学习(拿已经训练好的模型来使用)【预训练模型:BERT、GPT、Transformer-XL、XLNet、RoBerta、XLM、T5】、微调、微调脚本、【GLUE数据集】

深度学习-自然语言处理:迁移学习(拿已经训练好的模型来使用)【GLUE数据集、预训练模型(BERT、GPT、transformer-XL、XLNet、T5)、微调、微调脚本】 一、迁移学习概述二、NLP中的标准数据集1、GLUE数据集合的下载方式2、GLUE子数据集的样式及其任务类型2.1 CoLA数据集【判断句子语法是否正确】2.2 SST-2数据集【情感分类】2.3 MRPC数据集【判断

XLNet: 通用自回归预训练语言理解(Generalized Autoregressive Pretraining for Language Understanding)

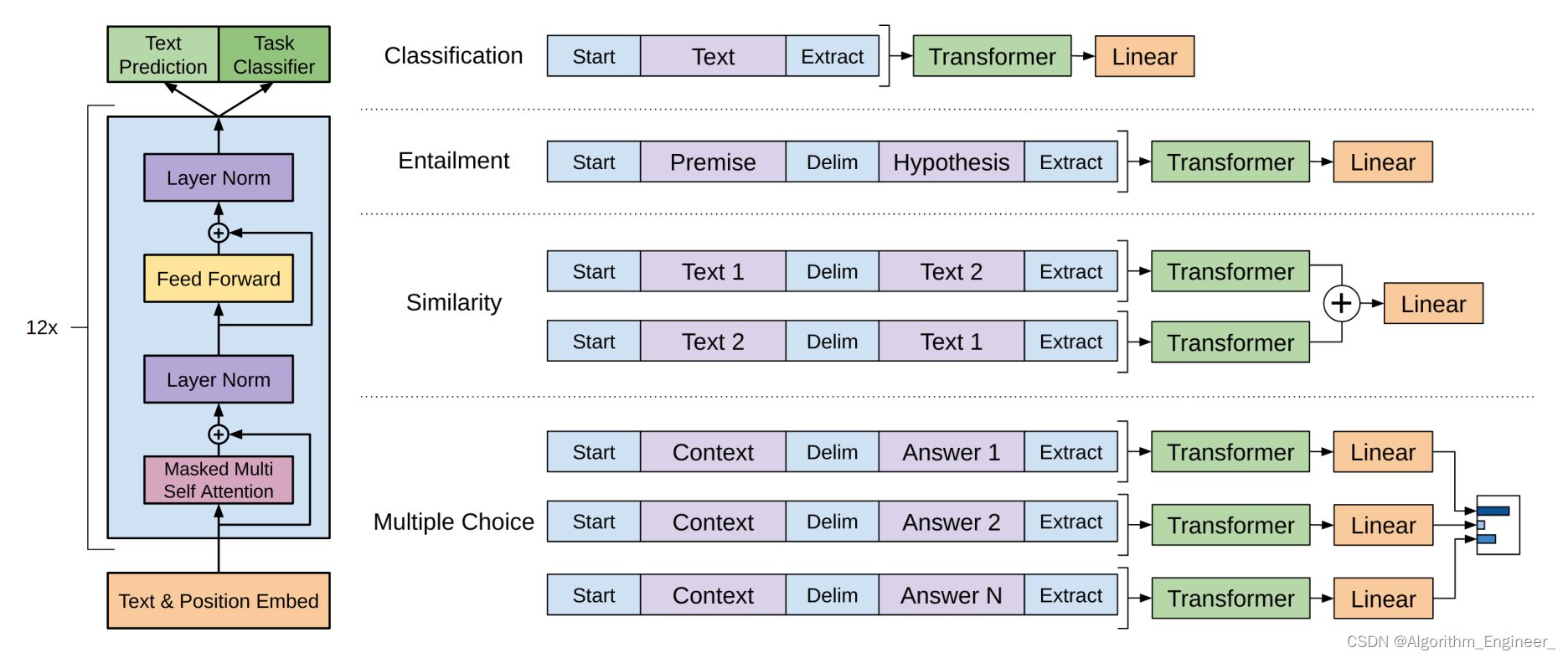

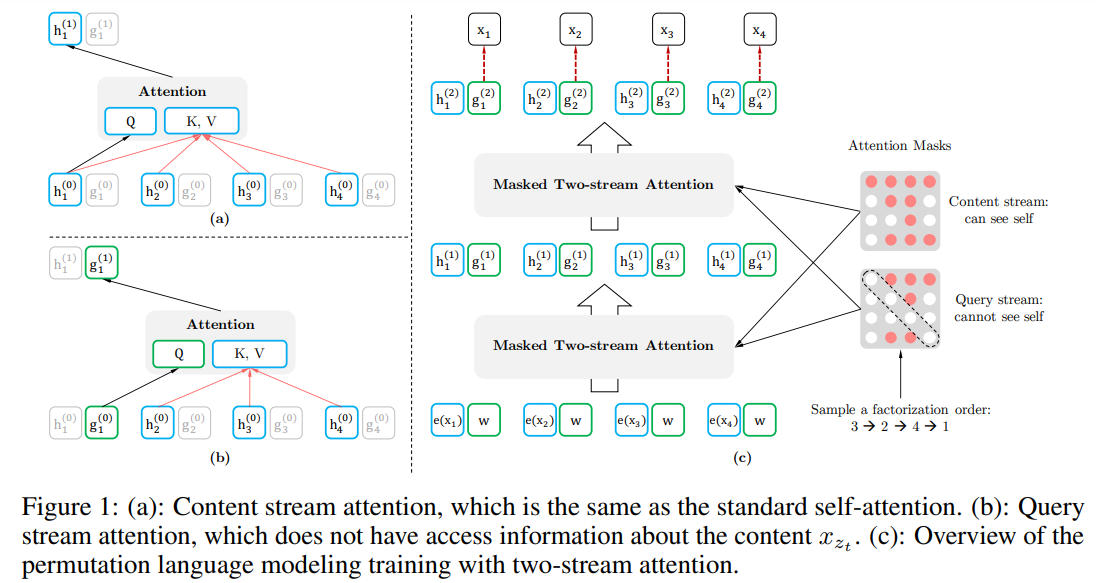

文章目录 引言提出的方法背景目标:排列语言模型结构:基于目标感知的双流注意力融合Transformer-XL多句建模讨论 Reference: 1. XLNet: Generalized Autoregressive Pretraining for Language Understanding 2. XLNet原理解读 引言 AR模型以前向或后向的单向方式建模语言模型

百度ERNIE 2.0强势发布!16项中英文任务表现超越BERT和XLNet

欢迎关注【百度NLP】官方微信公众号,及时获取更多自然语言处理领域的技术干货! 阅读原文:https://mp.weixin.qq.com/s/43UBYDpYd4pd3fZXYPJWUw 2019年3月,百度正式发布NLP模型ERNIE,其在中文任务中全面超越BERT一度引发业界广泛关注和探讨。 今天,经过短短几个月时间,百度ERNIE再升级。发布持续学习的语义理解框架ERNIE 2.0,

百度 ERNIE 2.0强势发布!16项中英文任务表现超越 BERT 和 XLNet

2019年3月,百度正式发布 NLP 模型 ERNIE,其在中文任务中全面超越 BERT 一度引发业界广泛关注和探讨。 今天,经过短短几个月时间,百度 ERNIE 再升级。发布持续学习的语义理解框架 ERNIE 2.0,及基于此框架的 ERNIE 2.0预训练模型。继1.0后,ERNIE 英文任务方面取得全新突破,在共计16个中英文任务上超越了 BERT 和 XLNet, 取得了 SOTA 效果