sqoop专题

【hadoop Sqoop】Sqoop从mysql导数据到hdfs

1.下载sqoop安装包 wget https://mirrors.tuna.tsinghua.edu.cn/apache/sqoop/1.4.6/sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz 2.解压安装包 tar -xzvf /sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz 3.配置hadoop mv s

【硬刚Hive】Hive面试题(3):如何用sqoop将hive中分区表的分区字段导入到MySQL中

问题分析: 1.hive中分区表其底层就是HDFS中的多个目录下的单个文件,hive导出数据本质是将HDFS中的文件导出 2.hive中的分区表,因为分区字段(静态分区)不在文件中,所以在sqoop导出的时候,无法将分区字段进行直接导出 思路:在hive中创建一个临时表,将分区表复制过去后分区字段转换为普通字段,然后再用sqoop将tmp表导出即实现需求 步凑如下: 1.创建目标表(

Sqoop 数据迁移

Sqoop 数据迁移 一、Sqoop 概述二、Sqoop 优势三、Sqoop 的架构与工作机制四、Sqoop Import 流程五、Sqoop Export 流程六、Sqoop 安装部署6.1 下载解压6.2 修改 Sqoop 配置文件6.3 配置 Sqoop 环境变量6.4 添加 MySQL 驱动包6.5 测试运行 Sqoop6.5.1 查看Sqoop命令语法6.5.2 测试数据库连接

Sqoop部署和基本操作

目录 一、说明二、部署三、常用命令 一、说明 数据导入(Import): Sqoop可以从关系型数据库(如MySQL、PostgreSQL、Oracle等)中抽取数据,并将其导入到Hadoop的HDFS中,存储为各种格式(如文本文件、Avro、Parquet等)供后续处理和分析使用。 导入过程中,Sqoop支持将数据直接导入到Hive表中,从而方便地进行SQL查询和分析。

大数据-ETL工具:Sqoop【关系型数据库(MySQL,Oracle...) <==(业务)数据==> Hive/HBase/HDFS】【Hadoop与关系数据库之间传送数据的工具】

我们常用的 ETL 工具有Sqoop、Kettle、Nifi: Kettle虽然功能较完善,但当处理大数据量的时候瓶颈问题比较突出;NiFi的功能强大,且支持大数据量操作,但NiFi集群是独立于Hadoop集群的,需要独立的服务器来支撑,强大也就意味着有上手门槛,学习难度大,用人成本高;Sqoop专为关系型数据库和Hadoop之间的ETL而生,支持海量数据,符合项目的需求,且操作简单门槛低。

大数据-案例-离线数仓-在线教育:MySQL(业务数据)-ETL(Sqoop)->Hive数仓【ODS层-数据清洗->DW层(DWD-统计分析->DWS)】-导出(Sqoop)->MySQL->可视化

一、商业BI系统概述 商业智能系统,通常简称为商业智能系统,是商业智能软件的简称,是为提高企业经营绩效而采用的一系列方法、技术和软件的总和。通常被理解为将企业中的现有数据转换为知识并帮助企业做出明智的业务决策的工具。 BI系统中的数据来自企业的其他业务系统。例如,一个面向业务的企业,其业务智能系统数据包括业务系统订单、库存、交易账户、客户和供应商信息,以及企业所属行业和竞争对手的数据,以及其他

Hadoop详解(五)——ZooKeeper详解,ZooKeeper伪分布搭建和集群搭建,Hadoop集群搭建,sqoop工具的使用

ZooKeeper简介 什么是ZooKeeper? ZooKeeper是Google的Chubby一个开源的实现,是Hadoop分布式协调服务。 它包含了一个简单的原语集,分布式应用程序可以基于它实现同步服务,配置维护和命令服务等。 它的结构图如下: ZooKeeper集群搭建的要求:必须要有奇数台。如果想让ZooKeeper既具有高效性,又能正常工作,只要

sqoop import and export

[b]import:[/b] sqoop import connect jdbc:mysql://mysql.example.com/sqoop --username sqoop --password sqoop --table cities --connect:指定JDBC URL --username/password:mysql数据库的用户名 --table:要读取的

利用 Sqoop 对关系型数据库 与 非关系型数据库,分布式等数据库之间进行数据迁移

基本流程图如下: 命令如下: Mysql导入Hive 1 1.1.表不存在则创建,并且加了where条件 sqoop import --connect jdbc:mysql://ip:port/db_name --username user_name --password password -m 4 --table mysql_table_name --hive-impo

Sqoop学习笔记 --- python保存 Sqoop 打印的信息

对于使用 Sqoop1 的人来说,想获取 Sqoop 打印的 MR 信息是一件头疼的事情, 但是使用Python进行编程,调用Sqoop命令,就会解决这个问题, 这里我们可以使用 python 的 commands 模块,具体如下: Demo: import commandsstatus, res = commands.getstatusoutput("sqoop i

解决Sqoop传输数据过程中的字段数异常

问题描述 在使用Sqoop将数据表导入到HDFS,再将HDFS的表文件导出时,往往会出现无法解析xxx值的错误,这种情况往往是该行的字段数异常(多或少)导致。 解决方案 写个简单的程序,将字段数异常的行找出来。 测试数据 1 aa bb cc2 fjd fjasl jfals3 jfas fda jjfas jald4 fjd fjasl jfals5 fjd fja

sqoop的安装配置

1. 上传并解压安装包 tar -zxvf sqoop-1.4.7.bin__hadoop-2.6.0.tar.gz -C ../server/ 重命名:mv sqoop-1.4.7.bin__hadoop-2.6.0 sqoop 2. 配置环境变量 sudo vim /etc/profile # 配置sqoop的环境变量 export SQOOP_HOME=/export/se

sqoop 使用过程中提供密码的几种方式详解

概述 本博文基于Sqoop1.4.6版本讲解在使用Sqoop工具从关系型数据库中导入导出数据过程中管理关系型数据库密码的几种方式。 这里我们通过讲解sqoopimport命令来说明: sqoop import在实际应用中主要用于将数据从关系型数据库(比如MySQL,SqlServer,Oracle等)导入到大数据集群文件系统(比如HDFS文件系统,HBase列式存储系统以及H

使用Sqoop遇到的问题

1. 导入MySQL的值为\N MySQL中的内容 Hive中的内容 解决办法:加入--input-null-string "\\\\N" --input-null-non-string "\\\\N" sqoop export --connect "jdbc:mysql://1.1.1.1:3306/monitor_center?Unicode=true&characte

用sqoop实现mysql和hive数据互导

在此测试的是伪分布式 hadoop1.2.1 sqoop-1.4.4.bin__hadoop-1.0.0 hive-0.12.0 1、数据准备 1.1建立测试用户sqoop grant all privileges on *.* to 'sqoop'@'%' identified by 'sqoop' with grant option; 注意:这一步不是必须,也可以在mysq

用Sqoop进行Mysql 与HDFS / Hbase的互导数据

1、建立测试用户sqoop,并在测试用户下建立数据哭sqoop和测试数据表employee 在Mysql中创建一个用户名:sqoop,密码:sqoop,并授权 grant all privileges on *.* to 'sqoop'@'%' identified by 'sqoop' with grant option; 可以在Linux命令行(不

Sqoop批量把MySQL数据导入到HBase

一、简介 只是为了方便 二、Sqoop安装 https://blog.csdn.net/u011374856/article/details/ 三、MySQL单表导入HBase 1、新建脚本 vi mysql_hbase.sh 2、编辑脚本,两个参数,第一个HBase表名称前缀(方便批量删除),第二个MySQL表名称 $SQOOP_HOME/bin/sqoop import \-

Liunx安装Sqoop及简单使用

一、简介 sqoop是apache旗下一款“Hadoop和关系数据库服务器之间传送数据”的工具。 可以将一个关系型数据库(例如 : MySQL ,Oracle 等)中的数据导进到Hadoop的HDFS、HIVE、HBASE中。 也可以将Hadoop的HDFS、HIVE、HBASE的数据导进到关系型数据库中。 官网:http://sqoop.apache.org 二、准备工作 1、安装h

Sqoop安装及测试

1.${SQOOP_HOME}/conf/ $ cp sqoop-env-template.sh sqoop-env.sh //拷贝模板生成配置环境目录 =============修改sqoop-env.sh 配置文件 #Set path to where bin/hadoop is available export HADOOP_COMMON_HOME=/opt/mo

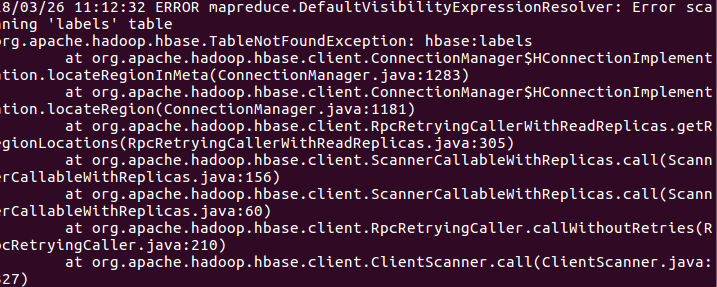

Sqoop数据导入到HBase遇上的问题及解决方法

运行bin/sqoop import --connect jdbc:mysql://ip:port/database --username *** --password ****--hbase-bulkload --hbase-create-table --column-family info --hbase-row-key username --hbase-table detects --tab

Sqoop与Shell脚本数据迁移实战

文章目录 前言一、sqoop实战示例1. 获取所有数据库2. 获取指定数据库的所有表3. 查询数据4. 把指定数据库的所有表导入指定hive数据库5. 把指定表导入hive数据库的指定表6. 查询数据导入到指定表 二、shell脚本实战示例1. shell脚本2. 解释 总结 前言 在数据驱动的时代,高效准确地迁移数据是每个数据工程师不可或缺的技能。本教程将深入探讨如何使用S

Sqoop的安装与测试

这里写目录标题 什么是Sqoop?Sqoop的安装与配置安装测试 什么是Sqoop? Sqoop就是hadoop和mysql的一个中间介质 , 作用就是可以将hadoop中的数据传到mysql中 , 或将mysql中的数据导入到hadoop中 Sqoop的安装与配置 安装 详细代码 //解压安装[root@hadoop soft]# tar -zxvf sqoop-1

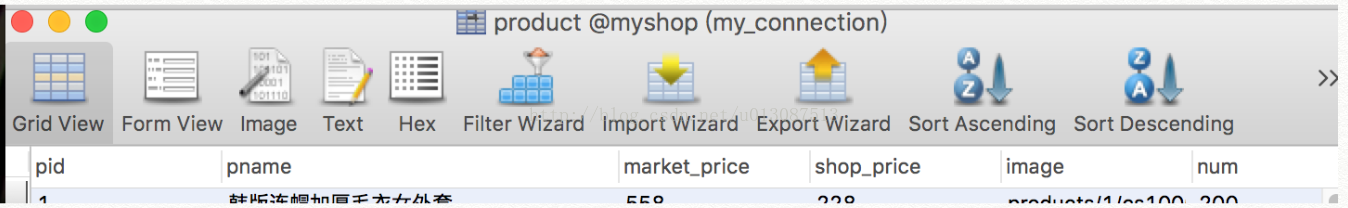

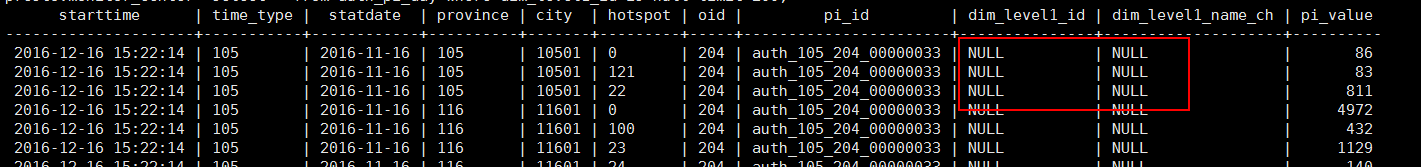

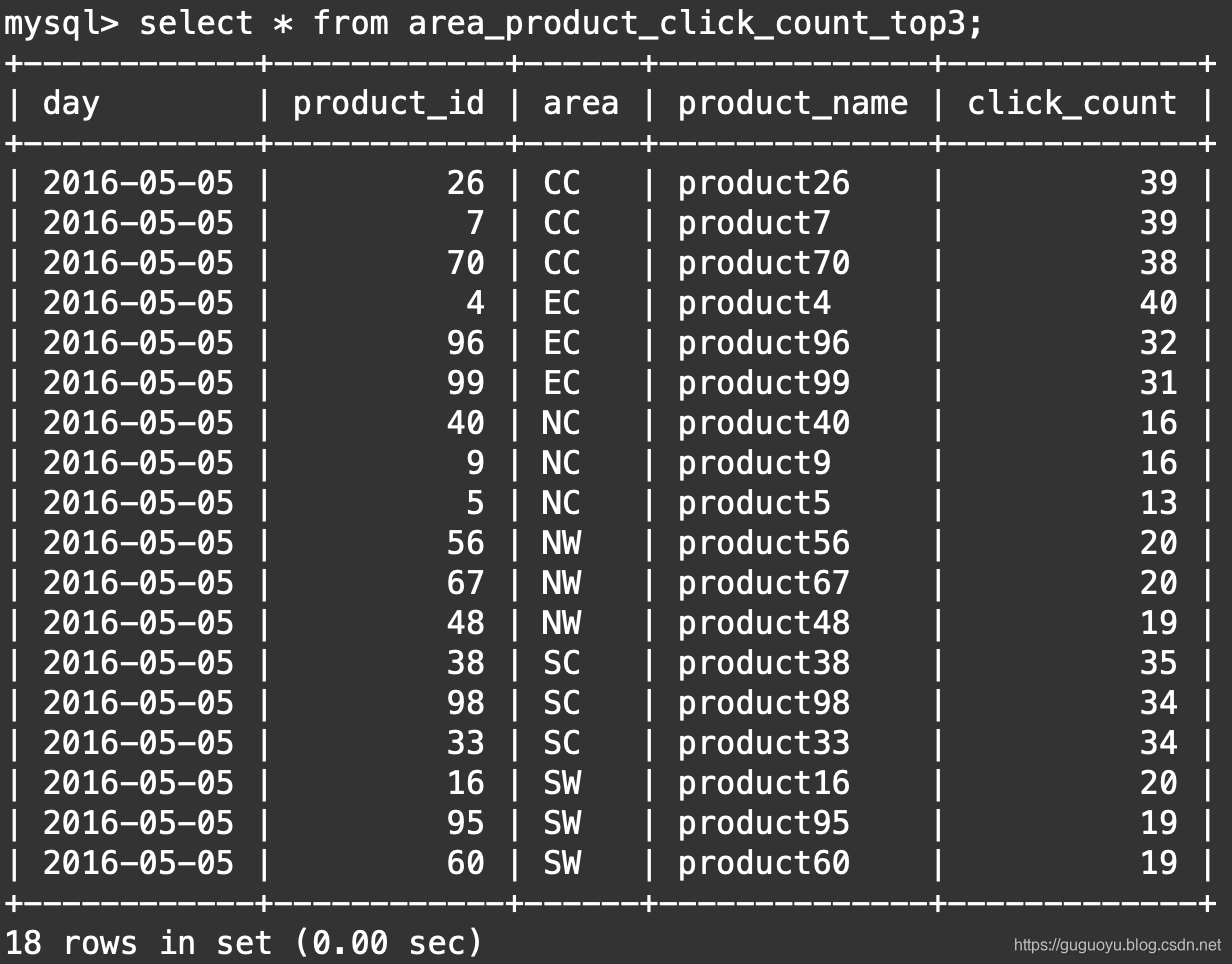

Hive、MySQL、Sqoop求TOP N

文章目录 一 数据说明二 分析三 Sqoop3.1 什么是Sqoop3.2 Sqoop部署3.3 Sqoop简单应用3.4 Sqoop import HDFS3.5 Sqoop import Hive 四 Hive中查询top3五 数据导出MySQL 一 数据说明 目前我们有三张表 1.位于MySQL的city_info表, product_info表 2.位于Hive的use

Hadoop 3.4.0+HBase2.5.8+ZooKeeper3.8.4+Hive+Sqoop 分布式高可用集群部署安装 大数据系列二

创建服务器,参考 虚拟机创建服务器 节点名字节点IP系统版本master11192.168.50.11centos 8.5slave12192.168.50.12centos 8.5slave13192.168.50.13centos 8.5 1 下载组件 Hadoop:官网地址 Hbase:官网地址 ZooKeeper:官网下载 Hive:官网下载 Sqoop:官网下载 为方便