smoe专题

Mistral AI 推出高质量的稀疏专家混合AI人工智能模型——SMoE,有望超越ChatGPT3.5

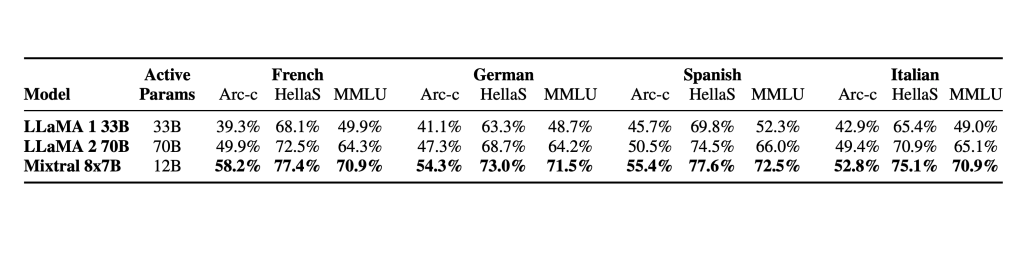

Mistral AI(“Mistral AI”是一家由前DeepMind和Meta Platforms(META.US)的研究人员组建的新公司。)继续履行为开发者社区提供最佳开放模型的使命。他们发布了 Mixtral 8x7B,这是一个高质量的稀疏专家混合模型(SMoE),拥有开放权重,该模型的性能在大多数基准测试中优于 Llama 2 70B,推理速度提高了6倍。 Mixtral 是一个稀疏的