serving专题

Docker使用tensorflow/serving镜像部署模型

Docker使用tensorflow/serving镜像部署模型 环境 简单梳理一下使用tensorflow/serving镜像在服务器上部署模型。 首先要保证在linux环境上已经安装好了docker,之后下载tensorflow/serving镜像: #下载镜像docker pull tensorflow/serving#查看下载的镜像docker images 下载官方的模型

TF-Serving从导出模型到部署服务源码

TF-Serving从导出模型到部署服务源码(Keras) 1.模型保存好之后,使用Keras的模型保存方法保存模型 model.save('my_model.h5') 常见的模型有h5和.keras h5文件包含 ·模型的结构,以便重构该模型 ·模型的权重 ·训练的配置(损失函数,优化器等) ·优化器的状态,以便于从上次训练中断的地方开始 2.使用SavedMod

Tensorflow-serving部署模型到服务器

Tensorflow-serving部署模型到服务器 1.启动docker systemctl start docker 2.查看已经下载的镜像 docker images如果没有,那么拉取镜像docker pull tensorflow/serving 4.在服务器启动docker docker run -t --rm -p 8501:8501 -v /root/keras_

在docker中安装paddle serving @FreeBSD(待续)

因为FreeBSD本身不能装paddle serving,所以我们要在docker里面装。 Paddle Serving官网:GitHub - PaddlePaddle/Serving: A flexible, high-performance carrier for machine learning models(『飞桨』服务化部署框架) wheel包下载:Serving/doc/Lates

TensorFlow Serving模型转换与部署

文章目录 1. TensorFlow Serving安装1.1. 拉取镜像1.2. 下载官方代码1.3. 运行TF Serving1.4. 客户端验证 2. 将ckpt模型转换为pb模型3. 模型部署4. 多模型部署4.1 多(单)用户单模型4.2 多(单)用户多模型4.3. 接口请求 5. 新增模型6. 可能出现的错误错误1错误2错误3错误4错误5错误6错误7错误8 Tensor

Docker tensorflow serving GPU libcuda.so.1问题

在docker中创建一个tensorflow-serving:latest-gpu容器时,报出如下BUG: tensorflow_model_server: error while loading shared libraries: libcuda.so.1: cannot open shared object file: No such file or directory 解决方法1:

[Java安全]Just-Serving-Pages赛题分析

文章目录 写在前面Just-Serving-Pages分析 写在前面 昨晚一点睡觉feng师傅提醒我了下,今天不当懒狗,我相信自己可以解决这里就先直接开始试着边做边写Wp了 Just-Serving-Pages分析 朴实无华,先看看依赖,这个版本其实是存在反序列化RCE的,但是条件比较苛刻 在src/src/cscg/servlets/ConfigServlet.java看

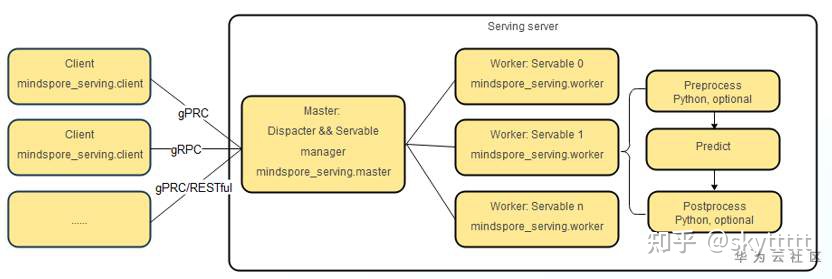

MindSpore Serving笔记分享

转载地址:【MindSpore训练营第五期】MindSpore Serving笔记分享_MindSpore_昇腾论坛_华为云论坛 作者:Jack20 【MindSpore训练营第五期】MindSpore Serving笔记分享 一键部署在线推理服务 --MindSpore Serving MindSpore Serving就是为实现将深度学习部署到生产环境而产生的 MindSpo

图像分类的serving

import timeimport requestsimport jsonimport numpy as npfrom PIL import Imageimport matplotlib.pyplot as pltimport osdef mainProcess(image_data):"""核心代码: 将请求数据发送到远端模型, 返回预测结果"""start = time.time(

tensorflow-serving

serving deploy reference 1. http://blog.csdn.net/wangjian1204/article/details/68928656

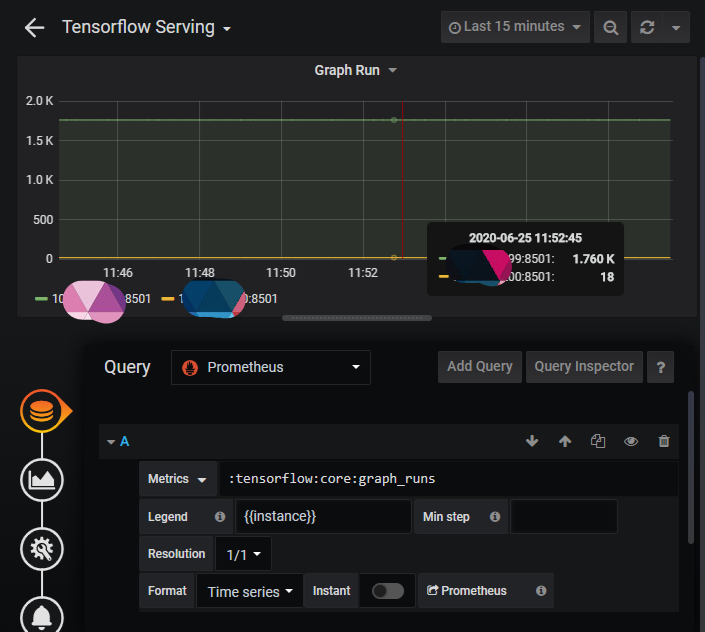

TensorFlow 篇 | TensorFlow 2.x 模型 Serving 服务

「导语」在模型训练完成后,我们需要使用保存后的模型进行线上预测,即模型 Serving 服务。 TensorFlow 团队提供了专门用于模型预测的服务系统 TensorFlow Serving,它专为生产环境设计,具备高性能且具有很强大的灵活性,本文将从服务搭建,服务配置,远程访问等多个方面对 TensorFlow Serving 进行详细地介绍。 Serving 服

![[Java安全]Just-Serving-Pages赛题分析](https://img-blog.csdnimg.cn/8b873c1406be47fe8a12091b4a8600ef.png?x-oss-process=image/watermark,type_ZHJvaWRzYW5zZmFsbGJhY2s,shadow_50,text_Q1NETiBAWTR0YWNrZXI=,size_20,color_FFFFFF,t_70,g_se,x_16)