sasl专题

Failed building wheel for sasl解决方案

今天安装superset依赖时报错: Failed building wheel for sasl 单独安装pip install sasl也报一样的错。 执行以下命令解决: sudo apt-get install libsasl2-dev

Hue error: 集成hive报错Could not start SASL: Error in sasl_client_start (-4) SASL(-4): no mechanism avai

1.问题描述 hue配置完hive后,打开hue界面报错: Could not start SASL: Error in sasl_client_start (-4) SASL(-4): no mechanism available: No worthy mechs found (code THRIFTTRANSPORT): TTransportException('Could not sta

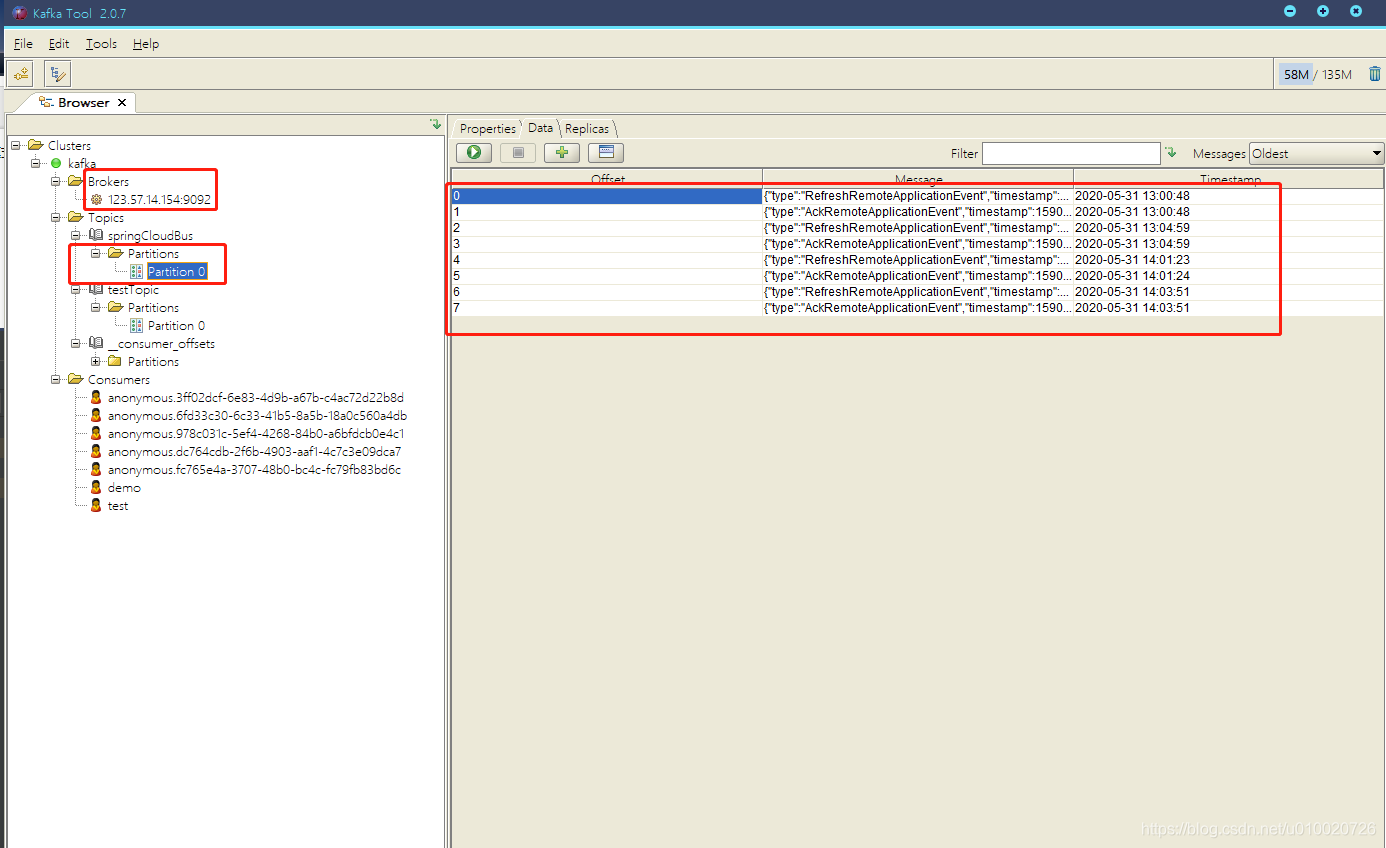

Kafka Tool 2 使用教程 SASL_PLAINTEXT

下载 Kafka Tool下载链接: 这里根据 你自己电脑系统 选择相对应版本 配置链接 如果使用的是SASL Plaintext,则通常必须将sasl.mechanism客户端属性更改为PLAIN。可以在“高级”部分下的“ SASL机制”文本字段中输入此属性。 如果kafka 开启SASL_PLAINTEXT认证(用户名和密码认证) 操作

SpringBoot集成Kafka之SASL_SSL

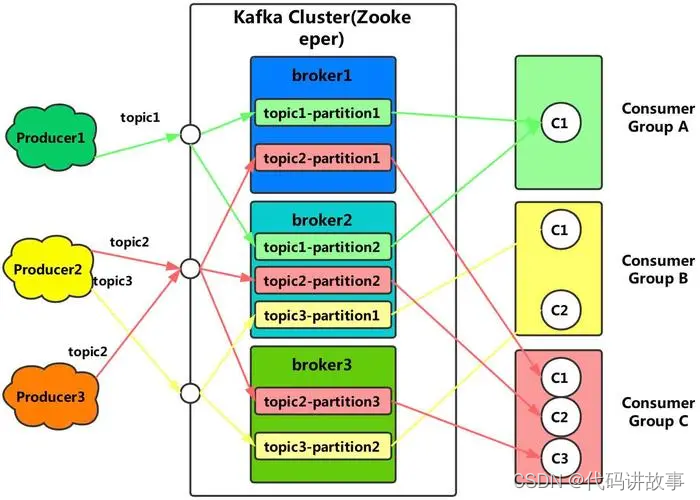

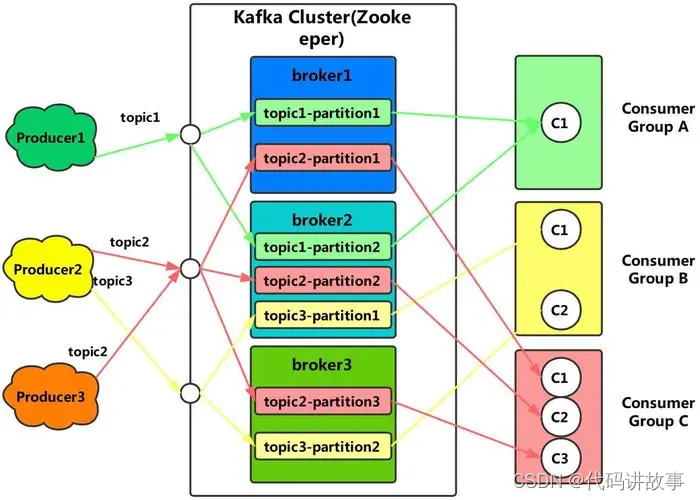

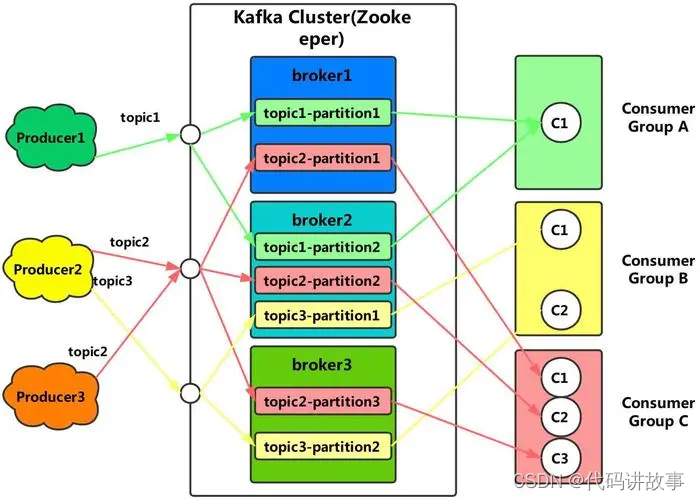

系列文章目录 文章目录 系列文章目录前言 前言 前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住分享一下给大家。点击跳转到网站,这篇文章男女通用,看懂了就去分享给你的码吧。 Kafka 是一个由 LinkedIn 开发的分布式消息系统,它于2011年年初开源,现在由著名的 Apache 基金会维护与开发。 Kafka 使用 Scala 实现,被

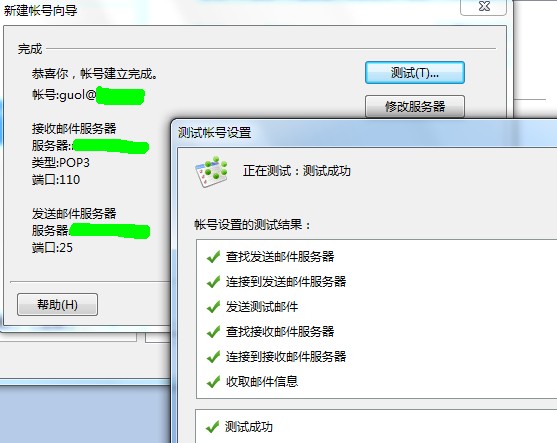

Postfix + Cyrus-IMAP + Cyrus-SASL + MySQL + IMP 完全指南

1. 概述1.1. 目的本文介绍如何在一个Linux平台上安装一套功能完整的邮件系统。这里我们以Postfix做SMTP服务器、Cyrus-IMAP做POP3/IMAP4服务器、通过Cyrus-SASL对存储在MySQL数据库中的用户进行验证和授权,并且使用IMP来提供一个完善的WEBMAIL界面。 这个邮件系统的设计目标是提供一个可扩充的、具备大多数功能的邮件系统。 本文的最新版本

淘淘第2天dubbo和zookeeper问题Will not attempt to authenticate using SASL (unknown error)

1、防火墙关闭 2、spring 配置文件的端口号2181 和 服务端zoo.cfg配置的端口号2181要一至。

kafka3.4.x配置sasl认证

背景这里kafka使用的是单独部署的zookeeper 需要走认证配置 我这里使用的zookeeper版本是3.8.3 kafka 3.4.0 kafka安装目录:/usr/local/bin/xx/kafka zookeeper安装目录:/usr/local/bin/xx/zookeeper 修改配置文件 找到kafka的/usr/local/bin/xx/kafka/config/se

Kafka SASL_SSL双重认证

文章目录 1. 背景2. 环境3. 操作步骤3.1 生成SSL证书3.2 配置zookeeper认证3.3 配置kafka安全认证3.4 使用kafka客户端进行验证3.5 使用Java端代码进行认证 1. 背景 kafka提供了多种安全认证机制,主要分为SASL和SSL两大类。 SASL: 是一种身份验证机制,用于在客户端和服务器之间进行身份验证的过程,其中SASL/PL

sasl/sasl.h: No such file or directory

yum install -y gcc-c++ yum -y install cyrus-sasl cyrus-sasl-devel cyrus-sasl-lib

Running setup.py install for sasl ... error

在服务器安装pyhive中,出现错误。 Building wheel for sasl (setup.py) ... errorERROR: Command errored out with exit status 1:command: /home/。/anaconda3/bin/python -u -c 'import sys, setuptools, tokenize; sys.argv

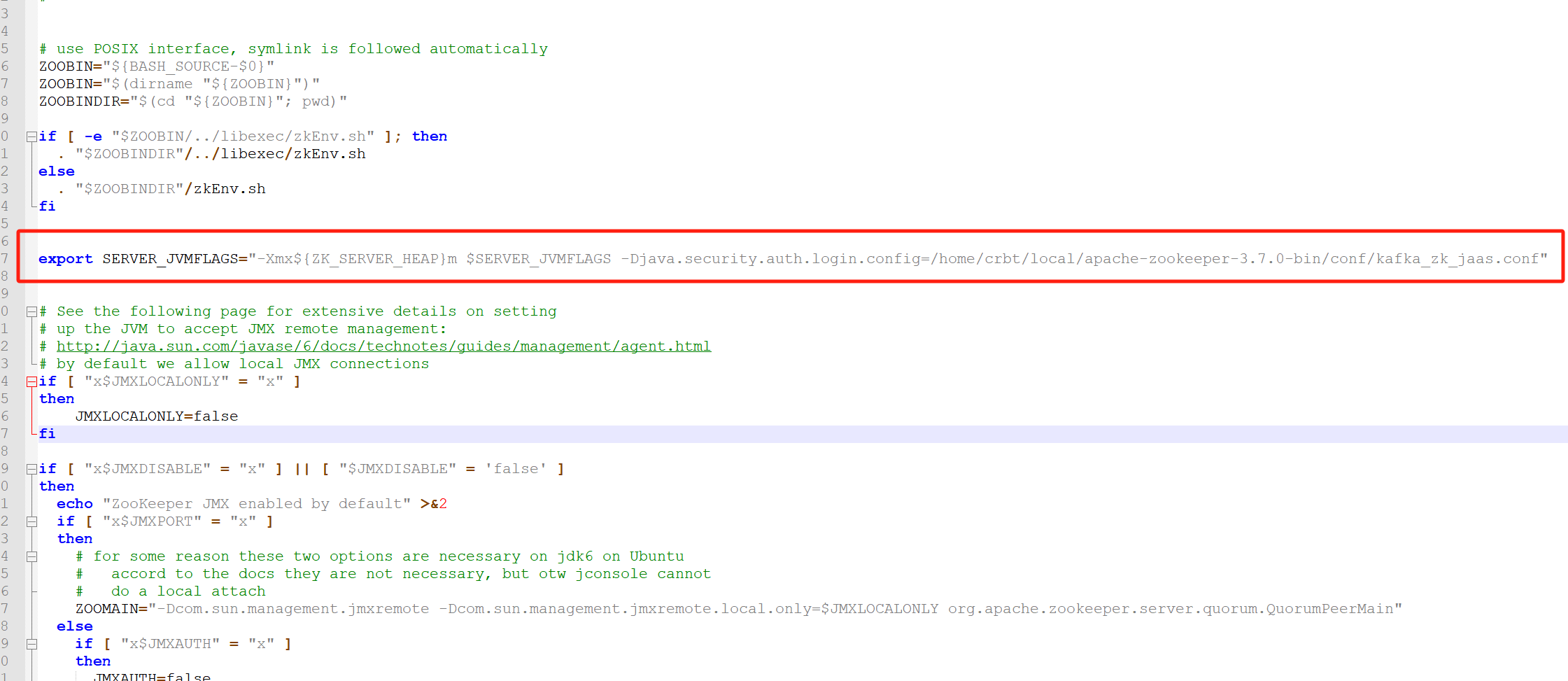

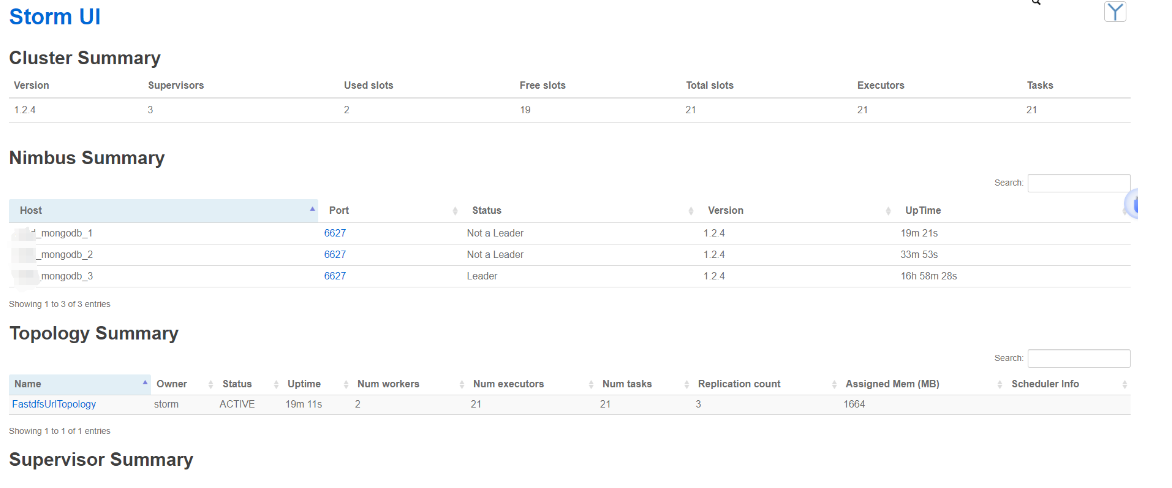

storm统计服务开启zookeeper、kafka 、Storm(sasl认证)

部署storm统计服务开启zookeeper、kafka 、Storm(sasl认证) 当前测试验证结果: 单独配置zookeeper 支持acl 设置用户和密码,在storm不修改代码情况下和kafka支持当kafka 开启ACL时,storm 和ccod模块不清楚配置用户和密码。 使用python脚本连接kafka用户和密码是能成功发送消息。 当前部署环境服务版本 服务IP模块版本信息1

xmpp使用tls和sasl登录

文章链接 http://blog.sina.com.cn/s/blog_733236dd01011dus.html 名词解释 TLS:安全传输层协议 TLS:Transport Layer Security 名词: 安全传输层协议(TLS)用于在两个通信应用程序之间提供保密性和数据完整性。该协议由两层组成: TLS 记录协议(TLS Record)和 TLS 握手协议(TLS

kafka 0.10.0.0 配置SASL_PLAINTEXT

首先增加kafka-jaas配置文件,修改server.properties,修改启动脚本sh 1、必须配置security.inter.broker.protocol=SASL_PLAINTEXT 原来2.2的时候没有配置这一项,0.11的时候也没有配置,这个版本不配置kafka启动不了,所以增加配置 security.inter.broker.protocol=SASL_PLAINTEX

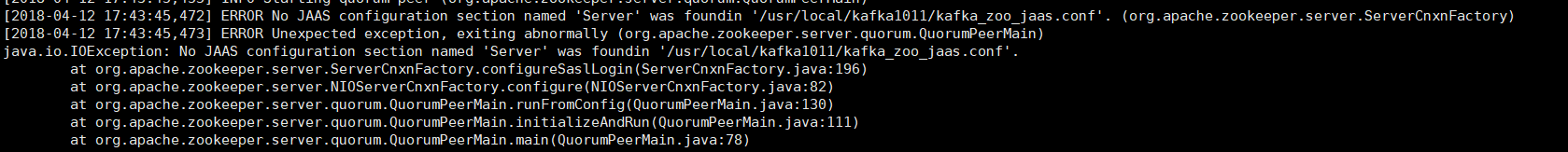

kafka 0.10.1.1的SASL入门配置教程

刚测通的kafka的producer和consumer,下来准备搞一下kafka的认证,SSL比较复杂,而且影响性能,内部暂时不考虑,因此把目标定在了SASL上。本来以为按照网上的教程简单配置一下很快就能搞定的,结果没有一个能用的,走了好多弯路,花了一天多才搞定,因此记录一下,此次的配置针对的是kafka0.10.1.1的版本 配置分为3部分,zookeeper的配置、broker的配置和pro

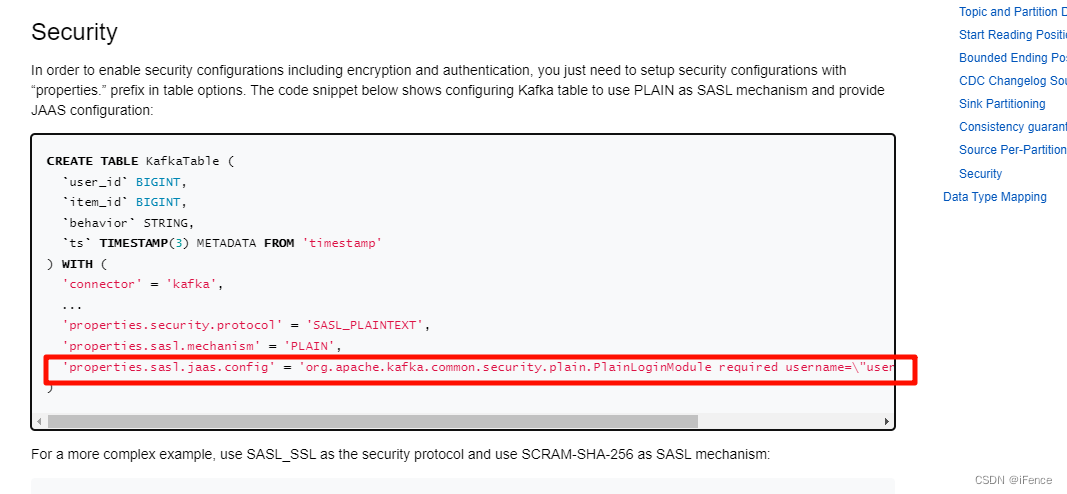

flink sql1.18.0连接SASL_PLAINTEXT认证的kafka3.3.1

阅读此文默认读者对docker、docker-compose有一定了解。 环境 docker-compose运行了一个jobmanager、一个taskmanager和一个sql-client。 如下: version: "2.2"services:jobmanager:image: flink:1.18.0-scala_2.12container_name: jobmanagerp

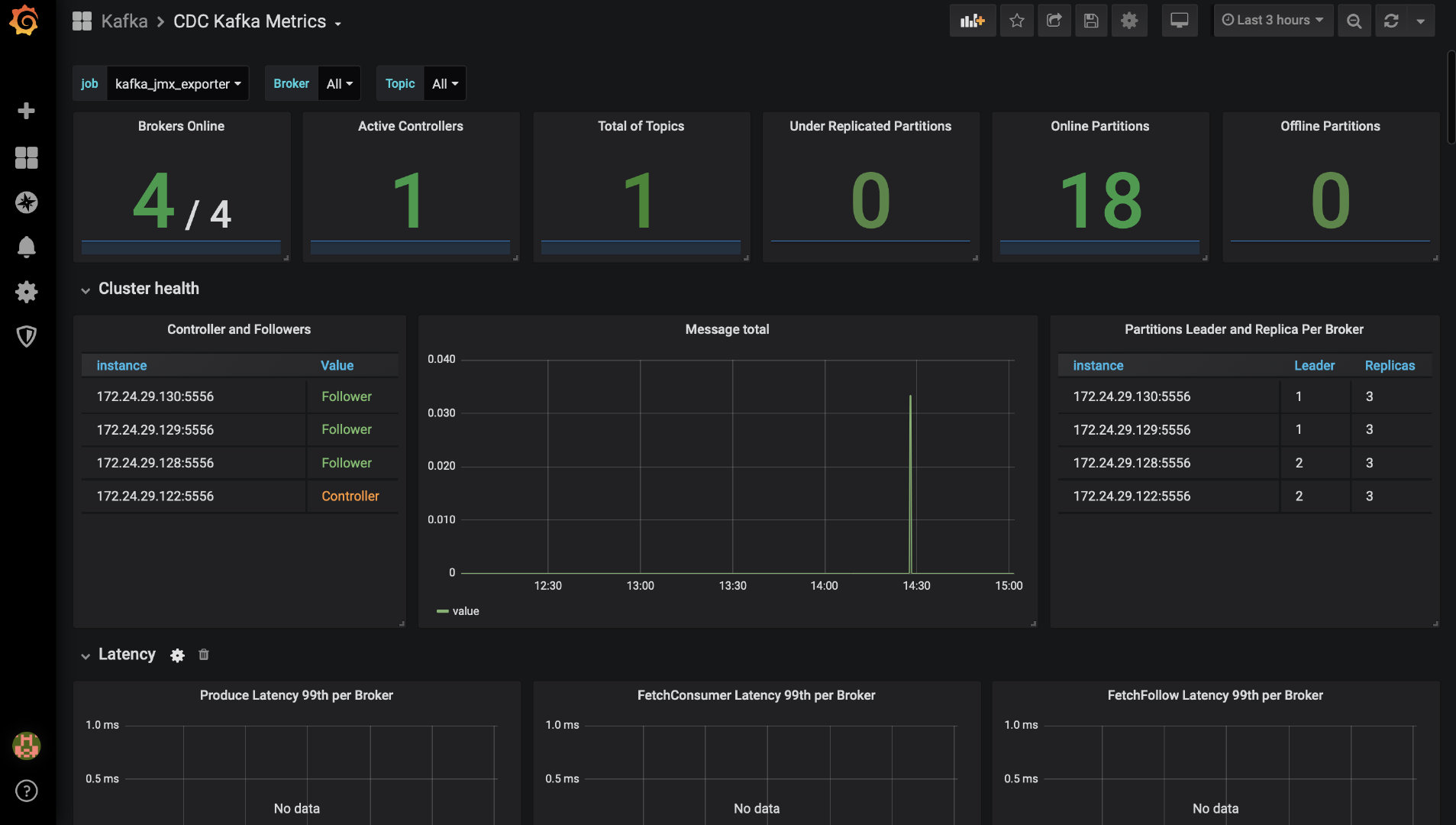

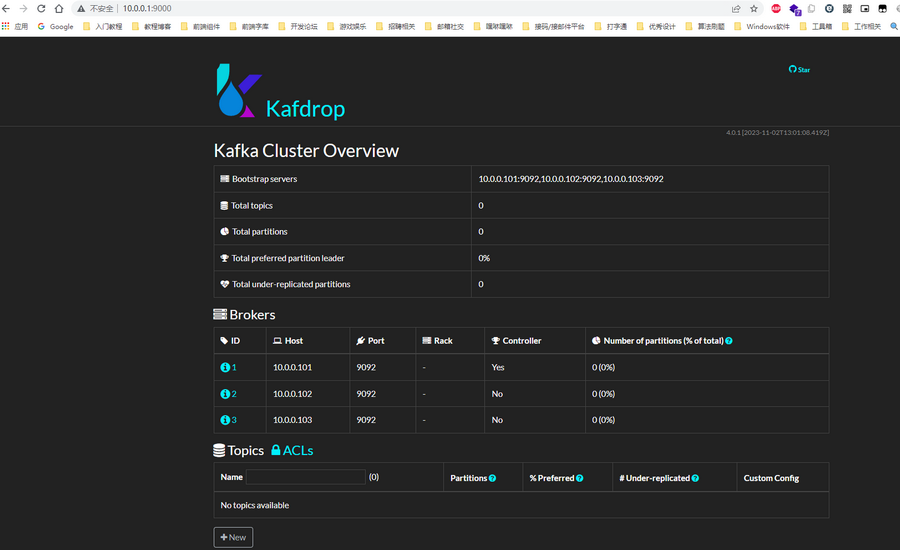

【Kafka】从安装到配置再到监控,教你搭建一套sasl/scram类型的Kafka集群

文章目录 准备工作修改配置文件创建初始用户创建jaas文件修改启动脚本启动Kafka添加SystemdKafka监控部署jmx_exporter配置Prometheus配置Grafana 后记 本文的主要内容是讲解一个4个broker,SASL/SCRAM类型的Kafka集群搭建过程。 准备工作 安装jdk 安装Zookeeper和kafka之前,需要先安装java环境,

KRaft使用SASL_PLAINTEXT进行认证

需要有KRaft相关的基础,才行。可参阅之前学习记录Kafka 一、配置 首先需要了解SASL的含义,SASL全称为Simple Authentication and Security Layer,它主要是用于在客户端和服务器之间提供安全的身份验证机制。 Kafka 支持以下几种 SASL 验证机制如下 GSSAPI (Kerberos)PLAINSCRAM-SHA-256SCRAM-SH

【KAFKA】Kafka集群搭建(安全认证SASL/PLAIN),并和springBoot整合

Kafka集群搭建(安全认证SASL/PLAIN),并和springBoot整合 搭建三台机器的kafka集群。 用外置的zookeeper做配置中心管理。 为了不让配置中心也产生单点,所以我们需要先搭建一个三个节点的配置中心集群; 1 环境: OS版本: Centos7.4 kafka版本: kafka_2.11-2.2.0 ZK版本: zookeepe

Hue Could not start SASL: Error in sasl_client_start (-4) SASL(-4): no mechanism available: No worth

问题: thriftpy.transport.TTransportException: TTransportException(type=1, message="Could not start SASL: b'Error in sasl_client_start (-4) SASL(-4): no mechanism available: No worthy mechs found'") 原因:

Linux Postfix+Dovecot+sasl

为什么80%的码农都做不了架构师?>>> 又有业务需求要搞postfix,几年前部署过,这真是一段时间不操作就忘光光啊,趁部署完赶紧记录一下,部署环境debian5,软件都是apt安装,不要源码安装。这次的业务要求是能调用接口发邮件,并且为了安全要经过认证的账号才能发邮件,没经过认证的则拒绝。如果发信时无需认证的邮件服务器,很容易造成大量垃圾邮件的产生,也给服务器带来了

Hue error: 集成hive报错Could not start SASL: Error in sasl_client_start (-4) SASL(-4): no mechanism avai

1.问题描述 hue配置完hive后,打开hue界面报错: Could not start SASL: Error in sasl_client_start (-4) SASL(-4): no mechanism available: No worthy mechs found (code THRIFTTRANSPORT): TTransportException('Could not sta

centos 7 kafka2.6单机安装及动态认证SASL SCRAM配置

目录 1.kfaka安装篇 1.1 安装jdk 1.2安装kafka 2.安全篇 2.1 kafka安全涉及3部份: 2.2 Kafka权限控制认证方式 2.3 SASL/SCRAM-SHA-256 配置实例 2.3.1 创建用户 2.3.2 创建 JAAS 文件及配置 3.测试 3.1 创建测试用户 3.2 配置JAAS 文件 3.2.1 生产者配置 3.2.2

spark_windows_sasl_gss_initiate_failed

本地Windows 环境 连接cdh 6.3.2 hive2.1.1, 集群hadoop 版本3.0.0-cdh6.3.2 本地windows hadoop 版本2.7.7 出现如上错误。 尝试解决办法: 之前cdh hadoop版本为2.7的时候,windows远程连接是正常的。 排查日志(主要是cloudera manager namenode日志)发现,是因为hadoop 版本

Kafka 开启SASL/SCRAM认证 及 ACL授权(一)认证

Kafka 开启SASL/SCRAM认证 及 ACL授权(一)认证。 kafka安全涉及3部份:传输加密,用户认证与授权,ZK开启ACL(Zookeeper存储了kafka的元数据以及用户信息,默认不开启acl所有用户可改,内网环境机器不对外开放可考虑使用默认不开启ZK ACL)。 官网地址:https://kafka.apache.org/ 词汇说明: 认证,即用户登陆。 授权,即管理

Kafka 开启SASL/SCRAM认证 及 ACL授权(三)验证

Kafka 开启SASL/SCRAM认证 及 ACL授权(三)验证。 官网地址:https://kafka.apache.org/ 本文说明如何做client验证ACL是否生效,我们之前开启了无acl信息不允许访问的配置。涉及的client有以下几个场景:shell脚本、python脚本、java应用、flink流。 kafka shell script验证 核心逻辑是,连zk的,使用zk

Kafka 开启SASL/SCRAM认证 及 ACL授权(二)ACL

Kafka 开启SASL/SCRAM认证 及 ACL授权(二)ACL。 官网地址:https://kafka.apache.org/ kafka authentorization:https://docs.confluent.io/platform/current/kafka/authorization.html 一、开启ZK ACL(可选,内网环境,用户无机器访问权限时) 给kafka