robustly专题

论文翻译 - Defending Against Alignment-Breaking Attacks via Robustly Aligned LLM

论文链接:https://arxiv.org/pdf/2309.14348.pdf Defending Against Alignment-Breaking Attacks via Robustly Aligned LLM Abstract1 Introduction2 Related Works3 Our Proposed Method3.1 Threat Model3.2 Our Pr

[RoBERTa]论文实现:RoBERTa: A Robustly Optimized BERT Pretraining Approach

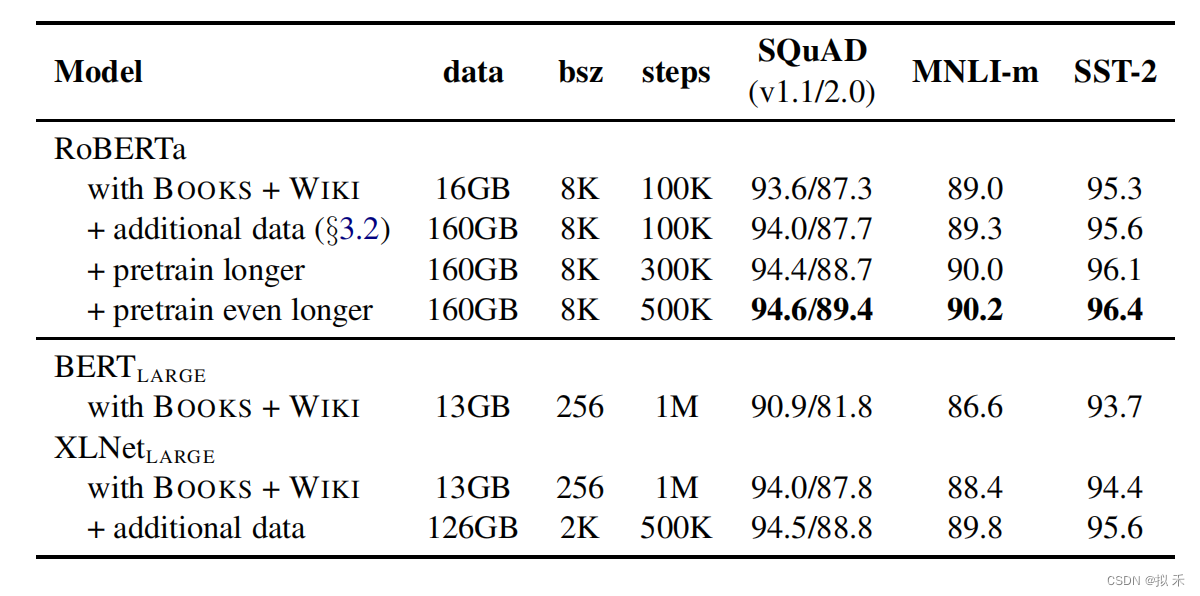

文章目录 一、完整代码二、论文解读2.1 模型架构2.2 参数设置2.3 数据2.4 评估 三、对比四、整体总结 论文:RoBERTa:A Robustly Optimized BERT Pretraining Approach 作者:Yinhan Liu, Myle Ott, Naman Goyal, Jingfei Du, Mandar Joshi, Danqi Chen,

2019-裴丹-CoFlux Robustly Correlating KPIs by Fluctuations for Service Troubleshooting-阿里巴巴

文献解读网文 https://zhuanlan.zhihu.com/p/71178532 重要概念 波动相关性 fluctuation correlation、flux-correlation 波动特征 波动特征(flux-feature)就是预测误差(prediction error)。 具体是怎么预测的呢?论文里边给出了7种预测模型,每种模型根据参数的不同有不同的预测结果,所有7

【NLP】 RoBERTa: A Robustly Optimized BERT Pretraining Approach

1. Dynamic Masking🌺 RoBERTa 是对 BERT 的优化提升,改进之一就是在 Masked Language Model (MLM) 任务中,使用 dynamic masking 代替原先的 static masking。 BERT :随机15%的 token 进行 mask,这个过程在数据预处理阶段进行的,而非模型训练阶段。每个样本只会进行一次随机 mask,

![[RoBERTa]论文实现:RoBERTa: A Robustly Optimized BERT Pretraining Approach](https://img-blog.csdnimg.cn/direct/0784bd8fbe274ebdb0c271aa94984dad.png)