reasoners专题

论文笔记:Large Language Models as Analogical Reasoners

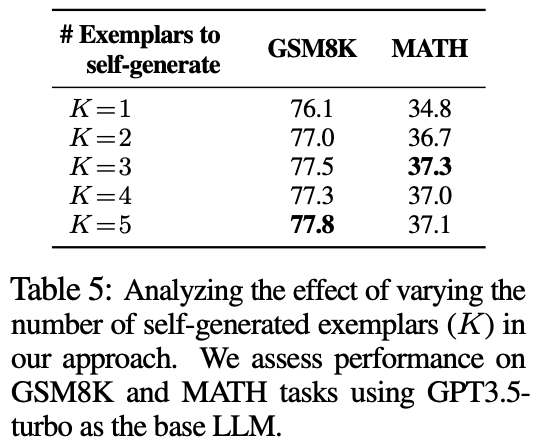

iclr 2024 reviewer打分5558 1 intro 基于CoT prompt的大模型能够更好地解决复杂推理问题 然而传统CoT需要提供相关的例子作为指导,这就增加了人工标注的成本——>Zero-shot CoT避免了人工标注来引导推理 但是对于一些复杂的任务难以完成推理,例如code generation——>论文提出一种“归纳学习”的提示方法 首先设计prompt让大模型生成出

2024年1月18日Arxiv最热NLP大模型论文:Large Language Models Are Neurosymbolic Reasoners

大语言模型化身符号逻辑大师,AAAI 2024见证文本游戏新纪元 引言:文本游戏中的符号推理挑战 在人工智能的众多应用场景中,符号推理能力的重要性不言而喻。符号推理涉及对符号和逻辑规则的理解与应用,这对于处理现实世界中的符号性质问题至关重要。本文探讨了大型语言模型(LLMs)在符号推理中的潜在应用,特别是在文本游戏这一具有挑战性的领域。文本游戏是测试自然语言能力的重要基准,尤其是在数学、地图阅

论文解读:Large Language Models as Analogical Reasoners

一、动机 大模型在各种类型的NLP任务上均展现出惊艳的表现。基于CoT propmt能够更好地激发大模型解决复杂推理问题的能力,例如解决数学解题,可以让模型生成reasoning path。现有的经典的CoT方法有few-shot cot、zero-shot cot等。然后现有的cot面临两个核心挑战: 需要提供相关的exemplars作为指导;需要尽可能减少人工标注的成本; Zero-sh