powerinfer专题

手机流畅运行470亿参数大模型,上交大发布PowerInfer-2推理框架,性能提升29倍

苹果一出手,在手机等移动设备上部署大模型迅速成为行业焦点。 目前,移动设备上运行的模型相对较小(苹果的是3B,谷歌的是2B),并且消耗大量内存,这在很大程度上限制了其应用场景。 即使是苹果,也需要与OpenAI合作,通过将云端GPT-4o大模型嵌入到操作系统中来提供更强大的服务。GPT-4o深夜发布!Plus免费可用!https://www.zhihu.com/pin/1773645611381

手机流畅运行470亿大模型:上交大发布LLM手机推理框架PowerInfer-2,提速29倍

卡奥斯智能交互引擎是卡奥斯基于海尔近40年工业生产经验积累和卡奥斯7年工业互联网平台建设的最佳实践,基于大语言模型和RAG技术,集合海量工业领域生态资源方优质产品和知识服务,旨在通过智能搜索、连续交互,实时生成个性化的内容和智能化产品推荐,为用户提供快速、可靠的交互式搜索服务,首创了聚焦工业领域的智能交互引擎。 详情戳:智能交互引擎https://datayi.cn/w/DPWgDgjP 苹果

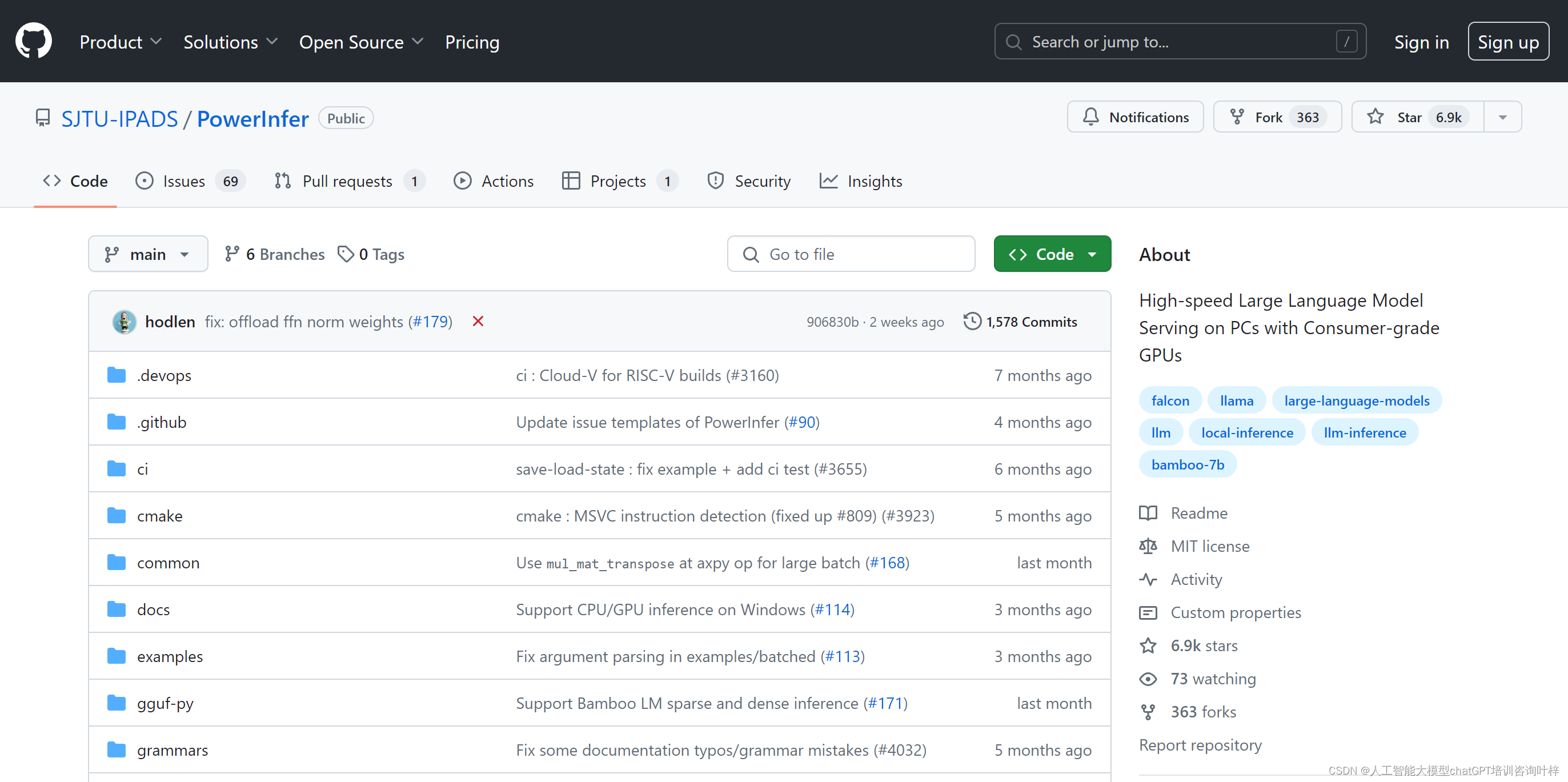

“PowerInfer:消费级GPU上的高效大语言模型推理引擎“

PowerInfer是由上海交通大学IPADS实验室开发的一个高效大语言模型(LLM)推理引擎,专为个人电脑(PC)上的消费者级GPU设计。它通过利用LLM推理中的高局部性,实现了快速且资源消耗低的模型推理,这一局部性主要体现在神经元激活的幂律分布上,即少数“热”神经元频繁激活,而大多数“冷”神经元则在特定输入下激活。 PowerInfer基于大型语言模型(LLM)在推理时神经元激活的局部性特征