perturbation专题

Adversarial Perturbation Constraint对抗扰动约束

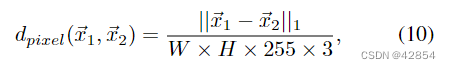

对抗扰动约束(Adversarial Perturbation Constraint)是在机器学习和深度学习领域中,一个涉及对抗样本(Adversarial Examples)的概念。对抗样本是指通过对输入数据进行微小、特意设计的扰动,使得模型产生错误预测或分类的输入数据。对抗扰动约束涉及这些扰动的生成和应用时的限制条件。 主要概念 对抗样本:这些是经过精心修改的输入数据,目的是欺骗机器学习

【论文记录】Input Perturbation: A New Paradigm between Central and Local Differential Privacy

算法&基本思想 By line 7 in Algorithm 1, it can be seen that the noise added to the original data affects the gradient. (adds noise to original data instances, leading perturbation on the gradient and ev

【翻译】Diversified Arbitrary Style Transfer via Deep Feature Perturbation

通过深度特征扰动实现多样化的任意风格转移 文章目录 Abstract1. Introduction2. Related Work3. 特定风格的特征空间4. 深度特征扰动5. Experimental Results5.1. Implementation Details5.2. Ablation Study5.3. 比较 6. Conclusion Abstract 图像风格转