oozie专题

Flink整合Oozie Shell Action 提交任务带Kerberos认证

最近这段时间一直在忙新集群迁移,上了最新的cdh6.3.0 于是Flink 提交遇到了许多的问题,还好有cloudera License 有了原厂的帮助和社区的伙伴,问题解决起来快了不少。 集群具体情况是 CDH6.3.0 Flink1.8.1,整个数据平台全部组件都上了kerberos和ldap因为要过认证,所以任务提交方法我们选择统一Oozie提交任务,并且因为kerberos认证,还需要F

Java调用oozie提交spark on yarn任务

1.需要在oozie-site.xml设置如下属性: <property> <name>hadoop.proxyuser.cenyuhai.hosts</name> <value>*</value> </property> <property> <name>hadoop.proxyuser.cenyuhai.groups</name> <value>*</value> </proper

关于oozie的一些参考网址

http://blog.csdn.net/renyp8799/article/details/17037989 http://blog.csdn.net/mafuli007/article/details/17071519 关于oozie的FAQ参考网址: https://github.com/yahoo/oozie/wiki/FAQ http://ww

关于oozie的简单说明

关于oozie的简单说明 1.oozie应用程序目录结构说明: 一个完整的oozie应用程序一般情况下至少包含三个文件及目录:job.properties、workflow.xml、lib(lib表示为用来存放程序运行需要的jar包,非必需) 2.flow nodes的六种类型: start, end, decision, fork, join, kill 3.action

oozie使用的注意事项

1.在pig中使用UDF函数时候的注意事项: (1).pig的udf函数jar包可以放在本地也可以放在hdfs中(推荐放在hdfs中) a.放在本地:<param>myUDF=./pig/myUDFs.jar</param> 其中,"myUDF"为变量名,"./pig/myUDFs.jar"为当前UDF函数的本地路径 b.放在hdfs:<param>myUDF=${nameNode}/us

oozie中运行mapreduce node-action时的常见异常解决方法

oozie中运行mapreduce node-action时的常见异常解决方法 在第一次使用oozie来管理mapreduce工作流时,出现了如下异常: java.io.IOException: Type mismatch in key from map: expected org.apache.hadoop.io.LongWritable, recieved org.apache.ha

oozie中运行pig action-node时的错误提示参数参考

oozie中运行pig action-node时返回的错误参数参考 我在使用oozie运行pig时,经常会遇到如下异常:Main class [org.apache.oozie.action.hadoop.PigMain], exit code [6],后来查找了一些文档,知道了这是使用UDF函数时出的问题,今天把常见的错误返回值贴出来供大家参考。 Pig返回值及其意义

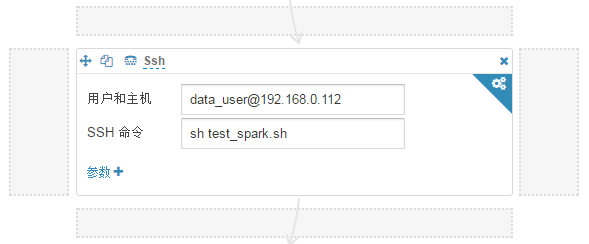

Spark job在hue-oozie中的另一种方式调度

工作中使用的是hue来配置oozie工作流调度及任务中调度关系,spark job的输入是由hive sql产生输出的表,在配置spark job由于一些客观关系出现很多问题导致无法正确的执行,在oozie中支持spark job的及shell job的配置执行 1. 采用spark program组件配置, 目前版本过低无法添加运行时的一些参数 官网http://gethue

hue(5):Hue与zookeeper、oozie、Hbase集成

一、配置步骤 1.和zookeeper集成,修改hue.ini [zookeeper] [[clusters]] [[[default]]] # Zookeeper ensemble. Comma separated list of Host/Port. # e.g. localhost:2181,localhost:2182,localhost:2183 host_ports=ha

Oozie 任务启动后占用大量资源导致任务失败解决

如果集群资源不足,Oozie 任务启动后占用大量资源可能导致任务失败一般有两种情况。 一是导致自身任务挂起无法执行成功;二是导致其他任务无法启动。 解决办法 在 workflow.xml 的配置 <configuration> 中增加如下属性 <property> : <property><name>oozie.launcher.mapreduce.map.memory.mb</name>

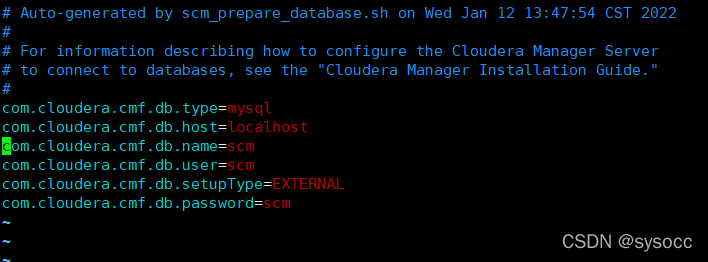

安装CDH6.2时hive、hue、oozie等找不到对应数据库

问题描述:如下图(忘了截图,找个了类似的),hive、hue、oozie等都找不到对应数据库,No database server found running on host xxx: 编辑文件 /etc/cloudera-scm-server/db.properties,发现服务端配置文件里默认是localhost: 这里有两种解决方法: 方法一:安装界面数据库主机名改为 localh

Oozie多任务串联和定时任务执行?看这篇就懂了!

写在前面: 博主是一名大数据的初学者,昵称来源于《爱丽丝梦游仙境》中的Alice和自己的昵称。作为一名互联网小白,写博客一方面是为了记录自己的学习历程,一方面是希望能够帮助到很多和自己一样处于起步阶段的萌新。由于水平有限,博客中难免会有一些错误,有纰漏之处恳请各位大佬不吝赐教!个人小站:http://alices.ibilibili.xyz/ , 博客主页:https://alice.blog.

Oozie调度Pig job常见的问题及分析

Oozie调度Pig job常见的问题及分析 guibin.beijing@gmail.com 1. Failing Oozie Launcher, Main class [org.apache.oozie.action.hadoop.PigMain], exit code [7] 这个错误一开始让人一头雾水!查阅了"Programming Pig. 2011 version"才知道exi

大数据调度框架Oozie,这个学习网站让你事半功倍!

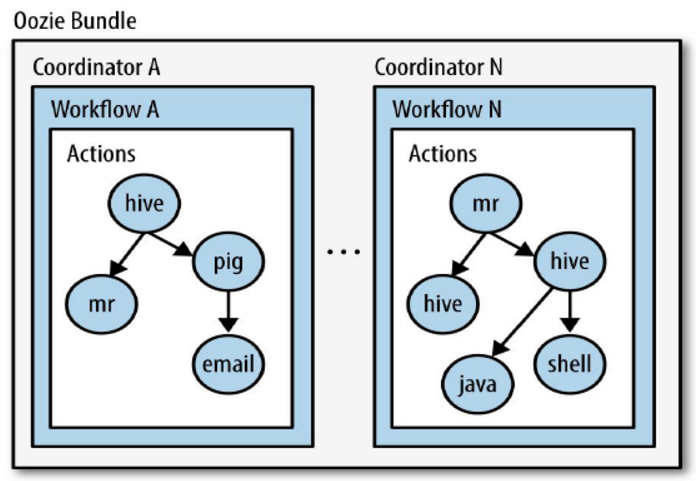

Oozie是一个基于工作流引擎的开源框架,由Cloudera公司贡献给Apache。它主要用于管理和调度Apache Hadoop作业,支持的任务类型包括Hadoop MapReduce、Pig Jobs等。 Oozie的核心概念包括workflow jobs和coordinator jobs。Workflow jobs是由多个动作(actions)组成的有向无环图(DAG),即任务按照预定的逻辑

[CDH5] Oozie web console is disabled 问题解决

问题解决: 下载ExtJS2.2: 下载地址:http://archive.cloudera.com/gplextras/misc/ext-2.2.zip 上传到服务器并解压 [root@hadoop1 libext]# cd /opt/cloudera/parcels/CDH/lib/oozie/libext/[root@hadoop1 libext]# unzip ext-2.2.zi

工作流调度框架 Oozie

工作流调度框架Oozie 工作流 import -> hive -> export 将不同的业务进行编排调度 作业/任务 定时执行 事件的触发执行 时间:如每天5点触发数据集:如某个文件夹中有文件就触发 1.Hadoop调度框架 1. Linux Crontab(最原始,最简单的任务调度) crontab是针对每个用户而言 规则:*分 *时 *天 *月 *星期 cmd 针对H

oozie源码阅读碎语

1. XConfiguration: Extends Hadoop Configuration providing a new constructor which reads an XML configuration from an InputStream. 2. ThreadLocal用法 3.Thread.currentThread().getContextClassLoader().

【ooize】oozie启动失败

今天遇到一个很蛋疼的问题,一个workflow僵死,通过oozie job -kill XXXX,无法将其杀死,郁闷之极,然后将oozie重新启动,重启之后发现该workflow仍然僵死,显示处于running状态,猜想应该是oozie所对应的数据库中存有该wf的状态信息,于是想去数据库中将此wf的信息删除,进入数据库中发现无法查询数据库表,原来是表被lock,原因找到,于是重启mysql服务,再

Oozie调度工具--一次性脚本文件的创建和执行

1,首先环境介绍,使用的是CDH的clouder manage 管理平台,已经安装Oozie组件 2,开启Oozie调度工具 3,可以直接在管理界面点击Hue,也可以在群集里面点击Hue,打开Hue编辑平台 4,打开Hue编辑器后,在里面找到怎么创建脚本,其中Workflow是创建一次性调度脚本的,计划是创建可以多次定时执行脚本的工具,首先介绍创建一次性调度脚本 5,在HDFS管理界面的根目

大数据技术之Oozie

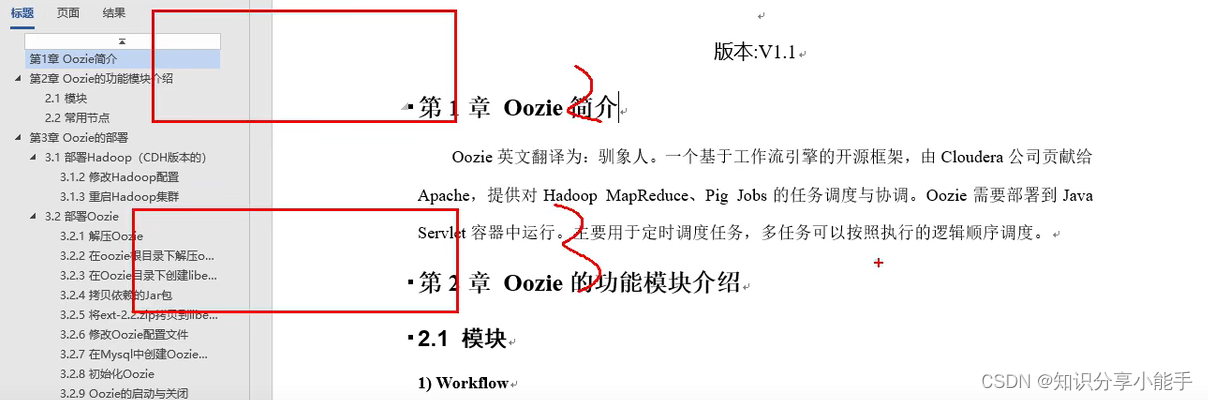

大数据技术之Oozie 第1章 Oozie简介 Oozie英文翻译为:驯象人。一个基于工作流引擎的开源框架,由Cloudera公司贡献给Apache,提供对Hadoop MapReduce、Pig Jobs的任务调度与协调。Oozie需要部署到Java Servlet容器中运行。主要用于定时调度任务,多任务可以按照执行的逻辑顺序调度。 第2章 Oozie的功能模块介绍 2.1 模块 W

大数据框架OOZIE 五分钟入门学习

OOZIE 是什么鬼? Apache Oozie是工作流调度用在Hadoop中。它是一个运行相关的作业工作流系统。这里,用户被允许创建向非循环图工作流程,其可以在并列 Hadoop 并顺序地运行。 它由两部分组成: 工作流引擎:一个工作流引擎的职责是存储和运行工作流程,由 Hadoop 作业组成:MapReduce, Pig, Hive. 协调器引擎:它运行基于预定义的时间表和数据的可用

B02 - 078、Kill杀死Oozie后的问题解决

初学耗时:0.5h 注:CSDN手机端暂不支持章节内链跳转,但外链可用,更好体验还请上电脑端。 一、Kill杀死Oozie后的问题解决 记忆词: ... B02 - 999、部署大数据环境及部分编译 ギ 舒适区ゾ || ♂ 累觉无爱 ♀ 一、Kill杀死Oozie后的问题解决 如果用kill杀死Oozie再重启,会导致o

走向云计算之工作流引擎Oozie

一、概述 目前计算框架和作业类型繁多:包括MapReduce Java、Streaming、HQL、Pig等,如何对这些框架和作业进行统一管理和调度是我们需要面临的一个问题。目前有多种解决方案:可以使用Crontab,也可以自己设计调度系统,还可以直接使用开源系统。 如果我们自己设计调度系统,可以通过crontab+shell来实现,如下所示: //mapreduce_job.shcmd=

![[CDH5] Oozie web console is disabled 问题解决](https://img-blog.csdnimg.cn/20200110165455459.png)