neutron专题

OpenStack Victoria版——7.2计算节点-Neutron网络服务组件

7.2计算节点-Neutron网络服务组件 更多步骤:OpenStack Victoria版安装部署系列教程 OpenStack部署系列文章 OpenStack Victoria版 安装部署系列教程 OpenStack Ussuri版 离线安装部署系列教程(全) OpenStack Train版 离线安装部署系列教程(全) 文章目录 一、安装相关软件二、配置公共组件三、配置网络

OpenStack Victoria版——7.1控制节点-Neutron网络服务组件

7.1控制节点-Neutron网络服务组件 更多步骤:OpenStack Victoria版安装部署系列教程 OpenStack部署系列文章 OpenStack Victoria版 安装部署系列教程 OpenStack Ussuri版 离线安装部署系列教程(全) OpenStack Train版 离线安装部署系列教程(全) 欢迎留言沟通,共同进步。 文章目录 一、创建n

启动neutron-openvswitch-agent.service的时候报错socket.error: [Errno 13] Permission denied

启动neutron-openvswitch-agent.service的时候报错socket.error: [Errno 13] Permission denied stderr: Traceback (most recent call last): File "/usr/bin/neutron-rootwrap-daemon", line 10, in <module>

23.neutron的工作原理及controller安装配置

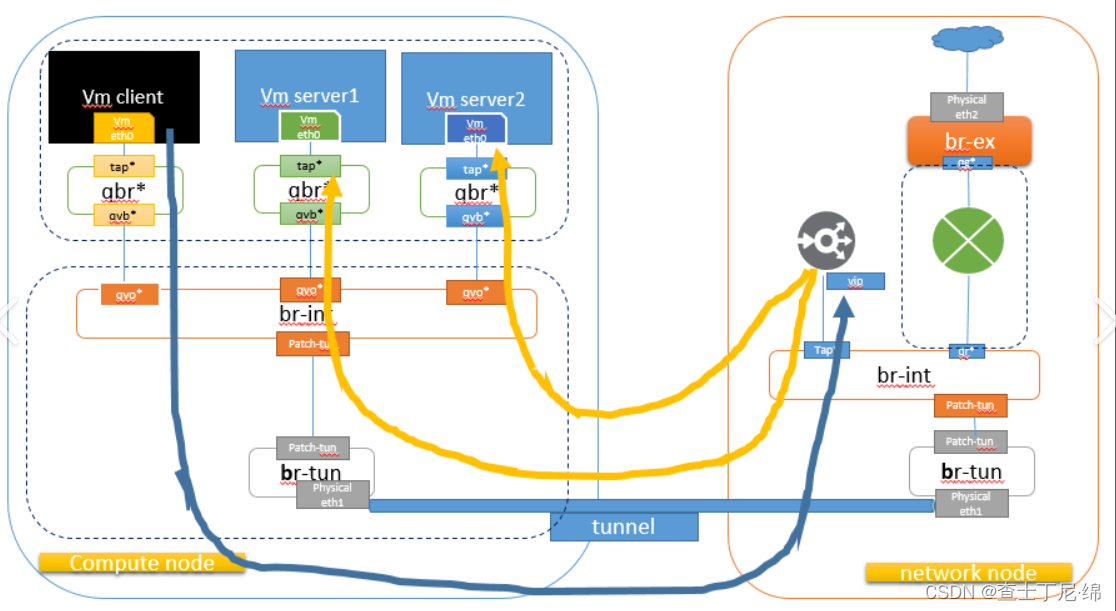

配置模式: neutron: flat flat DHCP VLAN VXLAN 网络节点neutron和计算节点compute都会有br-tun,默认创建的,它们之间建立VPN隧道的数据包通过每个计算节点的br-int连接到计算节点的br-tun,然后通过br-tun之间的VPN送到网络节点的br-tun,在送到br-int,在送到路由器从br-ext出去每个计算节点之间也会建立br

neutron学习小结

概述 基于yoga版本学习neutron,通过源码、官方文档、部署环境进行学习 neutron-dhcp-agent neutron.agent.dhcp_agent.main 创建server,调oslo_service launch server,最后实际调了server的start方法 neutron.service.Service.start Service

Openstack学习(2)——Neutron

Neutron 的设计目标是实现“网络即服务(Networking as a Service)”。为了达到这一目标,在设计上遵循了基于SDN 实现网络虚拟化的原则,在实现上充分利用了Linux系统上的各种网络相关技术。 Neutron 功能 二层交换Swithing:Nova的Instance是通过虚拟交换机连接到虚拟二层网络的。Neutron支持多种虚拟交换机,包括 Linux 原生的 Li

Neutron之Iptables总结

openstack在网络管理上用的是neutron组件,而neutron管理网络流量直接用的是iptables规则。通过iptables能够有效的指定安全规则,为云计算提供安全的网络环境。那么要研究openstack的网络管理,必然要落到底层的iptables的研究上。 这次关于iptables研究使用的物理主机是OA环境4号节点。通过在openstack的dashboard上增减虚拟机和

neutron是如何通过iptables管理网络的

在访问与安全的菜单下,新建一个安全组test。点击进入test,可以看到两个默认的出口,这个是系统自动定义好的,表示无论从哪个端口哪个ip都能出去。 然后添加两个新的规则 第一个规则表示,只能从默认安全组可以ping通该组的虚拟机; 第二个规则表示,只能从默认安全组跳进该组的虚拟机。 启动云主机创建新的虚拟机,选择oa环境和刚刚创建的安全组。 然后进入该虚拟机,查看虚拟机创在

Neutron在给虚拟机分配网络时,底层是如何实现的?

研究思路: 了解neutron和相关组件的工作流程。Neutron如何给不同租户分配网络 了解vxlan和vlan的区别 了解linux的底层命令实现,看日志文件,并记录日志信息 首先需要了解neutron使用的是vxlan管理网络,在数据中心中如果虚拟机超过250台,那么就可以考虑vxlan。因为一个vlan最多只能使用4096个ip地址,而vxlan通过24位分片id,在

OpenStack Neutron解析

OpenStack Neutron解析 很久之前写了一篇关于OpenStack Neutron解析的文章,那时只是粗略的写了一下把Neutorn的整体架构分析了一下,后来一直忙于其他事情,也就忘了去详细分析一下Neutron的架构。这次这篇算是完成未完之事,同时也是对之前的一个知识的总结及恢复。 OpenStack的Neutron自从由nova-network从Nova中分离出来之后,一直

OpenStack计算节点上虚拟网络(Neutron)详解

场景(一个租户,两个网络,一个路由,内部网络使用GRE,Libvirt VIF Driver使用LibvirtHybridOVSBridgeDriver): 场景一虚拟网络拓扑 Figure 11 场景一虚拟网络拓扑 如图我们有一个外网(External Network),IP段为172.16.0.0/16,两个内网,分别是Internal:10.18.0.0/24,和Interna

OpenStack Neutron解析---Linux Bridge Tun Tap

http://panpei.net.cn/2013/12/04/openstack-neutron-mechanism-introduce/ OpenStack Neutron运行机制解析概要 自从开学以来,玩OpenStack也已经3个月了,这段时间主要把精力投在了OpenStack的安装部署和网络组件Neutron的研究上了。这期间零零散散在安装部署和Neutron运作原理上来回切换,有

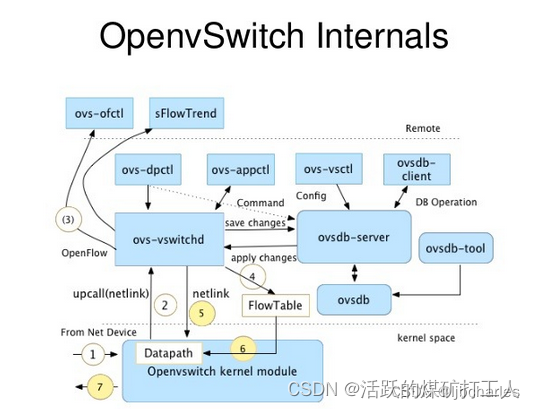

Neutron OpenvSwitch agent工作原理

在OpenStack中目前用的比较多的L2层agent应该就是openvswitch agent了。本文大致分析了一下openvswithc agent做了哪些事。 看一下openvswitch agent的启动: [plain] view plain copy neutron/plugins/openvswitch/agent/ovs_neutron_ag

对openstack(JUNO)的neutron的相关测试

这两天对公司的的openstack环境进行测试,因为环境是别的同事搭建的,我这边只负责相关的测试,一台服务器独立安装 controller node,另外两台服务器都安装network node+compute node。大概环境如下: 外网IP网段是192.168.1.0/24,其中192.168.1.100~192.168.1.200为floatingip分配范围,内网IP网段是17

openstack之neutron介绍

核心组件 neutron-server:提供API接口,把对应的api请求传给plugin进; neutron-plugin:管理逻辑网络状态,调用agent; neutron-agent:在provider network上创建网络对象; neutron-dhcp-agent:轻量级进程dnsmasq绑定到指定命名空间中的 br-int 的接口上,实现dns、tftp、dhcp等功能;

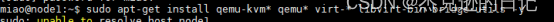

14 龙芯平台openstack部署搭建-neutron-controllercomputer部署(单节点)

一、创建neutron相关数据库、服务凭证和API端点 1.创建neutron数据库,授予合适的访问权限 mysql -uroot -ploongson -e “CREATE DATABASE neutron;” mysql -uroot -ploongson -e “GRANT ALL PRIVILEGES ON neutron.* TO ‘neutron’@‘localhost’ IDEN

OpenStack的Neutron来管理基础资源-网络

Neutron理论(下)及实验 Neutron ML2 解决 core plugin 的问题 1.ML2插件是一种允许OpenStack网络同时地利用多种二层网络技术的框架。目前与openswitch、linuxbridge、hyperv L2 agent协同工作。ml2框架对简化新增L2网络技术的做了很好支持,比起以往新增加的核心插件,ML2框架需要更少的初期以及后期维护工作,简单来说,

openstack Queens版本在centos7.1,最小化安装(安装neutron(计算节点))

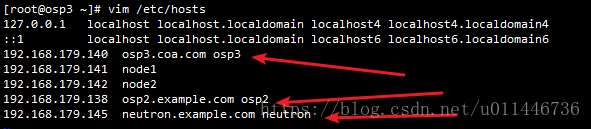

Hosts 10.0.2.111 controller 10.0.2.112 compute1 确保这网络OK ping -c 4 openstack.org ping -c 4 compute1 ping -c 4 controller yum installopenstack-neutron-linuxbridge ebtables ips

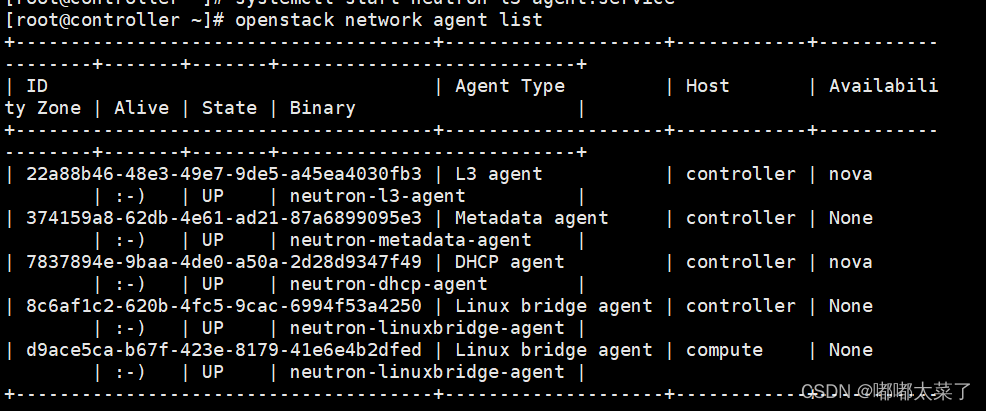

openstack Queens版本在centos7.1,最小化安装(安装neutron(控制节点))

Hosts 10.0.2.111 con01controller 10.0.2.112 com01compute1 确保这网络OK ping -c 4 openstack.org ping -c 4 compute1 ping -c 4 controller 在数据库中创建neutron库和用户并授权 [root@con01~]# mysql

Openstack学习笔记五(Networking (neutron) service)

前提准备 controller节点和compute1节点都加一块桥接模式的网卡: 1、controller节点 2、compute1节点 3、设置controller的桥接网卡 ① 查看网卡并修改配置文件 4、设置compute1的桥接网卡 ① 查看网卡并修改配置文件 5、检查网络、主机名映射 ①在controller节点和compute1互相ping测试

Neutron中的对象objects

对象版本化是滚动升级的关键概念。自从被Nova社区初始实现后,版本化对象model被加入oslo库,以便其它的project可获得其带来的益处。 ”Oslo VersionedObjects“ (即 OVO) 是数据库的前端,其中可定义软件与数据库schema之间的中间层。在这一层,每个数据库资源的版本化对象以严格的数据定义和版本号被创建。对于OVO,当你改变数据库schema时,对象的版本也改

Neutron升级规划

本文档的大部分内容讨论通过Neutron agents实现的升级相关考虑。期望于每个Neutron插件提供其自身的特定于后端选择的升级讨论文档。例如,OVN不使用Neutron agent,但是确实有本地控制器运行在每个计算节点。OVS支持滚动升级,但是,关于如何工作的文档应包含在networking-ovn(OVN Neutron插件)中。 升级规划 Neutron支持两种通用的升级场景:

Neutron重试操作

在neutron.db.api模块内部有一个修饰符叫做“retry_if_session_inactive”。其应用于保护所有执行DB操作的方法。此修饰符将获取它所保护的方法抛出的任何的死锁错误、RetryRequests、连接错误和单一限制破坏。 如果应用的方法在活动会话中调用,此修饰符不会重试操作。这是因为它捕获的大多数异常将会话部分的转到回滚状态,以至于其不再可用。重要的是保证有一个处于事

OpenStack-train版安装之计算节点安装Nova(计算服务)、安装Neutron(组网服务)

计算节点安装Nova(计算服务)、安装Neutron(组网服务) 安装Nova(计算服务)安装Neutron(组网服务) 安装Nova(计算服务) 安装和配置 # yum install openstack-nova-compute -y 配置,修改配置文件/etc/nova/nova.conf,在对应分组【[组名]】下添加配置: [DEFAULT] enabled_api

【Openstack Train安装】十、Neutron安装

Neutron,是Openstack中的一大核心组件,设计目标是实现“网络即服务(Networking as a Service)”。为了达到这一目标,在设计上遵循了基于 SDN 实现网络虚拟化的原则,在实现上充分利用了 Linux 系统上的各种网络相关的技术。 本文介绍Neutron安装步骤,Neutron需在控制节点和计算节点安装安装。 在按照本教程安装之前,请确保完成以下配置:

【星海随笔】SDN neutron (二) Neutron-plugin(ML2)

Neutron架构之Neutron-plugin Core-plugin(ML2)篇 Neutron-server接收两种请求: REST API请求:接收REST API请求,并将REST API分发到对应的Plugin(L3RouterPlugin)。 RPC请求:接收Plugin agent请求,分发到对应的Plugin(NeutronL3agent)。 Neutron-plugi