namattention专题

Unet改进3:在不同位置添加NAMAttention注意力机制

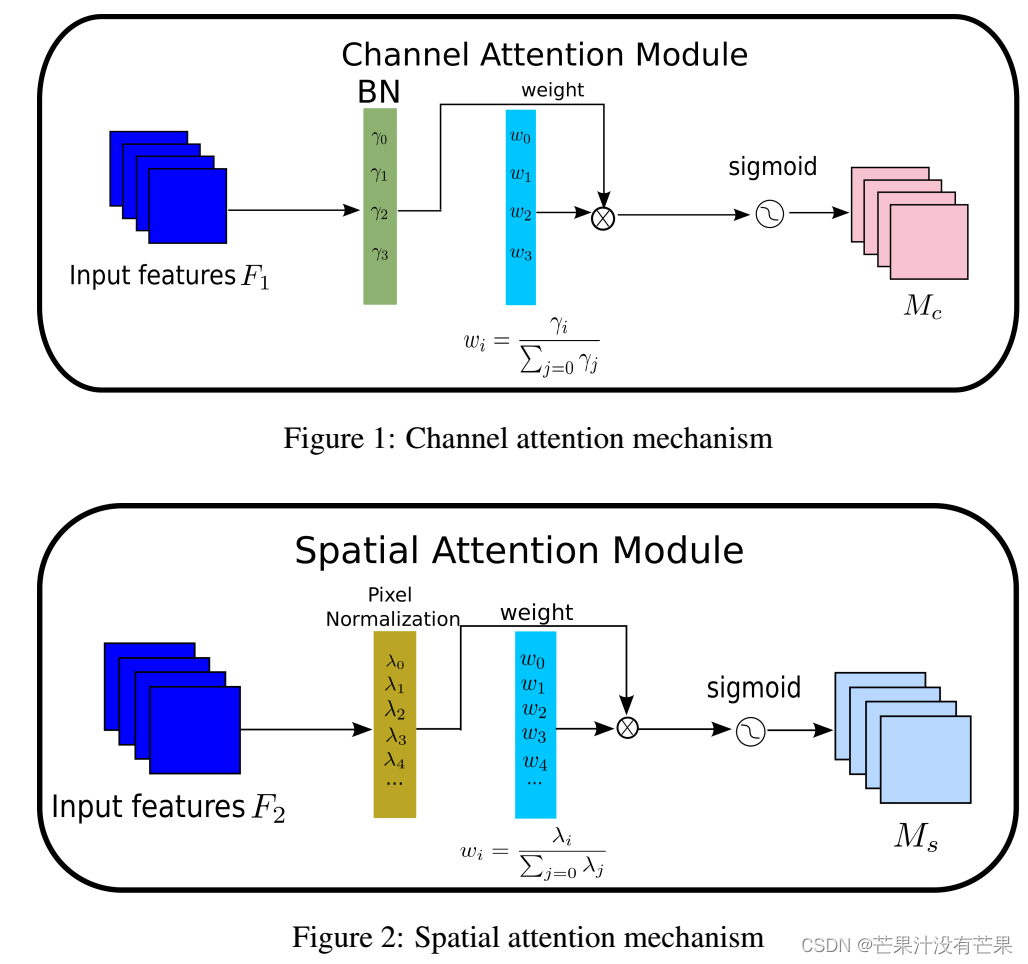

本文内容:在不同位置添加NAMAttention注意力机制 目录 论文简介 1.步骤一 2.步骤二 3.步骤三 4.步骤四 论文简介 识别不太显著的特征是模型压缩的关键。然而,它在革命性的注意机制中尚未得到研究。在这项工作中,我们提出了一种新的基于归一化的注意力模块(NAM),它抑制了较不显著的权重。它将权重稀疏性惩罚应用于注意力模块,从而使它们在保持类似性能的同时

Pointnet++改进:在特征提取模块加入NAMAttention注意力机制,有效涨点

简介:1.该教程提供大量的首发改进的方式,降低上手难度,多种结构改进,助力寻找创新点!2.本篇文章对Pointnet++特征提取模块进行改进,加入NAMAttention注意力机制,提升性能。3.专栏持续更新,紧随最新的研究内容。 目录 1.理论介绍 2.修改步骤 2.1 步骤一

改进YOLOv5、YOLOv8系列:17.添加NAMAttention注意力机制

最新创新点改进推荐 -💡统一使用 YOLO 代码框架,结合不同模块来构建不同的YOLO目标检测模型。 🔥 《芒果书》系列改进专栏内的改进文章,均包含多种模型改进方式,均适用于YOLOv3 、YOLOv4 、 YOLOR 、 YOLOX 、YOLOv5 、 YOLOv7 、 YOLOv8 改进(重点)!!! 🔥 专栏创新点教程 均有不少同学反应和我说已经在自己的数据集上有效涨点啦!! 包