mlu370专题

MLU370配置环境以及算子转换流程

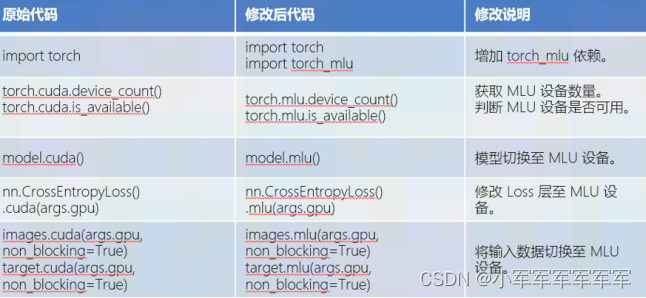

在MLU370上运行程序,需要把项目代码算子转化一下,算子转换的代码: python /torch/src/catch/tools/torch_gpu2mlu/torch_gpu2mlu.py -i /路径/ 例如:python /torch/src/catch/tools/torch_gpu2mlu/torch_gpu2mlu.py -i /workspace/volume/sh

MLU370用户指南 or MLU370-YOLOV5快速训练推理!!速度起飞

MLU370用户指南 or MLU370-YOLOV5快速训练推理!!速度起飞 用户前言创建开发环境开发环境登录及测试开发环境YOLOV5 修改适配370预训练模型推理(超简单)QA集锦 用户前言 在本章我们将从获取算力卷创建自己的云平台账号开始,一步一步的带着大家从0到1完成,从创建云平台环境,选择镜像,选择SDK版本,到SSH登录云平台环境,更改github原版yolov5

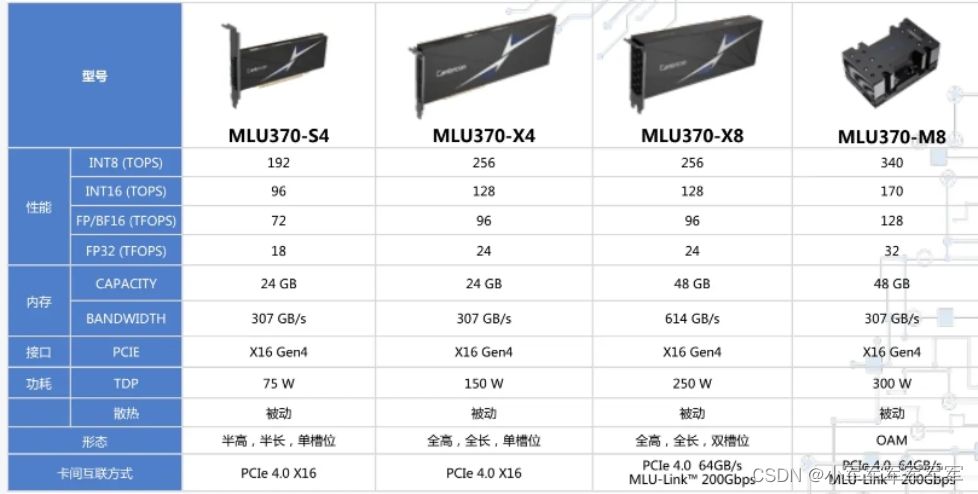

MLU370-M8轻轻松松跑通Qwen-7B-chat

这一期我们将快速让千问7B快速跑通在国产芯片MLU370-M8卡上,后续会更新更多有关于LORA、预训练、RLHF、SFT,Embedding、Fintuning等得操作过程,尽情期待 Qwen-7B-chat在MLU370-M8上实现 前言一、环境准备二、模型下载1.魔塔社区引入2.代码修改3.代码运行 效果展示 前言 通义千问-7B(Qwen-7B) 是阿里云研发

ChatGLM-6B如何推理在MLU370

提示:关于如何登录使用370,可以查看上一篇博文 文章目录 前言一、MLU370二、操作过程1.源码下载2.部署环境1.进入云平台2.编译transformers_mlu-4.27.13.修改模型读取4.运行成功 总结 前言 有各种类型的预训练架构,包括自动编码模型(例如BERT)、自回归模型(例如GPT)和编码器-解码器模型(例如T5)。然而,没有一个预训练框架在

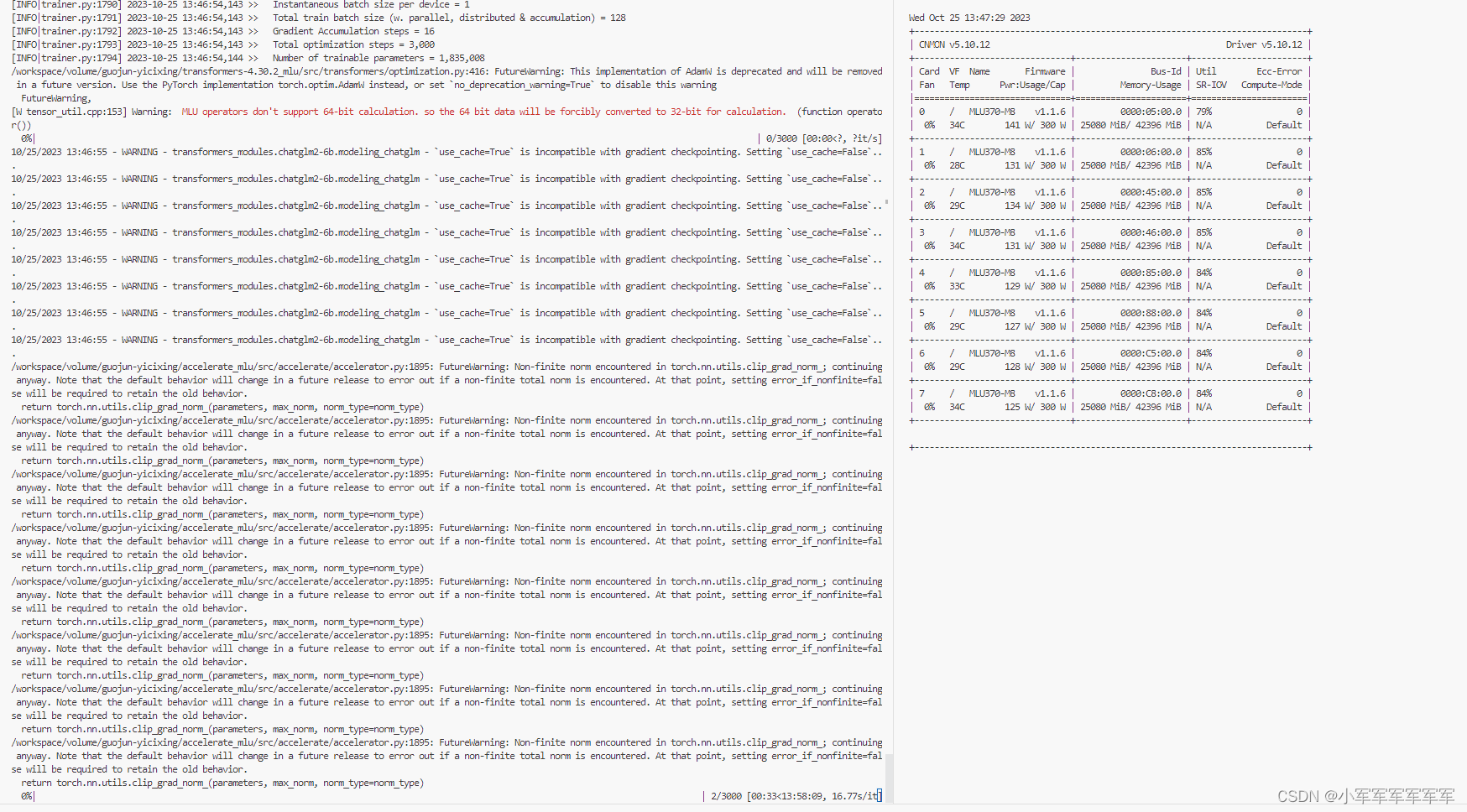

寒武纪芯片MLU370-M8完成GLM2-6B多轮对话Ptuning-v2

文章目录 前言一、环境准备1.云平台环境准备2.私有库安装3.快速模型下载4.代码修改 二、开始运行1.启动脚本2.运行状态 总结 前言 前几篇讲到了有关大模型在寒武纪卡上推理,是不是觉得越来越简单了,接下来上干活知识,基于寒武纪卡完成大模型微调,以及后面还会讲到基于寒武纪卡完成数字人训练+推理,敬请期待。 废话不多说,我们现在开始 一、环境准备 1.云平台环境准备