mechanisms专题

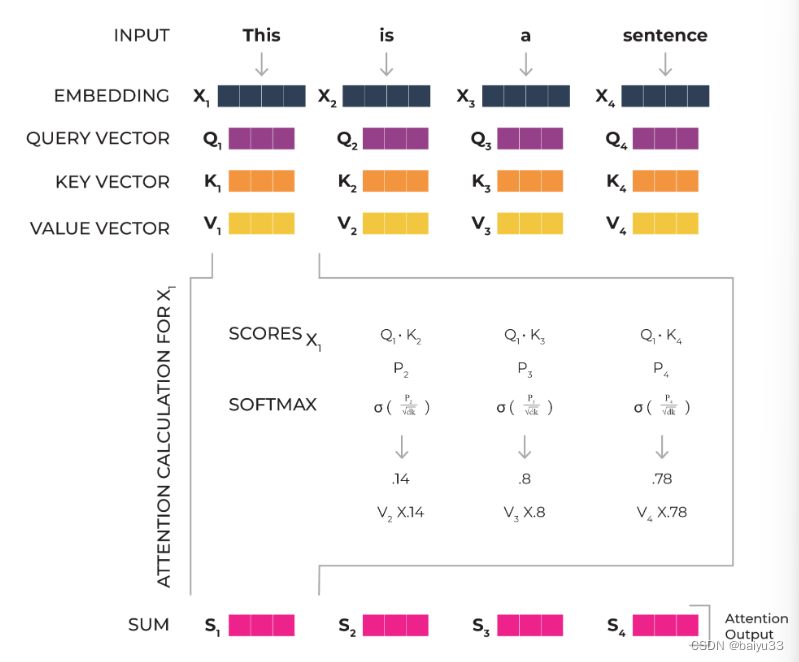

LLM(3) | 自注意力机制 (self-attention mechanisms)

LLM(3) | 自注意力机制 (self-attention mechanisms) self-attention 是 transformer 的基础, 而 LLMs 大语言模型也都是 transformer 模型, 理解 self-attention, 才能理解为什么 LLM 能够处理好上下文关联性。 本篇是对于 Must-Read Starter Guide to Mastering A

连接GaussDB(DWS)报错:Invalid or unsupported by client SCRAM mechanisms

用postgres方式连接GaussDB(DWS)报错:Invalid or unsupported by client SCRAM mechanisms 报错内容 [2023-12-27 21:43:35] Invalid or unsupported by client SCRAM mechanisms org.postgresql.util.PSQLException: Invalid

all available gssapi mechanisms failed错误解决

解决方法: vi /etc/ssh/sshd_config 将PasswordAuthentication 的属性 no 改为 yes service sshd restart

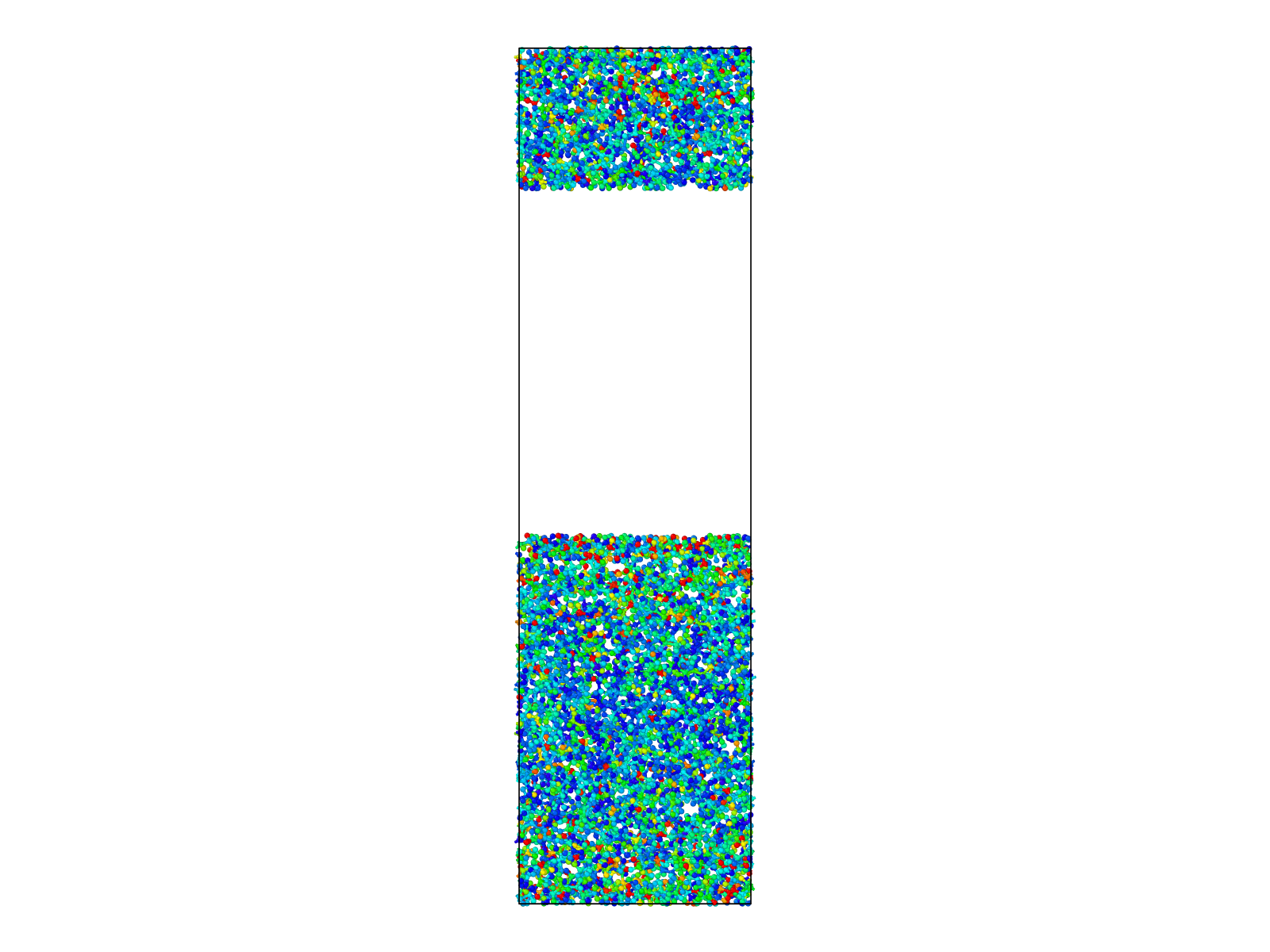

菜鸡论文模仿01(结构优化):Identifying the Mechanisms of Polymer Friction through Molecular Dynamics Simulation

模仿 MD最好的入门方式就是模仿!!!!! 找一篇难度适中的,软件,研究点都比较贴近自己方向的论文进行模仿。作为初学的我很幸运找到了这篇论文,在模仿过程中也逐渐的掌握了lammps的相关命令,如果大家也觉得适合的话,也可以进行模仿练习。比较贴近的意思是眼光要广,只要那篇论文有涉及到你的研究方向,哪怕是一个参数,你都值得一看。 Dai L, Minn M, Satyanarayana N, S